实时可编辑3D重建!鼠标拖拽就能控制,港大VAST浙大联合出品

最近,高斯溅射(Gaussian Splatting)在新视角合成领域掀起了一轮革命性浪潮,取代上一代技术神经辐射场(NeRF)成为学界业界顶流。而真实场景往往是动态的,如何合成动态场景的新视角是更具价值与挑战的领域。

随着图形学与AI的发展,数字资产的创造日益引起人们的重视。对于重建的真实场景进行编辑也是AIGC领域业内关注的热门方向,其为制作数字资产提供了高效与便捷。

香港大学CVMI实验室携手3D大模型公司VAST与浙江大学,提出了目前SOTA的动态高斯溅射模型SC-GS,并支持用户交互式实时编辑重建的场景。

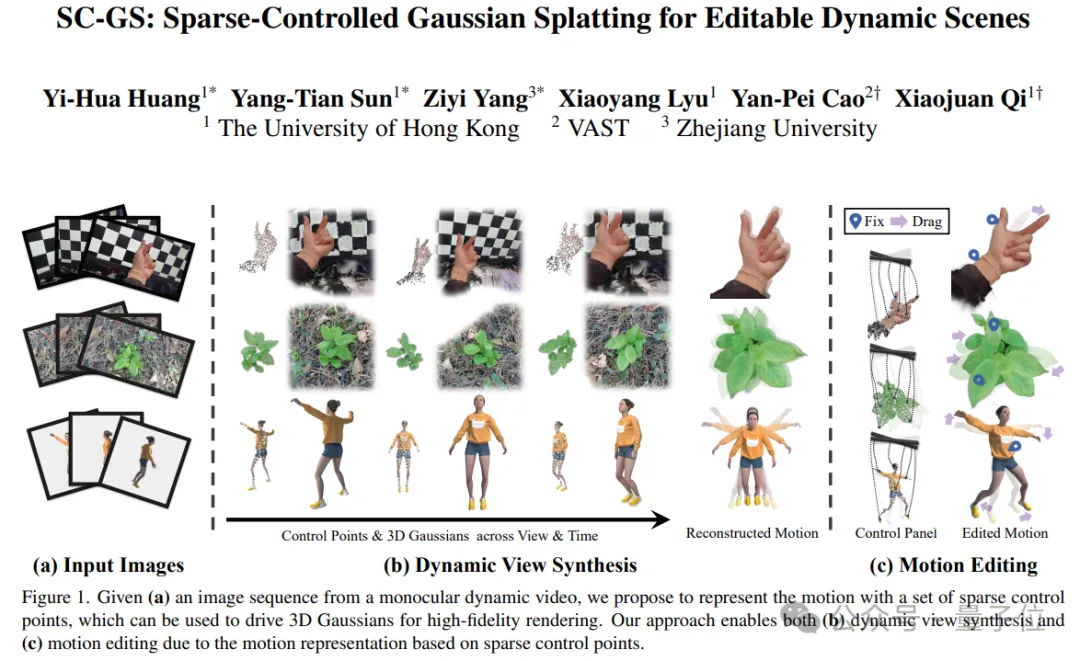

△面向可编辑动态场景的稀疏控制高斯溅射

SC-GS支持用户对重建的动态高斯进行实时交互编辑,制作新的场景运动或形状:

使用鼠标的拖拽与键盘组合按键就能够方便的操作。

△实时交互编辑

怎么做到的?

SC-GS的灵感来源于对自然世界大多数动态过程的观察,由于物质大多数都是刚性或连续的,因此物体的移动往往可以由稀疏的变形基底表示,并不需要稠密的变形场进行建模。

摒弃了大多数现有方法对动态场景的变形场进行稠密建模的方案,SC-GS突破性地引入稀疏的控制点对动态场景的变形进行表示与建模,并由一个神经网络预测每个控制点在不同时刻的运动状态,从而驱动整个场景中的动态高斯进行变形。

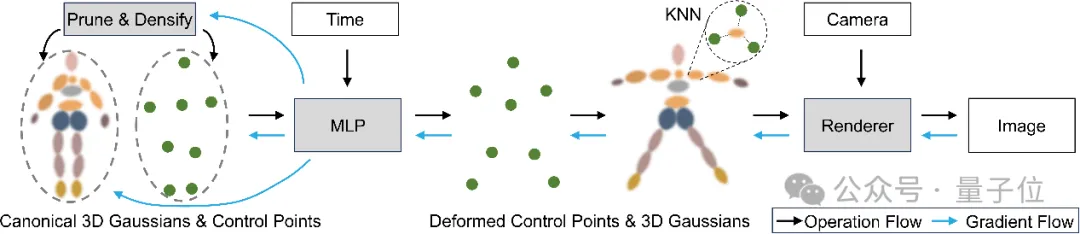

SC-GS首先初始化少数各向同性的球状高斯结合神经网络预测的运动进行渲染,使用渲染结果拟合动态场景的多视角图片,得到粗糙但不过拟合的变形场建模。

通过对这些球状高斯进行降采样,得到预设数量的稀疏控制点,并通过径向基函数插值得到标准空间中各个高斯在不同时刻的变形参数进行驱动变形。

训练过程中,稀疏控制点,神经网络还有高斯共同训练优化,实现动态场景的建模。

研究团队发现稀疏控制点虽然能够完美解决变形场过拟合到训练视角的问题,但其重建的变形也会出现不符合真实物理的现象。这是由于控制点的运动缺乏物理约束,容易出现交错与碰撞。

因此研究团队引入了局部刚性约束,限制控制点与邻接点形成的边在运动过程发生非刚性变形,以让控制点的运动规律尽可能地符合真实物理。

这一约束进一步提升了动态新视角合成的性能。

基于训练完成的模型,通过分析控制点的轨迹,能够得到控制点连接形成的图结构与各个边上的刚性权重。通过对该图进行“尽可能刚性”(ARAP)的变形,能够以符合物理的条件对建模场景进行编辑。

由于变形的对象是稀疏的控制点,因此变形过程能够实时进行,这也为交互式编辑提供了可能,让用户能够更高效,更便捷的创建属于自己的数字资产。

△基于稀疏控制点驱动稠密高斯的方法框架

实验结果

SC-GS能够对建模场景进行交互式编辑,制作新的场景运动或形状。

△动作形状编辑结果

SC-GS提供了方便快捷的编辑方案,在可视化窗口界面利用鼠标拖拽与键盘按键即可实现。

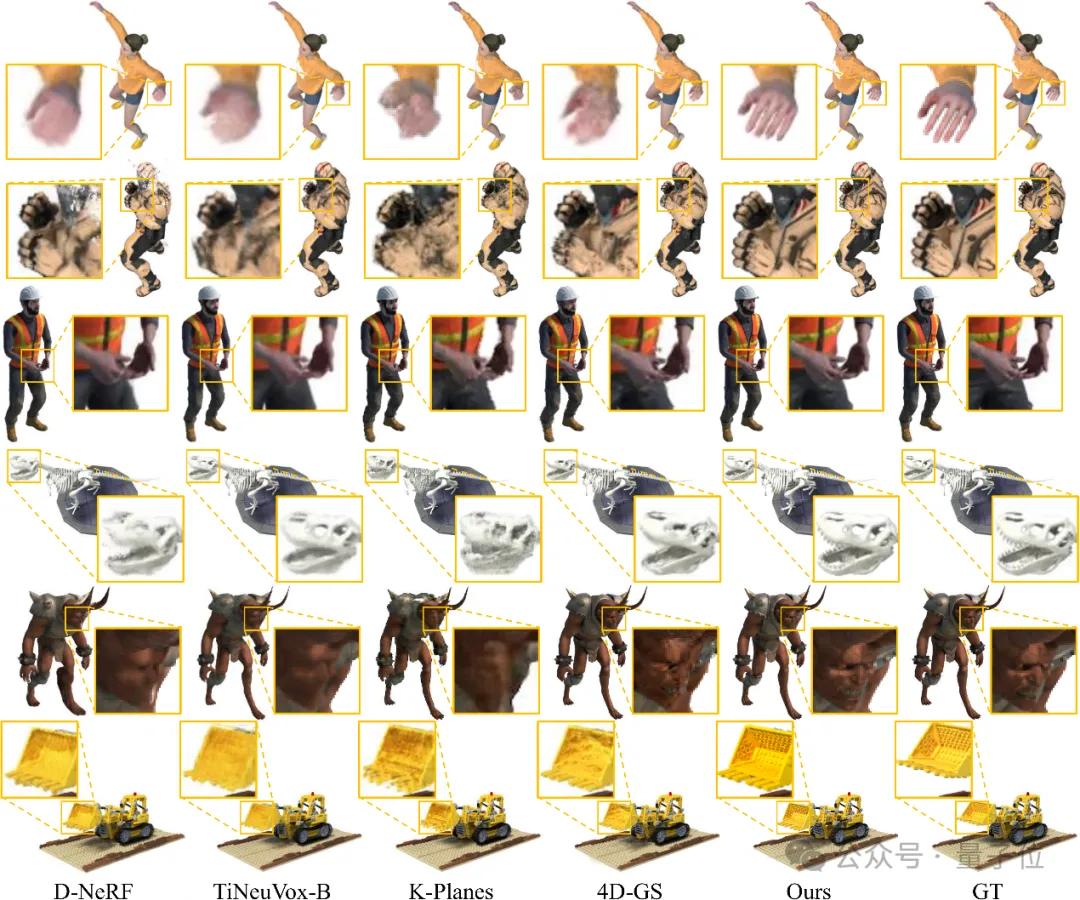

此外,SC-GS能够以SOTA的性能合成动态场景的新视角图片,对于精细的几何纹理细节都有着最高的保真度。对于人体手指,恐龙骨骼等精细部位的渲染都有着精准的复现。

△DNeRF数据集定性对比,SC-GS超过现有方法达到最佳视觉质量

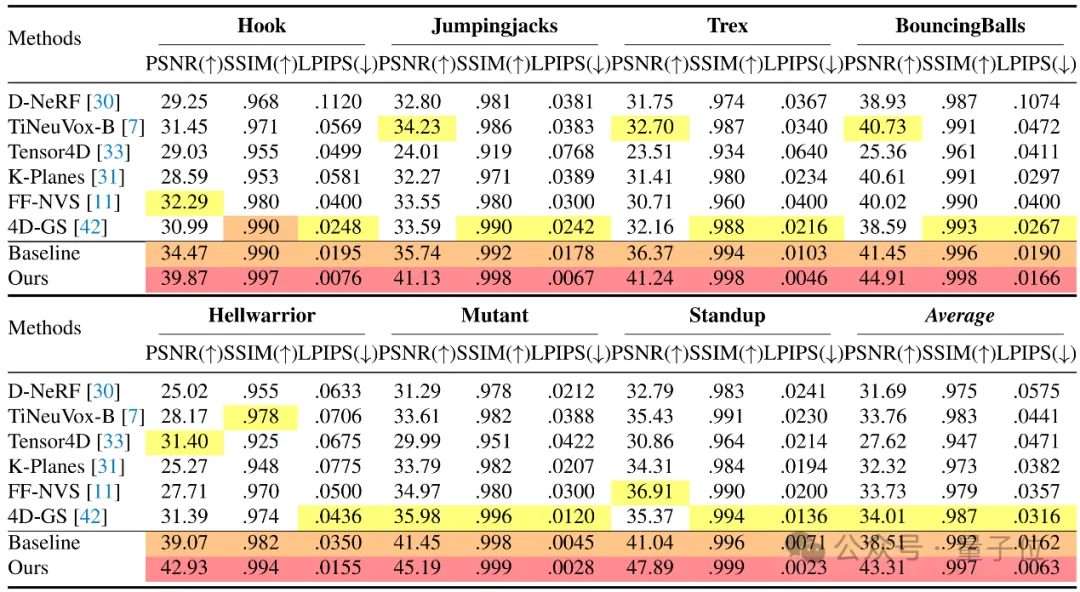

定量实验同样表明,SC-GS远超现有方法,在DNeRF数据集上实现了均值超过40的PSNR指标。

△SC-GS全面大幅度超越现有的动态场景新视角合成方法

最后研究人员表示:

SC-GS让我们看到了高斯溅射在动态场景与交互式编辑方面的潜力,我们期待2024年会有更精彩的工作与探索。

项目主页:https://yihua7.github.io/SC-GS-web/

论文链接:https://arxiv.org/pdf/2312.14937.pdf

代码仓库:https://github.com/yihua7/SC-GS

本文转自 量子位 ,作者:量子位