轻量化AI的崛起:蒸馏模型如何在资源有限中大放异彩 原创

01、概述

我们可能已经听说了 Deepseek,但你是否也注意到 Ollama 上提到了 Deepseek 的蒸馏模型?或者,如果你尝试过 Groq Cloud,可能会看到类似的模型。那么,这些“distil”模型到底是什么呢?在这一背景下,“distil”指的是组织发布的原始模型的蒸馏版本。蒸馏模型本质上是较小且更高效的模型,设计目的是复制较大模型的行为,同时减少资源需求。

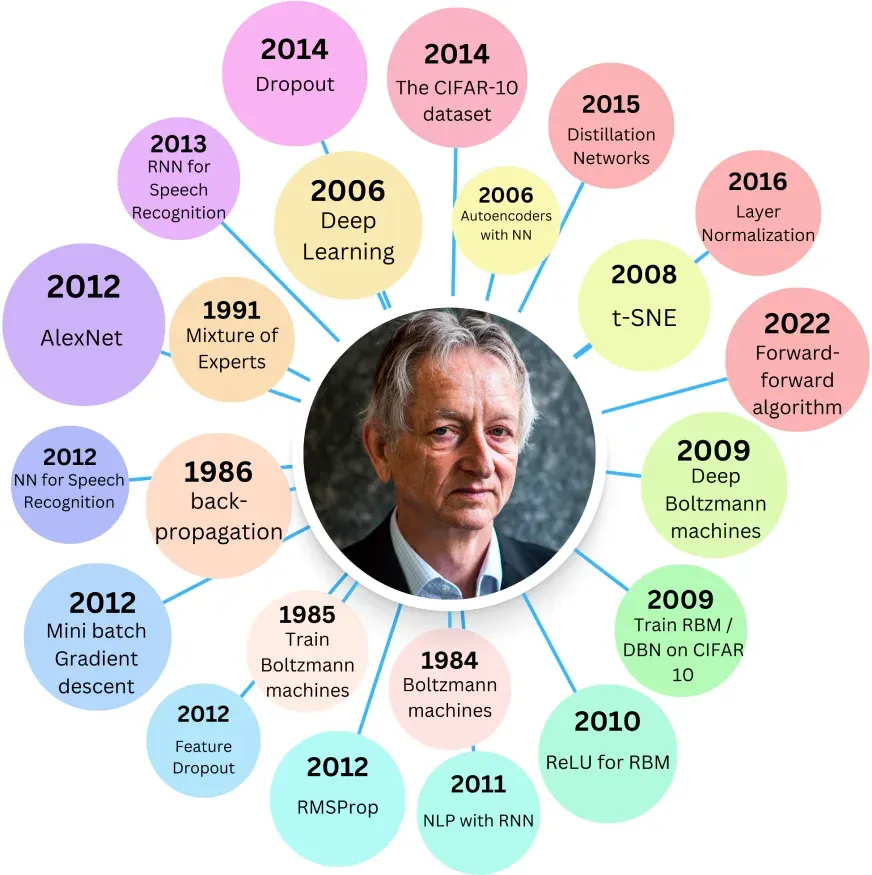

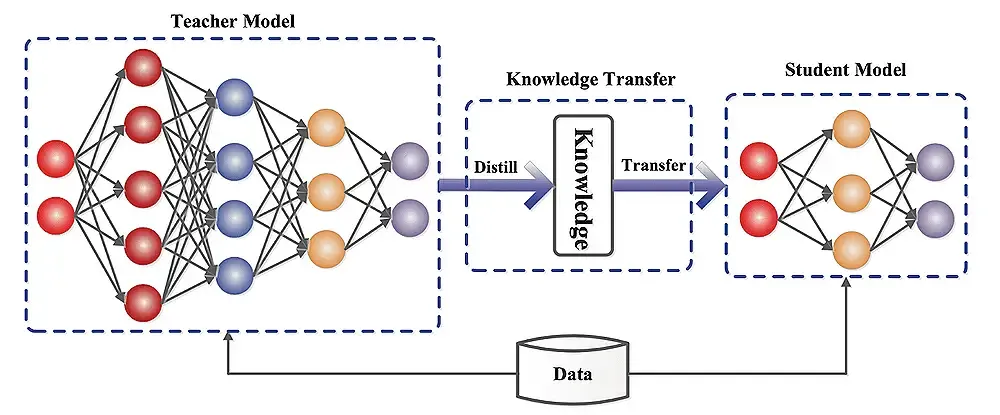

这种技术由 Geoffrey Hinton 在 2015 年的论文“Distilling the Knowledge in a Neural Network”中首次提出,旨在通过压缩模型来保持性能,同时降低内存和计算需求。Hinton 提出了一个问题:是否可以训练一个大型神经网络,然后将其知识压缩到一个较小的网络中?在这里,较小的网络被视为学生,而较大的网络则扮演教师的角色,目标是让学生复制教师学习的关键权重。

02、蒸馏模型的益处

蒸馏模型带来了多方面的优势,包括:

- 减少内存占用和计算需求。

- 降低推理和训练时的能耗。

- 加快处理速度。

例如,在移动和边缘计算中,较小的模型尺寸使其非常适合部署在计算能力有限的设备上,确保移动应用和物联网设备中的快速推理。此外,在大规模部署如云服务中,降低能耗至关重要,蒸馏模型有助于减少电力使用。对于初创公司和研究人员,蒸馏模型提供了性能与资源效率之间的平衡,支持更快的开发周期。

03、蒸馏模型的引入

蒸馏模型的引入过程旨在保持性能,同时减少内存和计算需求。这是 Geoffrey Hinton 在 2015 年论文中提出的模型压缩形式。Hinton 提出了一个核心问题:是否可以训练一个大型神经网络,然后将其知识压缩到一个较小的网络中?在这一框架下,较小的网络(学生)通过分析教师的行为和预测,学习其权重。训练方法包括最小化学生输出与两种目标之间的误差:实际的真实标签(硬目标)和教师的预测(软目标)。

双重损失组件

- 硬损失:这是与真实标签(地面真相)比较的误差,通常在标准训练中优化,确保模型学习正确的输出。

- 软损失:这是与教师预测比较的误差。虽然教师可能不完美,但其预测包含了输出类别相对概率的宝贵信息,有助于指导学生模型实现更好的泛化。

训练目标是最小化这两者的加权和,其中软损失的权重由参数 λ 控制。即使有人可能认为真实标签已足够用于训练,加入教师的预测(软损失)实际上可以加速训练并提升性能,通过提供细致的指导信息。

Softmax 函数与温度

这一方法的关键部分是修改 Softmax 函数,通过引入温度参数(T)。标准 Softmax 函数将神经网络的原始输出分数(logits)转换为概率。当 T=1 时,函数表现为标准 Softmax;当 T>1 时,指数变得不那么极端,产生更“软”的概率分布,揭示每个类别的相对可能性更多信息。为了纠正这一效应并保持从软目标的有效学习,软损失乘以 T^2,更新后的总体损失函数确保硬损失(来自实际标签)和温度调整后的软损失(来自教师预测)适当地贡献于学生模型的训练。

具体实例:DistilBERT 和 DistillGPT2

- DistilBERT:基于 Hinton 的蒸馏方法,添加了余弦嵌入损失来测量学生和教师嵌入向量之间的距离。DistilBERT 有 6 层、6600 万参数,而 BERT-base 有 12 层、1.1 亿参数。两者的重新训练数据集相同(英语维基百科和多伦多书籍语料库)。在评估任务中:

GLUE 任务:BERT-base 平均准确率为 79.5%,DistilBERT 为 77%。

SQuAD 数据集:BERT-base F1 分数为 88.5%,DistilBERT 约为 86%。

- DistillGPT2:原始 GPT-2 有四个尺寸,最小版本有 12 层、约 1.17 亿参数(某些报告称 1.24 亿,因实现差异)。DistillGPT2 是其蒸馏版本,有 6 层、8200 万参数,保持相同的嵌入尺寸(768)。尽管 DistillGPT2 的处理速度是 GPT-2 的两倍,但在大文本数据集上的困惑度高 5 点。在 NLP 中,较低的困惑度表示更好的性能,因此最小 GPT-2 仍优于其蒸馏版本。你可以在 Hugging Face 上探索该模型。

04、实现大型语言模型(LLM)蒸馏

实现 LLM 蒸馏涉及多个步骤和专用框架:

框架和库:

- Hugging Face Transformers:提供 Distiller 类,简化从教师到学生模型的知识转移。

- 其他库:TensorFlow Model Optimization 提供模型剪枝、量化和蒸馏工具;PyTorch Distiller 包含使用蒸馏技术压缩模型的实用程序;DeepSpeed(由微软开发)包括模型训练和蒸馏功能。

涉及的步骤:

- 数据准备:准备代表目标任务的数据集,数据增强技术可进一步增强训练示例的多样性。

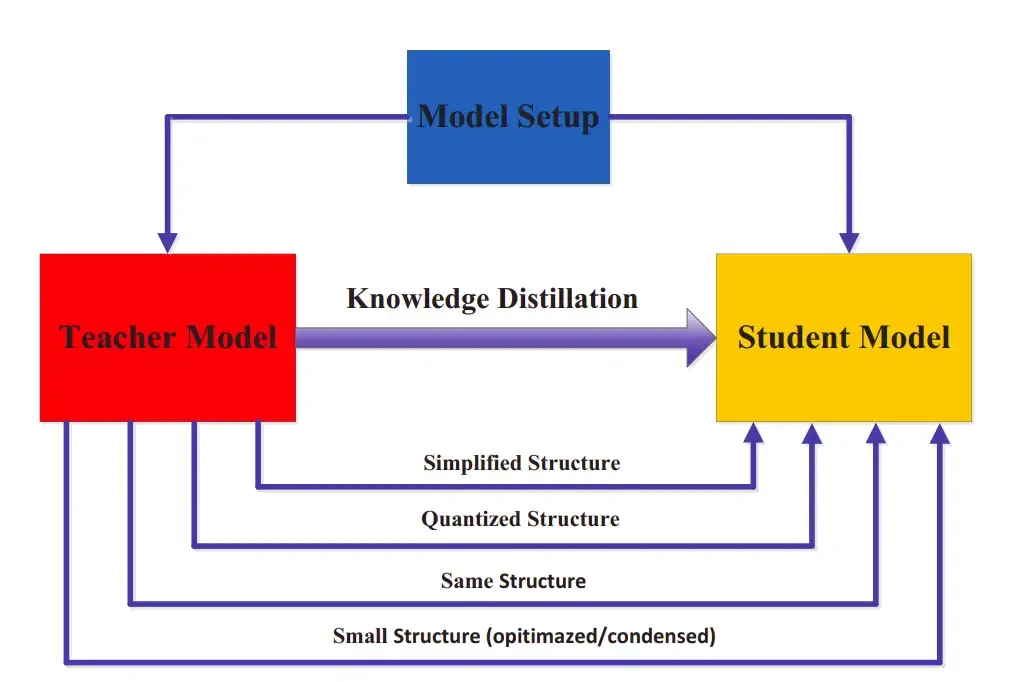

- 教师模型选择:选择表现良好的预训练教师模型,教师的质量直接影响学生的性能。

- 蒸馏过程:初始化学生模型,配置训练参数(如学习率、批量大小);使用教师模型生成软目标(概率分布)以及硬目标(真实标签);训练学生模型以最小化其预测与软/硬目标之间的组合损失。

- 评估指标:常用指标包括准确率、推理速度、模型大小(减少)和计算资源利用效率。

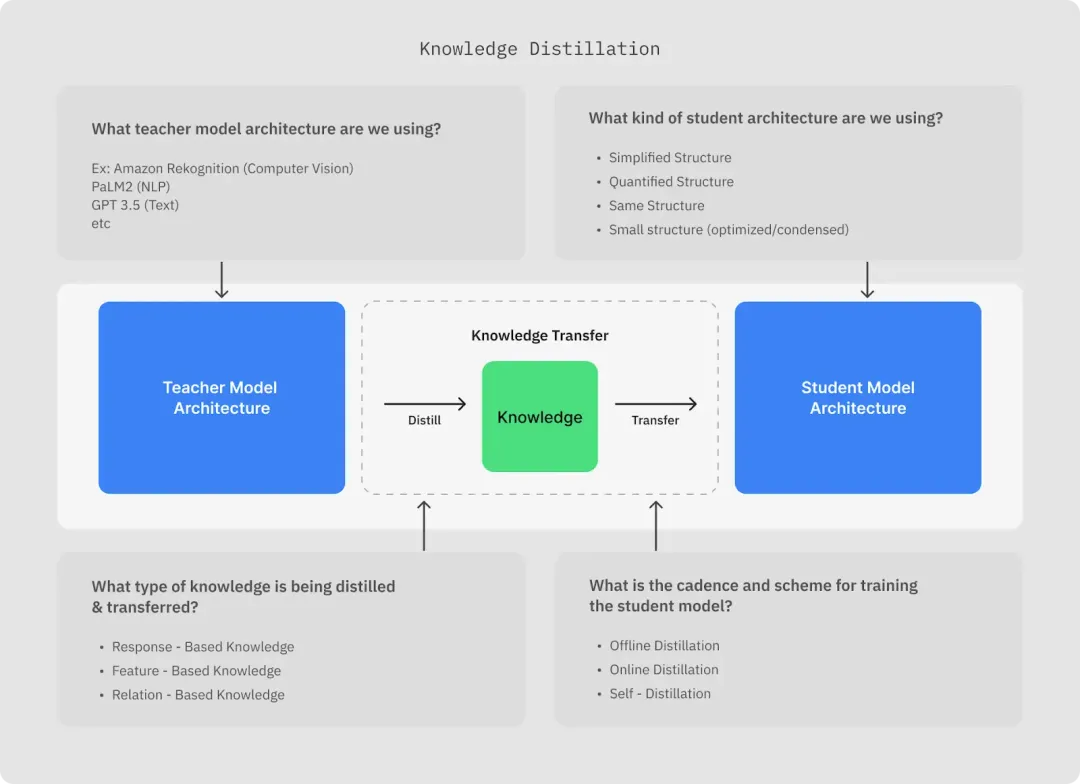

05、理解模型蒸馏

模型蒸馏的核心是训练学生模型模仿教师的行为,通过最小化学生预测与教师输出之间的差异,这是一种监督学习方法,构成了模型蒸馏的基础。关键组件包括:

- 选择教师和学生模型架构:学生模型可以是教师的简化或量化版本,也可以是完全不同的优化架构,具体取决于部署环境的特定要求。

- 蒸馏过程解释:通过最小化学生与教师预测之间的差异,学生学习教师的行为,确保在资源受限情况下保持性能。

挑战与局限性

尽管蒸馏模型提供了明显益处,但也存在一些挑战:

- 准确性权衡:蒸馏模型通常比其较大对应物略有性能下降。

- 蒸馏过程的复杂性:配置正确的训练环境和微调超参数(如 λ 和温度 T)可能具有挑战性。

- 领域适应:蒸馏的有效性可能因具体领域或任务而异。

06、未来方向

模型蒸馏领域快速发展,一些有前景的领域包括:

- 蒸馏技术进步:正在进行的研究旨在缩小教师和学生模型之间的性能差距。

- 自动化蒸馏过程:新兴方法旨在自动化超参数调整,使蒸馏更易访问和高效。

- 更广泛的应用:除了 NLP,模型蒸馏在计算机视觉、强化学习等领域也越来越受到关注,可能改变资源受限环境中的部署。

实际应用

蒸馏模型在各个行业中找到实际应用:

- 移动和边缘计算:较小的尺寸使其理想用于计算能力有限的设备,确保移动应用和物联网设备中的快速推理。

- 能效:在大规模部署如云服务中,降低能耗至关重要,蒸馏模型有助于减少电力使用。

- 快速原型开发:对于初创公司和研究人员,蒸馏模型提供性能与资源效率之间的平衡,支持更快的开发周期。

07、结论

蒸馏模型通过在高性能与计算效率之间实现微妙平衡,改变了深度学习。尽管由于其较小尺寸和依赖软损失训练,可能牺牲一些准确性,但其快速处理和减少资源需求使其在资源受限设置中特别有价值。总之,蒸馏网络模拟其较大对应物的行为,但由于容量有限,性能永远无法超过它。这种权衡使蒸馏模型在计算资源有限或性能接近原始模型时成为明智的选择。相反,如果性能下降显著或通过并行化等方法计算能力充足,选择原始较大模型可能更好。

本文转载自公众号Halo咯咯 作者:基咯咯