Mistral-Small-24B-Instruct-2501:小身材,大智慧,AI界的“轻量级拳王”来了! 原创

01、概述

在人工智能领域,开发既紧凑又高性能的语言模型一直是一个巨大的挑战。大型模型虽然表现卓越,但往往需要庞大的计算资源,这让许多硬件能力有限的用户和组织望而却步。与此同时,市场对多任务处理、多语言支持和高效准确响应的需求日益增长。如何在性能、可扩展性和可访问性之间找到平衡,尤其是在本地部署和数据隐私方面,成为了一个关键问题。这也催生了创新的需求:我们需要更小、更高效的模型,既能媲美大型模型的性能,又能保持多功能性和成本效益。

最近,自然语言处理领域取得了一些重要进展,像GPT-4、Llama 3和Qwen 2.5这样的大规模模型展现了卓越的性能,但它们对计算资源的需求也相当惊人。为了应对这一问题,研究人员开始专注于开发更小、更高效的模型,比如通过指令微调和量化技术来实现本地部署,同时保持竞争力。多语言模型如Gemma-2在语言理解方面取得了突破,而函数调用和扩展上下文窗口的创新则提升了任务适应性。尽管如此,如何在性能、效率和可访问性之间找到平衡,仍然是开发小型高质量语言模型的关键。

02、Mistral-Small-24B-Instruct-2501:小身材,大能量

最近,Mistral AI发布了一款名为Mistral-Small-24B-Instruct-2501的模型,这款模型虽然只有240亿参数,但却展现了顶尖的性能。它通过多样化的指令微调任务,实现了高级推理、多语言支持和无缝应用集成。与那些“庞然大物”相比,Mistral-Small专为高效的本地部署优化,支持像RTX 4090 GPU或32GB内存的笔记本电脑这样的设备,并通过量化技术进一步降低了资源需求。

32k上下文窗口:处理长文本的“神器”

Mistral-Small的一个亮点是它的32k上下文窗口,这意味着它可以轻松处理大量输入信息,同时保持高响应速度。无论是长篇文章、复杂指令还是多轮对话,它都能游刃有余地应对。此外,模型还支持JSON格式输出和原生函数调用,这让它在对话系统和任务特定场景中表现得更加灵活。

开源+低延迟:开发者的福音

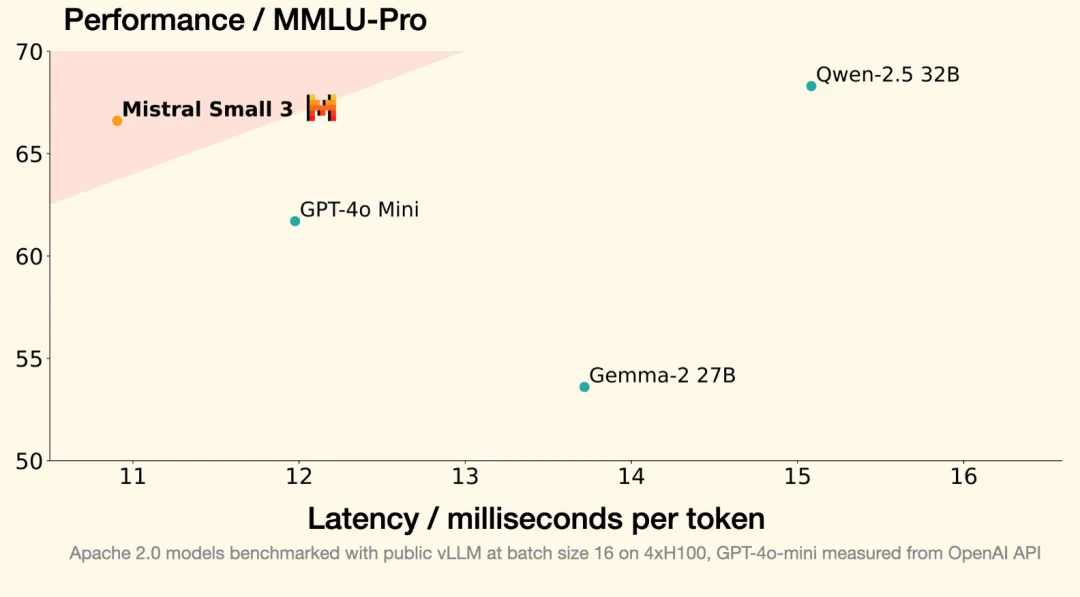

为了让更多开发者和企业能够使用,Mistral-Small采用了Apache 2.0开源协议,这意味着无论是商业还是非商业用途,都可以自由使用和修改。它的先进架构不仅实现了低延迟和快速推理,还特别适合那些对成本敏感的中小企业和个人开发者。可以说,Mistral-Small在性能和资源效率之间找到了一个完美的平衡点,甚至在某些任务上超越了Llama 3.3-70B和GPT-4o-mini这样的大型模型。

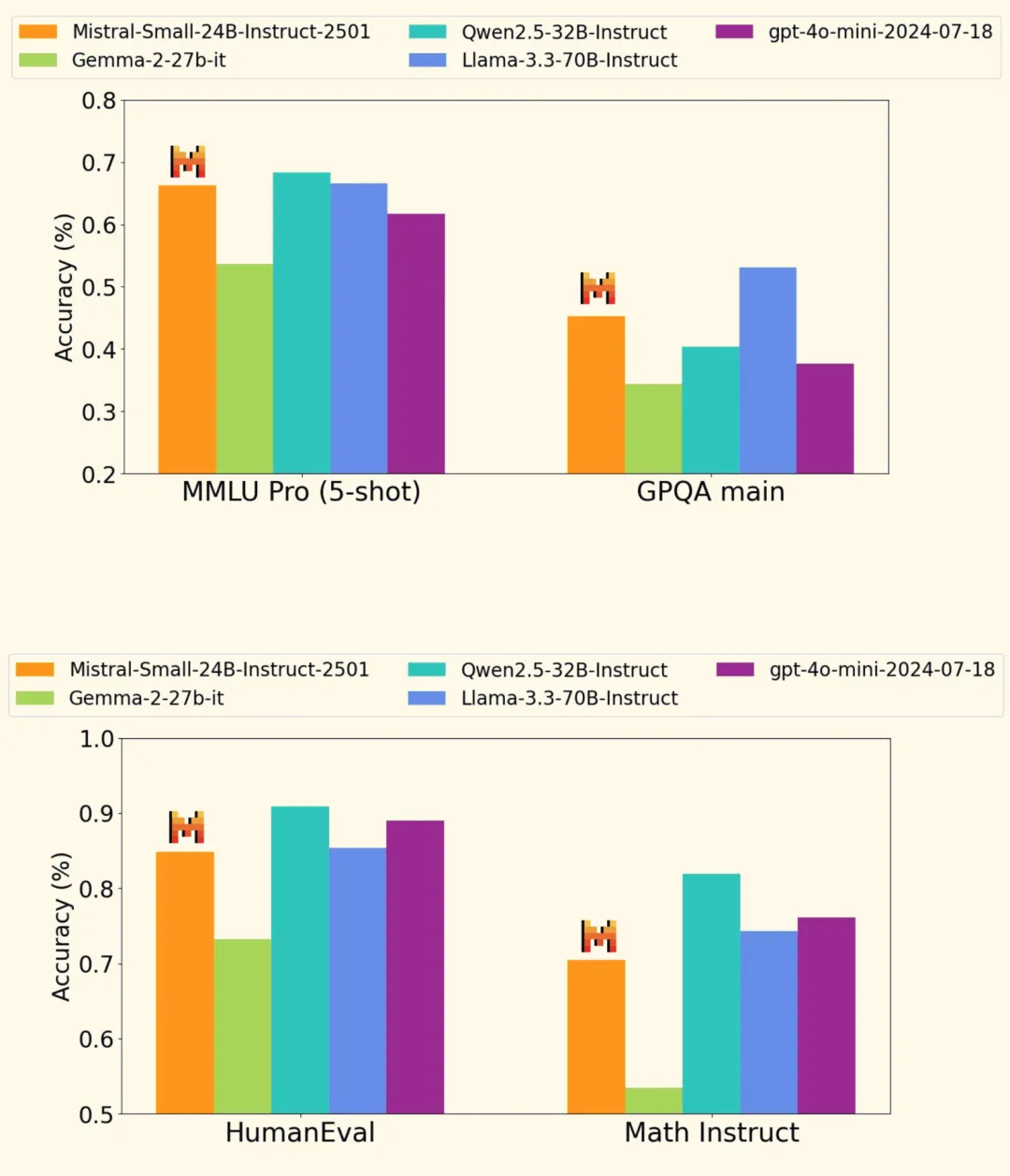

03、性能实测:小模型也能“打”大模型

Mistral-Small-24B-Instruct-2501在多个基准测试中表现抢眼,甚至在某些任务上超越了那些参数更多的“大块头”。比如,在HumanEval编码测试中,它的准确率达到了84.8%,在数学任务中也拿到了**70.6%**的高分。更令人印象深刻的是,它在指令遵循、对话推理和多语言理解方面的表现也相当出色,无论是在公开数据集还是私有数据集上都取得了竞争力十足的分数。

多语言支持:全球化的“语言大师”

Mistral-Small的多语言能力也值得一提。它不仅能处理常见的英语任务,还能在多种语言之间自如切换,这对于全球化企业来说无疑是一个巨大的优势。无论是翻译、跨语言沟通还是多语言内容生成,它都能轻松应对。

本地部署:数据隐私的“守护者”

对于那些对数据隐私有高要求的用户来说,Mistral-Small的本地部署能力无疑是一个巨大的加分项。你不再需要将敏感数据上传到云端,只需在本地设备上运行模型,就能享受到高效的AI服务。这对于医疗、金融等对数据安全要求极高的行业来说,简直是量身定制的解决方案。

开源+社区支持:AI界的“共享经济”

Mistral-Small的开源特性不仅降低了使用门槛,还为开发者社区提供了一个共享和协作的平台。无论是企业还是个人开发者,都可以基于这个模型进行二次开发,打造属于自己的AI应用。这种开放性和灵活性,正是AI技术快速发展的关键驱动力。

04、总结:小模型,大未来

Mistral-Small-24B-Instruct-2501的发布,标志着小型语言模型在性能和效率方面迈出了重要一步。它不仅展现了与大型模型媲美的能力,还通过高效的本地部署和开源特性,为更多用户提供了低成本、高灵活性的AI解决方案。无论是对话系统、多语言处理还是任务特定应用,Mistral-Small都能胜任。

未来,随着AI技术的不断进步,我们相信会有更多像Mistral-Small这样的“轻量级拳王”出现,它们将以更小的体积、更低的成本,为各行各业带来智能化的变革。而对于开发者和企业来说,这无疑是一个充满机遇的时代。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯

原文链接:https://mp.weixin.qq.com/s/NLy14KPwzNwXAWqMQAml9g