小洞不补,大洞吃苦:西交、麦马开源全新「拖动式编辑」框架&数据集

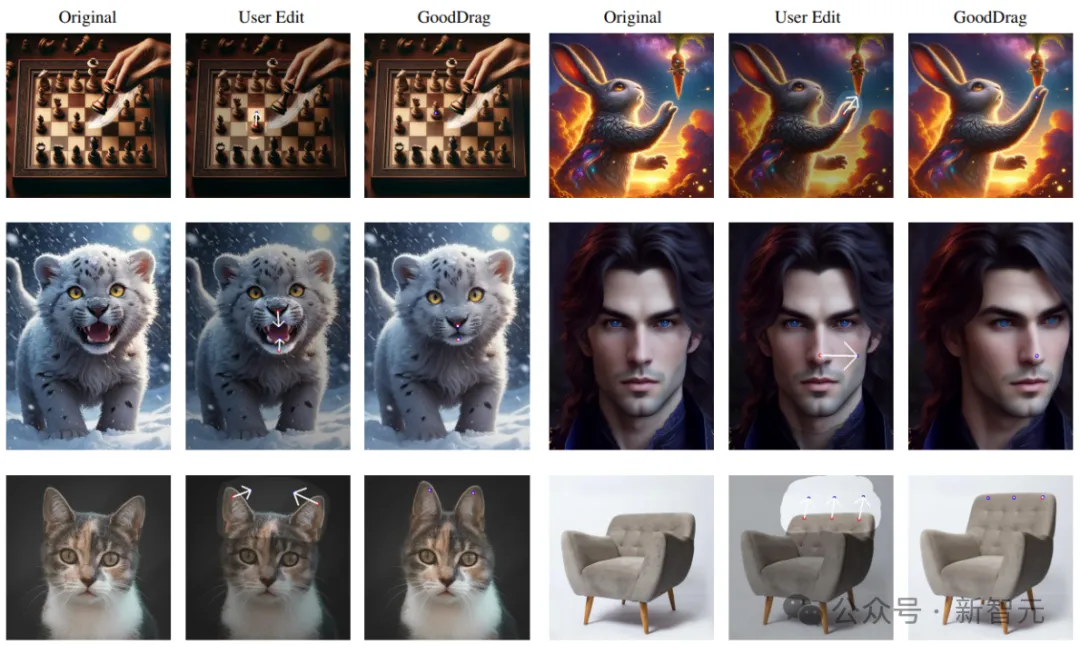

拖动式图像编辑是一种新型的、用户交互式的图像编辑方法。

通过设置起始点与目标点,用户可以将图像的内容拖动至指定位置,得到合理的图像结果。

当前的拖动式编辑基于GAN或者diffusion模型。然而这些方法或受限于GAN模型本身的生成能力,或在diffusion模型上无法得到稳定且高质量的结果。

论文地址:https://arxiv.org/abs/2404.07206

项目地址:https://gooddrag.github.io/

最近,西安交通大学和麦克马斯特大学的研究人员提出的一种全新GoodDrag方法包含一种Alternating Drag and Denoising(AlDD)的用于拖动式编辑的框架和information-preserving motion supervision,有效提高了基于diffusion模型的拖动编辑的图像质量。

值得注意的是,GoodDrag遵循简约的设计原则(如无必要,勿增实体):AlDD只需要改变计算顺序,而不增加任何计算;information-preserving的改进则只需要巧妙地对损失中的一项进行改动。这种简洁性极大提升了方法的泛化能力,也为未来研究提供了扎实的基准。

此外,研究人员还建立了包含不同类型拖动编辑任务的新数据集Drag100,并采用新的指标对拖动编辑结果的准确性和图形质量进行评估。

方法概述

1. 拖动编辑

基本的拖动编辑将一组起始点pi对应的图像内容拖动至对应的目标点qi,其主要过程分为两部,动作监督和当前点追踪。

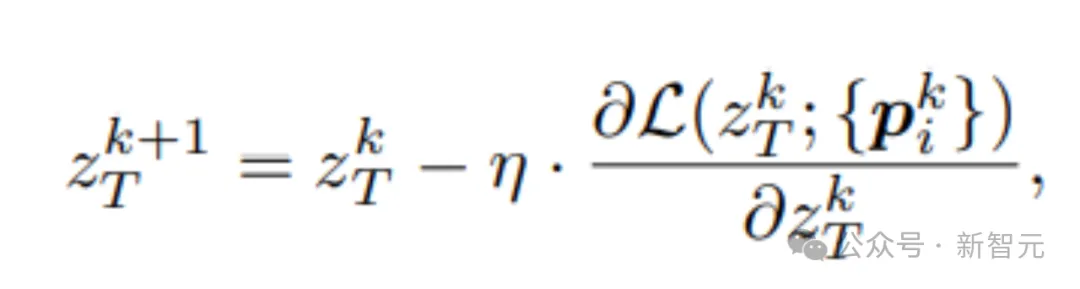

动作监督对当前的latent code进行更新后,得到一步拖动后的新latent code

此时,图像上对应的内容发生了变化,起始点对应的图像内容不一定随着随着拖动路劲改变,可能发生偏离,因此我们需要对当前点进行追踪,得到新的当前点。

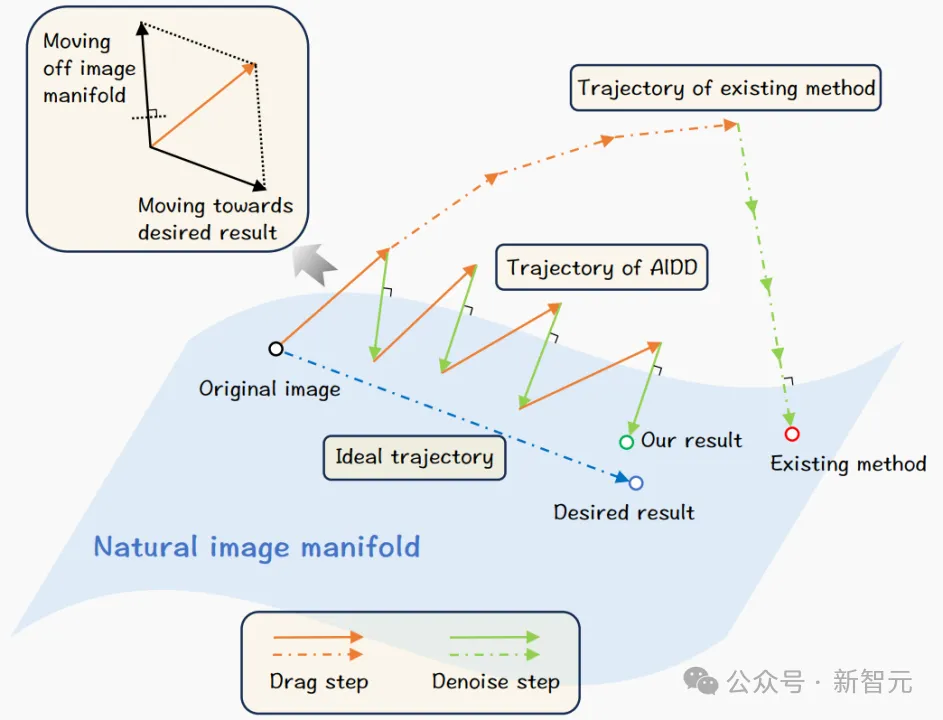

2. AlDD框架

A stitch in time saves nine (小洞不补,大洞吃苦)

当前基于diffusion的拖动编辑方法将所有的拖动操作集中在diffusion去噪的某一步上,然后通过去噪进行修复并得到拖动后的结果。

当大量的拖动编辑加入时,造成的扰动可能过大,从而使diffusion无法修复。我们提出的AlDD框架交替进行拖动编辑和diffusion去噪,有效抵抗拖动所带来的累积扰动,从而得到高质量的图像。

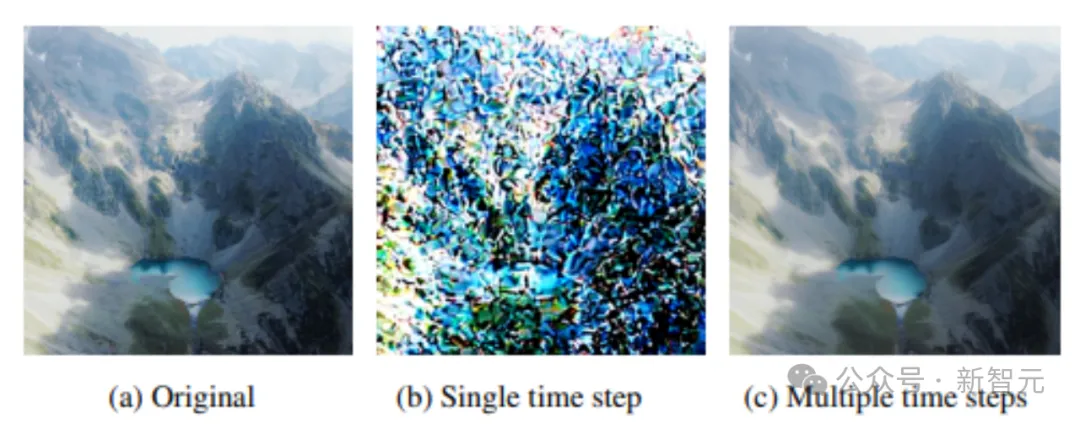

简单实验证明累积误差会对diffusion的去噪生成造成影响。图中未单步denoise加入多个高斯噪声和多步denoise过程每次加入一个高斯噪声,当大量误差累积时,diffusion无法恢复原图,相反,每次少量的扰动可以被diffusion的去噪过程修复。

3. Information-Preserving Motion Supervision

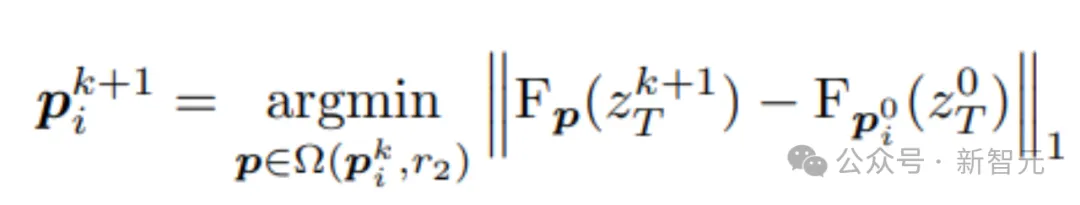

过去基于GAN或者diffusion的拖动编辑将当前追踪点所对应的patch作为下一步motion supervision的目标。

然而,这样的做法忽视了拖动编辑可能是不充分的;或者随着编辑,当前patch的内容由于累积误差发生了偏离。以偏离的patch作为motion supervision目标会进一步导致误差累积,从而进入恶性循环。

文中提出的Information-Preserving Motion Supervision,总是以当前diffusion的time stpe的feature中起始点的patch作为目标,从而进一步避免累积误差对Motion Supervision造成干扰。

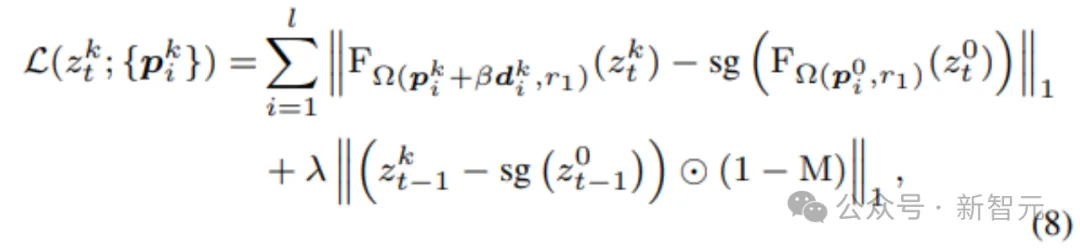

研究人员设计了新的动作监督式,此处pi^0所对应的特征总是作为动作监督目标。

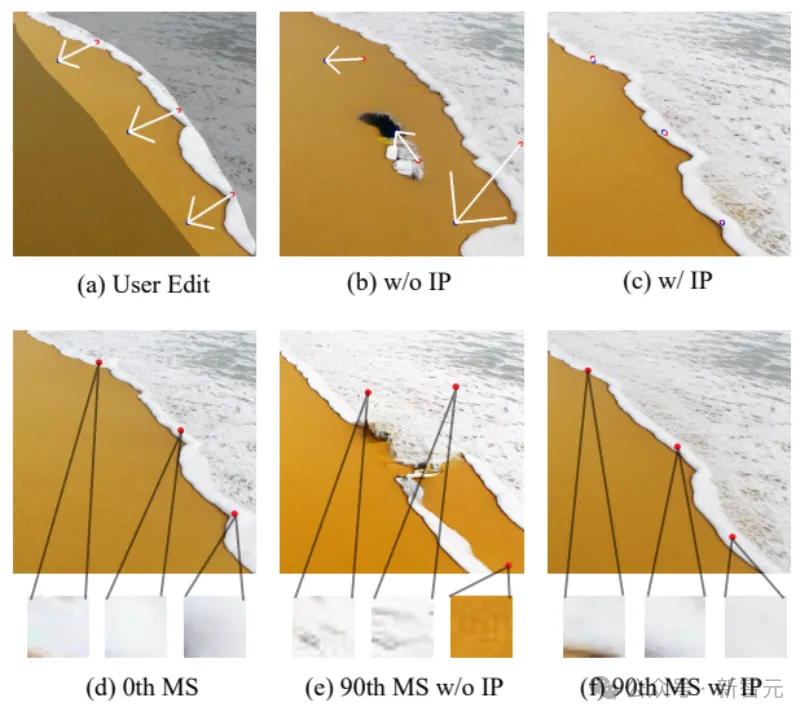

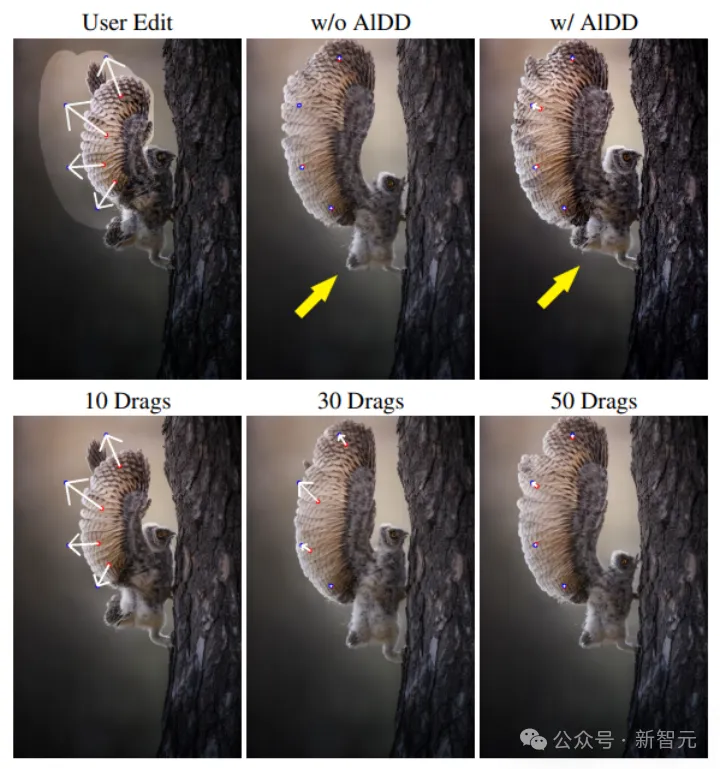

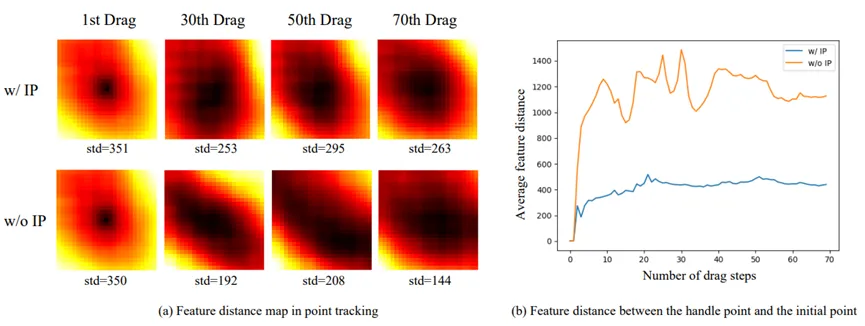

此图中,Information-Preserving Motion Supervision随着拖动编辑进行,其点对应的图像总是和原图像的起始点相符,而非Information-Preserving Motion Supervision则随着拖动Motion Supervision次数增加,对应的目标逐渐偏离原来的图像内容,从而导致结果不佳。

全新基准数据集Drag100

拖动编辑是一种新型的图像编辑手段,缺乏相应的数据集和定量评估方法。我们引入新的数据集Drag100,拖动准确性指数Dragging Accuracy Index (DAI)和图像质量评估分数Gemini Score (GScore)。

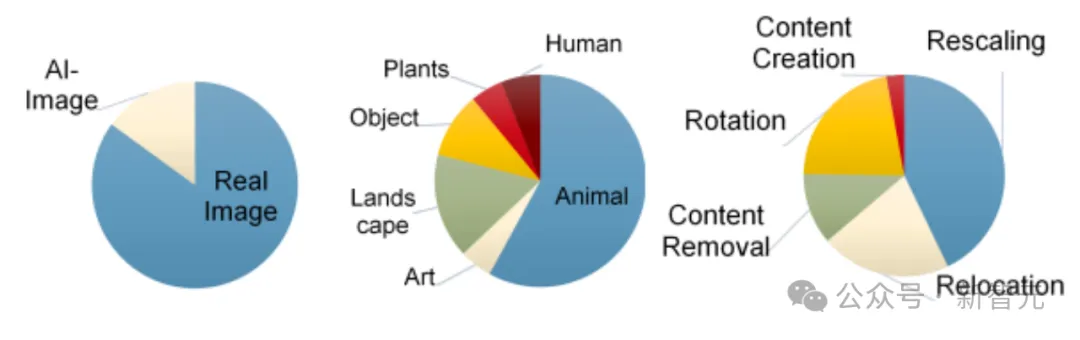

尽管最近的基于diffusion拖动文章提供了一些数据集,Drag100不仅仅考虑图像内容种类的不同,还考虑拖动任务的不同。拖动编辑大致包含以下几,移动,旋转,缩放,内容消除和内容生成。

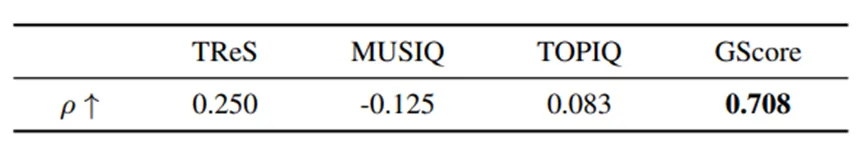

我们比较不同的图像质量评估指标和GScore与人眼判别的相关性。对不同的指标,我们分别计算与问卷人眼图像质量判断结果的Spearman’s rank correlation coefficient(斯皮尔曼等级相关系数)。最后的平均结果如下,GScore表现出高度的正相关,远优于其他图像质量评估指标。

另一方面,为了在开放数据集上评估生成图片的图像质量,我们尝试传统NoReference Image Quality Assessment (NR-IQA)方法,发现此类方法和人眼对图像质量的评估相关性较差。

因此,采用大型多模态模型,引入基于Gemini模型的GScore,以替代大范围测试时对人眼评估的依赖。我们通过问卷证明了GScore与人眼评判具有较高的相关性。

实验结果

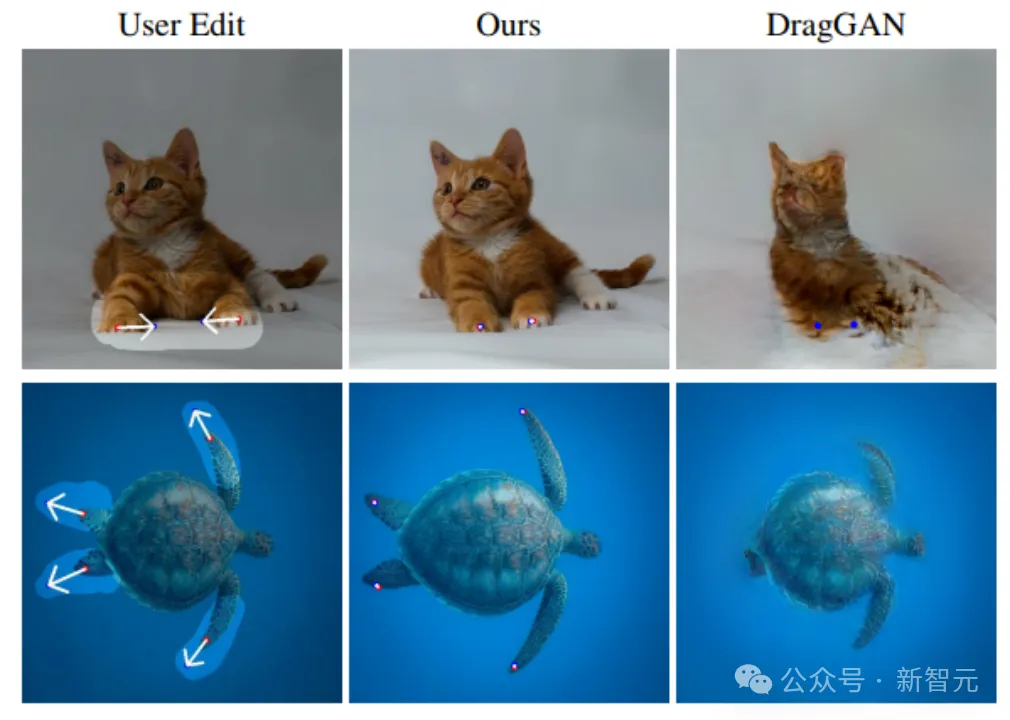

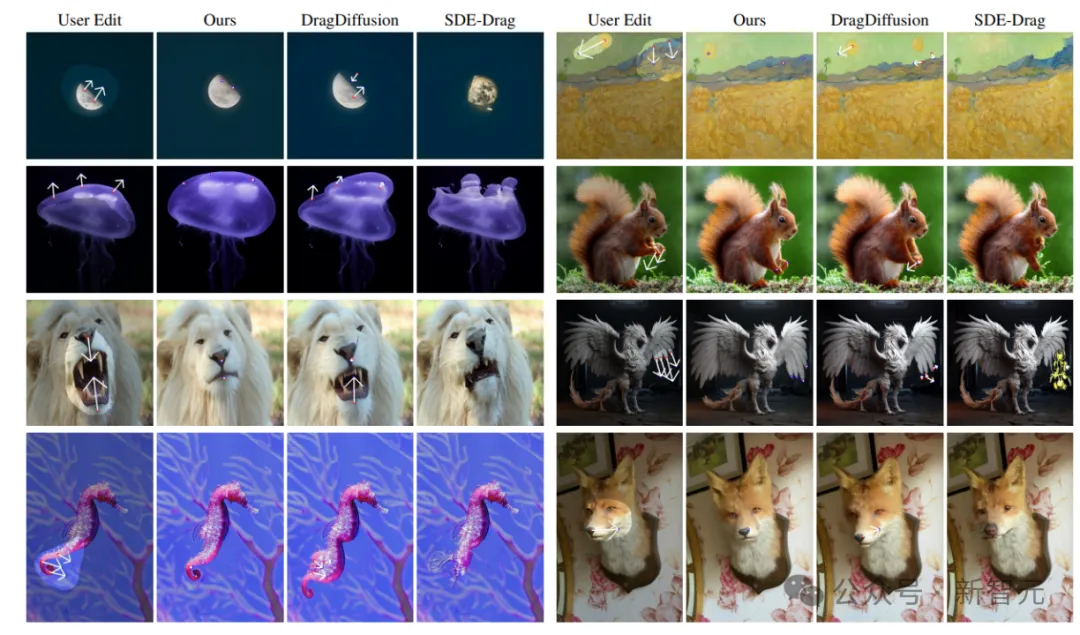

GoodDrag的拖动编辑效果在拖动精确度和图像质量在定性和定量上都超过了现有方法。

部分图像结果:

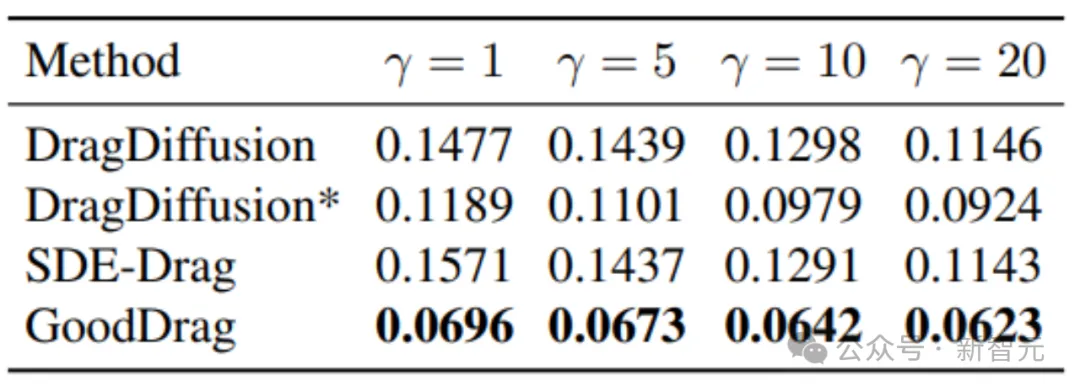

DAI在Drag100上的结果如下,DragDiffusion*增加了DragDiffusion默认的拖动编辑次数:

评估图像质量的GScore如下

此外,研究人员还进行实验验证AlDD和Information-Preserving Motion Supervision的有效性。

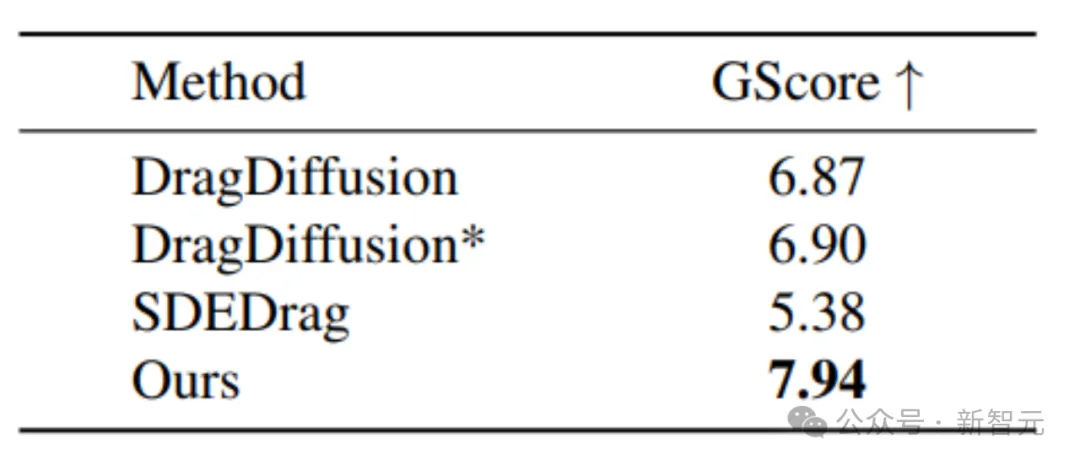

下图为是否采用AlDD框架的比较,使用AlDD可以保留原图的细致纹理,而非AlDD则会使图像失真。

Information-Preserving Motion Supervision可以进一步保证图像质量,也会导致拖动编辑的难度上升,因此我们对每次动作监督进行小learning rate的多次重复。不采用Information-Preserving Motion Supervision会导致目标偏离,从而拖动编辑失败。

以下热力图和折线图进一步说明Information-Preserving Motion Supervision的必要性。在当前的追踪时,Information-Preserving Motion Supervision可以使追踪区域更敏感,如以下热力图(以归一化)所示,Information-Preserving Motion Supervision方法使黑色区域更小,更具锋度,从而提高追踪的准确性。

同时折线图反映了用于追踪的特征和原特征数值上的差异,Information-Preserving Motion Supervision有效保留了原特征的内容。

总结

GoodDrag探索了基于diffusion模型对拖动编辑造成影响的因素。设计了AlDD框架和Information-Preserving Motion Supervision,有效提高了拖动编辑的准确性和图像质量。

此外还为拖动编辑提供了新的数据集Drag100,以及评估准确性DAI和评估图像质量的GScore。

GoodDrag现已开源,提供多种简易运行方式,支持用户使用自己的图片进行尝试:https://gooddrag.github.io/

本文转自 新智元,作者:新智元