QuantAgent:通过自我改进的大语言模型寻找交易中的圣杯

摘要

基于大型语言模型的自主代理在量化投资等专业领域的应用面临挑战,尤其是构建和整合领域特定知识库。本文提出一个两层循环的框架:内层循环通过知识库优化响应,外层循环在真实场景中测试响应并自动增强知识库。该方法使代理能够逐步接近最优行为,并具备可证明的效率。通过名为QuantAgent的自主代理实例化该框架,展示其在挖掘交易信号和提高金融预测准确性方面的能力。

简介

大型语言模型(LLMs)推动了自主智能体的发展,提升其在复杂任务中的能力,尤其在量化投资领域面临知识整合挑战。传统方法依赖于人力构建知识库或通过检索增强生成技术,但在某些领域(如金融alpha数据库)难以实现。

本文提出一个两层框架,旨在以最小人力开发领域特定知识库,采用内外循环系统进行自我改进。内循环通过与模拟环境互动优化响应,外循环通过真实环境反馈丰富知识库,促进性能提升。理论分析表明,该框架在某些假设下高效收敛,结合强化学习的分析技术。实际应用通过QuantAgent实现,专注于金融信号挖掘,构建包含信号、实施细节和绩效指标的知识库。实证结果验证了QuantAgent的自我改进能力,生成了更准确的金融预测信号。

整体框架

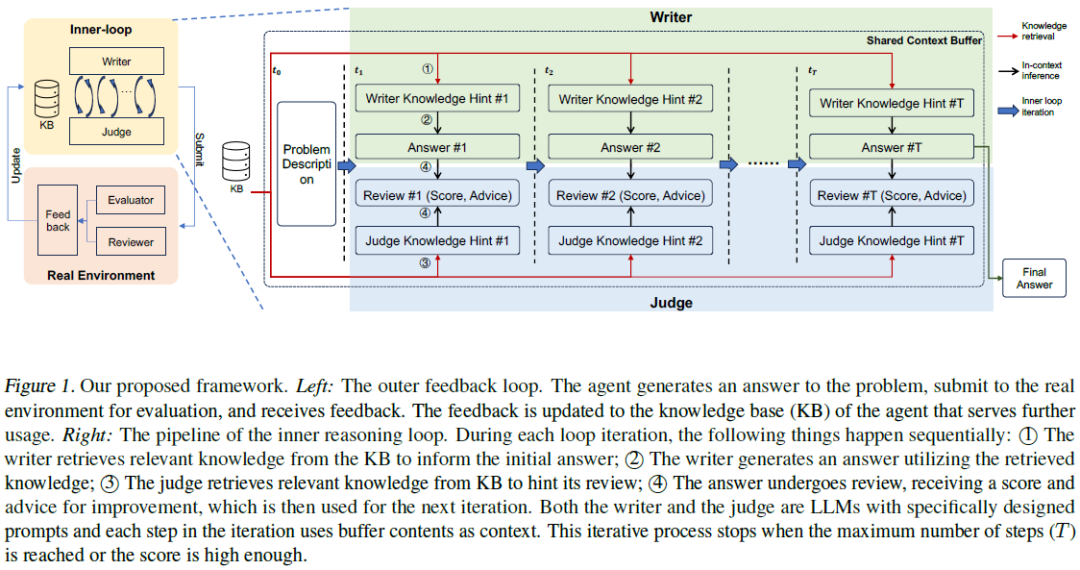

本文提出的框架采用两层架构:外层与真实环境互动,生成的输出经过评估并反馈至知识库,影响后续迭代。内层为推理循环,作家与评审组件进行对话,利用内部知识库进行推理和优化,直到产生满意的解决方案或达到预设阈值。

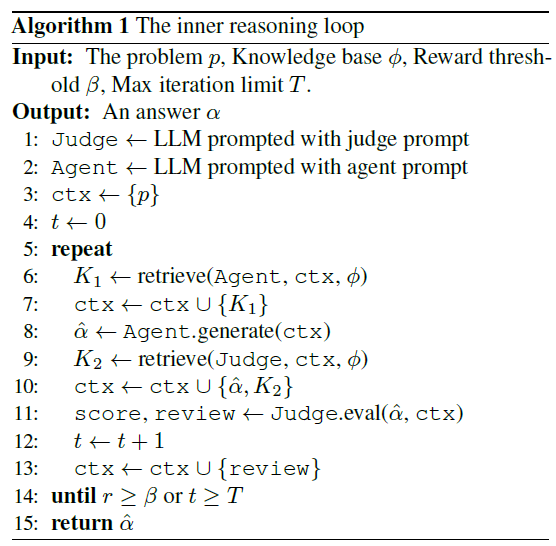

内在推理循环

内循环模拟推理环境,LLM或规则系统与知识库互动。使用内存缓冲区,初始包含用户查询,逐步丰富数据。代理向知识库提问,获取相关信息。评估者(规则集或LLM)检查信息是否满足用户查询。循环在形成响应或满足预设条件时结束。

组件

- 知识库:存储代理的输出记录、性能评分和反馈,通过查询提取信息,优化性能准确性与响应多样性。

- 上下文缓冲区:记录互动过程中的所有交流,确保一致性和连贯性,利用过去知识指导未来回应。

- 写作器:基于知识库数据构建响应,逐步改进输出,整合评估反馈以提升质量。

- 评估者:对写作器输出进行评分,评估效果依赖于知识库质量,关键在于提高输出准确性。

过程

单次迭代中,作者从知识库获取信息,形成回应。评审者对回应进行评分和反馈,反馈被纳入上下文以改进下一次回应。迭代过程依赖信息积累,逐步提升回应质量,直到达到预定性能阈值或确定最佳回应。内部循环的原则是通过有效的回应生成机制,作者在多次迭代中积累足够信息以满足评审标准,最终产生最佳答案。

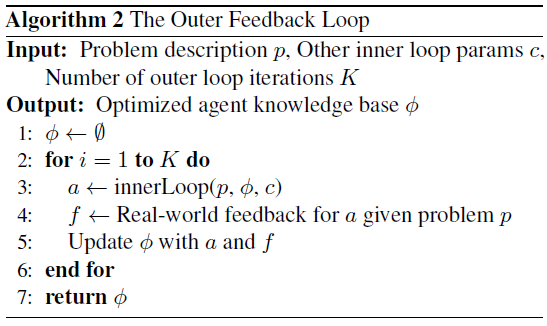

外部反馈循环

- 外循环:代理与真实环境的迭代交互,生成输出并进行评估与改进。

- 环境反馈:提供性能评分和定性评审,注入新见解以提升决策过程。

- 知识更新:反馈后更新知识库,进行完整性检查,确保信息的相关性和多样性。

- 内外循环对比:内循环评估快速且成本低,但精度较低;外循环反馈更为精准但资源消耗大。

随着外循环迭代增加,内循环评估者积累经验,逐步提高评估和反馈的精度。

与现有方法的比较

现有方法可视为我们框架的具体实现。去掉外循环后,自我精炼方法可视为两个LLM作为演员和评论者的形式,可能有或没有知识库。若将内循环简化为基础的检索增强生成过程,则可实现许多自我改进方法,如Voyager和FunSearch。

分析

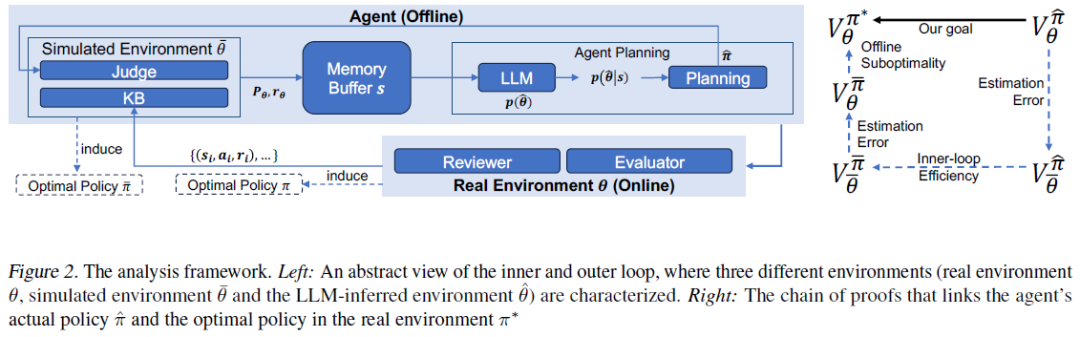

本节分析算法的效率,确保其能渐进收敛到最优解。评估成本,包括代币成本和推理时间成本。目的是理解系统设计组件的影响,分析其在现实世界中的可部署性。

效率

代理算法的效率分为内循环和外循环两个层面。

- 内循环效率:代理在当前知识库下能找到最佳答案。

- 外循环效率:模拟环境中的最优策略与现实世界的性能差距随着迭代增加而收敛。

两者结合保证策略收敛到全局最优,证明代理算法的效率。接下来将介绍问题的具体表述。

建模

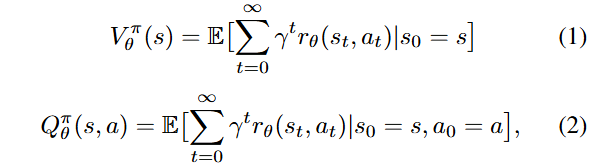

生成答案的过程被建模为马尔可夫决策过程(MDP),由状态空间S、动作空间A、转移函数T、奖励函数r和折扣因子γ组成。

- 状态s_t包含原始问题p和共享上下文信息,初始状态为空集,称为信息状态。

- 动作A与作者相关,包括生成答案和知识库查询,影响信息状态。

- 转移函数T描述在当前状态下执行动作后信息状态的变化,涉及知识库响应和评审过程。

- 奖励函数r为信息状态分配值,可能是连续值或0/1值,表示答案的有效性。

- 折扣因子γ影响未来奖励的权重,确保值函数V_θ^π(s)有界。

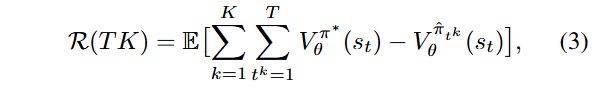

目标是学习一个策略,最大化所有状态的值函数,以获取足够的信息回答用户问题。证明代理在内外循环中高效,贝叶斯遗憾R(K)在KT中是次线性的。

内循环

假设4.1。LLM在上下文推理步骤中隐式执行环境参数θ的贝叶斯推断,基于信息状态s和预训练知识p(θ)。

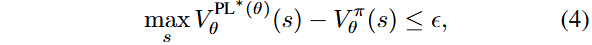

定义4.2。在参数化为θ的环境中,策略π满足ϵ-最优性的条件是最大值与策略π的价值差异小于6。

引理4.3。内循环中规划代理的贝叶斯遗憾在内循环迭代次数T上是次线性的。

证明直觉。LLM推断作为隐式贝叶斯推断,随着信息的增加,参数估计越来越准确,最终收敛到最优策略。

一次性方法缺乏效率的理论保证,因其信息不随迭代累积,但在实践中效果良好,表明一次性信息差距可能不大。

外循环

外部循环的效率源于悲观假设,认为可以通过悲观主义训练知识库上的最优策略。离线学习的最佳策略与在线最佳策略之间的性能差距可以通过信息差界定,前提是离线策略是通过悲观学习获得的。

假设4.4。在由离线知识库表征的模拟环境中,可以通过悲观值迭代(PEVI)获得最优策略π ¯。

引理4.5。在假设4.4下,π ¯与真实环境中的最优策略π ∗之间的性能差距受限于知识库覆盖不足引起的内在不确定性。

随着知识库积累更多关于真实环境的信息,模拟环境将更接近真实环境,使用悲观方法训练的最优策略的性能差距也会收敛。

总体结果

定理4.6。LLM代理在真实环境中的贝叶斯遗憾R(TK)是KT的次线性。

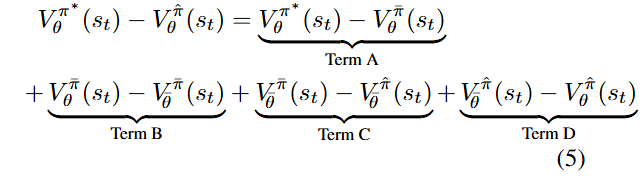

证明概要。性能差距可分解为多个项,具体包括V_0^*、V_0^f、v_0^π等。

假设4.4下,项A和B受离线数据集内在不确定性的限制,次线性于K(在简单假设下)。项D受信息差距限制,次线性于K。项C根据引理4.3,次线性于T。整体左侧和在公式3中求和后,次线性于KT。

成本分析

自我改进阶段的内循环令牌成本为O(T²H),外循环迭代K次的累积成本为O(KT²H)。推理阶段的令牌成本为O(T²H),假设生成响应的复杂度与训练相似。外循环每次迭代的时间成本为O(T(H + Const)),K次迭代的总时间为O(KTH)。推理阶段的时间复杂度降低为O(HT)。

实验

背景

任务是金融信号挖掘,旨在从金融市场数据中计算出可用于预测的信号。设计金融信号需要市场理解、编码能力和数学技能(如数值分析)。目标是获得高预测能力的金融信号。希望获得多样化的信号,以便构建机器学习模型进行更好的预测。

问题

目标。生成反映交易理念且表现良好的金融信号。

交易理念。从分布中采样,由另一个LLM生成。

实现。金融信号为代码(函数),遵循预定义模板。

数据集。500只中国A股,2023年市场数据(每日收盘价和成交量)。

基础LLM。选择gpt-4-0125-preview版本。

评估指标

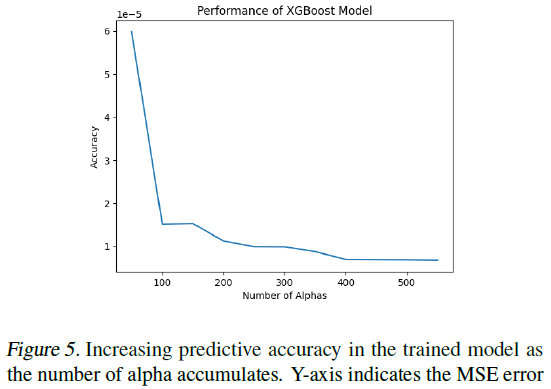

通过计算信息系数(IC)评估金融信号的预测能力,IC为皮尔逊相关系数,跨时间点平均。使用XGBoost回归树模型生成信号,检验知识库(KB)作为信号生成基础数据集的有效性。

分析信号的夏普比率,以评估其投资回报能力。评估信号的数值质量,包括有效和独特实体的数量,确保信号能区分股票。通过LLM进行信号的对比评估,构建胜率矩阵,排名不同代理在信号生成中的表现,反映其对交易理念的捕捉能力。

结果

自我提升的证据

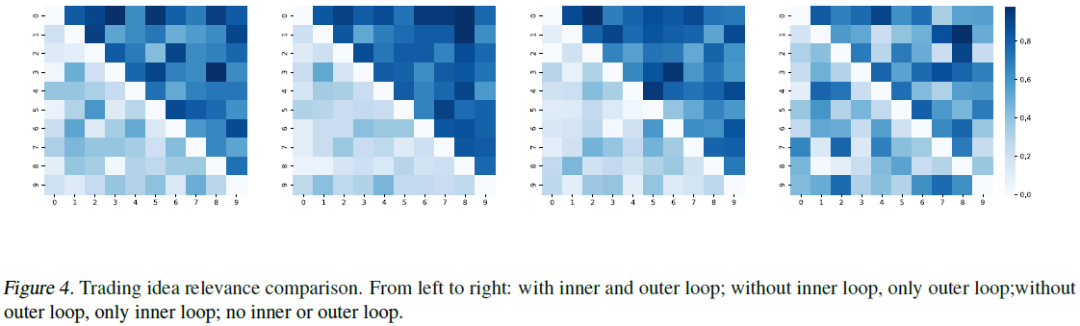

训练累积信号和单独段落的alpha表现出一致的性能提升,预测准确性提高。随着模型自我改进,代理生成更强信号,增强预测能力。信号质量通过生成迭代排序和分组比较,评估其传达交易理念的准确性。胜率分布图显示,模型进化过程中,代理在生成高质量信号方面技能提升。右侧矩阵的递减模式表明自我提升的有效性。

提高Alpha相关性

为了衡量信号质量,我们根据生成的迭代对整个过程中产生的信号进行分类,并根据GPT-4判断,将它们划分为数量相等的组,以便在准确传达潜在交易思想方面进行比较。图4显示了胜率的分布。胜率累积到右上角的模式表明,随着模型的发展,智能体在编写高质量信号方面获得了更好的技能,验证了内循环和外循环的有效性。

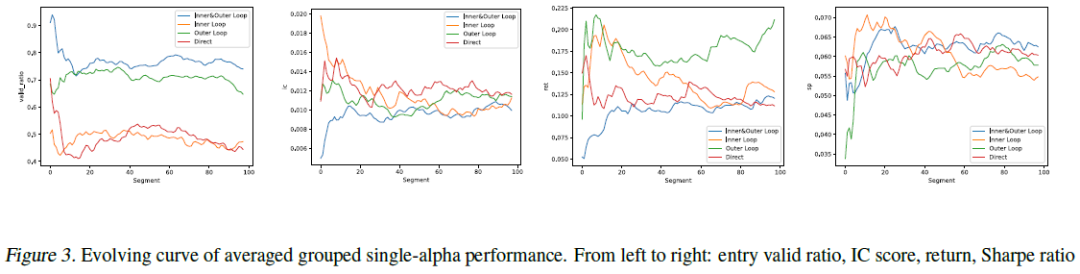

内循环和外循环的影响

图3展示了单一α属性在整个过程中的演变。尽管性能差异不明显,蓝色曲线的趋势显示了自我改进在各项指标上的有效性。

总结

自主代理在量化投资中表现出自我改进和适应能力,展示了其在金融分析和风险管理中的潜力。这些技术可扩展至医疗和物流等复杂领域,通过定制知识库和反馈机制。面临的挑战包括对知识库质量的依赖和计算优化需求。未来将致力于提高学习效率、拓展应用场景及实时适应动态环境。LLM基础的代理有望革新各行业的决策过程,推动智能自动化时代的到来。

本文转载自灵度智能,作者:灵度智能