视觉"顿悟时刻"被破解!MM-Eureka:大规模强化学习触发多模态模型能力涌现

Code:https://github.com/ModalMinds/MM-EUREKA

Model:https://huggingface.co/FanqingM/MM-Eureka-Zero-38B

https://huggingface.co/FanqingM/MM-Eureka-8BDataset:

https://huggingface.co/datasets/FanqingM/MM-Eureka-Dataset

Why We DO?

目前的研究大多未能在多模态环境中复现DeepSeek-R1的关键特性,如回答长度的稳定增长和准确率奖励。例如,R1-V仅在简单计数任务上有所改进,但未能复现回答长度增长和"顿悟时刻";R1-Multimodal-Journey探索了几何问题,但随着训练进行,回答长度反而下降;LMM-R1虽然在准确率奖励和回答长度方面取得了进步,但这种成功尚未在大规模图文数据训练中得到验证。虽然Kimi1.5在多模态推理中取得了有竞争力的结果,但它并未向社区开源其模型或训练数据。

What We do?

开源框架:我们基于OpenRLHF构建了一个可扩展的多模态大规模强化学习框架,支持包括InternVL在内的多种模型和多种RL算法。与R1-V等框架相比,我们的框架具有更强的可扩展性,成功训练了InternVL2.5-38B等大型模型

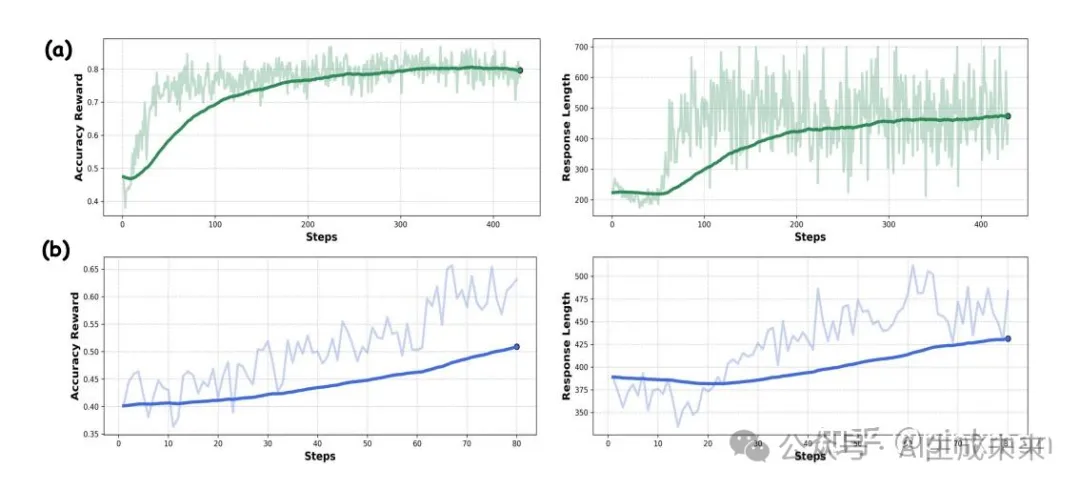

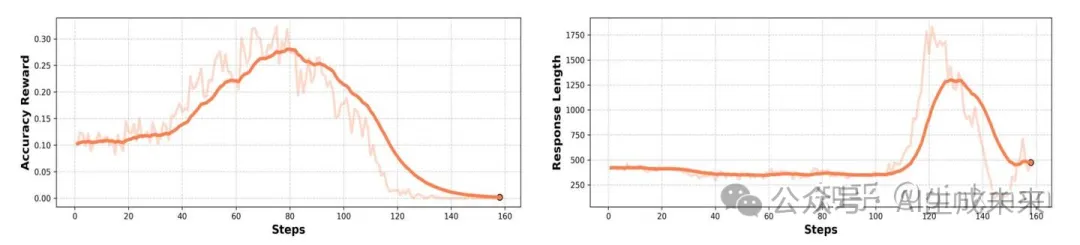

稳定的训练:MM-Eureka-8B基于InternVL2.5-Instruct-8B开发,MM-Eureka-Zero-38B基于InternVL2.5-Pretrained-38B开发。两者均可以复现出稳定的accuracy reward以及response length增长,并且具备visual aha-moment!

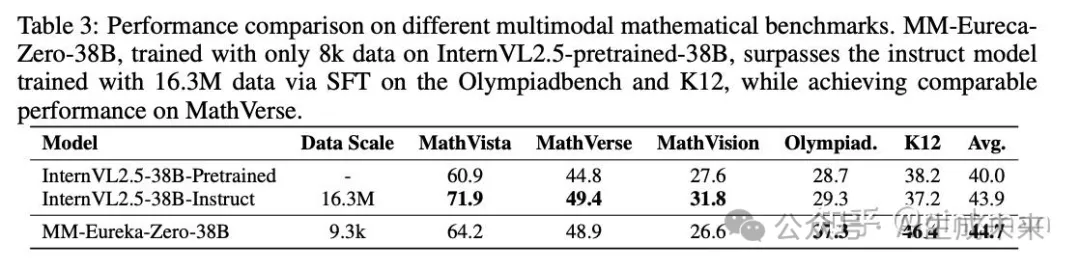

惊人的数据效率:仅使用54K图文数据进行规则型RL训练,平均性能超过使用1M数据的MPO模型;整体基准准确率与使用12M数据进行CoT SFT训练的模型相当! MM-Eureka-Zero仅使用8K图文数学推理数据(仅为指令模型的0.05%),在我们自己构建的K12基准测试上比指令模型高出8.2%,在MathVerse上表现相当

What is Important?

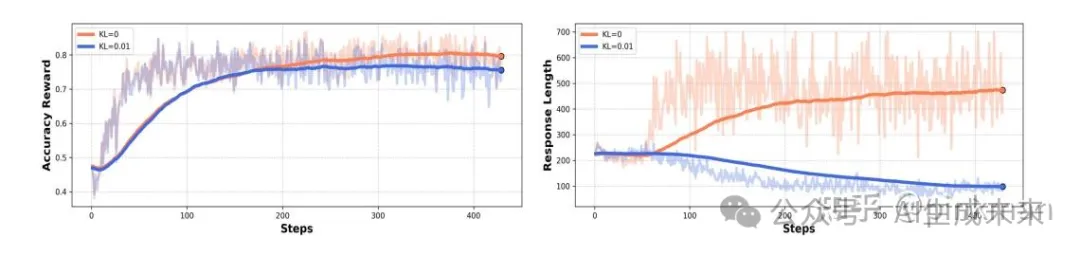

极简的RL设计足以获得很好的效果,如果是在instruct model上进行实验,添加KL散度往往会限制模型的探索,导致无法观测到response length的提高。

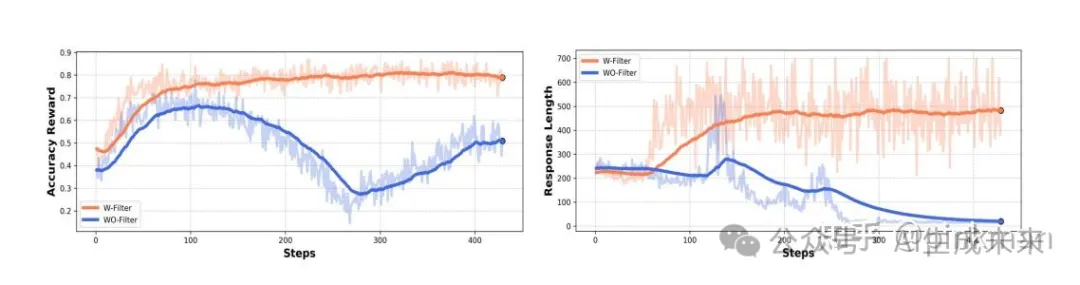

基于难度的数据过滤策略对于RL训练稳定性及其重要,我们发现在8B-instruct模型上训练,如果不进行数据过滤,RL的训练将会非常不稳定。

What We Find?

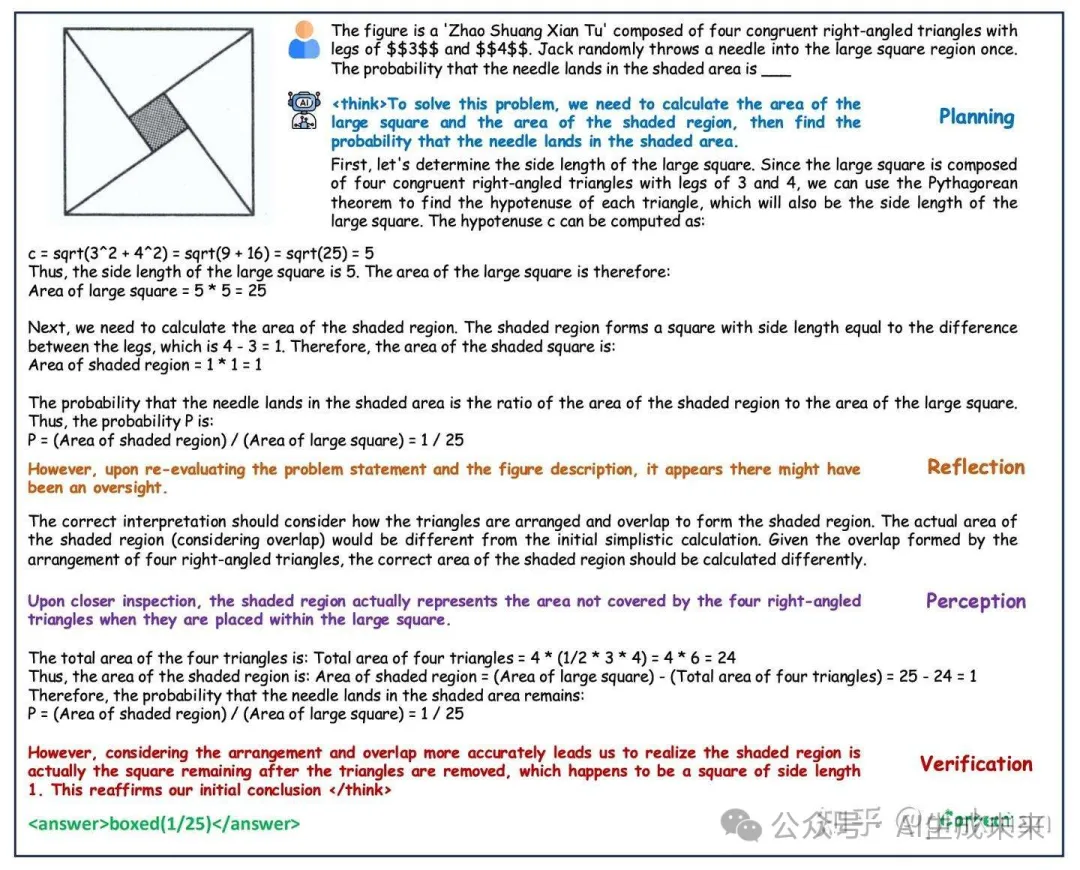

模型在RL训练的过程中同样会展示出类似DeepSeek-R1的aha-moment。特别得是:除了展示出反思和回溯操作,模型还学会了重新审视图像中的关键信息,我们认为这个是visual aha moment的关键特征

What We Wanna Do?

我们在复现过程中进行了许多其他的尝试,再次我们分享一些我们认为有帮助,但是并没有work的操作,我们认为这并不代表这些有问题,而是需要进一步地探索。

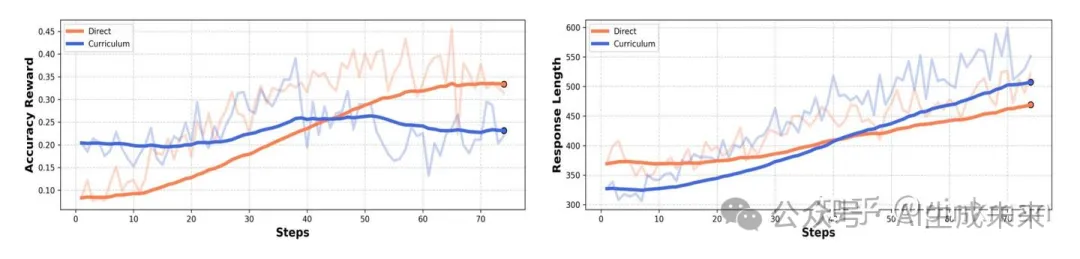

Curriculum Learning:

得益于我们基于难度划分数据,每个数据都有难度标签,自然的我们把数据按难度从低到高进行RL训练,然而我们发现这并不能使得性能获得收益。我们认为这是因为模型在简单题目上的学习难以直接泛化到难题,如何进行curriculum learning的数据组织仍然重要。

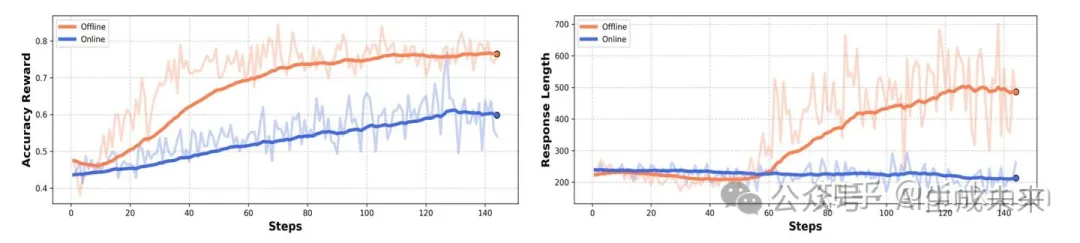

Online Data Filter:

我们将我们预先基于难度的数据筛选策略记为Offline Data Filter。这种方案虽然可以帮助RL进行稳定训练,但是其数据利用率降低了,所以我们希望在模型训练的过程中动态进行基于难度的数据筛选(类似PRIME)。但是我们发现训练结果并不如offline data filter稳定,我们认为这是因为每次更新时候的数据量不同,导致梯度不稳定。

Model Size:

尽管目前一些工作比如ORZ,SimpleRL在7B level的LLM上也复现了R1的表现,但是我们在多模态推理场景下,难以通过8B的internvl pretrained进行成功复现。我们认为这受制于多模态推理数据质量以及多模态预训练数据中很少存在long cot数据。

What We Hope?

我们开源了全套数据(包括我们自助收集的多模态K12数据集),代码,以及模型等。除此之外我们推出一个详细的技术报告(在我们的repo中),包括我们所有的复现程序以及一些未成功的尝试。我们希望这可以帮助社区共同推理多模态推理发展。

本文转自AI生成未来 ,作者:AI生成未来

原文链接:https://mp.weixin.qq.com/s/5c3q3Z9coOdC_L1t7Nw6wQ