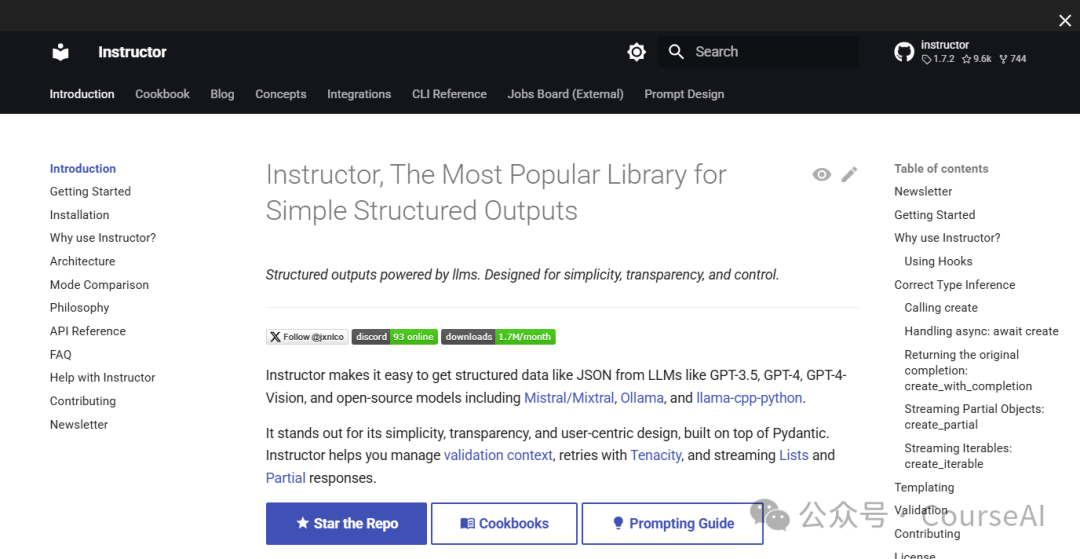

9.6K Star防翻车指南:Instructor让AI输出错误率归零!

Instructor是一个用于处理大型语言模型(LLMs)结构化输出的库,基于Pydantic构建,支持多种LLM。

- 主要功能包括验证、重试管理、流式响应等。

- 主要目的是简化与LLM交互时的结构化输出处理,避免手动解析文本带来的麻烦。

优点:

- 通过 Pydantic 模型定义输出结构,直接映射 LLM 的响应到类型安全的 Python 对象。例如,从自然语言中提取用户信息时,只需定义

User(name: str, age: int) 模型,即可自动解析并验证结果 - 支持 OpenAI、Anthropic、Cohere、Google AI、Llama.cpp 等多种模型后端,且与 Litellm 等平台兼容,支持编程语言(如 TypeScript、Go)适应不同技术栈

- 利用 Pydantic 的验证功能确保输出符合预期,同时内置重试逻辑(如 Tenacity),在模型响应不达标时自动重试请求,提高可靠性

- 支持流式处理部分响应和列表数据,适用于实时场景(如逐词生成),并提供异步接口(

async/await)以优化性能 - 通过

instructor.from_openai() 等函数无缝集成到现有 OpenAI SDK 代码,仅需添加response_model 参数即可启用结构化输出,无需重构 - 提供 CLI 工具管理微调任务、文件上传和使用监控,并支持钩子系统拦截 LLM 交互日志,便于调试

缺点:

- 对Pydantic的依赖可能带来一定的学习成本。

- 底层解析过程封装较深,某些情况下错误信息可能不够直观,增加调试难度

- 部分 LLM 提供商(如 Ollama)可能需要额外配置,且版本更新可能引入兼容性问题

Instructor与outlines、lm-format-enforcer的区别

库 | 核心目标 | 技术路径 |

Instructor | 将 LLM 的非结构化输出解析为强类型数据结构(如 Pydantic 模型),侧重输出验证与转换 | 基于 Pydantic 的静态类型校验 + 模型后处理(如重试、修正) + 多模型后端支持 |

Outlines | 通过约束生成过程,直接让 LLM 输出符合指定格式的文本(如 JSON、正则表达式),侧重生成控制 | 基于有限状态机(FSM)的动态生成约束 + 确定性解码策略(如正则引导) + 底层模型直接控制 |

lm-format-enforcer | 在生成阶段直接约束 LLM 的输出格式(如 JSON、正则表达式),避免无效输出 | 基于 前向预测(Lookahead) 动态限制 token 选择 + 语法树约束 + 本地模型集成 |

如何选择这两款工具呢?

- Instructor:

a.需要从已有文本或自由生成结果中提取结构化数据,更适合后处理。

b.希望快速集成到 OpenAI 等云服务,且不想管理本地模型。

c.熟悉 Pydantic 并偏好静态类型校验。

from pydantic import BaseModel

import instructor

from openai import OpenAI

client = instructor.from_openai(OpenAI())

class User(BaseModel):

name: str

age: int

# 调用 LLM 并直接解析为 User 对象

user = client.chat.completions.create(

model="gpt-3.5-turbo",

response_model=User,

messages=[{"role": "user", "content": "小明今年25岁"}]

)

print(user.name)- Outlines:

a.需要生成严格格式的文本(如 API 请求、代码)。

b.使用本地模型(如 Llama、Mistral)且能接受复杂约束定义。

c.追求生成阶段的确定性,避免无效输出的重试开销。

from outlines import models, generate, samplers

import torch

model = models.transformers("gpt2", device="cpu")

prompt = "生成用户信息JSON:"

schema = '''{

"name": string,

"age": int

}'''

# 动态约束生成

generator = generate.json(model, schema)

result = generator(prompt, sampler=samplers.greedy())

print(result) # 直接输出符合 schema 的 JSON- lm-format-enforcer与Outlines比较类似:

a.需要生成严格符合语法(如 JSON、代码)的文本。

b.使用本地模型(如 Llama、Mistral)且追求生成效率。

c.能接受较高的集成复杂度(需直接操作模型和约束定义)。

from lm_format_enforcer import JsonSchemaParser

from transformers import pipeline

# 定义 JSON Schema 约束

schema = {

"type": "object",

"properties": {

"name": {"type": "string"},

"age": {"type": "integer"}

}

}

# 初始化模型和格式解析器

model = pipeline('text-generation', model='gpt2')

parser = JsonSchemaParser(schema)

# 生成时强制符合约束

output = model(

"生成用户信息JSON:",

prefix=parser.get_initial_prompt(), # 注入格式约束

max_new_tokens=100,

format_enforcer=parser

)

print(output[0]['generated_text']) # 输出直接符合 schema 的 JSONhttps://python.useinstructor.com/

https://github.com/instructor-ai/instructor

本文转载自CourseAI,作者:CourseAI