在消费级硬件上微调 DeepSeek-R1

本篇是 DeepSeek 相关系列的第一篇,对 DeepSeek-R1 等大型 AI 模型进行微调可能需要大量资源,但使用正确的工具,可以在消费级硬件上进行高效训练。让我们探索如何使用 LoRA(低秩自适应)和 Unsloth 优化 DeepSeek-R1 微调,从而实现更快、更具成本效益的训练。

DeepSeek 最新推出的 R1 模型在推理性能方面树立了新的行业标杆,其表现可与许多专有模型相媲美,但与此同时,它依然保持了开源的特性,使得更多的开发者和研究者能够访问并基于这一平台进行创新。DeepSeek-R1 的一个特别值得注意的特点是其精简版本,该版本是在 Llama 3 和 Qwen 2.5 两个先进的基础模型之上训练而成的。这种设计不仅保留了原始模型的强大功能,还通过优化进一步提高了效率。更令人兴奋的是,这个精简版的 DeepSeek-R1 已经针对 Unsloth 框架进行了高度优化。Unsloth 是一个专门为促进高效模型调整而开发的工具集,它允许用户以更低的成本、更快的速度对模型进行个性化定制。这意味着无论是学术界还是工业界的从业者,都可以利用 Unsloth 来快速地根据特定应用场景的需求对 DeepSeek-R1 进行微调,从而实现更好的性能或满足特殊需求。总之,通过结合最新的研究成果以及强大的技术支持,DeepSeek R1 正引领着新一轮的人工智能技术革新。⚙️🧠🚀

在这篇博文中,我们将逐步指导如何在消费级 GPU 上使用LoRA(低秩自适应)和Unsloth对DeepSeek-R1 进行微调。💻📈🔥

理解 DeepSeek-R1

DeepSeek-R1 是由 DeepSeek 团队开发的一款开源推理模型,它在多个领域展现出了卓越的能力。该模型特别擅长处理需要复杂逻辑推理、数学问题解决以及实时决策的任务。这些特性使得 DeepSeek-R1 成为了科学研究、工程设计、教育等多个行业的宝贵工具。🧐📊✅与传统的大型语言模型(LLM)相比,DeepSeek-R1 的一大亮点在于其推理过程的高度透明性。这意味着用户不仅能够得到最终的结果,还可以清晰地了解模型是如何一步步得出这个结论的。这种透明度极大地提高了模型输出结果的可信度,并且对于那些对算法可解释性有着严格要求的应用场景来说至关重要。例如,在医疗诊断支持系统中,医生们希望能够清楚地知道人工智能建议背后的理由;在金融风险管理领域,监管机构也需要能够审核和理解自动决策系统的运作机制以确保合规性和公平性。

此外,由于是开源项目,DeepSeek-R1 也鼓励社区内的开发者参与到模型的持续改进过程中来。这不仅有助于发现并修复潜在的问题,还能促进新功能的研发,从而让整个生态系统变得更加丰富多样。总之,无论是从性能表现还是开放合作的角度来看,DeepSeek-R1 都是一款非常值得关注和探索的先进推理模型。

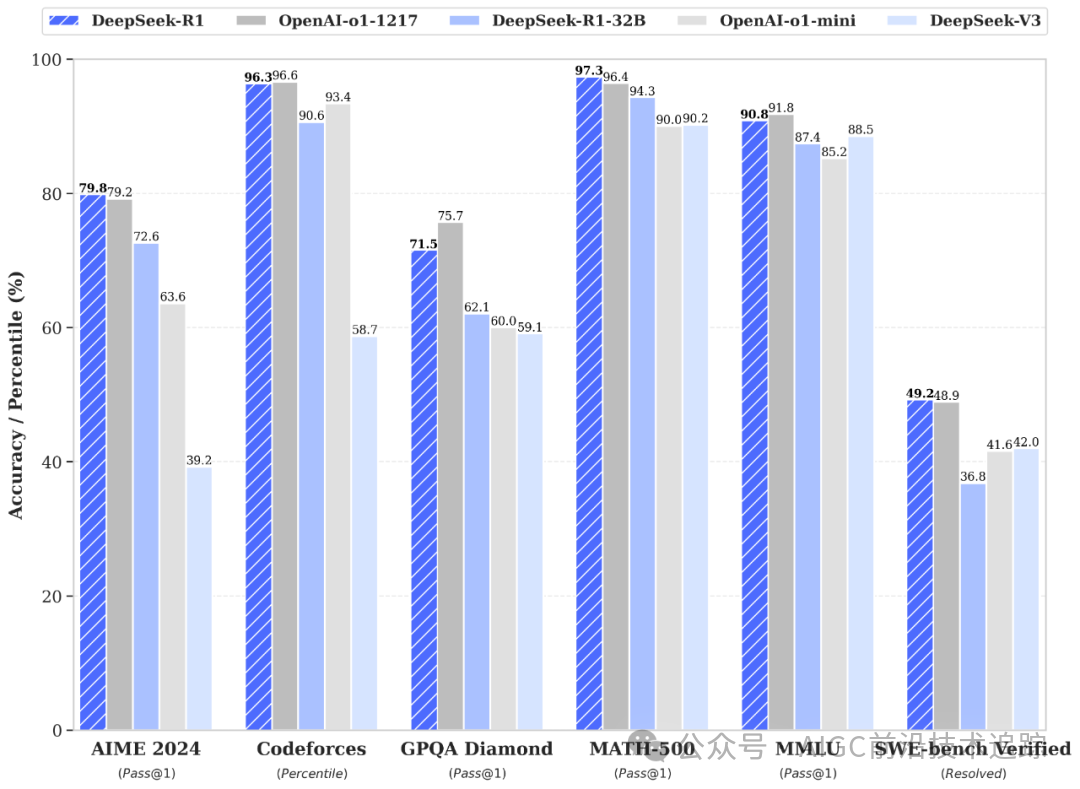

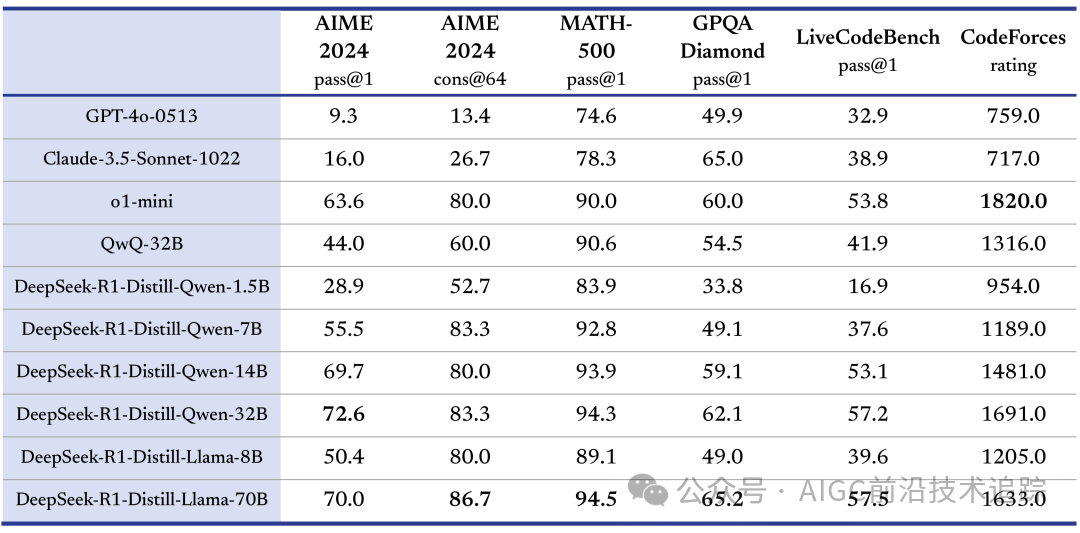

蒸馏小模型超越 OpenAI o1-mini

深度求索在开源 DeepSeek-R1-Zero 和 DeepSeek-R1 两个 660B 模型的同时,通过 DeepSeek-R1 的输出,蒸馏了 6 个小模型开源给社区,其中 32B 和 70B 模型在多项能力上实现了对标 OpenAI o1-mini 的效果。⚖️🧐🚀

HuggingFace 链接: https://huggingface.co/deepseek-ai

为什么需要微调?🎯🔍💡

微调是将 DeepSeek-R1 等通用语言模型适应特定任务、行业或数据集的关键步骤。

这就是为什么微调很重要:

- 领域特定知识:预训练模型是在大量通用知识的基础上进行训练的。微调可实现医疗保健、金融或法律分析等特定领域的专业化。🏥💰⚖️

- 提高准确性:自定义数据集可帮助模型理解小众术语、结构和措辞,从而获得更准确的响应。🎯✅📊

- 任务适应:微调使模型能够更高效地执行聊天机器人交互、文档摘要或问答等任务。🤖📜💬

- 减少偏差:根据特定数据集调整模型权重有助于减轻原始训练数据中可能存在的偏差。⚖️🧐🚀

通过对 DeepSeek-R1 进行微调,开发人员可以根据自己的特定用例进行定制,从而提高其有效性和可靠性。🔧💡📈

微调中的常见挑战以及如何克服它们🔥🔍💡

微调大规模人工智能模型面临着多项挑战。

以下是一些最常见的问题及其解决方案:

1. 计算限制

挑战:对大型语言模型(LLM)进行微调通常需要具备大量视频随机存取存储器(VRAM)和内存资源的高端图形处理单元(GPU)。解决方案:为降低计算需求,可以采用低秩适应(LoRA)技术与4位量化方法。此外,将部分处理任务卸载至中央处理器(CPU)或利用云服务(例如 Google Colab、Amazon Web Services、阿里云等)也是有效策略之一。

2. 小数据集上的过度拟合

挑战:在规模较小的数据集上进行模型训练时,可能会遇到过拟合的问题,即模型倾向于记忆训练数据中的特定模式,而非学习到能够泛化至未见数据的一般规律。解决方案:为缓解这一问题,可以采用数据增强技术以扩充训练样本的多样性,并结合正则化策略(例如Dropout或提前停止Early Stopping)来进一步控制模型复杂度,从而提高其对新数据的泛化能力。

3. 长时间训练⏳⚡🔧

挑战:依据硬件配置及数据集规模的不同,微调过程可能耗时数日至数周不等。解决方案:通过采用梯度检查点技术和低秩适应(LoRA)方法,可以在显著缩短训练时间的同时,确保模型的性能不受影响。

4. 灾难性遗忘⚠️📉🚀

挑战:在微调过程中,模型有可能会丧失其在预训练阶段所获得的一般性知识。解决方案:为解决这一问题,建议采用一种混合数据集进行微调,该数据集不仅包含了领域特定的数据样本,还融合了一定量的通用知识相关的数据。这种方法有助于维持模型对广泛知识的理解能力,同时也能增强其针对特定领域的性能,从而保证整体模型的准确性和泛化能力。

5. 微调模型中的偏差⚖️🧐🤖

挑战:微调模型可能继承训练数据集中的偏见。解决方案:构建一个多样化且无偏的数据集,采用去偏技术,并利用公平性指标对模型进行评估。

有效应对这些挑战可确保稳健、高效的微调过程。🔧📈🔥

设置环境

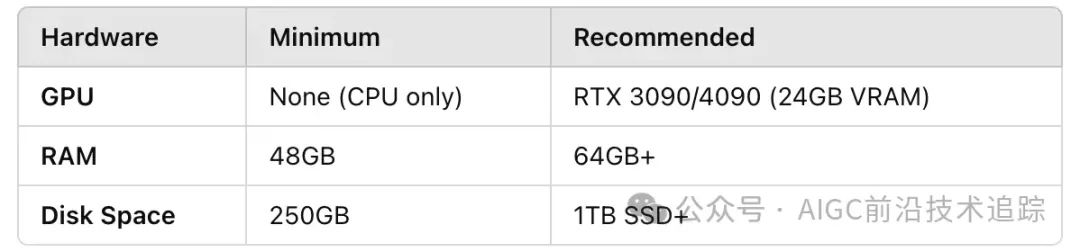

硬件要求

微调大型语言模型 (LLM) 需要大量计算资源。以下是推荐的配置:🛠️💾🔥

软件安装

确保你拥有Python 3.8+并安装必要的依赖项:🏗️📥💡

pip install unsloth torch transformers datasets accelerate bitsandbytes加载预先训练的模型和标记器🎯📖🛠️

使用Unsloth ,我们可以高效地以4-bit量化加载模型,以减少内存使用量。💾⚙️🚀

from unsloth import FastLanguageModel

model_name = "unsloth/DeepSeek-R1-Distill-Llama-8B-unsloth-bnb-4bit"

max_seq_length = 2048

model, tokenizer = FastLanguageModel.from_pretrained(

model_name=model_name,

max_seq_length=max_seq_length,

load_in_4bit=True,

)准备你的数据集

微调需要结构化的输入输出对。让我们假设一个用于指令跟踪任务的数据集:🏗️📋🚀

{"instruction": "What is the capital of France?", "output": "The capital of France is Paris."}

{"instruction": "Solve: 2 + 2", "output": "The answer is 4."}

# {"指令":"法国的首都是哪里?","输出":"法国的首都是巴黎。"}

# {"指令":"解答:2 + 2", "输出":"答案是 4。"}使用Hugging Face 的datasets库加载数据集:📚🔍💡

from datasets import load_dataset

dataset = load_dataset("json", data_files={"train": "train_data.jsonl", "test": "test_data.jsonl"})使用聊天样式的提示模板格式化数据集:💬✍️🤖

prompt_template = """Below is an instruction that describes a task. Write a response that appropriately completes the request.

### Instruction:

{instruction}

### Response:

"""

def preprocess_function(examples):

inputs = [prompt_template.format(instructinotallow=inst) for inst in examples["instruction"]]

model_inputs = tokenizer(inputs, max_length=max_seq_length, truncatinotallow=True)

return model_inputs

tokenized_dataset = dataset.map(preprocess_function, batched=True)应用 LoRA 进行高效微调⚡📈🛠️

LoRA 允许通过仅训练模型的特定部分进行微调,从而显著减少内存使用量。🔍🔧💾

model = FastLanguageModel.get_peft_model(

model,

r=16, # LoRA 等级

target_modules=["q_proj", "v_proj"], # 微调关键注意层

lora_alpha=32,

lora_dropout=0.05,

bias="none",

use_gradient_checkpointing=True,

)训练模型

配置训练参数:📜📉🔧

初始化并开始训练:🎯🏗️🔥

from transformers import Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

eval_dataset=tokenized_dataset["test"],

tokenizer=tokenizer,

)

trainer.train()评估并保存模型

训练后,评估并保存微调后的模型:🏗️📊🔧

# 评估模型

eval_results = trainer.evaluate()

print(f"Perplexity: {eval_results['perplexity']}")

# 保存模型和标记器

model.save_pretrained("./finetuned_deepseek_r1")

tokenizer.save_pretrained("./finetuned_deepseek_r1")部署模型进行推理

微调完成后,使用模型进行推理:🎯🔧💡

对于使用llama.cpp进行本地部署,请运行:🏗️📜🔥

./llama.cpp/llama-cli \

--model unsloth/DeepSeek-R1-Distill-Llama-8B-GGUF/DeepSeek-R1-Distill-Llama-8B-Q4_K_M.gguf \

--cache-type-k q8_0 \

--threads 16 \

--prompt '<|User|>What is 1+1?<|Assistant|>' \ # 1+1等于多少?

--n-gpu-layers 20 \

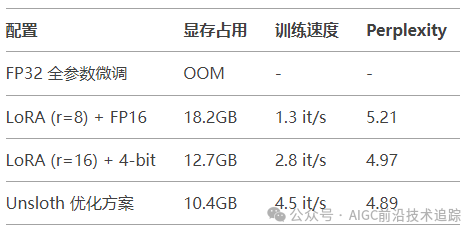

-no-cnv性能基准测试

在 RTX 4090 上的实验数据:

典型问题排查指南

- CUDA 内存不足:

- 减少

per_device_train_batch_size - 启用

gradient_checkpointing - 添加

--optim adafactor 使用内存优化器

- 损失震荡剧烈:

- 降低学习率(建议初始值 3e-5)

- 增加

gradient_accumulation_steps 至 16-32 - 添加

lr_scheduler_type="cosine"

- 生成结果重复:

- 在

generate() 中设置 no_repeat_ngram_size=3 - 增加

repetition_penalty=1.2

结论

通过利用LoRA和Unsloth ,我们成功地在消费级 GPU 上对DeepSeek-R1进行了微调,大大降低了内存和计算要求。这使得更快、更易于访问的 AI 模型训练成为可能,而无需昂贵的硬件。

本文转载自AIGC前沿技术追踪,作者:AIGC前沿技术追踪