LLM合集:微软发布基于过程的自奖励方法显著提升数学推理性能

1. Process-based Self-Rewarding Language Models

大型语言模型在各类下游任务中表现都很不错,现在已经在好多场景里广泛应用了。我们通过用人类标注的偏好数据训练语言模型,让它性能得到了进一步提升。不过,这种性能是受限于人类能力上限的。

为了突破这个限制,有人提出了自奖励方法,就是让语言模型自己给自己输出的内容奖励,然后用这些奖励数据来训练。但现在已有的自奖励方法在数学推理场景中不太好用,弄不好还会让模型性能变差。

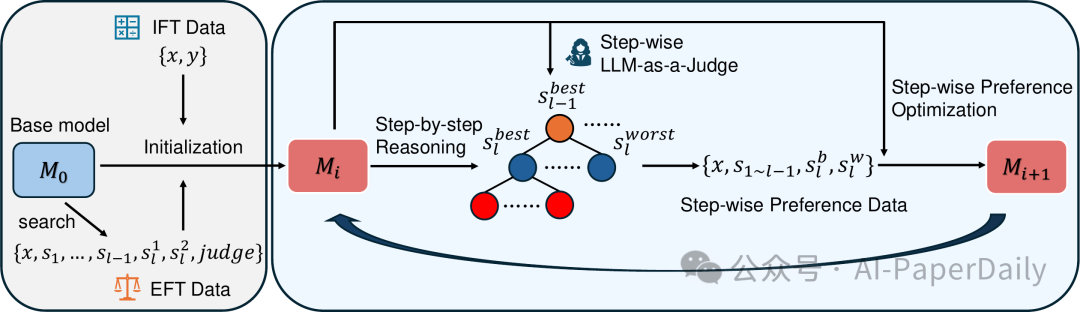

在本文里,我们提出了一种基于过程的自奖励流程。这个流程有长时间思考推理、用分步式语言模型当裁判,还有分步式偏好优化这些新做法。通过这种新范式,经过一轮轮基于过程的自奖励,语言模型在好几个数学推理基准测试中的性能都提高了。这就表明自奖励方法潜力巨大,有望让语言模型的推理能力超越人类。

论文: https://arxiv.org/pdf/2503.03746

2. ABC: Achieving Better Control of Multimodal Embeddings using VLMs

视觉嵌入模型在零样本任务里,像视觉检索和分类这些方面,效果还挺不错。但要是碰到那种不太明确、或者需要按用户指令来做的任务,它就不行了。这种任务得靠多模态嵌入模型,它能把视觉和自然语言输入结合起来,输出一种融合的嵌入。

现在那些基于 CLIP 的方法,都是把图像和文本分开来做嵌入,完了再把结果凑一块儿。我们发现这么搞,图像和文本这两种模态之间没啥深度互动,而且用户对最终呈现效果也不好控制。

所以我们提出了 ABC,这是个开源的多模态嵌入模型。它用视觉语言模型做主干,能把图像特征和自然语言指令深度融合在一起。在 MSCOCO 图像到文本检索这个任务里,ABC 的表现那是最好的,在大规模多模态嵌入基准里的分类和 VQA 任务中,也都拔得头筹。因为 ABC 能把视觉和语言统一起来表示,所以能用自然语言去解决那些不太好把握、可能有点模糊的视觉检索问题。

为了看看 ABC 这方面的能力到底咋样,我们专门设计了 CtrlBench 基准,这个基准要求把文本指令和图像内容交叉起来,才能实现正确检索。ABC 通过提供高质量的呈现效果,还有灵活的自然语言控制,让多模态嵌入技术往前迈了一步。我们的模型和数据集在项目页面就能找到。

论文: https://arxiv.org/pdf/2503.00329

3. HoT: Highlighted Chain of Thought for Referencing Supporting Facts from Inputs

大型语言模型(LLMs)有个毛病,老是会说些不实的话。它给出的回答里,事实和假话混在一起,这可把人难住了,想验证这些信息、根据它们准确做决策,太不容易。

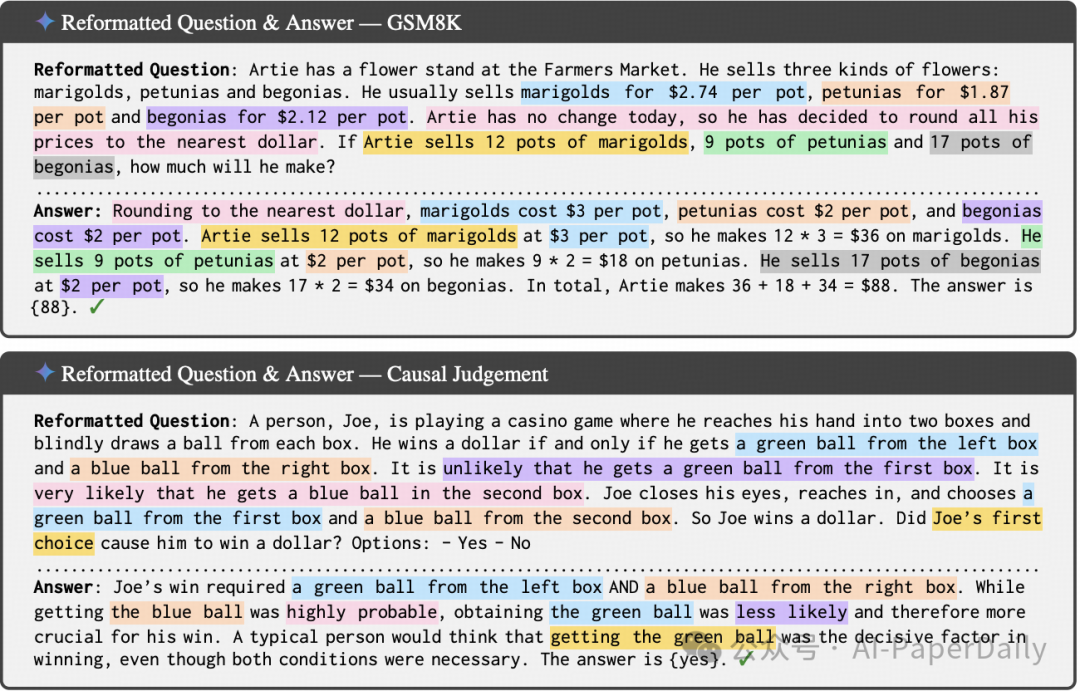

为了解决这个问题,我们提出了 Highlighted Chain-of-Thought Prompting(HoT)技术。用这技术,就要求大型语言模型给出带 XML 标签的回答,得把事实和查询里给的内容对应上。简单讲,要是给它一个问题,大型语言模型先得重新整理下问题,添上 XML 标签,把关键事实标出来,然后再给出回答,回答里得把输入里提到的事实突出显示。

有意思的是,在只给少量示例的情况下,HoT 在 17 种不同任务里,像算术、阅读理解、逻辑推理这些,表现都比普通的链式思维提示(CoT)要好。让人们去验证大型语言模型的回答时,那些标出来的内容能帮时间紧张的人更准确、更高效地判断模型回答得对不对。

论文: https://arxiv.org/pdf/2503.02003

4. Babel: Open Multilingual Large Language Models Serving Over 90% of Global Speakers

大语言模型(LLM)对自然语言处理(NLP)来说,那改变可太大了。不过现在开源的多语言 LLM 特别少,现有的那些,在语言覆盖范围上都有局限。这些模型一般都更重视那些资源多的语言,像一些用得很广泛,但相关资源不太够的语言,常常就被忽略了。

为了补上这个短板,我们提出了 Babel,这是个开源的多语言 LLM。它涵盖了全球使用人数最多的前 25 种语言,能服务全球 90% 以上的人,而且好多其他开源多语言 LLM 没涉及的语言,它也包括了。和以前那种连续预训练的方法不一样,Babel 通过层扩展技术,增加了模型的参数数量,这样就能把 Babel 的性能上限提高。

我们发布了两个不同版本:Babel - 9B,设计的时候就考虑到推理和微调要高效;还有 Babel - 83B,它给开源多语言 LLM 树立了新标杆。经过在多语言任务上的大量测试,发现 Babel 的性能比同样规模的开源 LLM 都要好。而且,用开源的监督微调数据集,Babel 也取得了很不错的成绩。Babel - 9B - Chat 在 100 亿规模的 LLM 里,排名很靠前;Babel - 83B - Chat 更是在多语言任务上做到了顶尖水平,和那些商业模型都能一较高下。

论文: https://arxiv.org/pdf/2503.00865

本文转载自AI-PaperDaily