GPU利润率545%!DeepSeek成本公开:还值得自建算力吗?

算力成本,大模型时代的“生死线”近日,国产大模型厂商DeepSeek罕见披露了其推理系统DeepSeek-V3/R1的核心架构与成本细节:单日GPU租赁成本超8.7万美元,理论利润率却高达545%。这一数据让行业再次聚焦大模型的核心命题——当云厂商提供“水电煤”般的算力时,自建集群是否还有必要?

一、DeepSeek的“吞吐量革命”:专家并行如何颠覆效率?

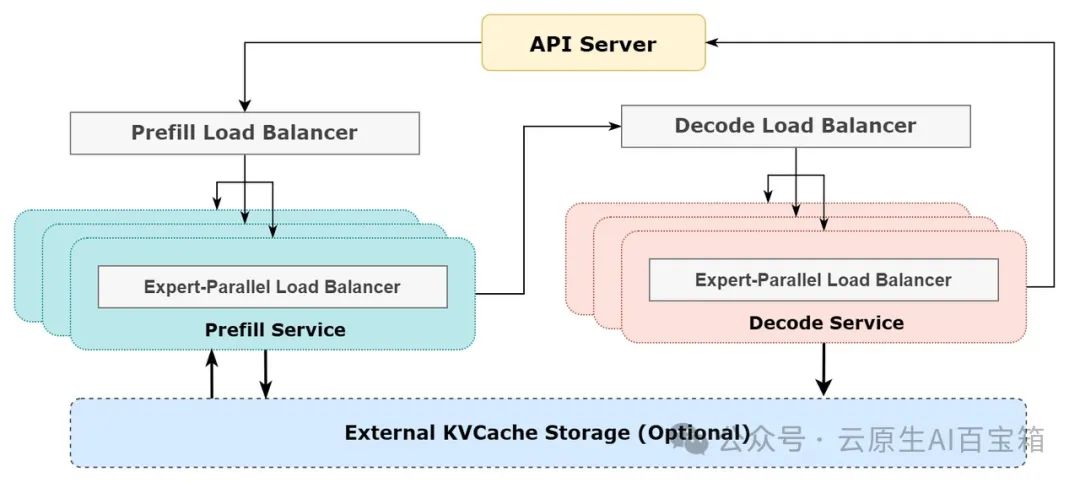

Diagram of DeepSeek's Online Inference System

DeepSeek-V3/R1的核心目标直指大模型推理的痛点:用更低的延迟,榨出更高的吞吐量。其杀手锏是大规模跨节点专家并行(EP):

•专家“分而治之”:每层256个专家中仅激活8个,通过跨节点分散计算,单卡负载锐减,矩阵乘法效率飙升。

•双Batch流水线:Prefill阶段用双Batch交替掩盖通信耗时;Decode阶段拆解Attention实现5级流水,通信与计算“无缝衔接”。

•动态负载均衡:针对不同GPU的请求长度、专家热度差异,实时平衡计算量、通信量、KVCache内存占用,避免“短板效应”。

结果如何? 单台H800 GPU的吞吐量达到:

- •输入73.7k tokens/s(Prefill,含56.3%缓存命中)

- •输出14.8k tokens/s(Decode),支撑日均7760亿token处理。

二、云上推理的“成本真相”:租赁竟比自建更赚?

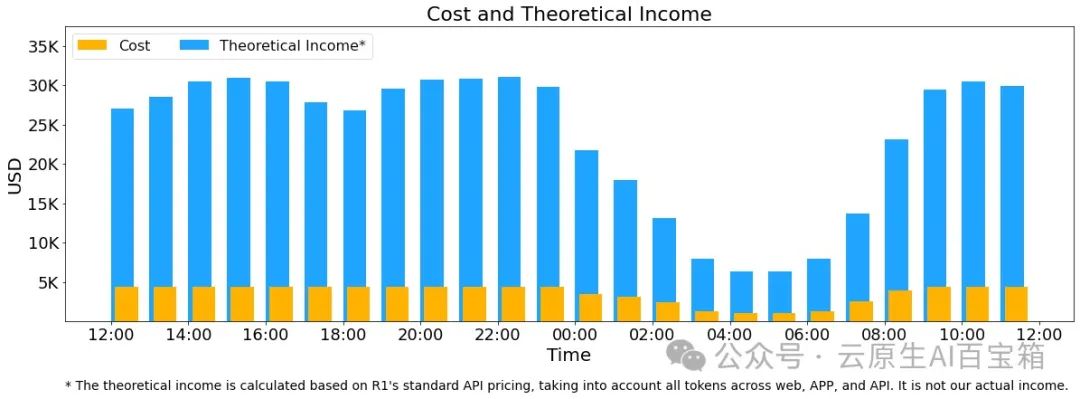

Cost And Theoretical Income

DeepSeek的成本账本揭开了一个反直觉结论:租用云GPU,反而比自建集群更“暴利”。

- •成本结构:日均租赁278节点(2222块H800),成本8.7万美元;理论收入达56.2万美元,利润率545%。

- •弹性优势:白天流量高峰全节点推理,夜间缩容用于训练研究,无需为闲置算力买单。

- •定价策略:按需使用云厂商的运维、网络、故障冗余能力,边际成本近乎为“零”。

- 行业启示录:云厂商的规模化效应,已让自建集群的“重资产模式”失去性价比。正如DeepSeek所暗示——“33%毛利的生意不值得做,不如白嫖云厂商的基建”。

三、自建VS租赁:大厂的两难选择

尽管云租赁经济性占优,但大厂仍有两大“难言之隐”:

1.可用性焦虑:高峰期抢不到资源?核心业务宕机损失远超成本。

2.数据安全心结:即便有“专机专用”“数据不出域”方案,领导仍可能认为“机器搬进自家机房才安心”。

现实魔幻一幕:某算力平台为说服客户,最终将服务器拆下直接送到甲方办公室——这本质上仍是“变相自建”,却折射出行业对数据安全的极致偏执。

四、未来展望:算力会像电力一样“即插即用”吗?

DeepSeek的实践指向一个未来:

- •算力电网化:厂商只需关注“接网能力”,无需自建发电厂(GPU集群)。

- •云厂商“工具化”:提供标准化、高弹性的算力单元,成为大模型时代的“基建底座”。

但有一个前提:云服务的稳定性、安全性必须无限接近“自建体验”,否则巨头们仍会押注可控性更高的私有集群。

结语:成本与控制的博弈,远未终局

DeepSeek的案例证明,云租赁已是大模型商业化的最优解。但对巨头而言,是否交出算力控制权,仍是战略级抉择。或许未来的答案不在“二选一”,而在于混合云——让核心数据留在本地,边缘计算拥抱云端。这场博弈,才刚刚开始。

引用链接

[1] deepseek-ai/open-infra-index: https://github.com/deepseek-ai/open-infra-index

本文转载自云原生AI百宝箱,作者:云原生AI百宝箱