辩论有助于从弱到强的泛化 原创

摘要:

现有的对齐已有能力模型与期望行为的方法通常依赖于人类提供监督的能力。然而,未来的超人类模型将超越人类的能力。因此,人类将只能对超人类模型进行弱监督。这种预期的人类评估不足将削弱未来AI系统的安全性。可扩展监督和从弱到强的泛化是解决这一问题的两种互补方法。在本文中,我们尝试结合这两种方法的优势,以进一步改进对齐。具体来说,我们研究了如何通过一个强大的预训练模型来改进人类监督,然后用增强的弱人类监督来监督强大模型。为了进行迭代的实证进展,我们考虑了一个类比:我们是否可以使用一个强大模型来改进弱模型的监督,然后用它来监督强大模型?我们通过在一个小型弱模型上使用真实标签进行微调,并借助一个大型强大模型的额外帮助,然后使用弱模型生成的标签对强大模型进行微调,进行了实证测试。我们发现,辩论可以帮助弱模型从一个不可信的强大模型中提取可信信息,这为训练弱模型提供了样本的上下文杠杆。我们还表明,弱模型的集成有助于利用强大模型辩论者生成长篇论证,并获得更稳健的监督估计。在OpenAI从弱到强的NLP基准测试上的大量实验表明,这种组合方法带来了更好的对齐,这表明辩论有潜力帮助从弱到强的泛化。

(注释: 强监督和弱监督的概念

在AI领域,强监督(Strong Supervision)和弱监督(Weak Supervision)是描述监督信号质量和可靠性的两个概念。简单来说,它们反映了AI在学习时得到的“指导”有多靠谱、有多清楚。以下用通俗的语言和比喻来解释这两个概念。

---

强监督(Strong Supervision)

定义:强监督是指AI在学习时,得到的指导信号非常明确、准确、可靠,通常由专家或高质量的数据提供。

- 就像一个经验丰富的老师,手把手教你做题,每一步都讲得清清楚楚,答案也绝对正确。

- 你完全不用怀疑老师的指导,按照他说的做,肯定能学会。

特点:

- 数据标签(指导信号)是精确的,比如“这张图片是猫”“这个答案是正确的”。

- 通常需要人类专家花时间标注,或者用非常可靠的方法生成。

- 成本高,因为需要大量高质量的努力。

例子:

- 教AI识别猫狗,人类专家一张张图片标清楚:“这是猫,这是狗。”

- 教AI回答科学问题,给它提供标准答案,比如“地球绕太阳转”。

在论文中的含义:

- 强监督可能是人类专家直接给超级AI提供准确的反馈,或者用强大的AI自己生成的高质量标签。但当AI比人类还聪明时,人类就没法提供这种强监督了。

---

弱监督(Weak Supervision)

定义:弱监督是指AI在学习时,得到的指导信号不够明确、不完全准确,或者质量较低,可能来自非专家、噪声数据或间接推断。

- 就像一个不太靠谱的同学教你做题,他可能会说“答案大概是这个吧”,但他自己也不完全确定。

- 你得自己琢磨琢磨,结合其他线索,才能学到东西。

特点:

- 数据标签可能模糊、不完整,甚至有错误,比如“这张图片可能是猫,也可能是狗”。

- 来源可能是非专家、自动生成的粗糙标签,或者从大量数据中“猜”出来的。

- 成本低,但需要AI自己有一定的“悟性”去处理不完美的信息。

例子:

- 教AI识别猫狗,只给它一些模糊的提示,比如“这些图片里大多数是猫”。

- 教AI回答问题,只告诉它“这个答案可能对,也可能不对,自己判断吧”。

在论文中的含义:

- 弱监督可能是普通人(而不是专家)给超级AI的反馈,或者一个小AI(能力不如超级AI)生成的标签。因为人类或小AI不如超级AI聪明,这些监督信号就不够强。

---

比喻:强监督 vs 弱监督

想象你在学做蛋糕:

- 强监督:一个米其林大厨站在旁边,告诉你每一步怎么做:“放2勺糖,搅拌3分钟,烤到金黄色。”你照做,蛋糕肯定好吃。

- 弱监督:一个没做过蛋糕的朋友说:“好像要放点糖吧,烤一会儿就行。”你得自己试错、摸索,才能做出像样的蛋糕。

---

在论文中的联系

论文研究的是弱到强泛化(Weak-to-Strong Generalization),意思是让一个超级厉害的AI(强模型)从不太靠谱的指导(弱监督)中学到正确的东西。因为未来的超级AI可能比人类聪明,人类只能提供弱监督(比如不完全准确的反馈)。论文的办法是:

- 用辩论让强AI自己吵出真相,帮弱AI学到更靠谱的知识。

- 再用增强后的弱AI去监督强AI,让强AI从弱监督里“悟”出正确的行为。

总结

- 强监督:靠谱老师教你,信号清楚,结果稳。

- 弱监督:半吊子朋友指点,信号模糊,得靠自己。

)

1.引言

当前的AI对齐技术严重依赖于人类标注数据的可用性,例如用于监督微调(SFT)的人类演示(Wei et al. 2021; Chung et al. 2024)和用于从人类反馈中进行强化学习(RLHF)的人类偏好(Christiano et al. 2017; Ouyang et al. 2022; Bai et al. 2022)。这些技术可以用来构建当前部署的最强大的AI系统(OpenAI 2023; Anthropic 2023)。

然而,随着模型变得越来越强大,它们将超越人类的能力(CAIS 2023)。在这种情况下,即使是人类专家也无法可靠地验证模型输出的质量或正确性,人类评估的角色将演变为非专家监督专家(Amodei et al. 2016; Bowman et al. 2022; Burns et al. 2023; Khan et al. 2024)。预期的人类评估不足将限制大多数现有对齐方法的有效性(Casper et al. 2023; McAleese et al. 2024)。此外,这些预测不准确的训练信号可能导致在策略训练期间奖励过度优化和奖励篡改,从而严重削弱其安全性(Gao, Schulman, and Hilton 2023; Denison et al. 2024)。

有两种互补的方法可以解决上述问题:可扩展监督(SO)和从弱到强的泛化(W2SG)(Leike 2023)。SO方法旨在提高人类监督更强大模型的能力,以便可以使用准确标注的数据进行对齐(Bowman et al. 2022)。与改进人类监督不同,W2SG方法通过微调一个强大的预训练模型,使其能够从弱人类监督中准确泛化(Burns et al. 2023)。

我们注意到,大多数先前的SO和W2SG技术都是单独研究的。相比之下,我们尝试结合SO和W2SG的优势,以进一步改进AI对齐。我们研究了如何通过一个强大的预训练模型来改进人类监督,然后用增强的弱人类监督来监督强大模型。为了进行迭代的实证进展,我们考虑了一个类比(Burns et al. 2023; Kenton et al. 2024):我们是否可以使用一个强大模型来改进弱模型的监督,然后用它来监督强大模型?

在本文中,我们通过在一个小型弱模型上使用地面真实标签进行微调,并借助一个大型强大模型的知识进行额外帮助,然后使用弱模型生成的标签对强大模型进行微调,进行了实证测试。我们假设一个在互联网规模数据上预训练的强大模型可以在训练弱模型时提供样本的上下文信息(Brown et al. 2020)。这让我们希望,一个弱-强模型团队可以创建一个更好的弱监督者,以激发强大模型的能力。

构建一个弱-强模型团队的一个主要挑战是找到从不可信模型中提取可信信息的方法(Bowman et al. 2022)。更具体地说,强大的预训练模型具有巨大的能力,但并未与人类价值观和意图良好对齐(Leike et al. 2018; Ji et al. 2023)。因此,强大模型可能会故意误导我们,生成不忠实的事实或做出虚假声明,这可能会在用于创建弱监督者时造成损害(Michael et al. 2023)。

另一个挑战是,弱模型(模型规模较小)可能缺乏完全处理强大模型生成长篇上下文的能力,这些上下文中充满了与手头任务无关的噪音。同时,最近的研究还表明,大型语言模型(LLMs)的性能与模型规模密切相关,复杂问题的难度可能超过单个弱模型的能力(Xu et al. 2023; Chung et al. 2024)。

在本研究中,我们证明了辩论可以帮助弱模型更可靠地从强大模型中提取信息。具体来说,给定一个问题,两个强大预训练模型的实例被随机分配两个相反的答案,然后这两个实例(辩论者)就答案进行辩论(Michael et al. 2023; Khan et al. 2024; Kenton et al. 2024)。在辩论中,撒谎比反驳谎言更难,即如果一个辩论者做出虚假声明,其对手可以令人信服地指出其论点中的缺陷(Irving, Christiano, and Amodei 2018)。因此,这些辩论中的论点可以告知弱模型每一方的优点和缺陷,并为弱模型训练提供上下文信息。

为了充分利用强大模型辩论者生成长篇论证,我们训练了一个弱模型的集成。我们聚合多个弱模型的预测,以获得比单个模型更稳健的监督估计(Ganaie et al. 2022)。特别是,我们探索了两种类型的集成:辩论集成,其中集成的不同成员在辩论采样时使用不同的随机种子;微调集成,其中成员仅在弱模型微调时使用不同的随机种子。我们发现,辩论集成始终优于单个弱模型和微调集成。本研究的主要贡献总结如下:

● 我们首次展示了可扩展监督和从弱到强泛化方法的简单组合,这在OpenAI从弱到强的NLP基准测试中带来了更好的对齐。

● 我们发现,辩论可以帮助弱模型从一个有能力但不可信的强大模型中提取可信信息,这为训练弱模型提供了样本的上下文杠杆。我们还表明,在我们的设置中,辩论优于其他可扩展监督技术。

● 我们表明,弱模型的集成有助于获得更稳健的监督估计。我们发现,集成的多样性至关重要,包含不共享辩论采样种子的成员的辩论集成表现更好。

尽管借助强大模型的知识,创建一个更好的弱监督者以激发强大模型的能力只是可扩展监督和从弱到强泛化技术结合的一种方式,但我们的结果为超人类对齐方法的进一步研究铺平了道路(Leike 2023)。我们在NLP领域提供了实证证据,表明辩论有助于从弱到强的泛化。

2.相关工作

AI对齐。AI对齐的目标是引导已有能力的模型按照人类价值观和意图行事(Leike et al. 2018; Ji et al. 2023)。当前的对齐方法通过在人类演示上进行模仿学习(Bain and Sammut 1995; Atkeson and Schaal 1997; Wei et al. 2021; Chung et al. 2024)、从人类反馈中进行强化学习(RLHF)(Christiano et al. 2017; Stiennon et al. 2020; Ouyang et al. 2022; Bai et al. 2022)或直接对齐算法(如直接偏好优化(DPO))(Rafailov et al. 2024b,a)来微调预训练的LLMs。模仿学习和偏好学习都依赖于高质量的人类监督,随着模型变得比人类更强大,这一需求变得越来越具有挑战性(Amodei et al. 2016)。

可扩展监督。可扩展监督技术旨在提高人类监督更强大模型的能力(Bowman et al. 2022)。这通常通过利用特殊问题结构来实现,例如假设评估比生成更容易(Karp 1975; Goodfellow et al. 2014)或可分解性(Christiano, Shlegeris, and Amodei 2018)。在理论上,有许多有前景的可扩展监督提案,包括递归奖励建模(Leike et al. 2018)、辩论(Irving, Christiano, and Amodei 2018)、市场制造(Hubinger 2020)、自我批评(Saunders et al. 2022)等(Lightman et al. 2023; McAleese et al. 2024; Sun et al. 2024)。最近在这一方向的实证研究表明,人机团队可以在问答任务上提高评估准确性,超越仅有人类的基线(Bowman et al. 2022)。

辩论最初是为AI安全提出的(Irving, Christiano, and Amodei 2018)。从那时起,一系列工作探索了辩论在可扩展监督中的可用性,使用人类或LLM辩论者(Parrish et al. 2022b,a; Michael et al. 2023; Khan et al. 2024; Kenton et al. 2024)。这些研究都是为了提高推理时法官的准确性,而在我们的工作中,辩论被用来训练一个更好的弱监督者。我们可以反过来使用弱监督者来对齐强大模型。基于LLM的辩论也在其他多个应用中被研究,例如翻译(Liang et al. 2023)、文本评估(Chan et al. 2023)、推理和内容生成(Du et al. 2023)。

从弱到强的泛化。与改进人类监督不同,从弱到强的泛化技术通过微调一个强大的预训练模型,使其能够从弱人类监督中准确泛化(Burns et al. 2023)。这些技术的希望在于,强大的预训练模型应该已经具备对齐相关任务的良好表示。因此,我们只需要一个弱监督者来激发强大模型已经掌握的知识。最近,一个理论框架被引入,以通过不匹配误差理解从弱到强的泛化(Charikar, Pabbaraju, and Shiragur 2024)。先前的工作主要探索了如何使用固定的弱监督者来监督强大模型,而在本研究中,我们还尝试借助强大模型的帮助来训练一个更好的弱监督者。

集成方法。我们的工作也与现有的使用集成方法的研究相关,这些方法通过结合多个模型的预测来实现(Ganaie et al. 2022)。在AI对齐的背景下,研究了奖励模型集成,以减轻在使用RLHF微调模型时的奖励过度优化问题(Coste et al. 2023; Eisenstein et al. 2023)。与我们的工作最相似的是,Liu和Alahi(2024)提出为从弱到强的泛化集成一组多样化的专业弱监督者。相比之下,在我们的工作中,我们旨在使用具有不同种子的弱模型集成,以充分利用强大模型辩论者生成长篇论证。

3.Preliminaries(预备知识)

我们回顾了(Burns et al. 2023)中的弱到强泛化流程,该流程也在后续工作(Liu and Alahi 2024; Charikar, Pabbaraju, and Shiragur 2024)中得到了采用。它通常包括三个阶段:

1. 创建弱监督者。我们通过在真实标签上微调一个小的预训练模型来创建弱监督者。我们将弱监督者的性能称为弱性能(weak performance)。

2. 训练强学生模型。我们通过在弱监督者生成的弱标签上微调一个大的预训练模型来训练强学生模型。我们将其性能称为弱到强性能(weak-to-strong performance.)。

3. 训练强上限模型。我们通过在真实标签上微调一个大的预训练模型来训练强上限模型。我们将该模型的最终性能称为强上限性能(strong ceiling performance)。

为了衡量强学生模型在弱监督下能够恢复的性能差距比例,我们使用上述三种性能定义了性能差距恢复率(PGR):

PGR = (weak-to-strong − weak)/(strong ceiling − weak)

4.Methods(方法)

Overview(概述)

在本研究中,我们按照以下三个步骤构建强学生模型:

1. 从两个大型预训练模型实例之间的辩论中生成论据;

2. 使用这些辩论论据训练一组弱模型;

3. 使用弱模型集合构建的标签训练强学生模型。

Argument Generation through Debate(通过辩论生成论据)

我们假设大型预训练模型嵌入了广泛覆盖的知识,可以帮助完成各种任务(Brown et al. 2020)。我们的目标是通过辩论从一个能力强大但不可信的强模型中提取可信信息(Bowman et al. 2022),以便反过来使用这些可信信息来帮助训练一个更好的弱模型。

我们首先描述我们研究的辩论协议,以从强模型中引出真相,遵循(Michael et al. 2023; Khan et al. 2024; Kenton et al. 2024)。给定一个问题及其两个答案选项(一个正确,一个错误),两个大型预训练模型实例(辩手)被随机分配为这两个对立的答案进行辩论。辩论是两个辩手之间基于回合的文本交换,他们轮流回顾前几轮的论据并为下一轮生成自己的论据。在预定回合数结束后,辩论结束,并保留辩论中论据的记录。在辩论期间,每个辩手为其分配的答案提供最具说服力的证据,并提出论据解释为何对手的主张是错误的。

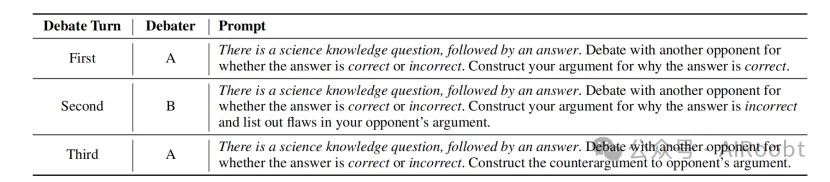

具体来说,在本研究中辩论进行三轮。在每轮开始时,辩手会收到概述问题、他们分配的答案以及当前辩论记录的指令。引发辩论的提示如表1所示。

- Table 1:在二元分类问题上诱导辩论的提示。

(注释:

1.有一个科学知识问题,后跟一个答案。针对该答案是正确还是错误,与另一个对手进行辩论。构建你为何认为答案正确的论据。

2.有一个科学知识问题,后跟一个答案。针对该答案是正确还是错误,与另一个对手进行辩论。构建你为何认为答案错误的论据,并列出对手论据中的缺陷。

3.有一个科学知识问题,后跟一个答案。针对该答案是正确还是错误,与另一个对手进行辩论。构建针对对手论据的反驳。

)

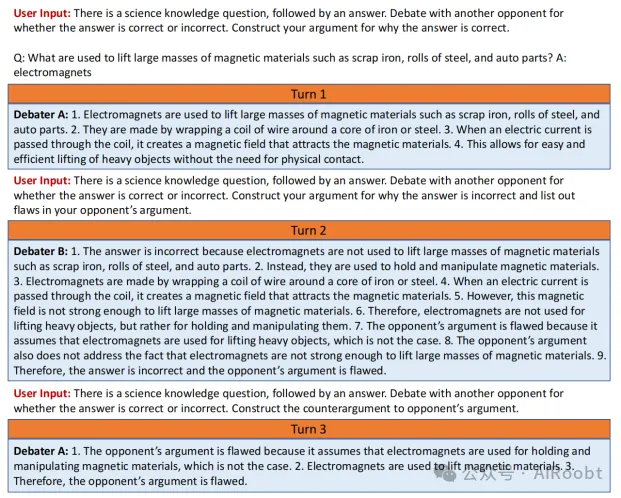

我们在图1中展示了这一辩论过程的概览。我们可以观察到,辩手B站在错误答案一边,并被激励提出误导性论据。然而,在下一轮中,辩手A令人信服地指出了这些虚假主张,因此辩手B无法轻易逃脱。这一观察符合“撒谎比驳斥谎言更难”的说法(Irving, Christiano, and Amodei 2018)。辩论中的这些论据可以提供关于双方优缺点的重要信息,有潜力显著提升弱模型的能力。

- Figure 1:辩论示意图。辩手A与辩手B之间的辩论过程示意图。

(注释:

用户输入:有一个科学知识问题,后跟一个答案。针对该答案是正确还是错误,与另一个对手进行辩论。构建你为何认为答案正确的论据。

Q:用来提升如废铁、钢卷和汽车零部件等大型磁性材料质量的工具是什么?

A:电磁铁

第1轮

辩手A:

1. 电磁铁被用来提升如废铁、钢卷和汽车零部件等大型磁性材料。

2. 它们是通过在铁或钢芯上绕制线圈制成的。

3. 当通过线圈通电时,它会产生一个吸引磁性材料的磁场。

4. 这使得在不需要物理接触的情况下轻松且高效地提升重物成为可能。

用户输入:有一个科学知识问题,后跟一个答案。针对该答案是正确还是错误,与另一个对手进行辩论。构建你为何认为答案错误的论据,并列出对手论据中的缺陷。

第2轮

辩手B:

1. 该答案是错误的,因为电磁铁并未被用来提升如废铁、钢卷和汽车零部件等大型磁性材料。

2. 相反,它们被用来固定和操控磁性材料。

3. 电磁铁是通过在铁或钢芯上绕制线圈制成的。

4. 当通过线圈通电时,它会产生一个吸引磁性材料的磁场。

5. 然而,这个磁场不足以提升大型磁性材料。

6. 因此,电磁铁并未被用来提升重物,而是用于固定和操控它们。

7. 对手的论据有缺陷,因为它假设电磁铁用于提升重物,这并非事实。

8. 对手的论据也没有提及电磁铁不足以提升大型磁性材料的事实。

9. 因此,该答案是错误的,且对手的论据存在缺陷。

用户输入:有一个科学知识问题,后跟一个答案。针对该答案是正确还是错误,与另一个对手进行辩论。构建针对对手论据的反驳。

第3轮

辩手A:

1. 对手的论据有缺陷,因为它假设电磁铁被用来固定和操控磁性材料,这并非事实。

2. 电磁铁被用来提升磁性材料。

3. 因此,对手的论据存在缺陷。

)

Weak Model Ensemble Training(弱模型集合训练)

对于弱模型的每个输入样本,我们将其与保留的辩论记录拼接。我们通过在带有真实标签的增强样本上微调一个小的预训练模型来训练弱模型。我们注意到,多轮辩论生成的辩论记录很长,这可能对弱模型来说难以完全处理。因此,我们训练一组弱模型 \(\{W_1, \ldots, W_k\}\) 以帮助提高鲁棒性(Lakshminarayanan, Pritzel, and Blundell 2017)。

我们探索了两种类型的集合:

- 辩论集合:每个成员使用的辩论记录使用不同的随机种子生成。

- 微调集合:所有成员共享相同的辩论记录,但在增强样本上微调时使用不同的种子。

辩论集合的训练成本更高,但多样性更强,因此可能导致更鲁棒的预测。除非另有说明,我们训练的集合由四个独立的弱模型组成。

Training Strong Models using Ensembles(使用集合训练强模型)

我们最终通过在弱模型集合构建的弱标签上微调一个大型预训练模型来训练强学生模型。我们简单地将集合中不同弱模型预测的平均值作为每个训练样本的弱标签(Ganaie et al. 2022)。

(

方法的整个过程可以用一个“吵架 + 团队学习”的故事来解释。

---

核心思路:吵出真相,团队帮忙

论文的办法是让两个聪明的AI吵架(辩论),通过吵架的过程把问题弄明白,然后让一群小AI(弱模型)听吵架学东西,最后用这些小AI的集体智慧去教一个超级AI(强学生模型)。简单来说,分三步:

1. 吵架(辩论):让两个厉害的AI针对问题争论,吵出靠谱的理由。

2. 小团队学习:一群不太聪明的小AI听吵架,学到有用的知识。

3. 教大佬:用小团队的集体结论去指导超级AI,让它变得更厉害。

---

具体步骤:怎么构建强学生模型

1. 第一步:让两个强AI吵架,生成论据

- 啥意思:找两个很聪明的AI(比如大模型Qwen-14B),给它们一个问题,比如“电磁铁能不能抬重物?”然后让它们站在对立面吵架,一个说“能”,一个说“不能”。

- 怎么吵:分成三轮:

- 第一轮:一个AI说“能抬,因为电磁铁有强磁场”;另一个说“不能,磁场不够强”。

- 第二轮:反对的AI反驳,“你说的不对,电磁铁只能固定东西”;支持的AI回应,“工业上都用它抬废铁,你错了”。

- 第三轮:继续互相挑刺,直到把理由讲清楚。

- 结果:吵完后,留下所有论据(辩论记录),就像一份“吵架笔记”,里面有支持和反对的理由。

- 为啥有用:吵架能把真相抖出来,因为撒谎比反驳谎言难。正确的理由会更有说服力。

比喻:就像两个学霸吵数学题,一个说“答案是4”,一个说“不对,是5”,你听着他们争论,就能搞清楚谁对。

2. 第二步:让一群小AI听吵架,组团学习

- 啥意思:找几个不太聪明的小AI(弱模型,比如Qwen-7B),让它们看“吵架笔记”,再结合正确答案(比如“电磁铁能抬重物”)来学习。

- 怎么学:

- 每个小AI都读笔记,但角度不同:有的看支持的理由,有的看反对的理由是怎么被驳倒的。

- 因为笔记很长,小AI一个人可能看不全,所以弄一群小AI(比如4个),组成一个“学习小组”。

- 小组里每个AI用不同的方法学(比如有的用不同的随机种子生成笔记),最后得出自己的结论。

- 结果:这群小AI学会了从吵架中挑出靠谱的信息,比如“电磁铁确实能抬重物,因为工业上常用”。

- 为啥用一群:一个小AI可能搞不清长篇大论,但一群AI一起努力,能把复杂的信息消化得更好。

比喻:就像一群普通学生听学霸吵架,每人记一部分笔记,最后凑在一起讨论,得出一个靠谱的答案。

3. 第三步:用小AI的集体智慧教超级AI

- 啥意思:把学习小组的结论(比如每个小AI对问题的判断)拿出来,平均一下,变成一个“不太聪明但还算靠谱”的指导信号。

- 怎么教:用这个信号去训练一个超级AI(强学生模型),让它微调自己的能力。

- 比如,小组说“电磁铁能抬重物”的概率是80%,超级AI就根据这个调整自己的答案。

- 结果:超级AI从这些弱指导中学到了正确的东西,表现比小AI好,甚至接近用正确答案直接教它的水平。

- 为啥行得通:超级AI本来就很聪明,只要给它一点靠谱的线索,它就能自己“悟”出更多。

比喻:就像一群普通老师给天才学生上课,老师水平一般,但凑在一起能给个大致正确的方向,天才学生靠自己的天赋把细节补全。)

5.Experiments

Tasks

我们采用了先前工作(Burns et al. 2023)的评估协议,并在四个分类数据集上进行了NLP任务的实验:SciQ(Welbl, Liu, and Gardner 2017)、BoolQ(Clark et al. 2019)、CosmosQA(Huang et al. 2019)和AnthropicHH(Bai et al. 2022)。我们将每个数据集转换为二元分类问题。对于多选题数据集,给定一个带有问题Q和k个候选答案A的数据点,我们构建k个新数据点,形式为(Q, A_i),其中正确答案的标签为1,所有错误答案的标签为0。我们还保持每个问题正确和错误答案的数量相同,以维持类别平衡。

Experimental Setups and Metrics

我们从每个任务中随机抽取最多20k个数据点,并将它们平分。我们在数据点的前半部分上训练一个弱模型,并使用它在另一半上的预测作为弱标签。弱标签是软标签(Hinton, Vinyals, and Dean 2015)。我们在所有任务的测试集上报告强学生模型的准确率和性能差距恢复率(PGR)。PGR的弱性能是简单微调的小模型的性能。

Implementation Details

我们的数据预处理、弱模型和强模型训练的实现基于OpenAI的弱到强代码库及其默认超参数(Burns et al. 2023)。具体来说,我们使用Qwen/Qwen-7B作为训练弱模型的小型预训练模型。同时,我们使用Qwen/Qwen-14B作为生成辩论论据和训练强模型的大型预训练模型。Qwen/Qwen-7B和Qwen/Qwen-14B都是开源的,这有助于重现性(Bai et al. 2023)。我们不使用GPT-2系列的预训练模型来训练弱模型(Radford et al. 2019),因为它们缺乏可扩展监督技术所需的能力,如与强模型紧密合作(Bowman et al. 2022)。

对于每个转换后的二元分类问题,我们将每个问题的两个候选答案作为两个对立的答案,随机分配给辩论中的两个强模型辩手。为了使弱模型和强模型适应二元分类设置,我们在编码器顶部为每个模型配备了一个带有两个输出的线性分类头。我们以批大小为32训练所有模型两个epoch。我们在单台8×A100机器上进行了所有实验。

Baselines

我们将我们的方法与竞争性的基线方法进行比较:

1. Finetune(Burns et al. 2023)简单地在一个弱模型生成的标签上微调强预训练模型;

2. Finetune w/aux. loss(Burns et al. 2023)使用辅助置信度损失微调强模型,该损失在强模型的预测与弱标签不一致时增强强模型对其自身预测的置信度;

3. Finetune w/pro. loss(Burns et al. 2023)使用类似于置信度的损失微调强模型,该损失将交叉熵目标设置为弱标签和强模型预测的乘积。

我们还报告了预备知识部分定义的弱性能和强上限性能。注意,强上限性能通常被视为仅考虑弱标签时弱到强性能的上限。

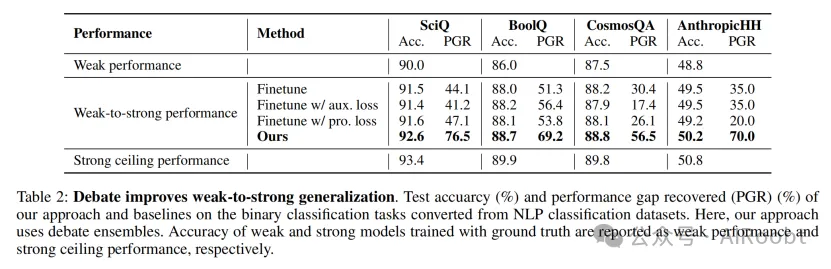

Main Results

在表2中,我们报告了每种方法在从SciQ、BoolQ、CosmosQA和AnthropicHH数据集转换的二元分类任务上的结果。这里,我们的方法使用辩论集合。在每个任务中,我们观察到在弱标签上微调的强学生模型的PGR均为正。这表明学生模型在所有研究的弱到强生成方法和任务中始终优于其弱监督者。同时,这种有希望的弱到强泛化也表明我们的实验设置有助于在解决未来超人模型对齐的弱监督问题上取得迭代的经验进展。

- Table 2:辩论改善了弱到强泛化。

同时,我们发现我们的方法在所有四个任务上显著优于每个强学生基线,包括在弱标签上微调的简单基线或配备置信度损失项的更复杂的基线。与有希望的基线Finetune w/aux. loss相比,我们的方法在SciQ中将PGR从41.2%提高到76.5%,在BoolQ中从56.4%提高到69.2%,在CosmosQA中从17.4%提高到56.5%,在AnthropicHH中从35.0%提高到70.0%。我们的方法还在所有比较的强学生中获得了最佳测试准确率。性能提升表明通过辩论从强模型中提取可信信息的优势,这有助于创建一个更好的弱监督者来引出强模型的能力。

此外,我们还看到,在标准交叉熵目标中添加置信度损失(Finetune w/aux. loss和Finetune w/pro. loss)通常会适度提升泛化性能。在我们的实验设置中,弱模型和强模型之间的计算差距并不显著,这可能限制了它们的性能。

Ablation Studies

最后,我们提供了全面的消融研究,以了解辩论在弱到强生成中的有效性。

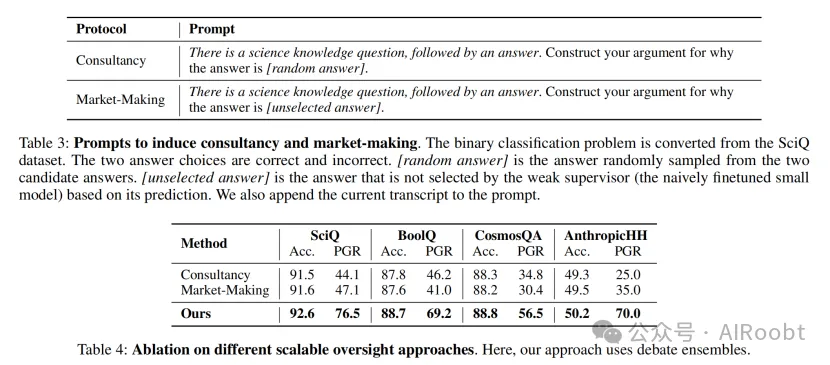

不同可扩展监督方法的消融

我们通过用其他可扩展监督方法替代辩论来展示其作为从能力强大但不可信的强模型中提取可信信息的机制的有效性:Consultancy(Michael et al. 2023)和Market-Making(Hubinger 2020)。

- Consultancy。在consultancy中,只有一个顾问而不是两个辩手。顾问是一个大型预训练模型的实例。给定一个问题及其两个答案选项(一个正确,一个错误),顾问被分配为其中一个答案辩护,每个有50%的几率。在consultancy期间,顾问为其分配的答案提供证据。consultancy结束后保留记录。

- Market-Making。在market-making中,只有一个辩手。辩手是一个大型预训练模型的实例,旨在生成改变某些模型对问题答案信念的论据。给定一个问题及其两个候选答案,我们让弱监督者(简单微调的小模型)基于其预测选择一个答案。相应地,辩手被分配为未被选择的答案辩护。最终保留记录。

具体来说,consultancy和market-making都进行一轮。在每轮开始时,顾问和辩手会收到描述任务、分配的答案和记录的提示。引发consultancy和market-making的提示如表3所示。

- Table 3:引发consultancy和market-making的提示。

- Table 4:不同可扩展监督方法的消融。

表4中的结果显示,我们方法中使用的辩论在所有四个任务的测试准确率和PGR方面均优于所有其他变体。这些结果验证了我们的说法,即辩论可以帮助从强模型中引出真相,至少在我们的设置中优于consultancy和market-making。同时,我们应该注意到,consultancy是一个相对较弱的基线,因为顾问为错误答案辩护的几率是50-50。

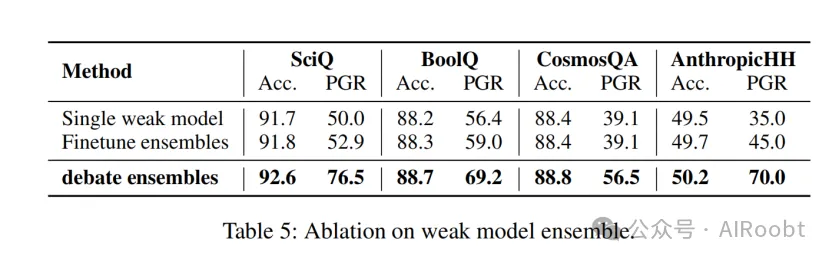

弱模型集合的消融

我们分析了弱模型集合对获得稳健的弱监督估计以进行弱到强泛化的影响。在表5中,我们比较了三种计算成本递增的弱模型集合方法:单个弱模型、微调集合和辩论集合。单个弱模型是在带有辩论记录的增强样本上微调的单个小模型。微调集合和辩论集合在方法部分有描述。

- Table 5:弱模型集合的消融。

- Figure 2:集合基数对性能的影响。

- Figure 3:辩论回合数对性能的影响。

我们发现,辩论集合在所有任务中始终优于单个弱模型和微调集合。相反,微调集合在4个任务中的3个中相对改善了性能,在另一个任务中表现相当。这些结果表明,生成辩论论据的多样性是弱模型集合成功的关键,这有助于创建一个更好的弱监督者。同时,单个小弱模型可能缺乏完全利用辩论中长论据的能力,从而导致性能有限。

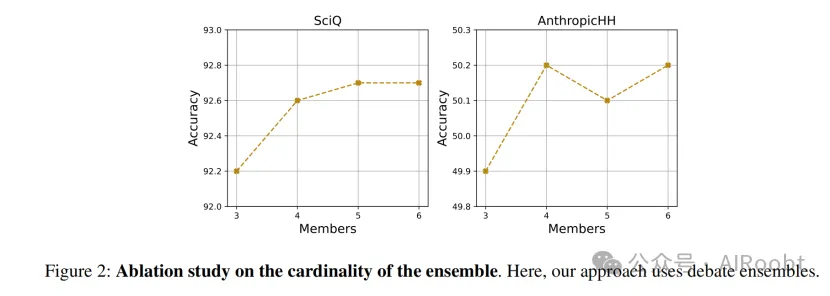

集合基数的消融

回想一下,我们的弱模型集合方法引入了一个额外的超参数基数。基数是集合的大小。我们分析了集合基数对最终性能的影响。在图2中,我们在SciQ和AnthropicHH任务上增加了集合中使用的弱模型成员数量。我们可以观察到,3成员和4成员集合之间存在显著差距。另一方面,4成员、5成员和6成员集合的性能非常相似。这表明4成员集合可能效果最好,超过此点后收益递减。

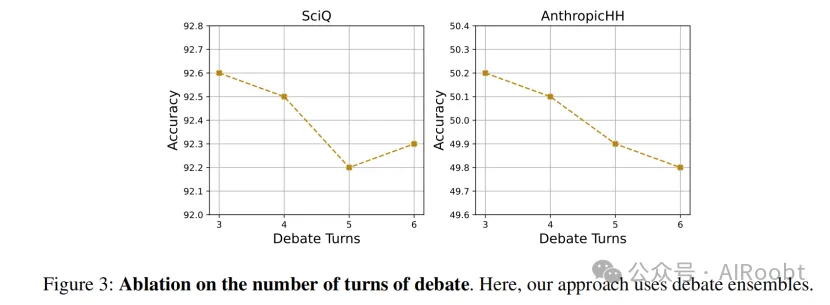

辩论回合数的消融

接下来,我们分析了辩论回合数对最终性能的影响。在图3中,我们在SciQ和AnthropicHH任务上将辩论长度增加到最多6轮。我们发现,更多的辩论回合并没有提高最终性能。我们观察到,像Qwen/Qwen-14B这样的强模型辩手在几轮后倾向于重复论据,这可能解释了为什么额外的回合没有提供进一步的好处。

6.Limitations and Conclusion

Limitations(局限性)

在我们的工作中,我们将多个弱模型的预测聚合在一起,以获得更稳健的监督估计。虽然这种方法在我们的实验中表现良好,但它引入了额外的计算开销。具体来说,训练一个弱模型集合比训练单个弱模型成本更高。此外,在辩论集合中,为每个弱模型生成不同的辩论记录进一步增加了计算负担。

我们还注意到,我们的实验是在相对简单的NLP分类任务上进行的,这些任务可能无法完全捕捉未来超人模型对齐的复杂性。特别是,我们的任务是二元分类问题,这比更复杂的任务(如开放式文本生成或多步骤推理)要简单得多。

最后,我们的方法依赖于强模型能够生成有用的辩论论据的假设。如果强模型的论据质量差或具有误导性,那么弱模型集合可能无法从这些论据中提取有用的信息。在这种情况下,我们的方法可能无法改善弱到强泛化。

Conclusion(结论)

在这项工作中,我们探索了一种结合可扩展监督和弱到强泛化方法的方法,以改善AI对齐。具体来说,我们展示了辩论如何帮助弱模型从能力强大但不可信的强模型中提取可信信息。我们还表明,弱模型集合有助于获得更稳健的监督估计,特别是在处理强模型生成的冗长论据时。

我们的实验结果表明,这种组合方法在OpenAI的弱到强NLP基准上取得了更好的对齐表现。这为进一步研究混合超人对齐方法奠定了基础,并提供了辩论在帮助弱到强泛化方面的潜力证据。

尽管存在局限性,我们相信我们的工作为解决超人模型对齐中的弱监督问题迈出了重要一步。未来的工作可以探索更有效的弱模型集合方法,以及在更复杂任务上应用这些技术。

本文转载自公众号AIRoobt ,作者:AIRoobt