微软Phi-4-Mini技术报告:Phi-4-Mini如何以小博大 精华

想象一下,如今的AI世界里,大模型如GPT-4、Claude动辄上百亿参数,能力惊人却耗资巨大,像是一辆辆豪华跑车,虽快却烧油无数。普通人或中小企业想用AI解决问题时,常常被高昂的成本挡在门外。可就在这时候,微软扔出了一颗“重磅炸弹”——Phi-4-Mini和Phi-4-Multimodal。这两个小巧的模型,参数量仅3.8亿,却在语言、数学、编码甚至多模态任务上表现出色,堪称“小身躯,大能量”。这不禁让人好奇:微软是怎么让“小个子”打败“大块头”的?它能给论文带来什么惊喜?今天,论文就来拆开这篇论文,聊聊Phi-4-Mini的秘密。

一、小模型逆袭:Phi-4-Mini解决了什么难题?

在AI领域,普遍认为模型越大越强,但大模型的训练和运行成本高得吓人,尤其是在手机、边缘设备上几乎没法用。Phi-4-Mini要解决的核心问题是如何用更少的参数,实现媲美甚至超越大模型的性能。论文里提到,Phi-4-Mini只有3.8亿参数,却能在数学推理、编程任务上匹配参数量两倍的模型,甚至在某些场景下挑战像DeepSeek这样的7亿、8亿参数对手。这就像一个轻量级拳手,竟然能和重量级选手过招还不落下风。

更厉害的是,Phi-4-Multimodal把能力扩展到了多模态,能同时处理文字、图片和语音。比如,你给它一张图和一段语音,它能直接告诉你图里是什么,还能把语音内容总结出来。这种多才多艺的设计,瞄准的是未来AI的趋势——用一个模型搞定多种任务,而不是像现在这样,每种任务都得单独训练一个大模型。微软的野心很明显:让AI更轻、更快、更全能。

二、技术揭秘:微软是怎么做到的?

1.数据精挑细选,像筛金子一样训练模型

Phi-4-Mini的成功离不开高质量的数据。微软没用海量杂乱的数据轰炸模型,而是像淘金一样,精心挑选了优质的网络数据和合成数据,尤其在数学和编码上加码。比如,他们用专门的数学题和代码数据集,让模型学会“深度思考”,而不是只会背答案。这种“少而精”的策略,让Phi-4-Mini在关键任务上效率爆棚。

(1)预训练数据:与Phi-3.5-Mini相比,论文从以下几个关键方面改进了预训练数据的质量:

1)更好的数据过滤:通过使用经过增强的质量分类器,该分类器在由更干净的正负样本组成的更大规模精选数据集上训练,论文最终在多种语言的各个方面(如有毒、晦涩、科学等)实现了更好的过滤质量,从而形成了一个更全面、更可控的过滤策略。

2)更好的数据和编程数据:对于数学和编程数据,论文使用特定的基于指令的数学和编程数据集增强了原始数据。这种增强在数学、编程和推理方面取得了有效的结果。

3)更好的合成数据:论文将Phi-4合成数据[AAB+ 24]以相同的处理和去污染方式纳入了模型训练。

4)更好的数据混合:借助更好的分类器,论文通过消融实验重新调整了数据混合。特别是,论文增加了推理数据的比例。这为模型质量带来了提升。

通过这些技术,论文构建了5万亿的预训练数据语料库,相比Phi-3.5-Mini,数据规模更大、质量更高。

(2)后训练数据:与Phi-3.5-Mini相比,Phi-4-Mini包含了显著更大、更多样的函数调用和总结数据。此外,论文还合成了大量的指令跟随数据,以增强模型的指令跟随能力。

在编程方面,论文整合了大量代码补全数据,包括要求模型在现有代码片段中间生成缺失代码的任务。这挑战模型理解需求和现有上下文,从而带来显著的性能提升。

(3)推理训练数据:论文从更大的推理模型生成大量合成的思维链(Chain-of-Thought, CoT)数据,覆盖不同领域和难度级别。在采样过程中,论文同时采用基于规则和基于模型的拒绝方法来丢弃不正确的生成结果,并将其反馈重新采样。

此外,论文将正确采样的答案标记为"受偏好"的生成,将错误的答案标记为"不受偏好",并创建DPO数据。这些数据仅用于实验性推理模型,尚未应用于正式发布的Phi-4-Mini检查点。

(4)视觉-语言训练数据:Phi-4-Multimodal模型的预训练阶段涉及丰富多样的数据集,包括交错的图像-文本文档、图像-文本对、图像基础数据、来自PDF和真实图像的OCR合成数据集,以及图表理解的合成数据集。

在此阶段,模型的主要重点是预测下一个标记,仅专注于文本标记,忽略与图像标记相关的任何损失。预训练过程共涉及0.5T标记,结合了视觉和文本元素。另外,最大图像分辨率限制在1344x1344,因为大多数训练图像尺寸小于此大小。

(5)视觉-语音训练数据:对于视觉-语音数据,Phi-4-Multimodal模型在多样的合成视觉-语音数据上进行训练,覆盖单帧和多帧场景。具体而言,我们重用视觉-语言SFT数据的子集,并使用内部文本到语音(TTS)引擎将用户查询从文本转换为音频。这个子集经过仔细选择,以避免某些不适合朗读的数据集。

还通过使用内部自动语音识别(ASR)模型转录音频,并计算原始文本和转录之间的词错误率(WER)来衡量合成语音的质量。我们最终的视觉-语音数据是通过基于WER的过滤生成的,以确保质量。

(6)语音和音频训练数据:语音/音频功能的训练数据可分为两类:

1)带有ASR转录的预训练数据,以在语音和文本模态之间提供强大的对齐;

2)后训练数据,用于解锁涉及语音/音频模态的Phi-4-Multimodal的指令跟随能力。

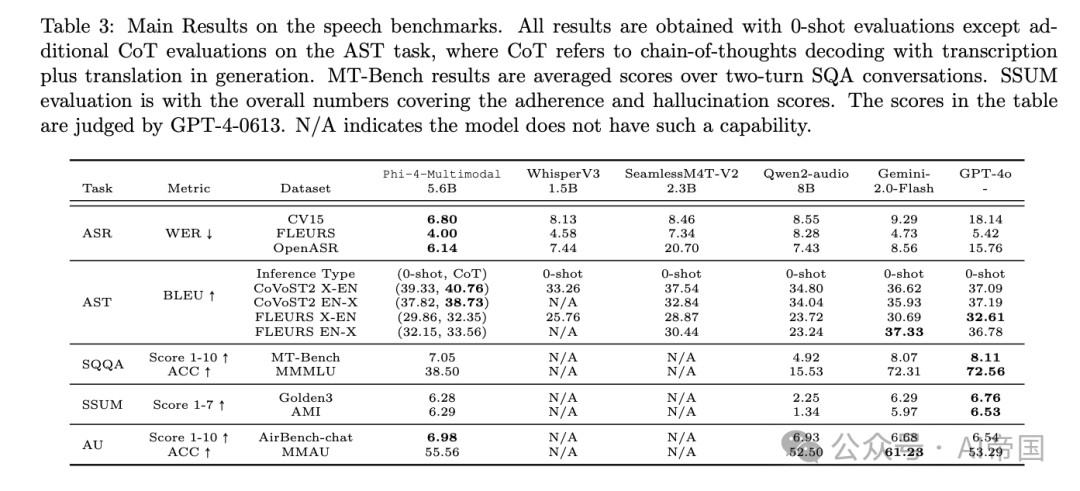

后训练数据涵盖多种任务,包括自动语音识别(ASR)、自动语音翻译(AST)、语音问答(SQA)、口语查询问答(SQQA)、语音总结(SSUM)和音频理解(AU)。

2. 架构升级:Group Query Attention的巧妙优化

技术上,Phi-4-Mini用了一种叫Group Query Attention(GQA)的机制。简单说,这就像给模型装了个“省油引擎”,通过优化内存使用(KV cache),让它在处理长文本时更快、更省资源。具体来说,它把查询头设为24个,键值头只有8个,内存消耗降到原来的三分之一。这意味着Phi-4-Mini能轻松处理长达12.8万字符的上下文,比很多大模型还灵活。

3. LoRA混合:多模态的“魔法插件”

Phi-4-Multimodal更牛,它用了一种“LoRA混合”技术。LoRA就像模型的“插件”,不用动基础语言模型,只加装特定模块就能处理图片、语音。比如,想让模型看图说话,就插上视觉LoRA;想听语音做总结,就用语音LoRA。这种设计不仅灵活,还避免了不同任务互相干扰。训练时,微软分阶段进行:先练语言,再加视觉,最后融合语音,层层递进,确保每个能力都扎实。

三、效果如何?小模型真能干大事!

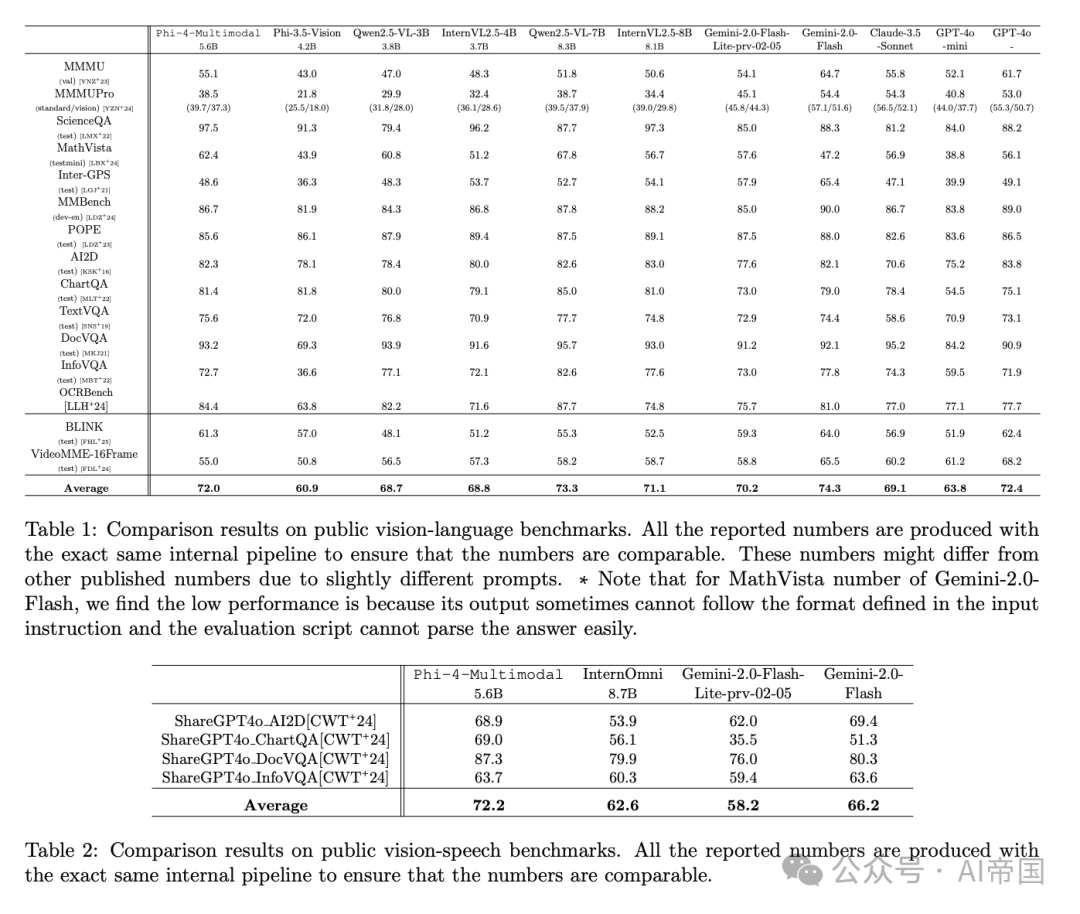

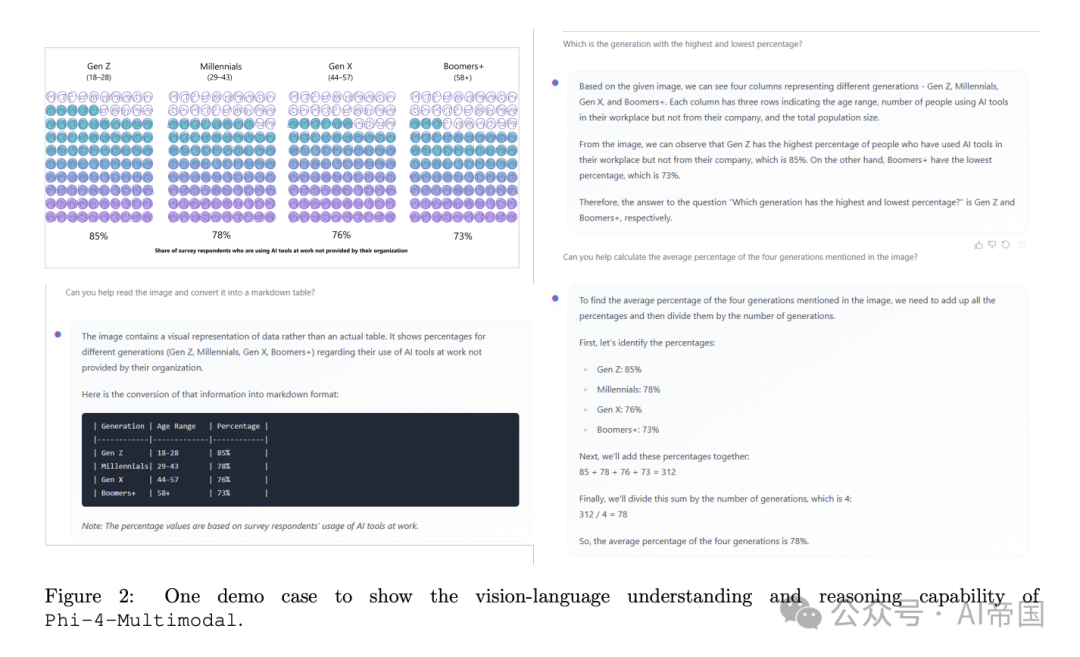

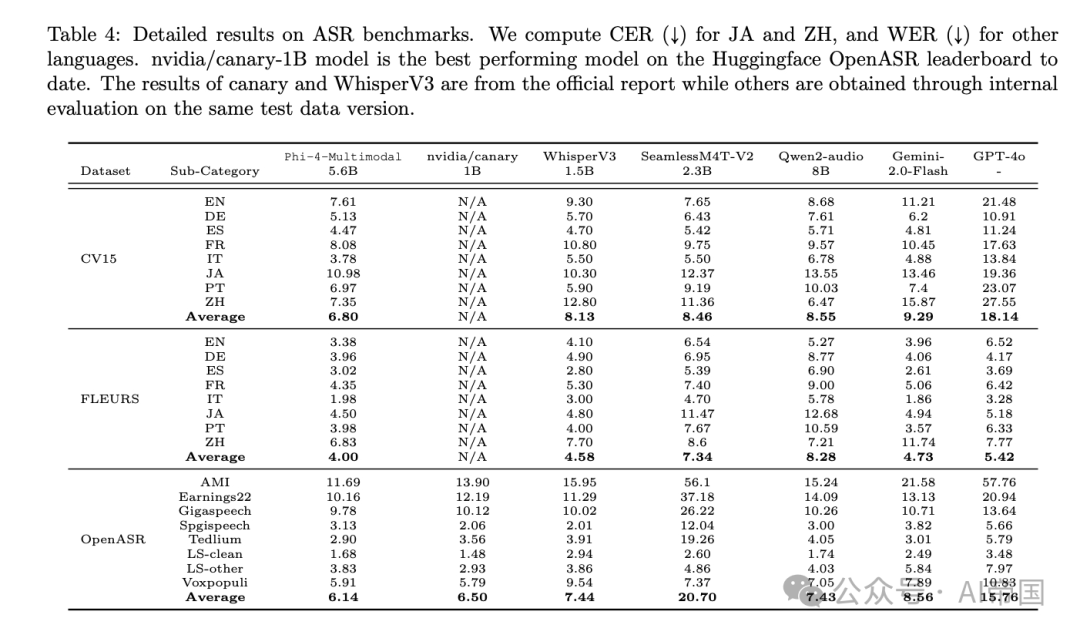

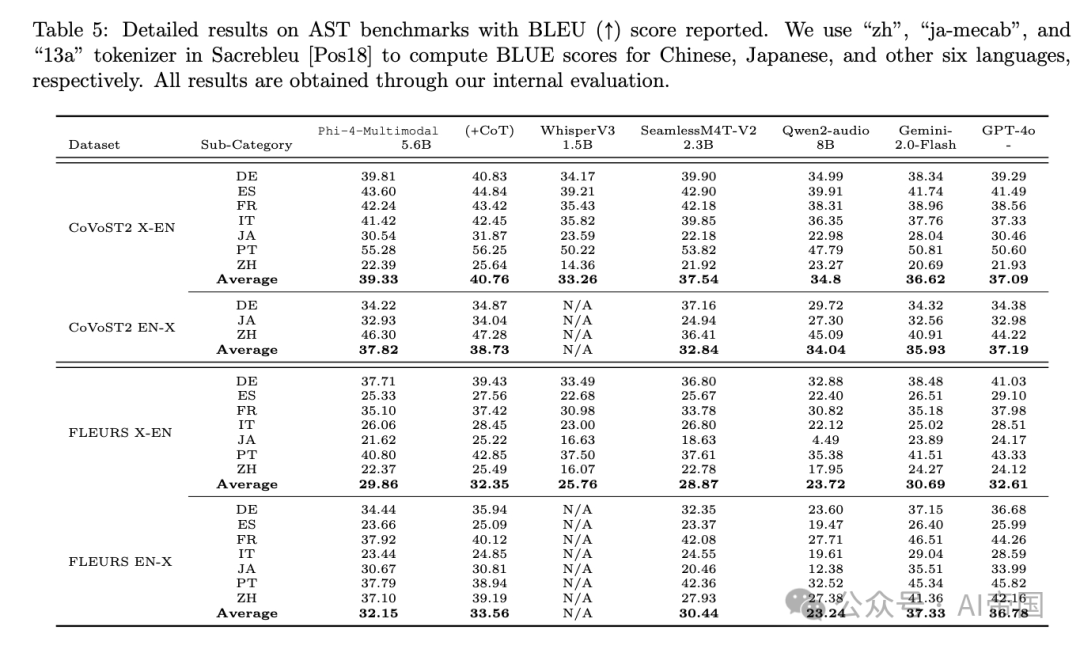

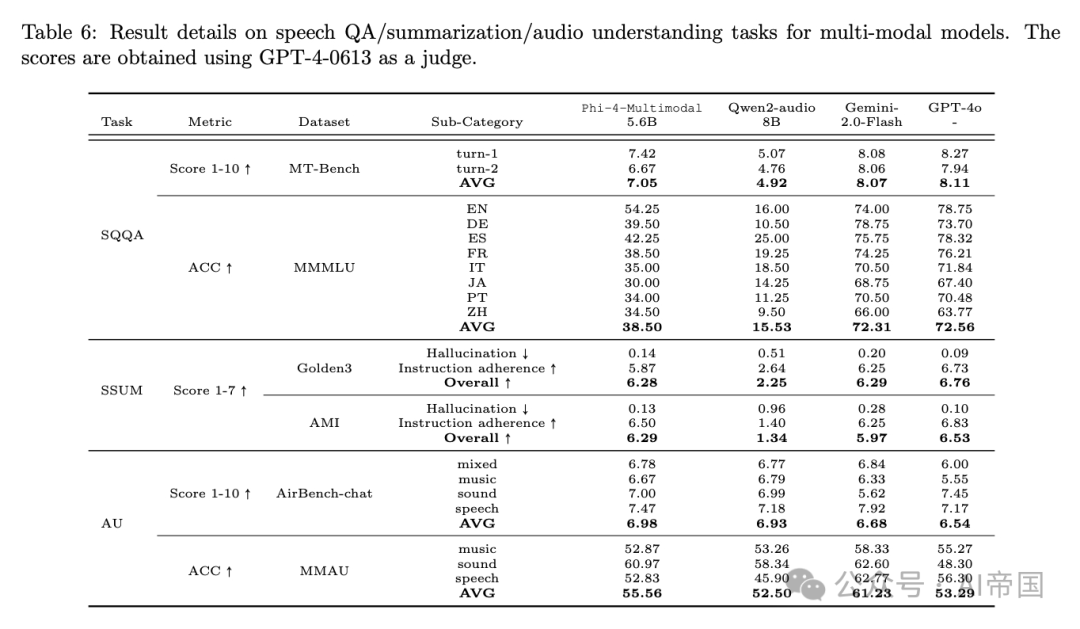

结果让人眼前一亮。Phi-4-Mini在数学和编码任务上,能和参数量两倍的模型打平手,甚至在推理能力上比肩更大规模的DeepSeek模型。Phi-4-Multimodal更夸张,它在语音识别(OpenASR排行榜第一)、图像描述、视频总结等任务上吊打同级别对手,甚至在某些测试中超过GPT-4o和Gemini。比如,它能把30分钟的语音总结成几句话,还几乎没错漏;给它张科学图表,它能瞬间读懂并回答问题,准确率让大模型都汗颜。

图片

图片

更重要的是,这两个模型体积小巧,适合在普通设备上跑。想象一下,未来你的手机就能装个Phi-4-Multimodal,拍照问问题、语音记笔记,全都不用联网。这不只是技术突破,更是AI普及的希望。

图片

图片

图片

图片

图片

图片

图片

图片

图片

图片

四、未来展望:AI的新方向在哪里?

Phi-4-Mini和Phi-4-Multimodal告诉论文,AI不一定非要“大而全”,小而精可能是未来。微软用事实证明,通过聪明的数据选择和架构设计,小模型也能挑大梁。这对普通用户和开发者来说是福音:成本低了,门槛降了,AI可以走进更多人的生活。从智能助手到教育工具,再到医疗辅助,Phi-4系列的潜力才刚开始显现。它还挑战了一个常识——“越大越好”,用实力证明“浓缩才是精华”。

想知道它有多强?拿个场景感受下:你拍张数学作业的照片,录段语音问“怎么解”,Phi-4-Multimodal几秒钟就给你答案,还顺便把解题思路讲得清清楚楚。这样的AI,谁不想试试呢?

论文标题:Phi-4-Mini Technical Report: Compact yet Powerful Multimodal Language Models via Mixture-of-LoRAs

论文链接:https://arxiv.org/abs/2503.01743

本文转载自AI帝国,作者:无影寺