FlexTok-一种图像编码新方式 原创

本文介绍一种图像编码的方法。

图像标记化推动了自回归图像生成发展,但传统 2D 网格标记和现有 1D 标记方法存在不足,如无法适应图像内在复杂性。FlexTok 创新之处在于可将 2D 图像投影为可变长度、有序的 1D 标记序列,图像标记化通过提供一种比原始像素更高效、更易处理的压缩离散表示,极大地推动了自回归图像生成的发展。

传统方法多采用二维网格标记化,但像TiTok这样的最新研究表明,一维标记化能够通过消除网格冗余来实现高质量的图像生成。

感兴趣的小伙伴可以阅读原文:https://arxiv.org/pdf/2502.13967

模型介绍

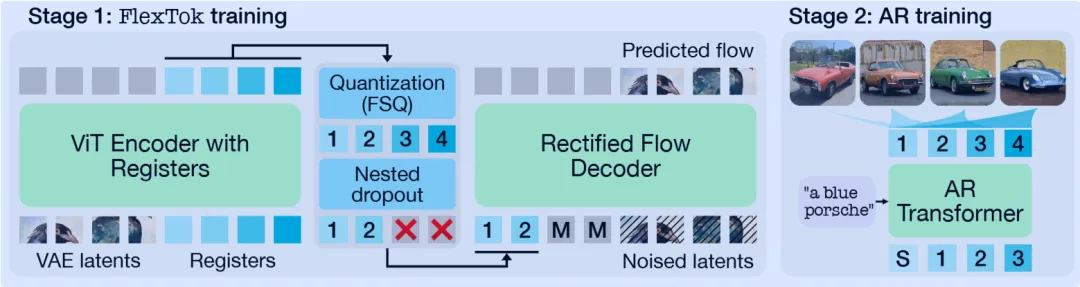

上图展示了 FlexTok 的整体架构和工作流程,分为两个主要阶段:

阶段 1:FlexTok 训练:

- 重采样与量化:FlexTok 使用带有寄存器的视觉 Transformer(ViT)将 2D 的变分自编码器(VAE)潜在特征重采样为 1D 的离散标记序列。之后,使用有限标量量化FSQ对这些序列进行量化,得到瓶颈层表示。

- 整流流模型解码与重建:量化后的瓶颈层表示被用于为整流流模型提供条件,该模型负责解码并重建原始图像。

- 学习有序可变长度标记序列:通过对寄存器标记应用嵌套随机失活,FlexTok 学习到有序的、可变长度的标记序列。这种方式使得模型能够以一种从粗到细的方式对图像进行编码,早期的标记捕获图像的高级语义和几何信息,而后续添加的标记则逐步补充更精细的细节。

阶段 2:自回归(AR)训练

- 训练 AR 模型:训练类别条件和文本条件的自回归 Transformer 模型,以从粗到细的方式预测 1D 标记序列。

- 生成图像细节递进:随着预测的标记数量增加,生成的图像会变得更加具体。模型首先编码高级概念,例如图像中是否有汽车;然后逐渐添加更精细的细节,如汽车的形状、品牌和颜色等 。通过这种方式,FlexTok 能够根据不同的条件和需求,生成具有不同细节程度的图像,展示了其在图像生成任务中的灵活性和有效性。

实验效果

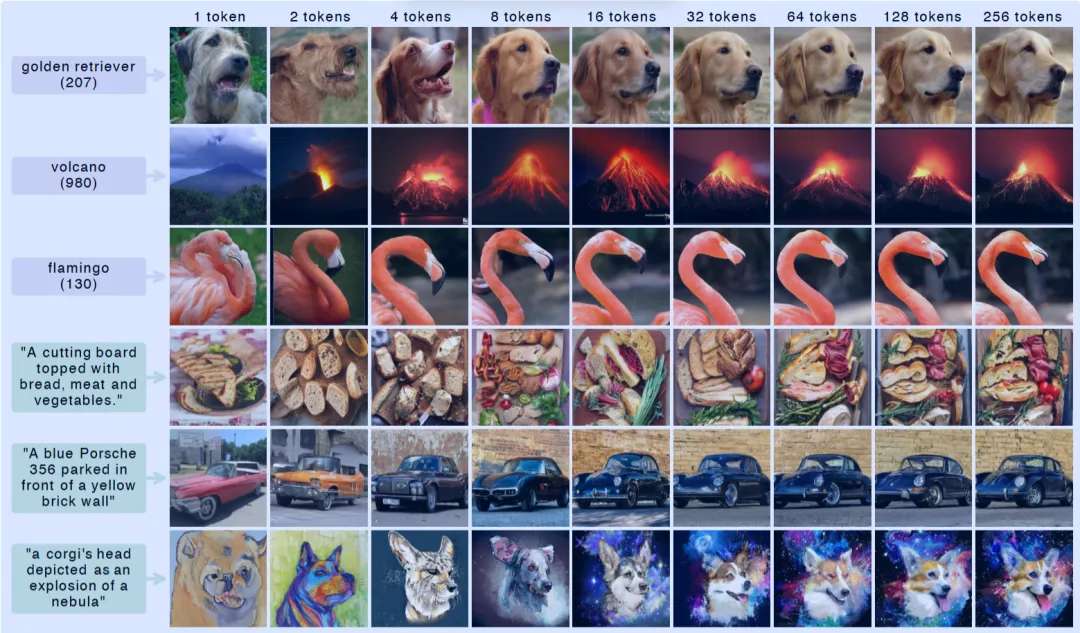

FlexTok将图像转化为有序的标记序列。通过训练基于类别和文本条件的模型,FlexTok标记序列扮演了“视觉词汇表”的角色,使自回归模型能够以递增的特异性描述图像内容。与传统自回归模型在固定光栅扫描顺序下生成图像不同,FlexTok方法能够逐步细化图像细节。简单的条件,例如ImageNet类别标签,可能仅需16个标记即可满足;而更复杂的条件,如开放式文本提示,则可能需要多达256个标记才能达到最佳效果。

如上图所示,不同词元数量的图像生成示例。使用类别条件(前3行)和文本条件(后3行)生成的图像表明,基于FlexTok的模型在仅使用单个词元的情况下也能生成高质量图像,并且所有这些都在单个模型内实现。随着生成的词元增多,条件对齐效果增强。例如,对于提示语“一只柯基犬的头部被描绘成星云爆炸的样子”,前两个词元捕捉到了狗的艺术描绘这一高级概念,而添加更多词元则会增加更多细节,如狗的品种和星云背景。

文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷

原文链接:https://mp.weixin.qq.com/s/fp_FEuISXmHPCa0fhEGJDg