多智能体强化学习如何让AI回答更精准?MMOA-RAG的突破性进展 原创 精华

01、概述

近年来,大型语言模型(LLMs)在自然语言处理领域掀起了一场革命,从智能聊天机器人到知识检索系统,LLMs的应用无处不在。然而,这些模型生成的答案有时会过时,甚至出现“幻觉”(即生成不准确或无依据的内容)。为了解决这一问题,**检索增强生成(Retrieval-Augmented Generation, RAG)**应运而生。RAG通过引入外部知识库来增强LLMs的表现,但如何优化复杂的RAG系统仍然是一个巨大的挑战。

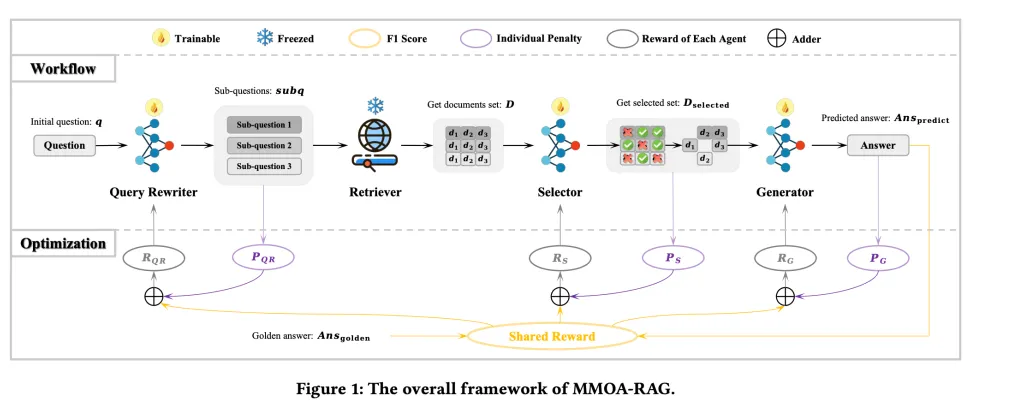

传统的优化方法通常将RAG的各个模块分开优化,导致效率低下且目标不一致。而今天我们要介绍的多模块联合优化算法(MMOA-RAG),则通过多智能体强化学习(Multi-Agent Reinforcement Learning, MARL),实现了对整个RAG系统的协同优化。本文将深入探讨RAG优化的挑战,以及MMOA-RAG如何通过协作学习显著提升答案的准确性。

02、RAG系统的挑战:模块间的协同优化

一个理想的RAG系统通常由多个相互依赖的模块组成:

- 查询重写(Query Rewriting):通过重构用户查询,使其更具结构性和相关性,从而提高检索质量。例如,当用户问“量子计算研究的最新进展是什么?”时,重写模块可能会将其转化为“量子计算的最新突破和发现”,以提高文档检索的准确性。

- 文档检索(Document Retrieval):从外部知识库(如数据库、搜索引擎或向量知识系统)中检索相关信息。例如,在客服AI中,检索过去的用户投诉和解决方案,可以确保生成个性化且准确的回答。

- 文档过滤(Document Filtering):从检索到的文档池中选择最有用的内容。该模块根据相关性、新颖性和简洁性对文档进行评分,去除重复或信息量较低的内容。例如,当用户问“绿茶的健康益处是什么?”时,过滤模块可能会优先选择最近的元分析研究,而不是较旧的研究或泛泛而谈的文章。

- 答案生成(Answer Generation):基于过滤后的文档生成最终答案。该模块利用LLM生成连贯、准确且符合语境的回答。例如,当被问及“社交媒体对政治话语的影响”时,生成器会综合学术研究、新闻报道和社交媒体分析,生成一个全面的回答。

目前,大多数优化技术将这些模块分开处理,依赖监督微调(Supervised Fine-Tuning, SFT)。然而,这种方法导致模块目标与最终目标(生成最准确且符合语境的回答)之间脱节。尽管已有研究尝试使用强化学习(Reinforcement Learning, RL)来优化RAG,但这些方法通常只针对一两个模块进行优化。而MMOA-RAG则通过将整个RAG系统建模为一个多智能体系统,每个模块都是一个RL智能体,共同协作以实现最终目标。

03、MMOA-RAG框架与多智能体强化学习

MMOA-RAG将RAG系统建模为一个**协作多智能体强化学习(Cooperative Multi-Agent Reinforcement Learning, Co-MARL)**问题。在这个框架中,多个智能体在同一个环境中协作,以最大化共享目标。具体来说,该框架由以下四个要素定义:

- 全局状态(G):系统的当前状态,包括查询嵌入、检索到的文档和上下文。

- 观察(O):每个智能体接收到与自身任务相关的部分全局状态。例如,文档选择器会观察到文档的相关性评分和语义相似性。

- 动作(A):每个智能体根据观察结果采取行动,以改进查询重写、文档选择或答案生成。

- 奖励(R):智能体根据最终输出的F1分数获得共享奖励,确保所有智能体的目标一致。

这种协作机制避免了智能体之间的目标冲突,确保它们共同致力于提高答案质量。

04、MAPPO算法与训练细节

什么是近端策略优化(PPO)?

近端策略优化(Proximal Policy Optimization, PPO)是一种强化学习算法,能够在保持策略更新稳定性的同时,平衡探索与利用。它通过裁剪目标函数防止策略更新过于激进,从而避免灾难性失败。

伪代码:

MAPPO如何扩展PPO以支持多智能体系统?

MMOA-RAG采用了多智能体近端策略优化(Multi-Agent PPO, MAPPO),这是PPO的扩展版本,专为多智能体环境设计。与标准PPO不同,MAPPO通过以下方式实现多智能体协同优化:

- 全局评价模型(Global Critic Model):一个中心化的评价模型评估所有智能体的动作,确保每个智能体的决策都服务于全局优化目标。

- 共享奖励机制(Shared Reward Mechanism):所有智能体共同优化一个共享目标(如最终答案的F1分数),而不是各自为战。

- 同步多智能体训练(Simultaneous Multi-Agent Training):所有RAG模块同时优化,确保它们相互补充而非矛盾。

这种协作训练策略使每个RAG模块都能为最终答案的生成做出有效贡献,从而生成更准确且符合语境的回答。

05、MMOA-RAG的实验结果与未来方向

实验结果

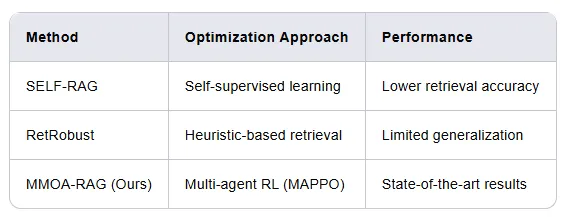

MMOA-RAG在多个数据集上进行了实验,包括HotpotQA、2WikiMultihopQA和AmbigQA。实验结果表明,MMOA-RAG在检索精度和答案准确性方面均达到了最先进的水平。与其他方法(如SELF-RAG和RetRobust)相比,MMOA-RAG展现了更强的泛化能力和鲁棒性。

未来方向

未来研究将探索以下方向:

- 动态奖励塑造(Dynamic Reward Shaping):通过调整奖励函数,进一步优化智能体协作。

- 多轮问答(Multi-turn Question Answering):扩展MMOA-RAG以支持多轮对话场景。

- 复杂RAG架构的集成:将MMOA-RAG应用于更复杂的RAG架构,如结合知识图谱或推理模块。

06、总结

MMOA-RAG通过多智能体协作强化学习,为RAG系统的优化提供了一种全新的思路。通过协同优化查询重写、文档选择和答案生成模块,MMOA-RAG显著提升了AI生成答案的准确性和可靠性。未来,随着动态奖励塑造和多轮问答等技术的引入,MMOA-RAG有望在更复杂的场景中发挥更大的作用。

本文转载自公众号Halo咯咯 作者:基咯咯

原文链接:https://mp.weixin.qq.com/s/QLpQp8vF0eI27t_906e6Ng