MLLMs人类偏好增强对齐,自然图像和数据图表分离;视觉感知标记,模型自主决定感知内容

OmniAlign-V: Towards Enhanced Alignment of MLLMs with Human Preference

2025-02-25|SJTU, Shanghai AI Lab, NJU, FDU, ZJU|🔺54

http://arxiv.org/abs/2502.18411v1

https://huggingface.co/papers/2502.18411

https://github.com/PhoenixZ810/OmniAlign-V

研究背景与意义

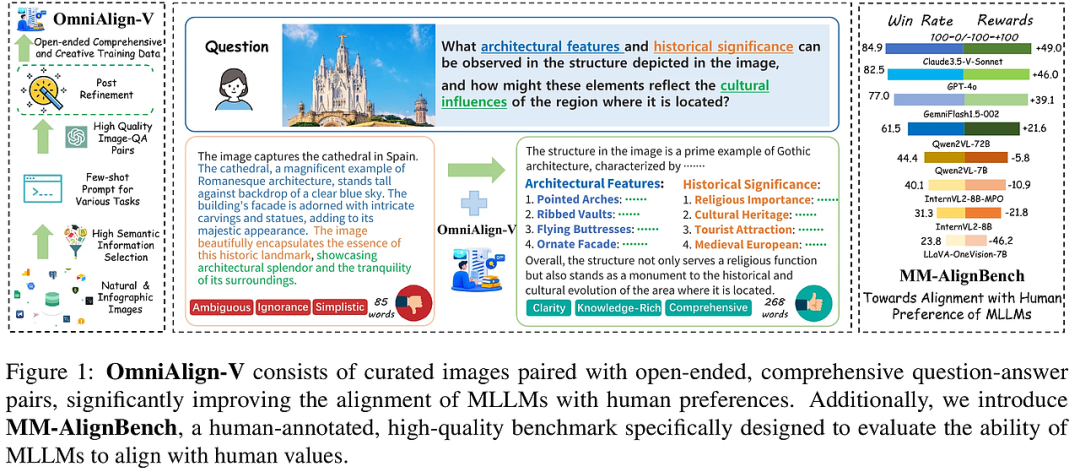

随着多模态大语言模型(MLLMs)的快速发展,现有的研究主要集中在提升模型的基础能力,如物体识别、OCR等,而在与人类偏好对齐方面存在显著差距。这种对齐的缺失直接影响了多模态对话交互中的用户体验。本文提出的OmniAlign-V数据集,旨在通过提供高质量、多样化的训练样本,显著提升MLLMs与人类偏好的对齐能力。此外,本文还引入了MM-AlignBench,一个专门设计用于评估MLLMs与人类价值观对齐能力的高质量基准。

研究方法与创新

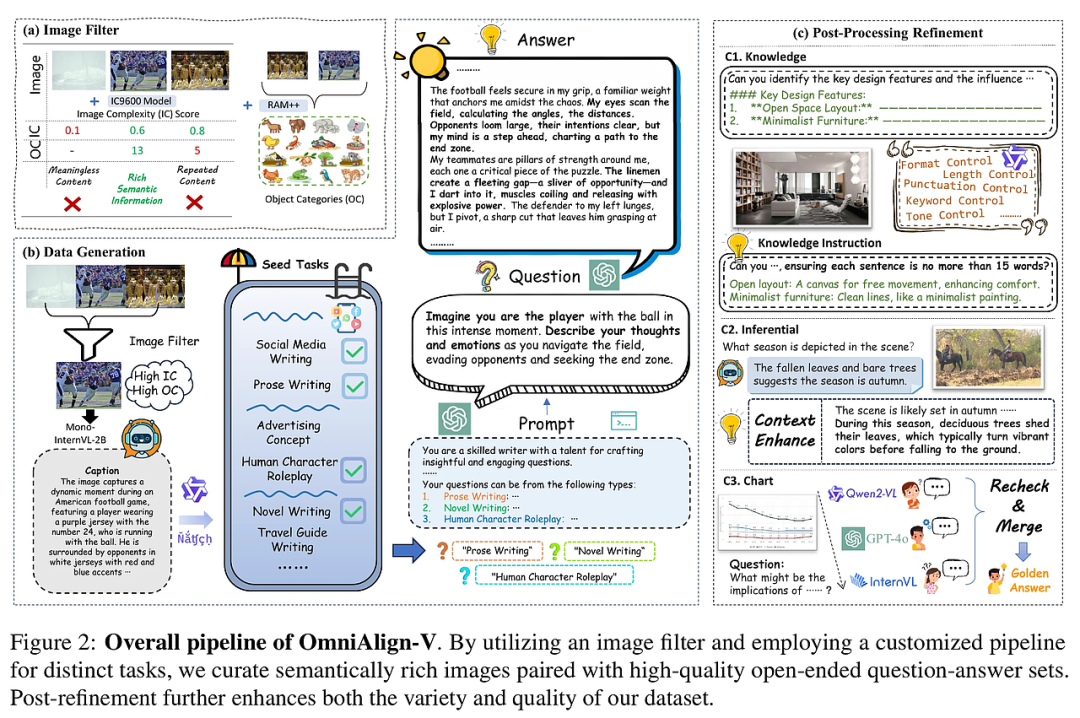

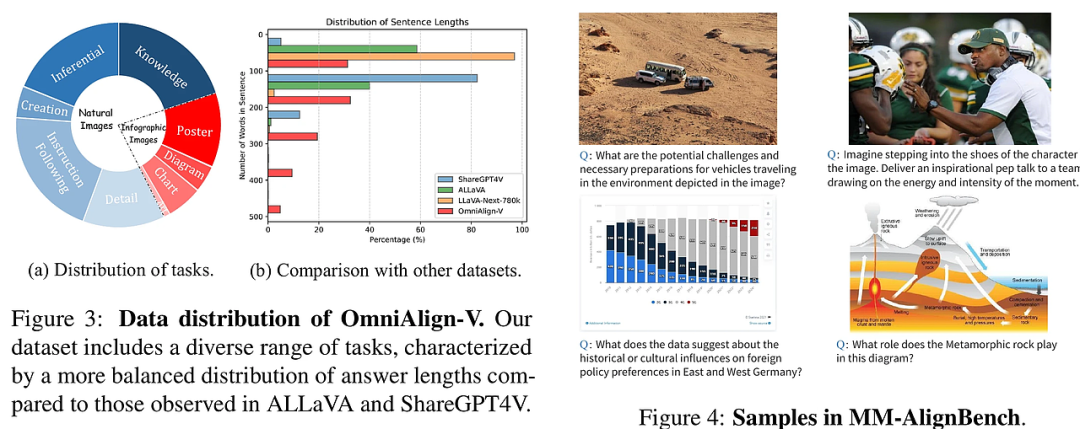

OmniAlign-V数据集的核心创新在于其多样化的任务设计和高质量的数据生成流程。首先,数据集将图像分为自然图像和信息图表两大类,并为每类图像设计了不同的任务类型,如知识问答、推理任务和创造性任务。其次,通过图像筛选策略,确保所选图像具有丰富的语义信息,从而生成更具挑战性和多样性的问答对。

在数据生成过程中,OmniAlign-V采用了多阶段的生成和优化流程。对于自然图像,使用GPT-4生成多样化的问答对,并通过后处理步骤进一步优化答案的质量。对于信息图表,设计了专门的提示词,确保生成的问答对能够深入挖掘图像中的信息。此外,OmniAlign-V还引入了指令增强的知识问答,通过将复杂指令融入问题中,进一步提升模型的对齐能力。

实验设计与结果分析

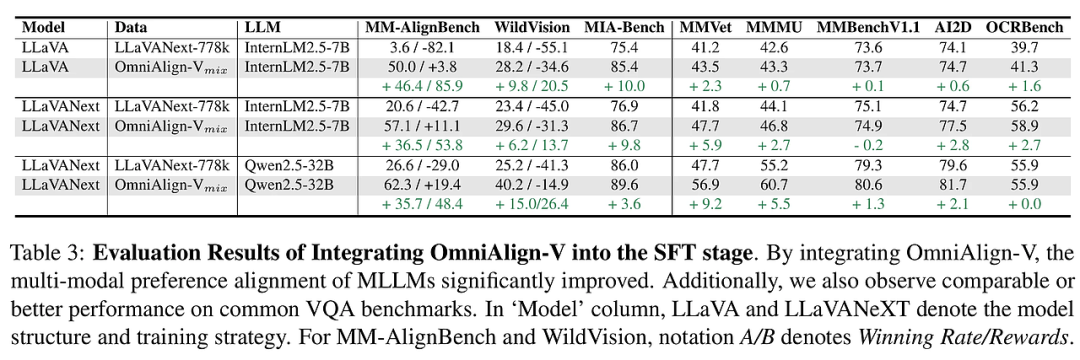

实验结果表明,使用OmniAlign-V进行微调的MLLMs在多个基准测试中表现显著提升。特别是在MM-AlignBench和WildVision等人类偏好对齐基准上,模型的性能得到了大幅改善。此外,OmniAlign-V在保持模型基础能力的同时,进一步提升了其在复杂问答任务中的表现。

通过对比实验,OmniAlign-V在多个任务类型上的表现均优于现有的数据集。例如,在知识问答任务中,OmniAlign-V生成的问答对不仅涵盖了广泛的主题,还通过指令增强的方式提升了模型的指令遵循能力。在创造性任务中,OmniAlign-V通过多样化的任务设计,显著提升了模型在生成创意内容方面的表现。

结论与展望

OmniAlign-V的引入为提升MLLMs与人类偏好的对齐能力提供了新的解决方案。通过多样化的任务设计和高质量的数据生成流程,OmniAlign-V显著提升了模型在复杂问答任务中的表现。未来的研究可以进一步探索如何将OmniAlign-V与其他多模态数据集结合,以进一步提升模型的泛化能力和对齐效果。

此外,MM-AlignBench的引入为评估MLLMs的对齐能力提供了新的基准。通过精心设计的图像和问题,MM-AlignBench能够更全面地评估模型在真实世界场景中的表现。未来的工作可以进一步扩展MM-AlignBench的规模和多样性,以覆盖更多的应用场景和任务类型。

Introducing Visual Perception Token into Multimodal Large Language Model

2025-02-24|NUS|🔺5

http://arxiv.org/abs/2502.17425v1

https://huggingface.co/papers/2502.17425

https://github.com/yu-rp/VisualPerceptionToken

研究背景与意义

在当今的多模态大语言模型(MLLM)领域,视觉信息的处理能力直接影响模型在空间推理、细粒度理解等任务中的表现。然而,现有的MLLM系统缺乏自主控制其视觉感知过程的能力,例如无法选择性地审查图像的特定区域或聚焦于与特定对象类别相关的信息。这种局限性导致模型在处理复杂视觉任务时,往往依赖于手动设计的流程,限制了其在实际应用中的灵活性和效率。

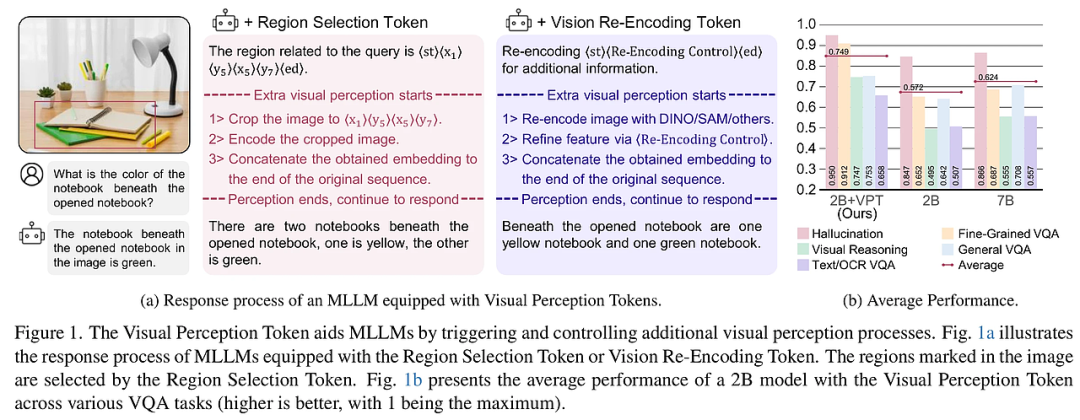

本文提出的“视觉感知标记”(Visual Perception Token)概念,旨在赋予MLLM一种机制,使其能够自主控制视觉感知过程。通过设计两种类型的视觉感知标记——区域选择标记(Region Selection Token)和视觉重编码标记(Vision Re-Encoding Token),MLLM可以像生成文本一样生成这些标记,并利用它们触发额外的视觉感知动作。这一创新不仅提升了模型在空间推理和细粒度理解任务中的表现,还为MLLM在视觉信息处理中的自主性开辟了新的研究方向。

研究方法与创新

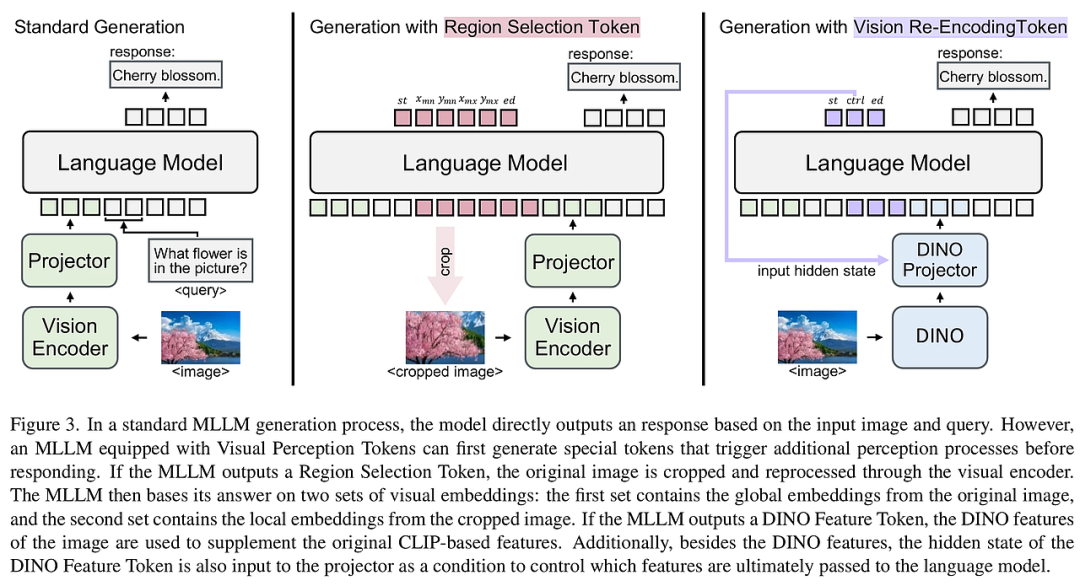

本文的核心创新在于引入了视觉感知标记,使MLLM能够自主控制其视觉感知过程。具体来说,区域选择标记能够明确识别图像中需要进一步感知的特定区域,而视觉重编码标记则利用其隐藏状态作为控制信号,引导额外的视觉感知过程。这两种标记的引入,使得MLLM在处理视觉信息时,能够更加灵活和精准。

区域选择标记区域选择标记通过将图像划分为若干单元格,并使用这些单元格的索引来描述需要进一步感知的区域。这种方法避免了直接使用像素坐标的复杂性,简化了模型的训练过程。具体来说,模型生成一组区域选择标记,指示图像中需要裁剪的区域,然后将裁剪后的图像重新输入模型进行进一步处理。这种方法在处理文档理解、OCR相关任务时尤为有效,因为它能够直接提高图像的分辨率,从而提升任务表现。

视觉重编码标记视觉重编码标记则通过触发额外的视觉编码器(如DINO或SAM模型)来重新编码原始图像,并将生成的视觉特征与原始视觉特征结合,输入到MLLM中。视觉重编码标记的隐藏状态作为控制信号,能够精细地控制最终输入到语言模型的嵌入序列。这种方法在处理需要多次视觉感知的任务时,表现出显著的优势。

训练数据与模型架构为了训练MLLM使用视觉感知标记,本文构建了一个包含829k样本的训练数据集,涵盖了通用视觉问答(General VQA)、细粒度视觉问答(Fine-Grained VQA)、空间推理(Spatial Reasoning)和文本/OCR相关视觉问答(Text/OCR-Related VQA)等任务。模型架构方面,本文在标准的MLLM基础上,增加了额外的视觉编码器和投影器,使得模型能够处理视觉重编码标记生成的额外视觉特征。

实验设计与结果分析

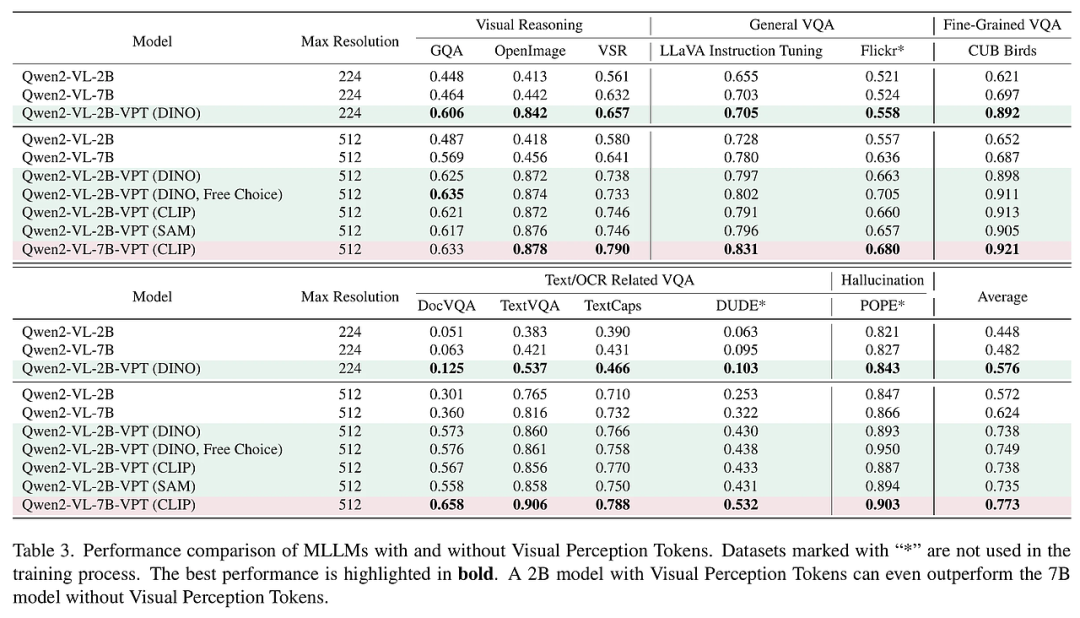

本文通过一系列实验验证了视觉感知标记的有效性。实验结果表明,引入视觉感知标记后,2B参数的模型在多个任务中的表现显著提升,甚至超过了7B参数的基线模型。具体来说,在空间推理和细粒度视觉问答任务中,2B+VPT模型的性能分别提升了34.6%和32.7%。此外,视觉感知标记在零样本设置下也表现出色,进一步证明了其泛化能力。

实验结果在通用视觉问答任务中,2B+VPT模型的表现与7B模型相当,但在空间推理和细粒度视觉问答任务中,2B+VPT模型显著优于7B模型。例如,在CUB-200-2011数据集上,2B+VPT模型的性能提升了20.7%。此外,在处理低分辨率图像时,2B+VPT模型的表现也优于7B模型,证明了视觉感知标记在不同分辨率下的有效性。

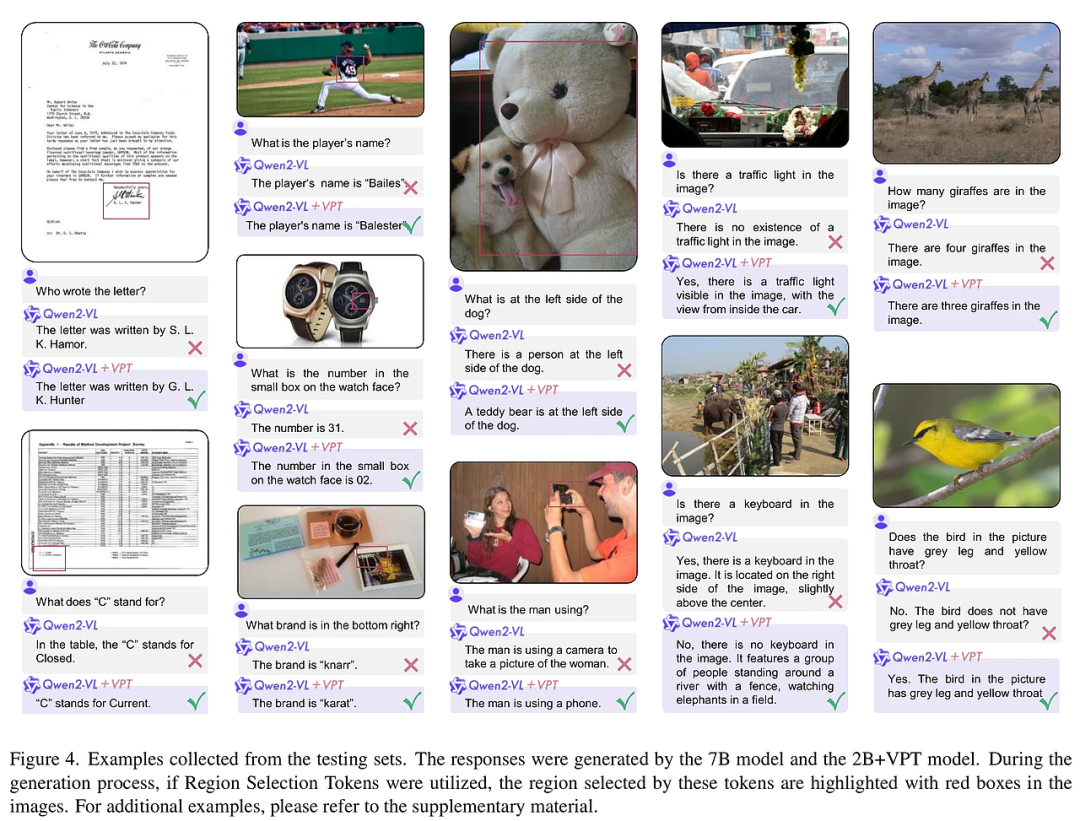

案例分析通过具体案例的分析,本文展示了视觉感知标记在处理复杂视觉任务时的优势。例如,在处理文档理解任务时,区域选择标记能够精确定位图像中的小区域(如签名、页脚等),从而显著提升OCR任务的准确性。在处理空间推理任务时,视觉重编码标记能够通过多次视觉感知,增强模型对空间关系的理解。

结论与展望

本文提出的视觉感知标记为MLLM在视觉信息处理中的自主性提供了新的解决方案。通过区域选择标记和视觉重编码标记,MLLM能够更加灵活和精准地处理视觉信息,显著提升了其在空间推理、细粒度理解等任务中的表现。未来的研究方向可以进一步探索视觉感知标记在其他多模态任务中的应用,以及如何通过更复杂的控制机制,进一步提升MLLM的视觉感知能力。

此外,本文的实验结果表明,视觉感知标记在处理低分辨率图像时也表现出色,这为在资源受限环境下的应用提供了新的可能性。未来的工作可以进一步优化视觉感知标记的训练过程,探索如何在不增加模型参数的情况下,进一步提升其性能。

总之,视觉感知标记的引入为MLLM在视觉信息处理中的自主性开辟了新的研究方向,具有广泛的应用前景。

本文转载自 AI研究前瞻,作者: 胡耀淇