推理模型+Multi-Agent,可能就是Deep Research的全貌!

继谷歌、OpenAI和Perplexity相继发布各自的Deep Research后,牛津大学发布了一个 “Agentic Reasoning: Reasoning LLMs with Tools for the Deep Research”的工作,并且代码开源了,今天咱们来详细看看他们的 deepresearch 的玩法!

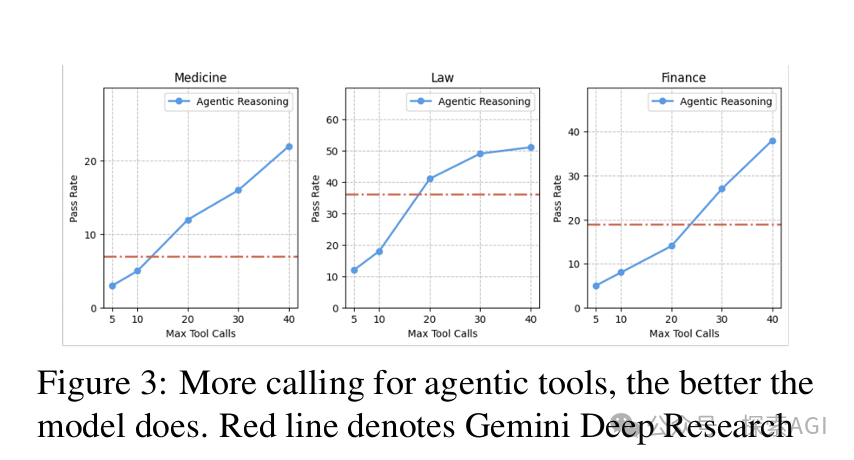

这个框架,不仅在PhD级别的科学推理测试(GPQA)上超越了现有的RAG系统和闭源大模型, 而且在金融、医疗和法律等领域的深度研究任务中,击败了谷歌的Gemini Deep Research!

为什么能做到这一点?

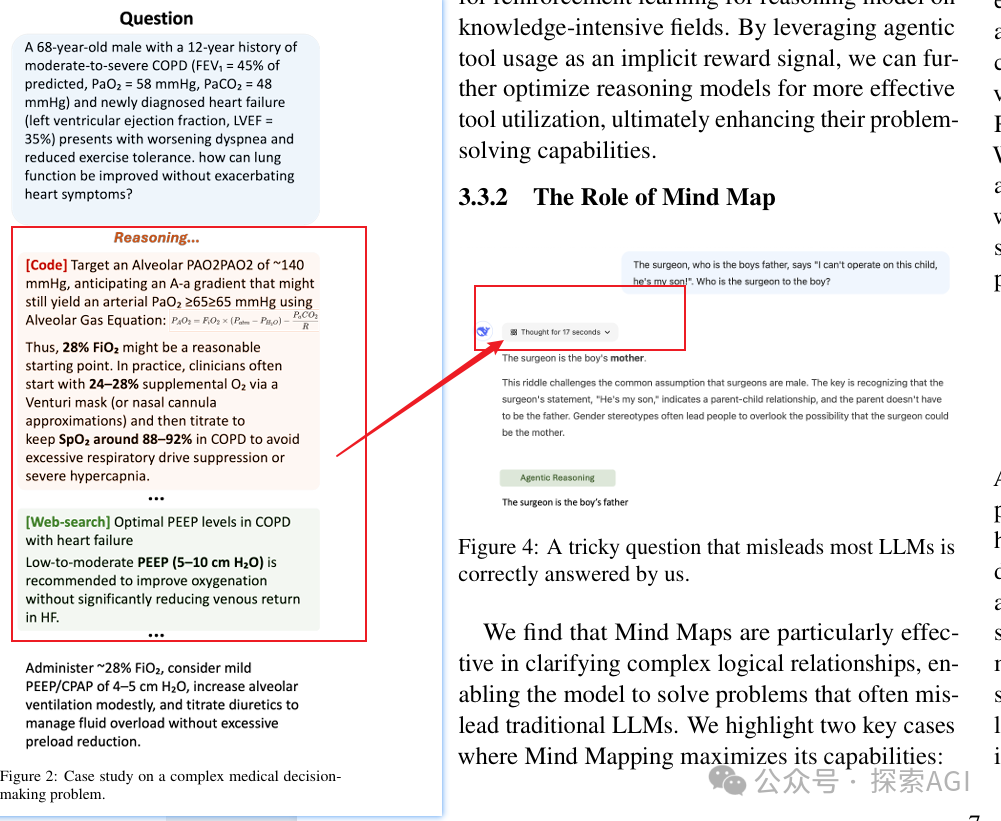

普通的推理模型只能依赖自身知识,或者联网的上下文知识,进行长时间思考推理,最后做出回应。而推理模型的思考过程,如果能调用工具来辅助推理,那必须是事半功倍。

Agentic Reasoning来了,它模仿了人解决复杂问题的方式。 通过互联网收集信息、用计算工具进行定量分析、在白板上组织思路。

所以他们定制了3个核心智能体:

- Web搜索智能体:负责从互联网获取信息

- 代码智能体:使用Python进行计算分析

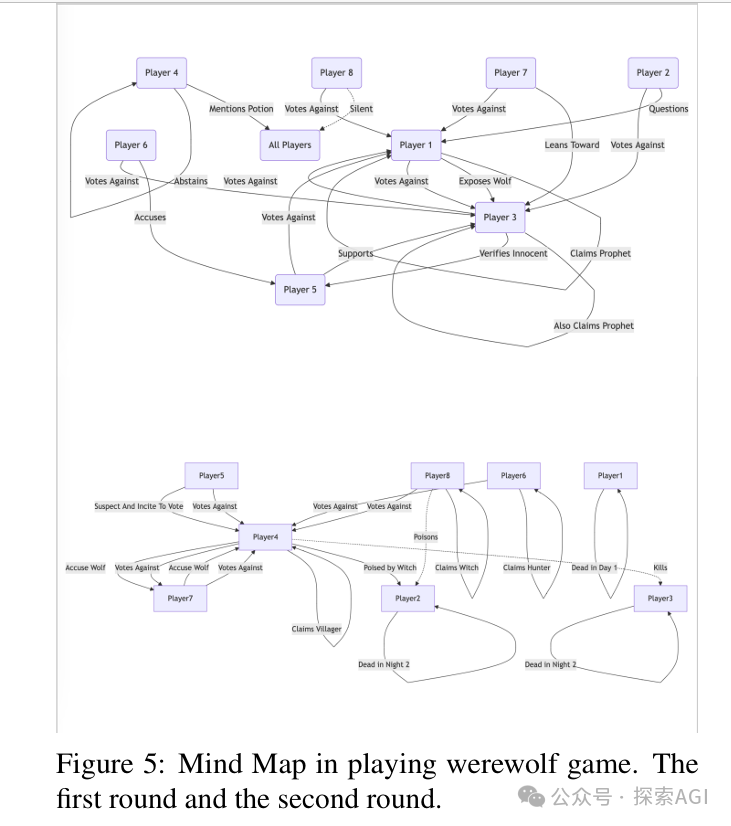

- "思维导图"记忆智能体:构建基于推理上下文的知识图谱 (trick,后面细说)

对复杂问题的工具调用推理过程,本身可以很好的跟推理大模型的思考过程融合到一起!

推理大模型进行正常的推理,根据任务需求自行实时决定是否需要其他信息。(生成相应的token即可,工具调用完成,可以把结果整合回推理链中)。

经过过长的思维链+外部知识(web,code),思维链可能会变得很混乱,所以这个框架引入了一个MindMap智能体。这个智能体可以将原始的推理链转换为一个结构化的知识图谱(这个工作直接把graphrag搬过来了,实体抽取->构建社区->抽象社区摘要)。

一些发现!

分工的重要性

让不同的LLM专注于各自擅长的任务(如DeepSeek-R1负责推理,Claude-Sonnet负责编程),能显著提升整体表现。

少即是多

仅使用少量智能体工具反而能获得最佳效果。增加更多工具反而会增加选择错误的风险。

工具使用与准确性

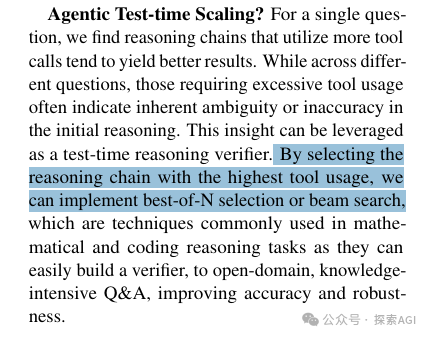

对单个问题而言,使用更多工具通常能带来更好的推理结果。但是如果跨问题都需要频繁调用工具,可能意味着初始推理轨迹存在缺陷。

项目开源地址:https://github.com/theworldofagents/Agentic-Reasoning

框架的表现,在几个领域大幅超越 Google DeepResearch效果。甚至超越了各个领域的人类专家。在一些需要20分钟以上的深度研究问题上,也表现优异。

本文转载自 探索AGI,作者: 猕猴桃