直击痛点,新一代身份保持视频生成解决方案!阿里等提出FantasyID:多视角与3D融合!

文章链接:https://arxiv.org/pdf/2502.13995

项目链接:https://fantasy-amap.github.io/fantasy-id/

亮点直击

- 首次尝试从单视角参考图像中提取3D面部先验,以增强面部结构的稳定性,从而在整个视频生成过程中有益于身份(ID)保持。

- 通过采用多视角面部增强策略,能够显著增强对广泛视角下2D面部外观的感知,从而有益于与面部表情和头部姿势相关的运动动态。

- 设计了一种可学习的层次化特征引导机制,以促进对身份保持和动态建模的精确控制,从而生成具有更好时间一致性和身份一致性的高保真人物视频。

总结速览

解决的问题

- 面部动态表现不足:现有的身份保持文本到视频生成(IPT2V)方法在生成视频时,难以在保持身份一致性的同时,实现满意的面部动态表现。

- “复制-粘贴”问题:使用单视角参考面部图像进行模型调优时,模型可能会简单地复制参考面部图像,导致生成视频中的面部表情和头部姿势缺乏多样性。

- 层次化控制信号的敏感性:扩散Transformer(DiT)的层次化结构导致不同层对控制信号的敏感性不同,需要专门的调节策略来平衡身份保持和时间一致性。

提出的方案

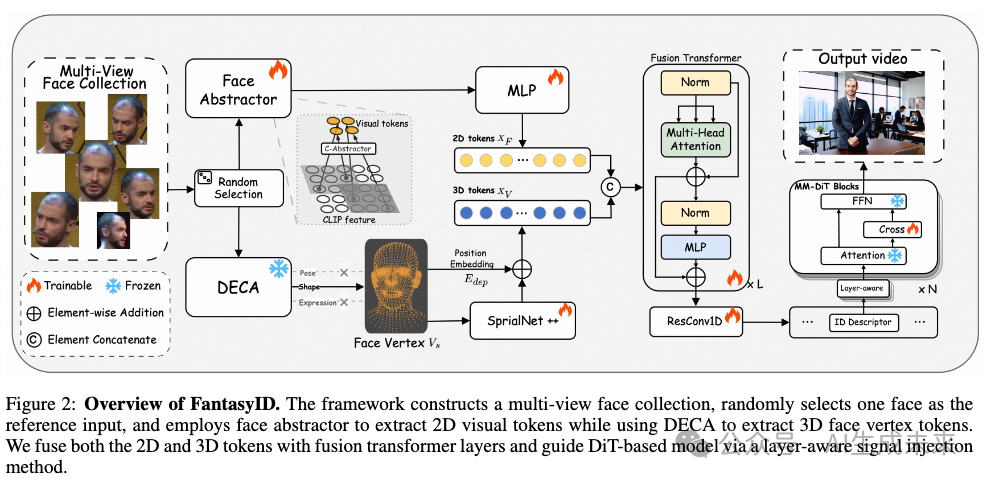

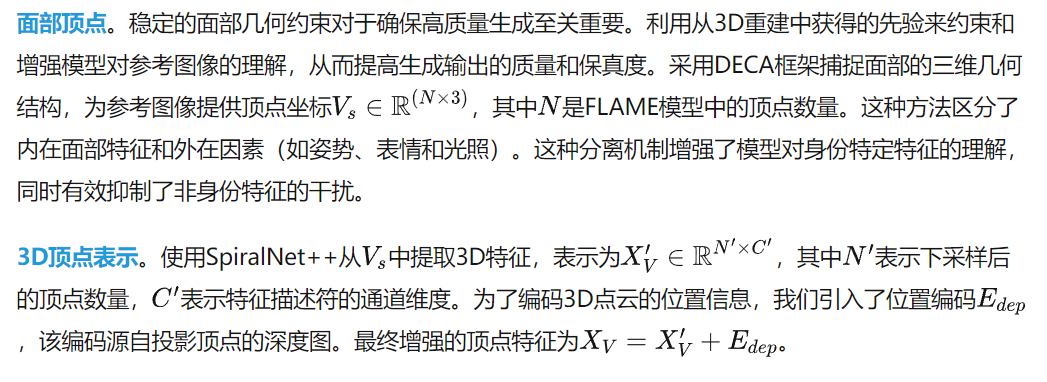

- 引入3D面部几何先验:通过集成3D面部几何先验,确保在视频合成过程中面部结构的稳定性和一致性。使用DECA提取身份特定的3D特征(如形状点云),并丢弃与身份无关的特征(如姿势和表情)。

- 多视角面部增强策略:通过从不同视角增强单视角参考面部图像,形成一个面部池,从中随机选择图像作为预训练视频模型的输入,以避免模型学习“复制-粘贴”的捷径。

- 层次化自适应注入机制:将融合的2D和3D面部特征通过基于Transformer的特征融合模块进行混合,并引入层次化自适应注入机制,选择性地将融合特征注入到每个DiT层中,以平衡身份保持和运动动态。

应用的技术

- 3D面部几何先验:使用DECA提取3D面部几何特征。

- 多视角面部增强:通过多视角图像增强技术,生成多样化的面部图像。

- Transformer特征融合:使用基于Transformer的特征融合模块,将2D和3D面部特征进行融合。

- 层次化自适应注入机制:引入层次化自适应注入机制,选择性地将融合特征注入到DiT的不同层中。

达到的效果

- 提升面部动态表现:通过引入3D面部几何先验和多视角面部增强策略,显著提升了生成视频中面部表情和头部姿势的多样性。

- 避免“复制-粘贴”问题:多视角面部增强策略有效避免了模型简单地复制参考面部图像,增强了生成视频的动态性。

- 平衡身份保持和运动动态:层次化自适应注入机制使得模型能够自适应地选择最有益的特征,从而在保持身份一致性的同时,实现更好的运动动态表现。

- 实验验证:实验结果表明,该方法在当前的无调优IPT2V方法中具有优越性。

方法

给定一张参考面部图像,FantasyID旨在生成一个忠实保留个体身份特征的视频。下图2展示了FantasyID的概述。对于每个训练视频,构建一个多视角面部集合,并随机选择一张参考图像作为输入条件。接着,利用面部抽象器提取2D clip tokens,使用DECA解耦与核心身份无关的特征(如表情、姿势)并提取3D结构信息,并通过融合Transformer将2D tokens和3D tokens融合为面部描述符嵌入。此外,通过采用层次化信号注入方法对基于DiT的模型进行控制,确保每一层的精确调制。

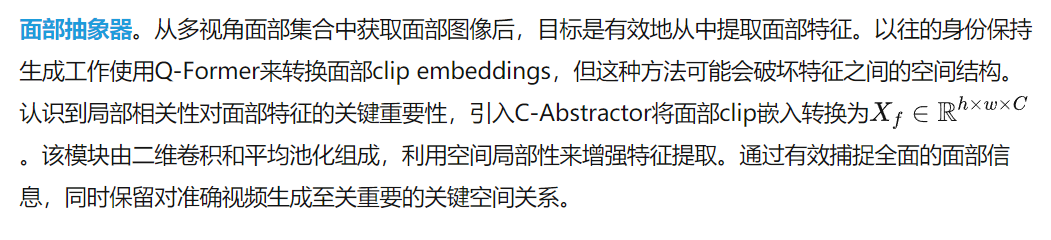

多视角集合与面部抽象器

多视角面部集合。在训练阶段获取有效的身份参考至关重要。为了确保模型专注于关键区域,首先从视频的每一帧中裁剪出面部区域,消除背景干扰。借鉴MovieGen的方法,单一参考图像可能导致模型学习直接复制面部的捷径,因此在训练阶段构建了一个包含不同视角的面部图像集合。使用RetinaFace提取面部关键点之间的几何关系,以计算头部姿势角度,并选择六张视角差异最显著的图像形成一个多视角面部集合I。通过为模型提供多样化的视角,它能够更全面地理解主体,从而增强其在各种姿势和表情下保持身份一致性的能力。

3D约束

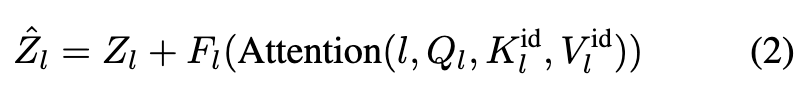

融合Transformer

层次化控制信号注入

受DiT架构中每一层对整体性能有独特贡献的观察启发,本文采用类似的方法来控制基于DiT的面部视频生成。不同层对控制信号的敏感性不同。为了解决这一问题,本文提出了一种层次化控制信号注入机制,根据每一层的作用动态调整控制信号的集成。

对于每个MM-DiT块,采用一个轻量级模型Fl来学习最优特征表示。该轻量级网络由一个卷积块和归一化组成。每一层的独立权重增强了保真度和多样性,使控制信号精确地适应每一层的需求。这确保了输出的稳定性和表现潜力。该过程由以下公式定义:

实验

实验设置

评估指标。本文采用 ArcFace嵌入相似度来评估两个关键方面。首先,参考相似度(Reference Similarity, RS) 计算参考图像与视频帧之间的相似度,以评估身份保持能力。其次,帧间相似度(Inter-Frame Similarity, IFS) 测量连续视频帧之间的相似度,以评估运动过程中身份特征的稳定性。此外,我们通过分析面部区域的 Fréchet Inception Distance (FID) [3] 来评估视频质量,并使用由平均密集光流 测量的面部运动(Face Motion, FM) 来评估运动程度。我们使用了 50 张细节丰富的肖像参考图像。为了更准确地衡量身份保持能力,我们从每个视频中裁剪出面部区域进行定量评估。

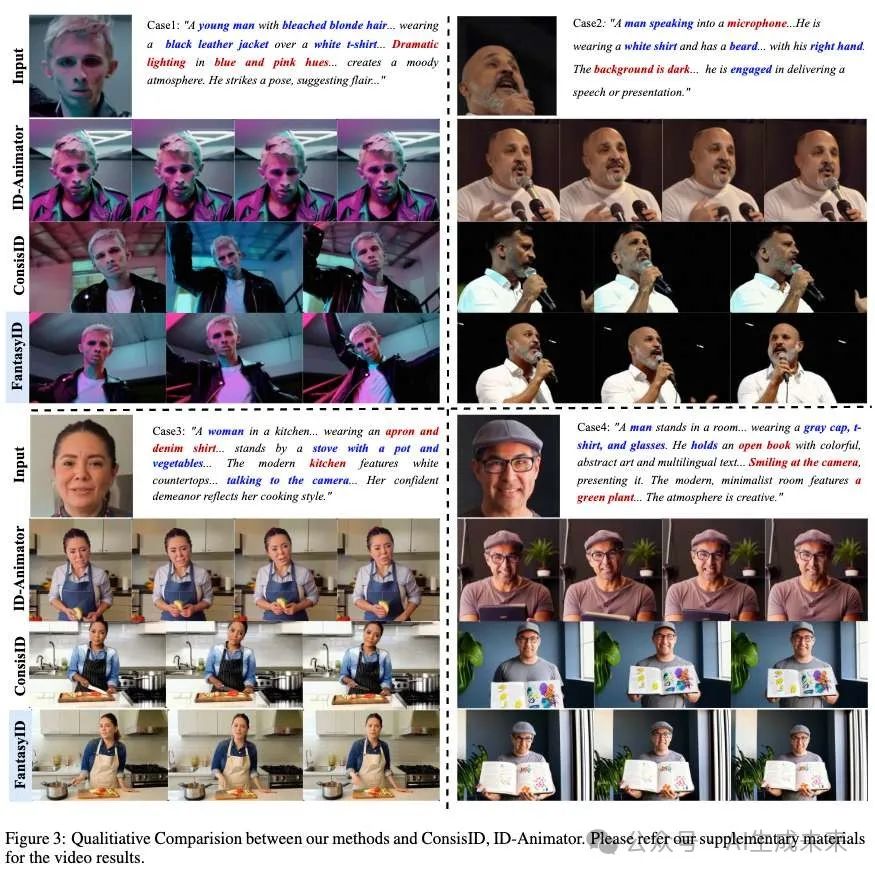

定性分析

为了进行定性评估,展示了与基于扩散的身份保持模型(ConsisID 和 ID-Animator)的比较结果。其他模型,如 VideoMaker和 MagicMirror,由于未开源,因此未包含在直接比较中。

下图 3 展示了 ID-Animator 在生成面部以外的人体部位时存在困难,并表现出明显的“复制-粘贴”伪影。此外,生成的内容通常显得过于静态,缺乏自然运动。这些限制显著限制了其在需要动态和真实人类行为或交互的场景中的实际应用。对于 ConsisID,虽然整体视觉质量较高,但在面部运动过程中仍存在结构不稳定的问题,如案例 1 所示。尽管 ConsisID 保留了参考图像中的皮肤纹理等特征,但在案例 3 和 4 中未能准确再现整体面部结构。相比之下,本文的方法在视觉质量、从参考图像中保留主体身份以及在运动过程中保持帧间一致的面部结构方面取得了最佳效果。

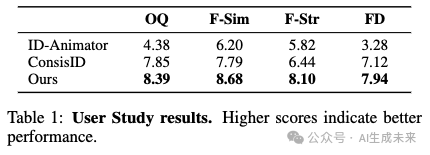

为了进一步验证我们提出方法的有效性,本文进行了一项包含 32 名参与者的综合用户研究。每位参与者被要求评估四个关键方面:整体质量(Overall Quality, OQ)、面部相似度(Face Similarity, F-Sim)、面部结构(Facial Structure, F-Str) 和 面部动态(Facial Dynamics, FD),并在 0 到 10 的范围内对每个方面进行评分。如下表 1 所示,评分结果表明 FantasyID 在所有评估维度上均优于基线方法,证明了其在人类评估中的优越感知质量。

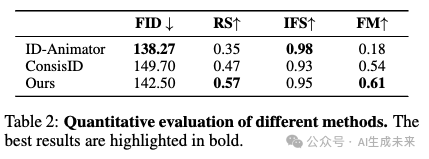

定量分析

下表 2 展示了各种面部视频生成方法的综合定量评估结果。ID-Animator 在 FID 分数和 IFS 分数上表现优异。然而,这种表现可以归因于其倾向于生成更静态的内容,从而确保了高质量和出色的身份一致性。这种对静态表示的关注可能限制了其生成多样化和动态面部运动的能力。相比之下,尽管本文的方法在 FID 分数上略高,但在捕捉动态表情方面表现出色,面部运动分数达到 0.61,同时取得了最高的 RS 分数 0.57,反映了卓越的身份保持能力。值得注意的是,本模型在所有指标上均优于 ConsisID,展现了在动态性和身份保持方面的卓越能力。

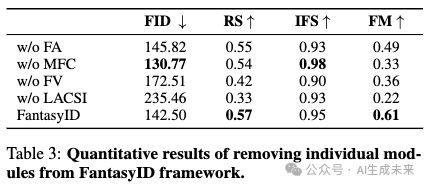

消融实验

这些实验系统地移除了各个组件,以评估它们对模型整体性能的影响,结果如下表 3 所示。本文研究了排除多视角面部集合(Multi-View Face Collection, MFC)、面部抽象器(Face Abstractor, FA)、面部顶点(Face Vertex, FV) 和 层次化控制信号注入(Layer-Aware Control Signal Injection, LACSI) 的影响。此外,修改了不同输入的面部顶点数据,以验证 3D 约束的有效性。

定性分析

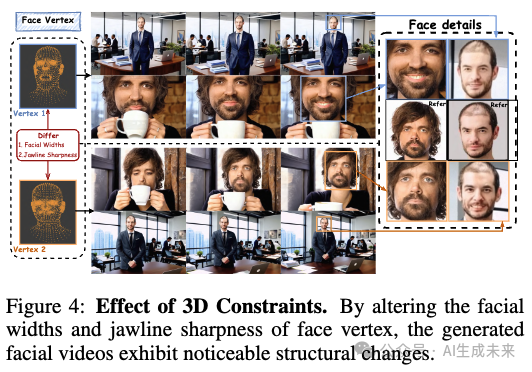

3D 约束的效果。为了验证 3D 约束控制机制的有效性,修改了 3D 面部顶点以生成具有不同面部宽度和下颌线锐度的视频。下图 4 展示的定性结果显示了面部结构的显著变化,从而证实了3D 约束在引导面部特征生成方面的有效性。这证明了本文的方法在控制面部特征方面的灵活性和精确性。

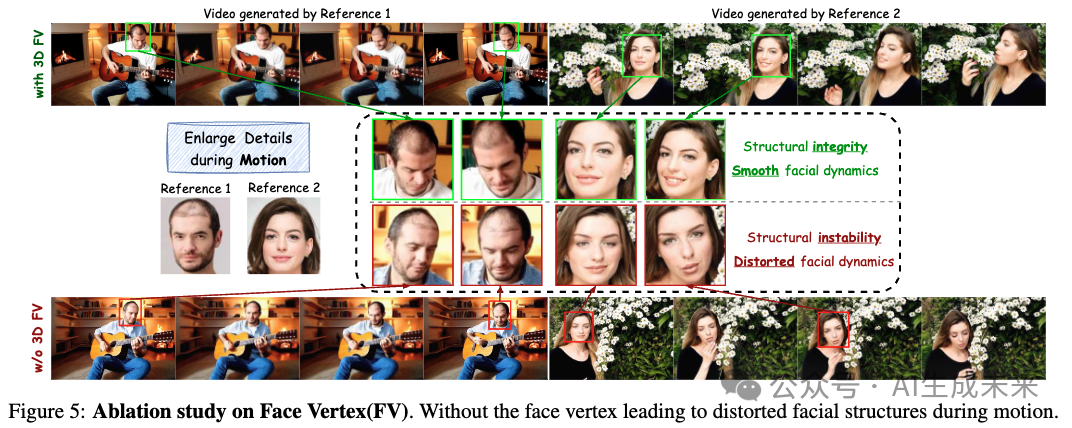

无面部顶点。我们通过排除框架中的面部顶点来评估 3D 约束的重要性。下图 5 的定性结果表明,缺少 3D 面部顶点数据会导致模型仅依赖 2D 特征提取,从而导致运动过程中面部结构的扭曲。前面表 2 的定量结果显示所有指标均有所下降,表明面部运动更加不稳定。这些结果表明,3D 顶点集成在保持结构完整性和确保平滑面部动态方面起着关键作用。

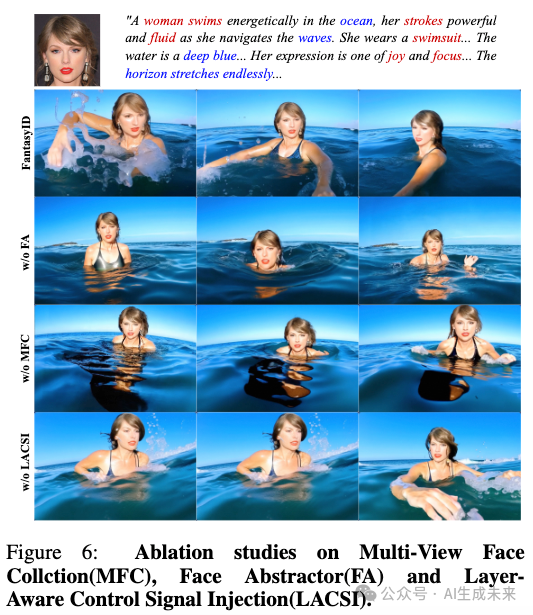

无多视角面部集合。我们在训练阶段用单一面部图像替换了多视角面部集合。如下图 6 所示,这种方法显著减少了捕捉到的面部运动范围,限制了模型理解和表示不同角度的能力。如前面表 3 所示,这种方法在 FID 和 IFS 分数上表现最佳。这种表现可以归因于模型倾向于通过优先考虑与参考图像的更高相似性来走捷径,从而以牺牲动态范围为代价保持一致性。

无面部抽象器将面部抽象器替换为 Q-Former,如上面图 6 所示,这导致了一些面部扭曲。这些扭曲可能是由于 Q-Former 倾向于破坏面部 CLIP 特征的空间特性。此外,上表 2 中的结果表明,这种方法在 FID、RS 和 IFS 分数上表现较低。这表明面部抽象器在捕捉全面且空间一致的面部信息方面更为有效。

无层次化控制信号注入通过移除层次化控制信号注入模块 ,观察到面部相似度显著下降,如上图 6 所示,同时所有指标分数也有所下降,详见前面表 3。这些结果表明视频质量和身份保持能力均有所下降。相比之下,层次化控制方法通过学习每一层最合适的特征控制信号,能够更有效地适应不同 DiT 块之间的独特特征分布。这种方法在生成身份特征时确保了最佳性能和保真度。

结论

FantasyID 提出了一种突破性的身份保持人物视频生成方法,克服了传统方法的局限性。通过采用多视角面部集合、面部抽象器、3D 约束和层次化控制信号注入,它显著提升了视频质量、身份保持能力和时间一致性。这种可扩展的无训练解决方案在复杂运动中保持了高保真表示。未来的工作将专注于优化多身份保持,并扩展 FantasyID 在动态视频制作和个性化内容创作中的作用。

本文转自 AI生成未来 ,作者:AI生成未来