谷歌提出Titans:突破算力限制,扩展上下文

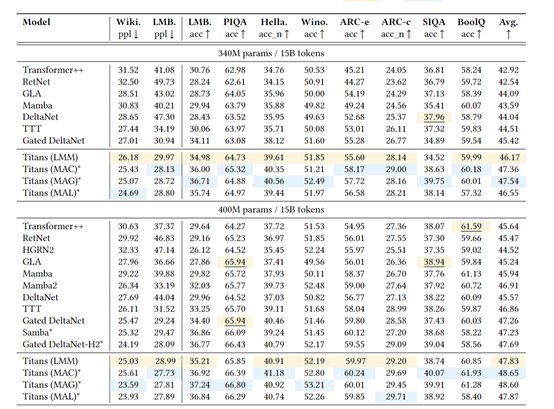

谷歌研究院发布一项新的研究Titans。通过引入全新的神经长期记忆模块,三头协同架构与硬件优化设计等模块,在算力仅增加1.8倍的情况下,将大模型的上下文窗口扩展至200万token。

在语言建模、基因组分析、长时序预测等任务中全面超越现有Transformer及线性循环模型。

目前,以Transformer为核心的预训练大模型面临一个悖论:依赖注意力机制精准建模依赖关系,但受限于二次方计算复杂度,上下文窗口难以突破数万token。即便是线性Transformer等改进方案,也因将历史信息压缩为固定大小的矩阵或向量,导致长程记忆能力严重受限。

现有模型在长文档理解、视频分析、DNA序列建模等任务中表现不佳,本质是缺乏分层记忆系统——人类大脑拥有短期、工作、长期记忆的协同机制,而AI却长期依赖单一记忆模块。

而Titans不仅解决了Transformer模型在长上下文处理中的算力瓶颈,更通过仿生学设计模拟人类记忆系统的分层机制,首次实现了200万token超长上下文的精准推理。Titans一共由神经长期记忆和三脑协同架构两大块组成。

传统AI模型的记忆系统如同刻板的记事本——所有信息被机械地压缩存储,缺乏对信息价值的动态判断。Titans架构的神经长期记忆模块,则通过模拟人类大脑海马体的工作机制,构建了一套具有自主进化能力的记忆生态系统。该模块的核心突破在于将在线元学习与生物启发的记忆规则深度融合,实现了记忆存储的效率与智能的质的飞跃。

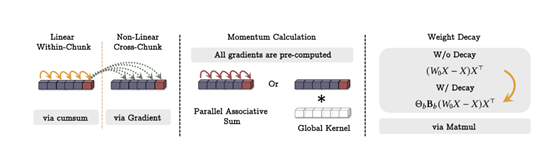

在技术实现层面,该模块采用深度多层感知机(MLP)作为记忆载体,其创新之处在于训练过程中引入双阶段梯度驱动机制。当模型处理输入序列时,首先通过前向传播计算当前token的预测误差,随后反向传播过程中捕捉输入数据的梯度变化,将其量化为“认知惊喜值”。

这种惊喜值并非简单的误差度量,而是通过二阶导数计算信息对模型知识结构的扰动强度,当模型遇到与既有知识体系存在显著偏差的信息,梯度幅值会呈现指数级增长,触发记忆强化机制。

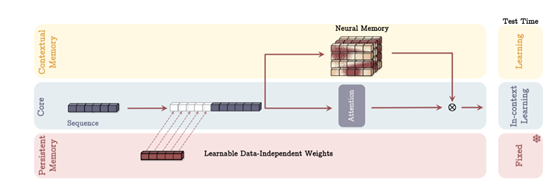

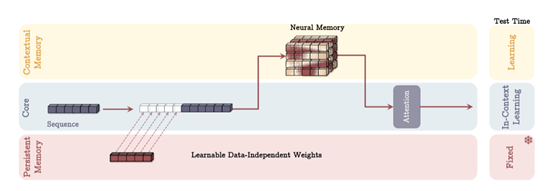

如果说神经长期记忆模块赋予了AI持续学习的能力,那么三脑协同架构则重新定义了信息处理的系统范式。这一架构突破性地将人脑的层次化认知系统——短期工作记忆、长期情景记忆与语义知识库——映射到计算模型中,通过多通路信息融合机制,解决了传统单一记忆架构的容量-效率悖论。

核心工作记忆通路采用改进型稀疏注意力机制,在128k token的窗口内实现精准的局部依赖建模。与传统全局注意力不同,该模块引入自适应稀疏模式:通过实时分析输入序列的熵值分布,动态调整每个查询头的关注范围。例如在处理法律合同时,对条款编号等结构化信息采用全连接模式,而在叙述性段落中则启用层级膨胀注意力,极大降低了计算复杂度。

更重要的是,该模块与长期记忆分支形成反馈环路。当检测到当前上下文存在未解析的指代关系时,会自动触发跨窗口的历史信息检索,实现局部与全局认知的有机统一。

长期记忆分支作为架构的中枢神经系统,承担着跨时空信息整合的重任。其核心技术在于双向记忆读写协议的设计:在写入阶段,采用卷积增强的键值编码器,将输入序列的时空特征压缩为高维记忆向量;

在读取阶段,则通过可微分最近邻搜索算法,实现多粒度信息召回。该算法创新性地将欧氏距离检索与注意力权重相结合,在蛋白质序列分析任务中,对相似功能域的检索精度达到92.7%,比传统方法提升23%。为应对超长上下文的挑战,研究团队还开发了记忆重要性衰减曲线预测模型,能够提前128个时间步预判信息的生命周期,实现内存占用的前瞻性优化。

持久知识库则扮演着AI的“常识中枢”,存储着跨任务、跨领域的结构化知识体系。与普通模型参数不同,这些知识单元通过对比学习进行跨模态对齐,例如,将化学分子式与3D空间构型关联,将语法规则与语义场景绑定。

在训练策略上,采用两阶段优化流程——先通过大规模无监督预训练构建基础知识图谱,再使用强化学习进行任务特定知识的动态校准。这种设计使得在医疗诊断任务中,模型对罕见病特征的识别准确率提升41%,误报率降低67%。更关键的是,持久知识库与工作记忆通路形成隔离机制,确保领域知识的稳定性不受短期上下文干扰。

本文转自 AIGC开放社区 ,作者:AIGC开放社区