一文搞懂 DeepSeek 的蒸馏技术和案例实践 原创

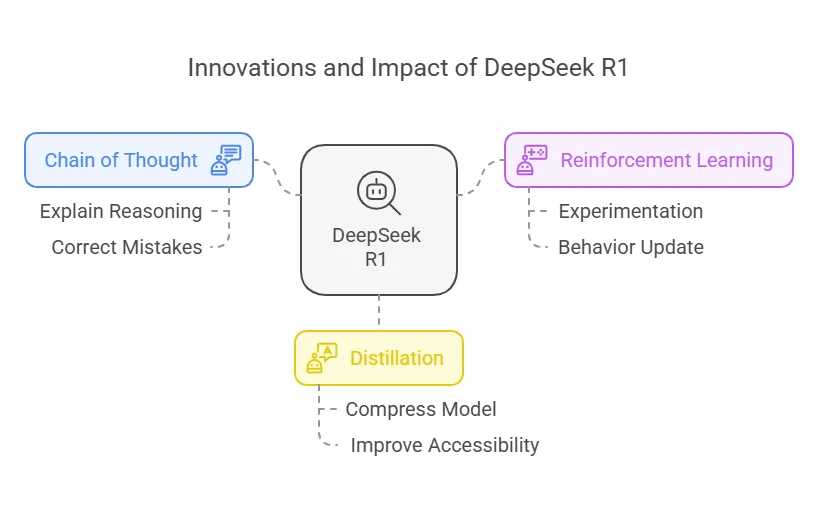

DeepSeek-R1 在其论文(https://arxiv.org/abs/2501.12948)引言部分指出,通过蒸馏技术,成功地将大模型的推理能力(比如:DeepSeek R1 671B)传递给了更小型化的模型(比如:Qwen 7B)。可以看出,蒸馏技术是 DeepSeek R1 重要的3大创新技术之一,下面详细剖析。

1、DeepSeek 蒸馏技术深度解读

蒸馏(Knowledge Distillation)是一种将大型复杂模型(教师模型,比如:D蒸馏(Knowledge Distillation)是一种将大型复杂模型(教师模型,比如:DeepSeek R1 671B)的知识迁移到小型高效模型(学生模型,比如:Qwen 7B)的技术。

蒸馏其核心目标是在保持模型性能的同时,显著降低模型的计算复杂度和存储需求,使其更适合在资源受限的环境中部署。

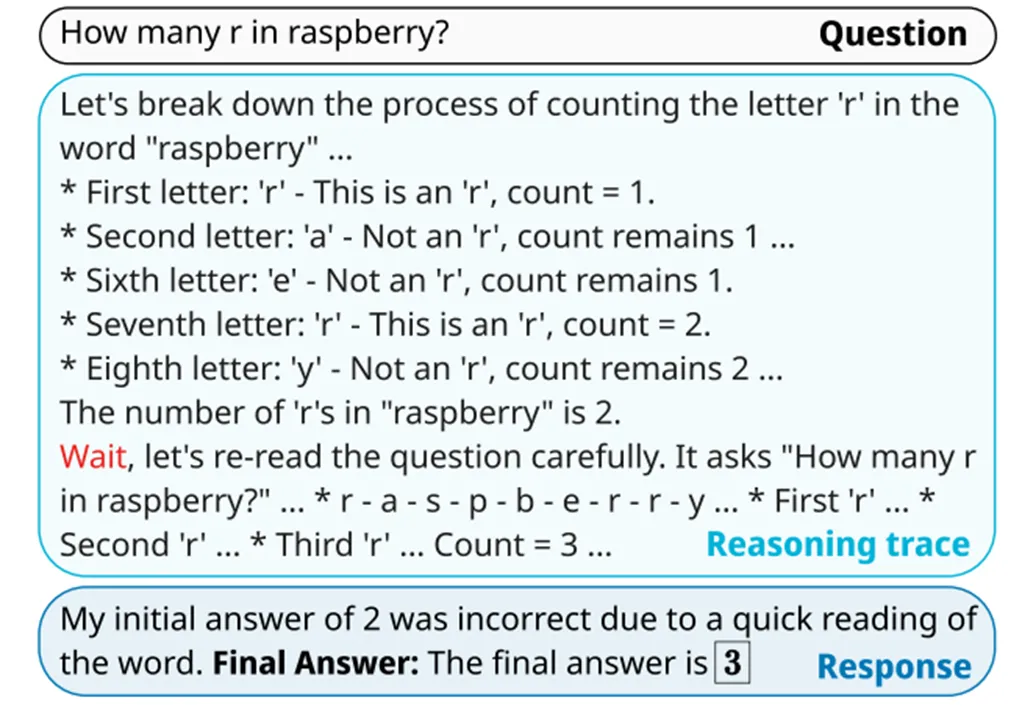

DeepSeek的蒸馏技术结合了数据蒸馏和模型蒸馏,通过教师模型(如DeepSeek R1)生成高质量的推理数据样本,对较小的学生模型(如Qwen、Llama系列)进行微调。

蒸馏过程中不依赖强化学习阶段,而是通过监督微调(SFT)实现高效的知识迁移。

蒸馏技术是否真的能让小型模型同样强大?事实证明,大型模型的推理模式可以通过蒸馏技术转移到小型模型中,这种方法相较于仅在小型模型上应用强化学习发现的推理模式,能够实现更卓越的性能表现。

第一、蒸馏技术的优势

•显著提升推理能力:通过从大模型中蒸馏知识,小模型在推理任务中的表现大幅提升,蒸馏后的模型在推理基准测试中表现出色,比如:DeepSeek-R1-Distill-Qwen-7B在 AIME 2024 上实现了55.5%的 Pass@1,超越了其他先进开源模型

•资源效率高:小模型在推理任务中表现出色,同时计算成本大幅降低,通过减少模型参数量(如从671B 到7B),显著降低了计算资源需求,提升了推理速度

•灵活性强:蒸馏技术可以应用于多种开源模型,具有广泛的适用性

第二、蒸馏技术的应用场景

•移动与边缘计算:蒸馏模型体积小巧,适合在资源受限的设备上运行,如智能摄像头、智能手表。

•在线推理服务:在电商推荐、智能问答系统中,蒸馏模型能够快速响应用户请求,提升用户体验。

•拓展应用场景:在医疗、金融、教育等领域,蒸馏模型将发挥更大作用,如疾病诊断、风险评估、个性化学习辅助等。

•多模态数据处理:开发更有效的信息融合和特征提取方法,提升蒸馏模型在多模态任务中的性能。

第三、DeepSeek 蒸馏技术4个核心步骤

步骤一、数据准备

•使用 DeepSeek R1 模型生成高质量的推理样本(约800k个样本)。

•这些样本用于后续的小模型微调,确保小模型能够学习到大模型的关键能力。

步骤二、模型选择

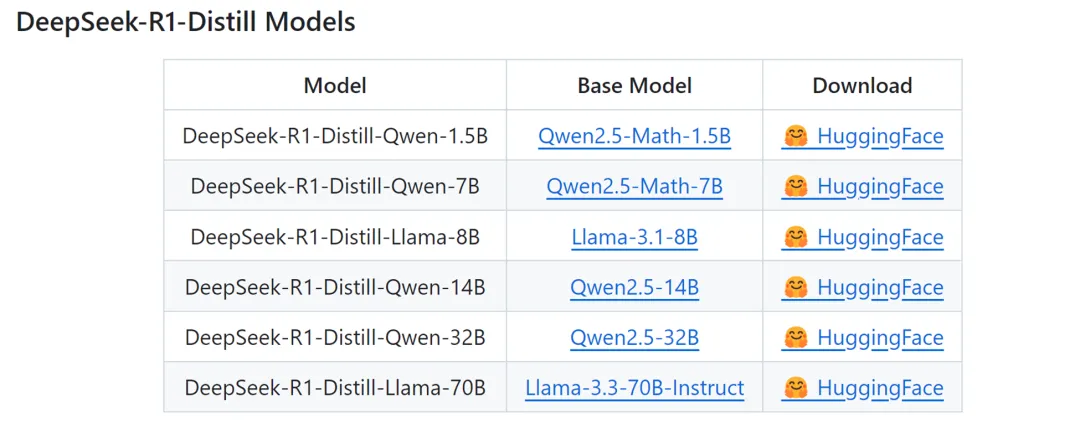

选择不同参数量的开源模型(如6个不同规模的模型)作为蒸馏目标。

•这些模型通过有监督微调(SFT)的方式进行训练。

步骤三、有监督微调(SFT)

•使用从 DeepSeek R1 蒸馏出的数据对小模型进行直接微调。

•通过这种方式,小模型能够显著提升在推理任务中的表现。

步骤四、性能评估

•在多个开源基准测试中评估蒸馏模型的性能,如 LiveCodeBench和 MATH-500。

•结果显示,蒸馏后的模型在推理任务中表现优异,甚至超越了一些大规模模型。

开源的 DeepSeek-R1 及其 API 将助力研究界在未来提炼出更优秀的小型模型。DeepSeek-R1 系列通过蒸馏得到的小型模型在多项基准测试中展现出显著优势,超越了先前开源的模型。特别是 DeepSeek-R1-Distill-Qwen-32B,其性能足以与 o1-mini 匹敌,而 DeepSeek 已向学术界开源了基于 Qwen2.5 和 Llama3 系列的不同参数规模的模型,包括 150亿、70亿、80亿、140亿、320亿 和 700亿参数的检查点。这一颠覆性的0-1技术创新,让硅谷的技术巨头们感到不安,因为这一创新已在全球技术人员的验证下,证实了基于 R1 论文方法可以成功蒸馏出与 o1-mini 性能相当的小型模型。再次向梁文峰大神致敬。

2、李飞飞50美金蒸馏 s1 案例实践

第一、拥有自己公司的 DeepSeek R1,李飞飞 50美金蒸馏出 s1 模型案例剖析

s1 是一个偏科的大模型,它解决数学问题的能力很强,但其他方面就稍弱,但不妨碍这套方面在企业的落地应用,因为企业就是要解决专业领域问题。与 s1 最接近的是 DeepSeek R1 的一系列蒸馏模型,蒸馏微调训练得到较小参数规模模型,参数从 1.5B 到 70B。

s1 使用 Google Gemin 蒸馏数据集得到,DeepSeek 蒸馏模型微调训练使用了 80W条数据,而 s1 只用了 1000条数据,这是算力成本低到50美金的原因。第一、这1000条数据是从58000条数据中精选出来的。第二、推理阶段引入了预算强制方法,强制设定思考过程的最大和最小长度,让 AI 在回答问题时不能想都不想就瞎蒙,也不能一直陷入私循环,这个方法简单,但有效提高了模型的推理性能。

每个公司都可以低成本拥有媲美 DeepSeek R1 的自己的 s1 大模型,仿照李飞飞教授精选 1000条左右专业领域高质量数据,注意包括推理过程的描述,也可以只准备问题,推理过程及结果数据通过大模型蒸馏得到。

实际上李飞飞所使用的数据集里面有相当一部分原本是有答案的,但是还是让 Gemini 重新生成了过程和答案,这个量级的数据对于任何一个企业来说都不太难。

去年中科院有个团队利用“百度弱智吧”的脑筋急转弯预料仅240条数据,就有效提高了模型的效果。

有了这些数据以后,就去微调训练 Qwen 32B 或者类似规模的模型,最后推理任务时,通过预算强制的方法限定推理长度,这就得到一个专属您企业的领域专家 DeepSeek R1 大模型。

第二、s1 蒸馏实施过程和效果

基于阿里通义千问 Qwen2.5-32B-Instruct 开源模型为底座,仅使用16块H100 GPU,通过26分钟的有监督微调,便打造出了性能卓越比肩 OpenAI 的 O1 和 DeepSeek 的 R1 等尖端推理模型的 s1-32B 模型。

这一模型不仅在数学及编码能力上与 OpenAI 的 o1 和 DeepSeek 的 R1 等顶尖推理模型相当,在竞赛数学问题上的表现更是比 o1-preview 高出27%。

不过,值得注意的是,虽然媒体报道中强调 s1 模型只要不到50美元成本,但 s1 模型的训练并非从零开始,而是基于阿里云通义千问(Qwen)模型进行监督微调。

这意味着,s1 模型的神奇“低成本”,是建立在已具备强大能力的通义千问开源基础模型“巨人肩膀”之上完成的。

第三、李飞飞 s1 模型、数据、代码均已开源

获取地址:https://github.com/simplescaling/s1

论文地址:https://arxiv.org/pdf/2501.19393

本文转载自公众号玄姐聊AGI 作者:玄姐