DeepSeek开源周“第一刀”砍向算力!重磅开源FlashMLA,挑战H800算力极限,网友直呼:极致的工程设计! 原创

编辑 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

上周五,DeepSeek刚刚预告了重磅开源周!

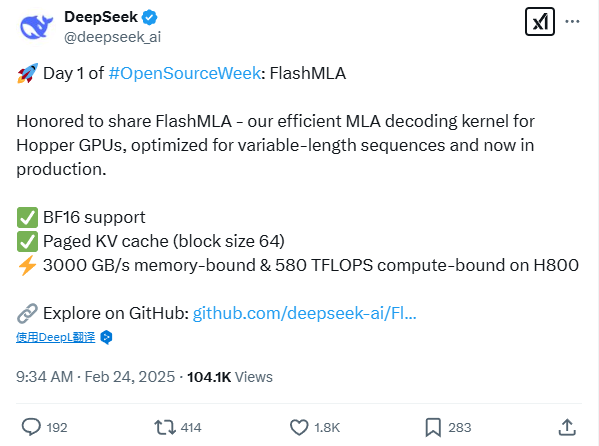

周一一早,DeepSeek就履行承诺,开源了针对 Hopper GPU 的高效 MLA 解码内核——FlashMLA!

图片

图片

根据DeepSeek介绍,FlashMLA内核针对变长序列进行了优化,是已投入生产的核心技术。

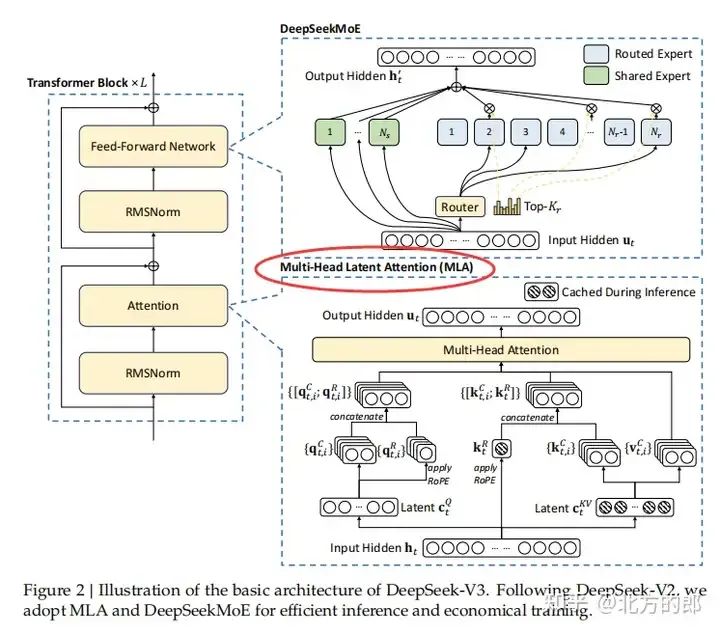

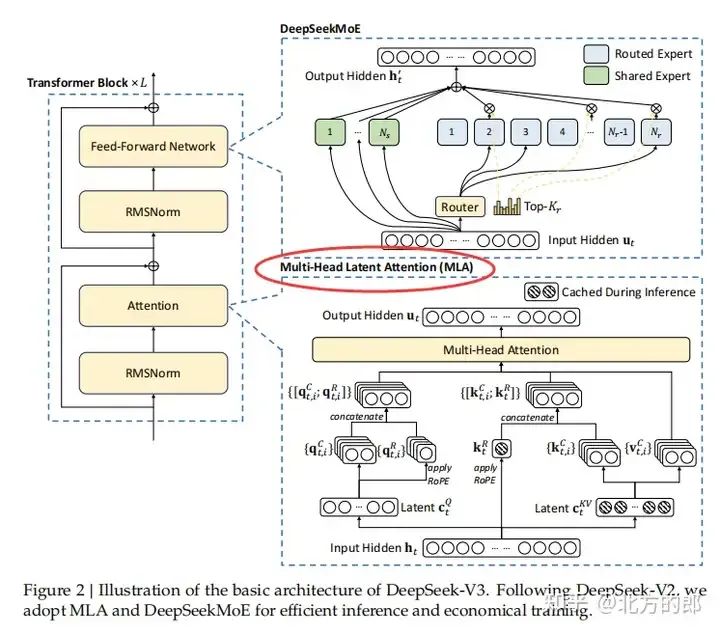

从DeepSeek-V2开始,MLA出现在的所有的DeepSeek大模型里面,是DeepSeek大模型提升效果的非常重要的机制。

MLA(Matrix-Less Attention)多头潜在注意力,通过数学变换避免了直接计算大规模矩阵,从而降低计算复杂度。MLA 的设计使其能够更好地利用现代 GPU 的并行计算能力,从而加速推理过程。

图片

图片

图片

图片

简单来说,FlashMLA 的优化让 AI 处理不固定长度的文本更高效,比如聊天对话或文章生成场景。通过优化,GPU 能更聪明地管理记忆(缓存),让它在处理长短不同的句子时,不会浪费太多计算资源。

评论区的网友纷纷给出好评!

一位网友调侃说,提高显卡效率,但是拜托别烧坏我的英伟达股票!

图片

图片

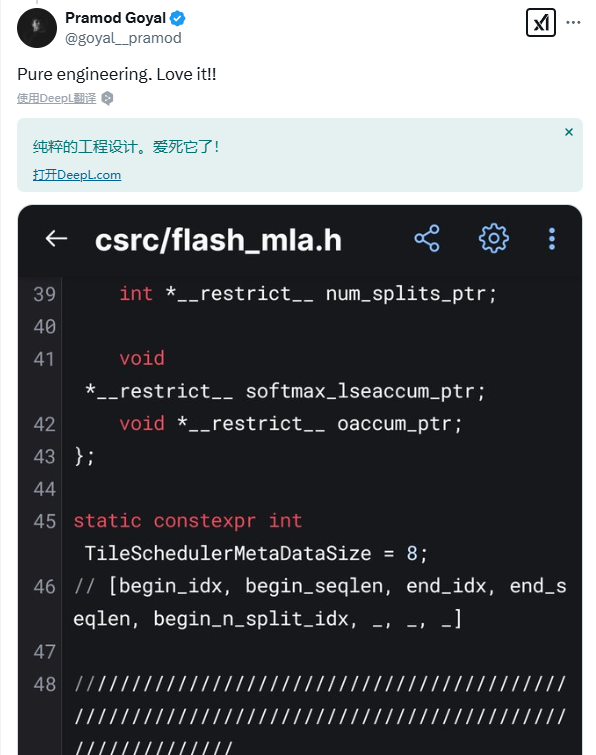

另一位运行项目的网友更是大加赞美:纯粹的工程设计,爱死它了!

图片

图片

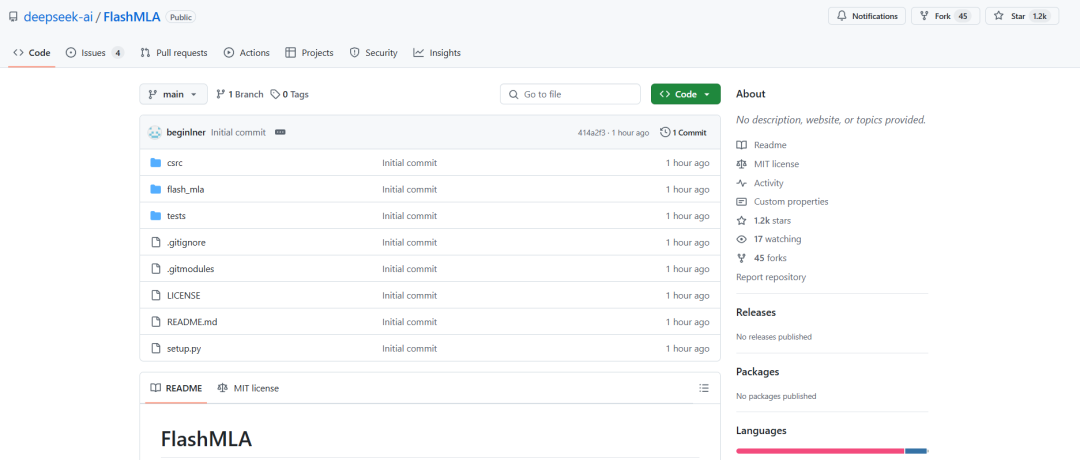

开源地址:https://github.com/deepseek-ai/FlashMLA

图片

图片

该项目目前已经斩获了1.2k的Star量,DeepSeek开源周的火爆程度可见一斑!

接下来,我们看看FlashMLA开源项目的内容。

1.FlashMLA核心内容解读: 中高端消费级 GPU 能运行更大模型了!

DeepSeek给出了FlashMLA的三个关键词,我们来一一解读下:

- 支持 BF16:在 Transformer 推理过程中,BF16 计算可以加速矩阵运算,同时保证数值稳定性,与 FP32 相比,带来了显著的计算效率提升。

- 分页式 KV 高速缓存(块大小为 64):采用分页式管理,意味着 FlashMLA 允许更灵活的 KV 缓存复用,减少 GPU 内存压力,优化长序列的推理性能。

- 在 H800 上实现 3000 GB/s 内存绑定和 580 TFLOPS 计算绑定:说明FlashMLA 能够最大化利用 H800 的内存带宽和计算能力,实现近乎极限(甚至突破)的吞吐量。。

FlashMLA作为针对 Hopper GPU 的 LLM 推理加速方案,其核心价值体现在这几点:

- 优化变长序列推理,适用于对话型 AI 和多轮交互。

- 提高计算效率(580 TFLOPS)和 内存带宽利用率(3000 GB/s),减少推理延迟。

- 降低显存占用,提高 LLM 生产环境的吞吐量,优化 GPU 资源利用。

网友@Hemang Dave在评论区兴奋地感叹:Apple 研究表明,类似方法可以运行比 GPU 可用 DRAM 大两倍的模型,同时显著提升推理速度(CPU 提升 4-5 倍,GPU 提升 20-25 倍)。这意味着 FlashMLA 能在 Hopper GPU 上运行更大规模的 AI 模型,而无需昂贵的硬件升级,大幅降低部署成本。

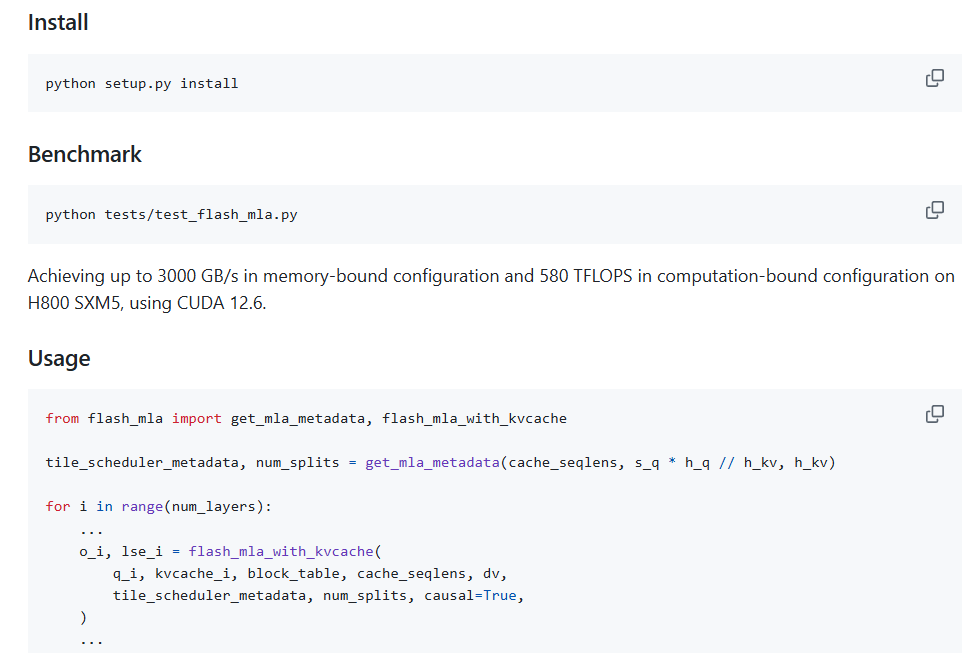

2.FlashMLA开源项目部署

项目的部署需要:

- Hopper 系列 GPU

- CUDA 12.3 及以上版本

- PyTorch 2.0 及以上版本

快速启动:

图片

图片

3.写在最后:DeepSeek R1成抱抱脸最受欢迎大模型

DeepSeek第一天的项目就如此重磅!

更让人对未来4天的发展更加惊喜,网友直接预测:我听说第五天将开源AGI!

图片

图片

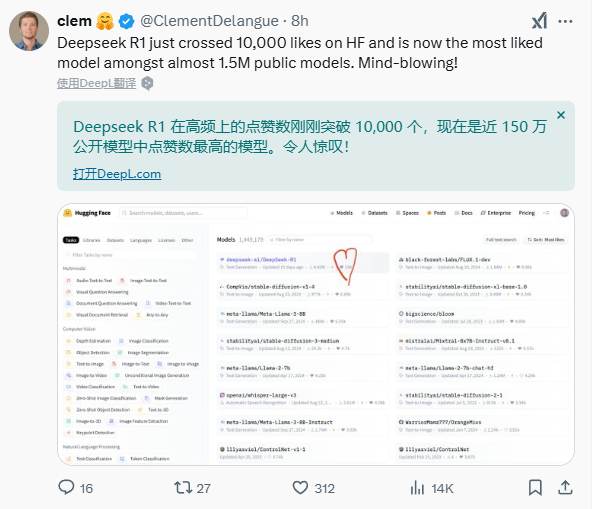

另外,DeepSeek R1在开源平台抱抱脸上的点赞已经超过一万,成为150个模型中最受欢迎的一个!

图片

图片

我们有理由相信,DeepSeek这只蓝鲸鱼,必定成为这波AI浪潮的弄潮儿!

本文转载自51CTO技术栈,作者:伊风