颠覆直觉:Top N 越大,RAG效果可能越差

一、RAG 系统的背景与挑战

在自然语言处理(NLP)领域,大型语言模型(LLMs)如 GPT、BERT 等已经展现出了强大的文本生成、问答和摘要能力。然而,这些模型也存在一些显著的局限性。

• 首先,LLMs 的知识是静态的,这意味着它们无法及时更新以反映新信息,导致生成的回答可能过时。

• 其次,LLMs 有时会生成听起来合理但事实上错误的回答,这种现象被称为“幻觉”。

• 最后,LLMs 在涉及高级专业领域的知识时,往往缺乏足够的深度。

为了应对这些挑战,检索增强生成(Retrieval-Augmented Generation, RAG)系统应运而生。RAG 系统通过引入检索组件,使 LLMs 能够动态地利用外部知识源,从而生成更准确、更及时的回答。

RAG 系统已经在多个行业中得到广泛应用,尤其是在企业内部文档查询等场景中。然而,尽管 RAG 系统的应用日益广泛,关于其最佳配置的研究却相对缺乏,特别是在上下文大小、基础 LLM 选择以及检索方法等方面。

二、试验结果

RAG 系统通常由两个主要组件构成:检索器(Retriever)和生成器(Reader):

• 检索器负责从外部知识库中检索相关的上下文片段,这些片段随后被传递给生成器

• 生成器基于这些上下文生成最终的回答。

作者重点探讨了这三个方面(检索器、上下文、生成器)对系统整体性能的影响。

首先研究了上下文大小对生成器问答能力的影响。结果表明:随着上下文片段数量的增加,系统的性能逐步提升,但当片段数量达到 10 到 15 个时,性能开始趋于稳定,甚至在某些情况下会出现下降。这一现象表明,过多的上下文片段可能会导致信息过载,反而影响生成器的表现。

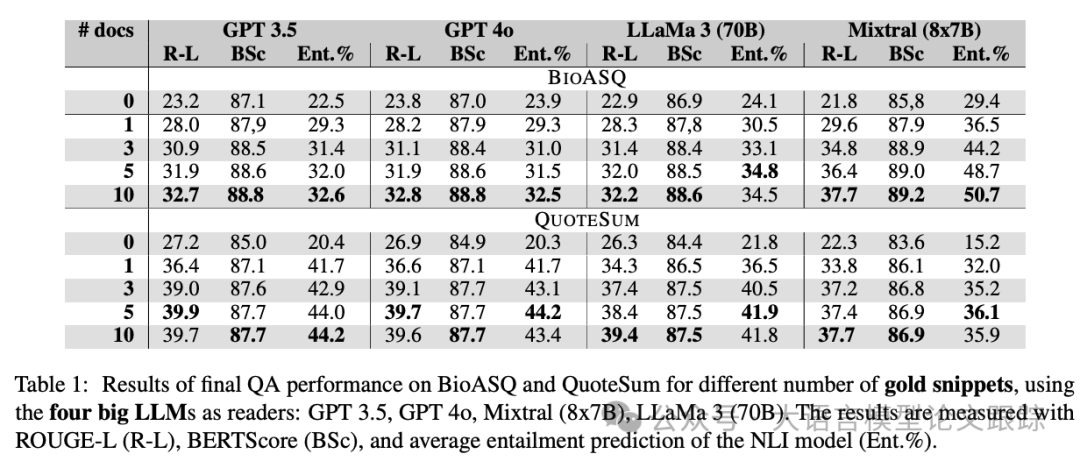

2.1 黄金片段测试

图片

图片

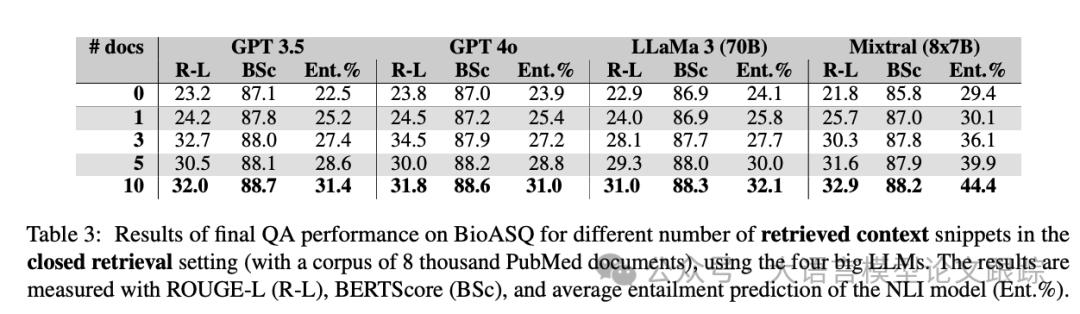

上图展示了四个较大尺寸的大语言模型(LLMs)在使用黄金片段后的表现,四个模型分别是GPT3.5、GPT-4o、Llama 3 70B、Mixtral (8x7B)。

所有模型都呈现出相似的模式:

• 从较低的零样本性能开始,仅使用一个上下文片段就能显著提升性能。

• 大多数模型在所有三个评估指标上逐步且稳定地改进。

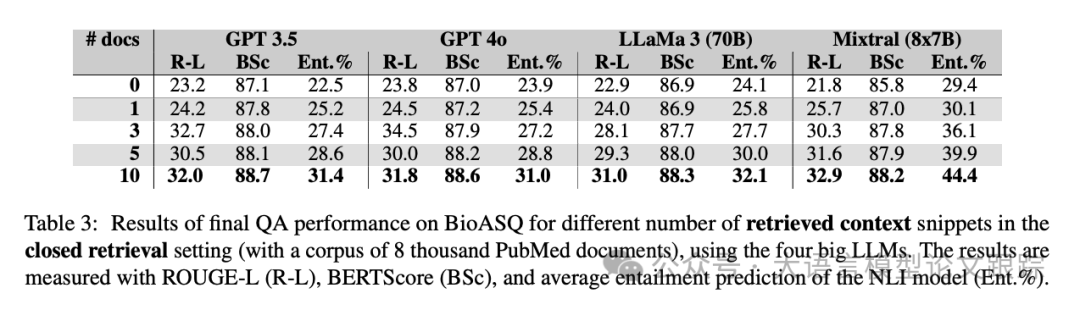

2.2 封闭式测试

使用了包含八千篇PubMed文章的小型知识库,这些文章在BioASQ中被用作黄金证据。

图片

图片

实验结果如上表所示,模型性能与之前有所下降。即使是表现最佳的Mixtral模型,其性能也平均下降。

尽管如此,随着选择的top k片段数量的增加,性能仍然逐步提升,表明更多的上下文信息能够带来更好的表现。

这一点在top-10设置中尤为明显,因为选择的证据片段越多,选中用于生成理想答案的黄金证据片段的概率就越高。

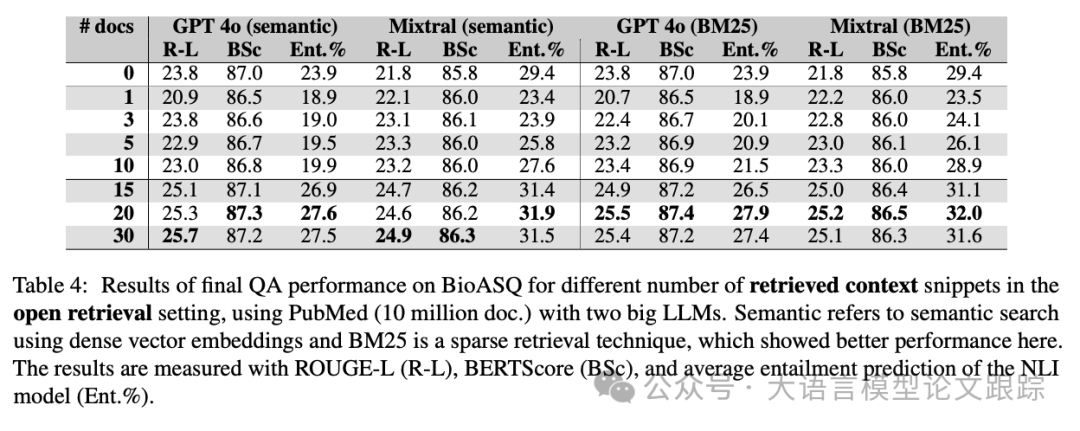

2.3 开放式测试

使用约1000万篇PubMed文章作为检索的知识库。其目的是观察:

(1)在开放式设置下,性能与使用黄金证据的封闭式设置相比有多大差异;

(2)不同检索器对性能的影响。

图片

图片

图片

图片

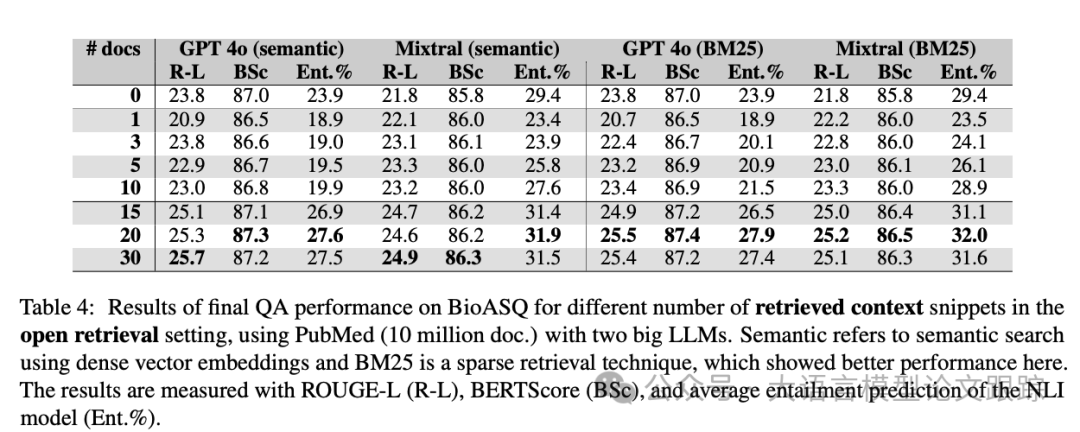

上表结果显示:

• 开放式检索显然是最具挑战性的设置,整体平均得分最低。

• 使用BM25检索文档的最终性能略优于语义搜索。

3. 结论

3.1 检索技术

图片

图片

从上表可以看出,BM25在整体性能上表现更优。由于BM25基于关键词匹配,这种检索技术优化了搜索结果的精确度(precision)而非召回率(recall),从而确保检索到的文档更有可能讨论问题中提到的相同概念(关键词)。

优化精确度并将查询关键词与知识库中的内容匹配,可以提升性能。特别是在生物医学领域等关键应用中,优化精确度和生成稳健的答案可能比语义搜索提供的召回率更为重要。

注:

• ROUGE-L 是一种基于最长公共子序列(LCS)的评估指标,主要用于衡量生成文本与参考文本之间的相似性。它关注生成文本中与参考文本匹配的最长连续子序列,侧重于召回率(Recall),即生成文本中有多少内容与参考文本一致。

• BERTScore 是一种基于预训练语言模型(如 BERT)的评估指标,通过计算生成文本与参考文本在语义空间中的相似性来评估质量。它使用 BERT 模型将文本编码为向量,然后计算生成文本与参考文本之间的余弦相似度。相比 ROUGE 等基于词汇重叠的指标,BERTScore 更能捕捉语义层面的相似性,适合评估生成文本的语义准确性。

• Ent.% 是基于自然语言推理(Natural Language Inference, NLI)模型的评估指标,用于衡量生成文本与参考文本之间的逻辑一致性(蕴含关系)。NLI 模型会判断生成文本是否逻辑上蕴含(Entailment)参考文本的内容。

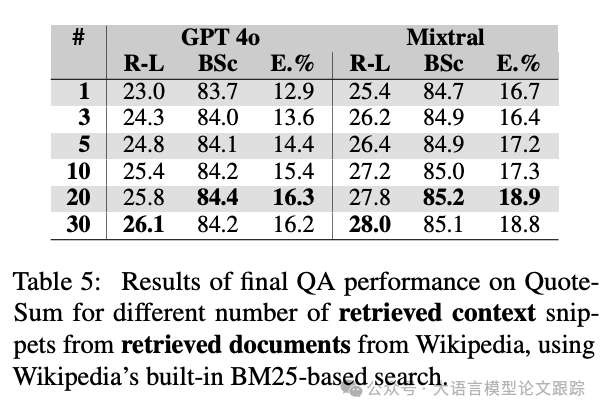

3.2 内部知识与外部知识的冲突

图片

图片

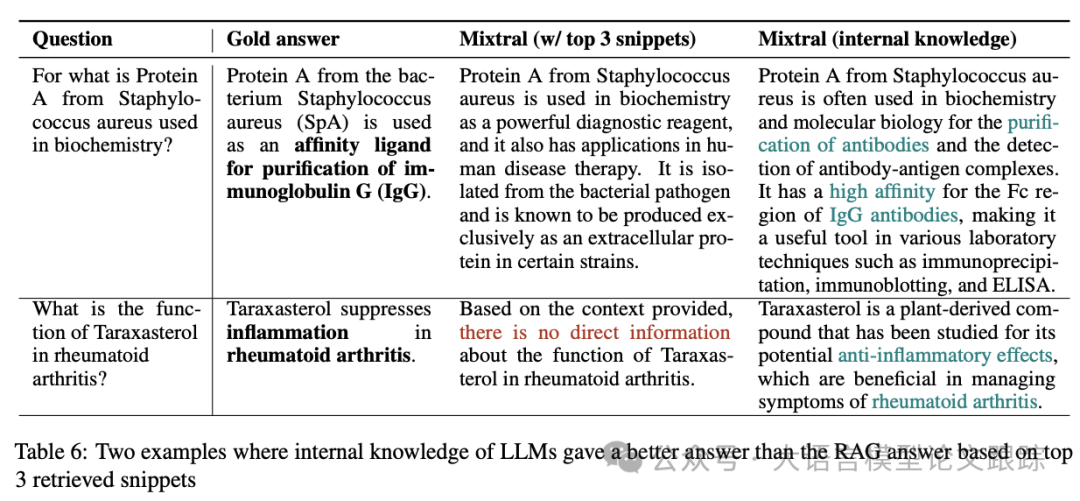

上表中开放式检索的一个有趣现象:GPT和Mixtral在零样本答案(无上下文片段)中的得分高于提供多达10个上下文片段的答案。

这种现象的一个可能解释是:尽管在语料库中发现的片段可能与问题在语义上相似,但它们并不总是提供所有重要信息。

当仅使用普通提示时,LLM基于其“内部”知识生成答案:反映了LLM从大规模预训练语料库中积累的知识。

因此,LLM的内部知识答案可能比RAG设置中的答案更具信息量,因为在RAG设置中,LLM被指示仅使用提供的短片段来回答问题。随着更多片段的加入,RAG答案的信息量开始超越LLM的内部知识。

图片

图片

以上表中的第一个示例为例,Mixtral基于内部知识生成的答案提到了纯化和IgG,与黄金答案一致,而基于top-3片段生成的答案则是不完整的。

一般来说,瓶颈通常与错误的检索有关——有时检索到的片段根本没有回答问题,尤其是对于BioASQ中复杂的生物医学术语。

另一方面,普通设置下的LLM总是基于其最佳知识提供答案,因此在检索不佳的情况下表现更好。在上表的第二个示例中显而易见。

展示了LLM内部知识与传递给它们的上下文知识之间冲突的已知挑战,也是一个有趣的未来研究方向。

3.3 上下文饱和

图片

图片

上表中的另一个发现是,性能提升存在一定的上限。

随着不断增加上下文片段的数量,增加到20个时,性能趋于停滞,而在检索到30个上下文片段时,性能略有下降。

当达到饱和点后,向提示中添加更多上下文只会导致回答中的噪音和混淆。

证实了文献中的先前发现,即在长提示中,上下文可能会“迷失在中间”,并在LLM回答问题时被忽略。

注:本论文代码和数据已开源:https://github.com/jvladika/ContextRAG

本文转载自大语言模型论文跟踪,作者:HuggingAGI