重磅!4000+实验揭秘:如何在512个GPU上训练大语言模型?

图片

图片

想知道ChatGPT这样的大语言模型是如何炼成的吗?今天带你揭开大模型训练的神秘面纱,看看在数百个GPU上协同训练大语言模型的技术秘密。

为什么这很重要?

曾几何时,训练大语言模型是少数顶级研究实验室的专利。虽然现在我们可以下载Llama或DeepSeek这样的开源模型,但最具挑战性的部分——训练代码、知识和技术仍然隐藏在复杂性之后。这些关键知识分散在众多论文和私有代码库中,让大多数开发者和研究者望而却步。

图片

图片

图片

图片

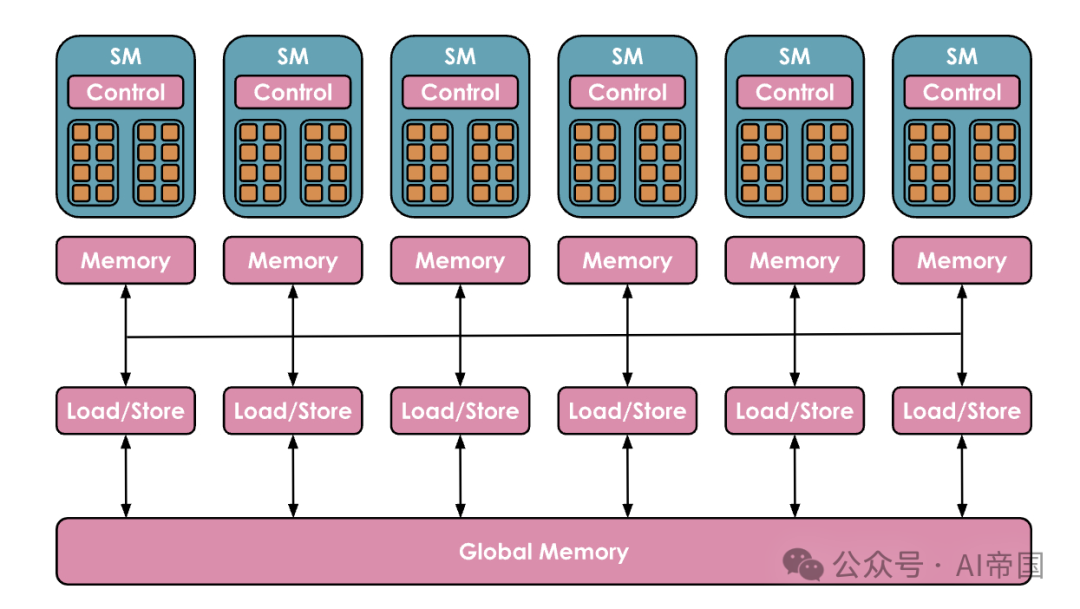

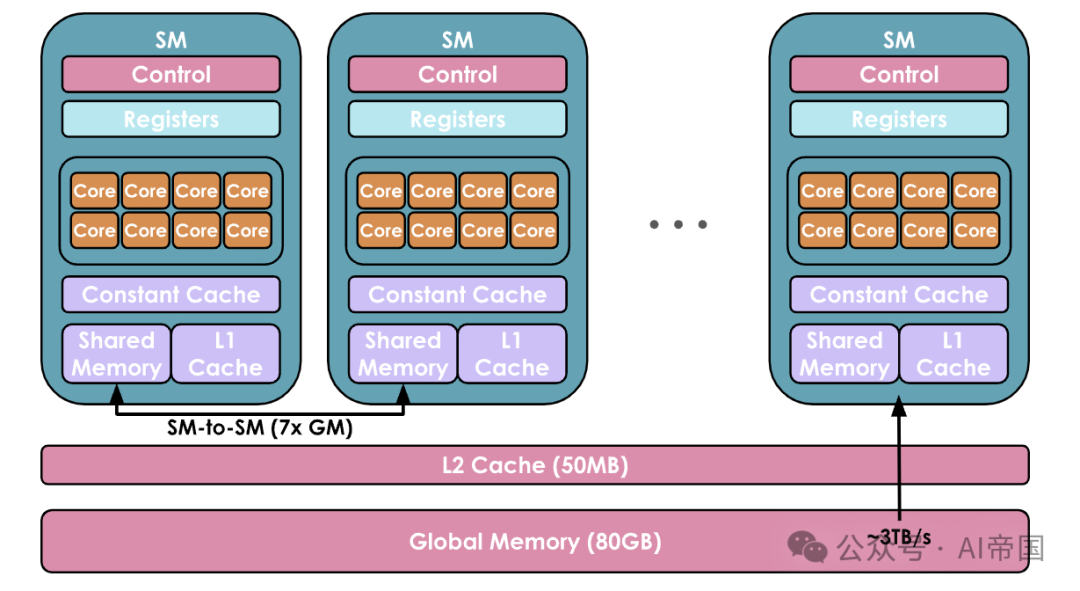

深入解析:GPU集群上的"交响乐"

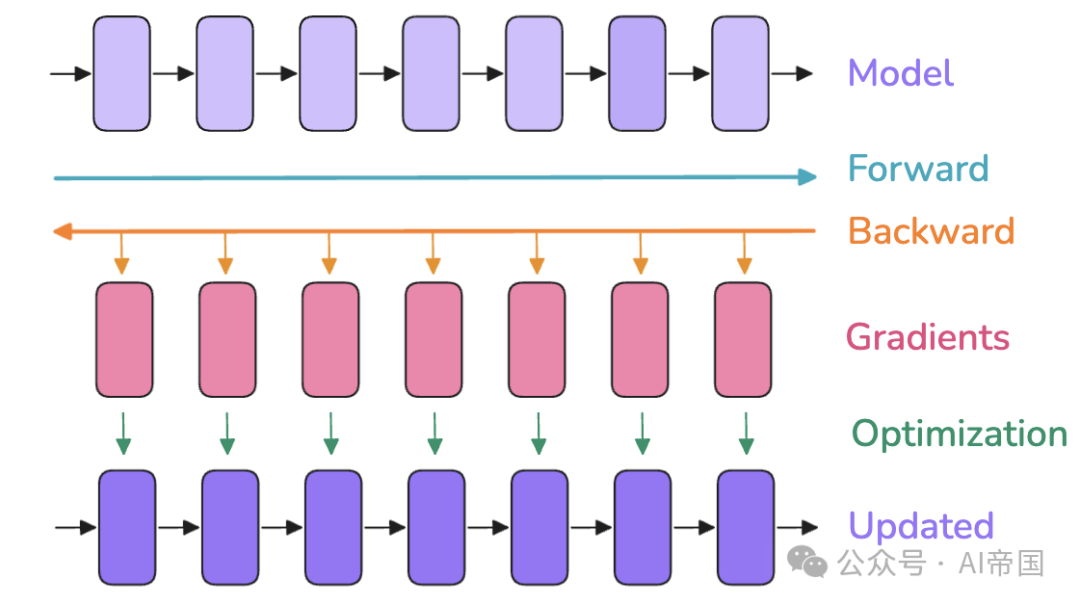

当一个模型在单个 GPU 上训练时,训练通常包括三个步骤:

- 前向传播,将输入通过模型传递以产生输出

- 反向传播来计算梯度

- 使用梯度更新参数的优化步骤

它看起来大致是这样的:

图片

图片

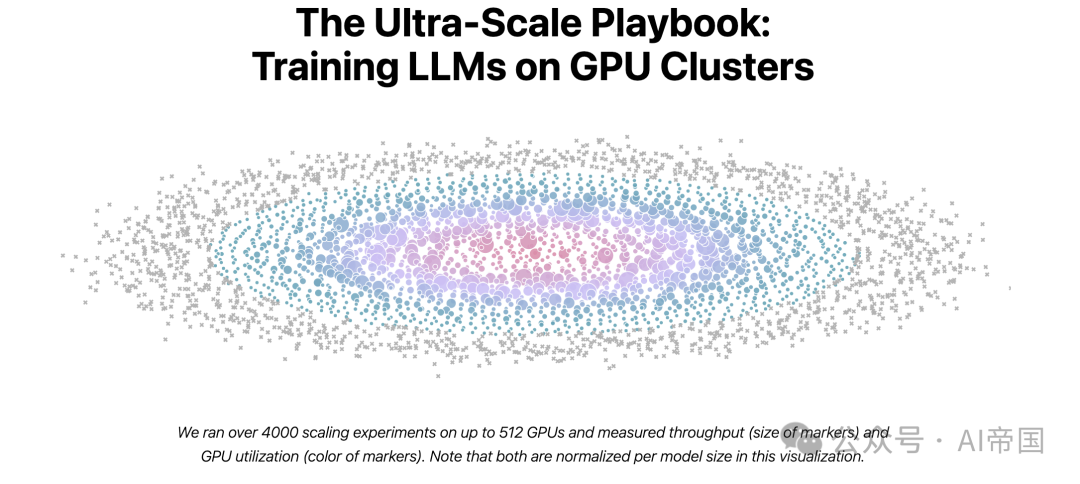

研究团队进行了超过4000次扩展性实验,使用高达512个GPU进行测试。他们发现,训练大语言模型面临三大核心挑战:

- 内存使用:这是硬性限制,如果训练步骤超出内存,就无法继续

- 计算效率:需要确保硬件大部分时间都在进行计算,而不是数据传输

- 通信开销:必须最小化GPU之间的通信开销,因为这会导致GPU空闲

为了应对这些挑战,研究人员采用了多种并行技术:

- 数据并行

- 张量并行

- 流水线并行

- 上下文并行以及ZeRO和内核融合等优化方法

关键发现与实践指导

图片

图片

研究揭示了一些重要的训练规律:

1.批量大小的演进:

- DeepSeek-V3/R1的训练中,批量大小从3072个输入序列逐步增加到15360

- 现代LLM训练通常使用400万到6000万tokens的批量大小

- Llama 1用约400万tokens批量大小训练了1.4万亿tokens,而DeepSeek用约6000万tokens批量大小训练了14万亿tokens

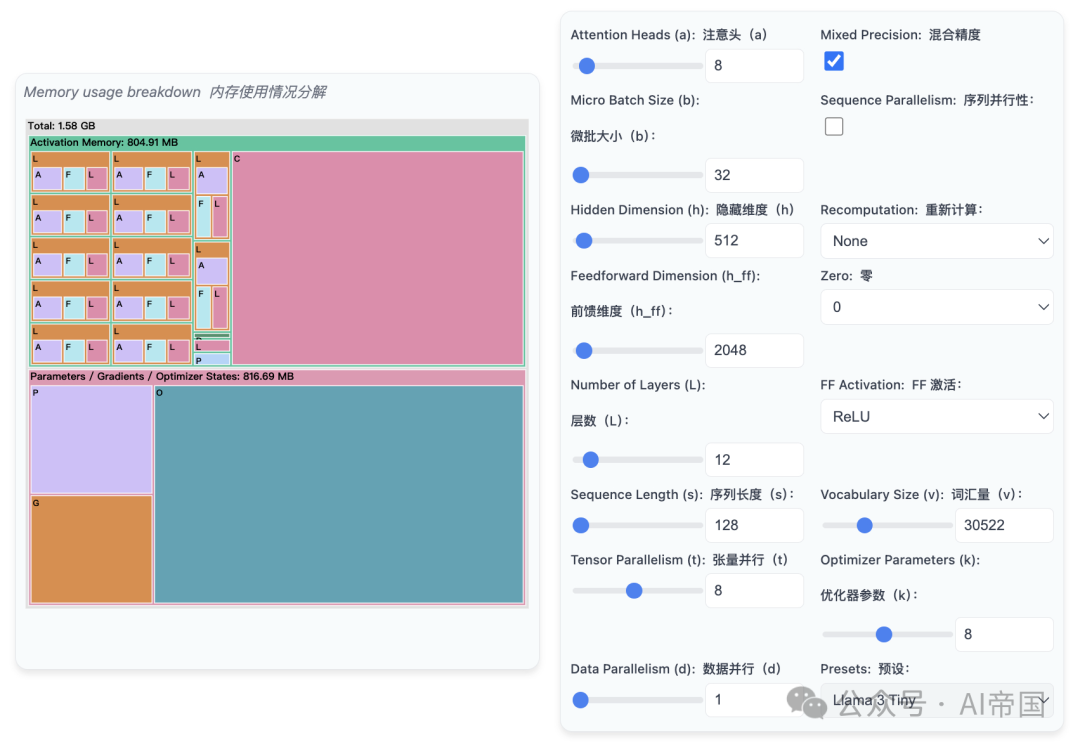

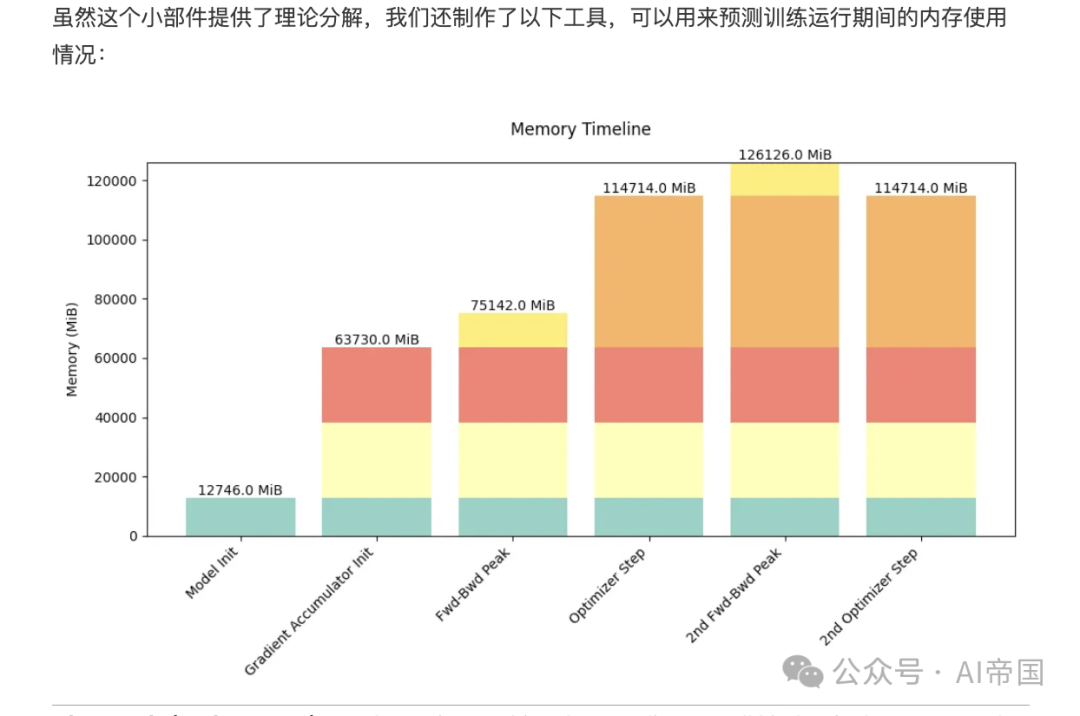

2.内存管理的精妙之处:

- 模型权重

- 模型梯度

- 优化器状态

- 计算梯度所需的激活值

这些都需要在有限的GPU内存中精心安排

3.混合精度训练:

- 使用BF16进行大部分计算(每个参数2字节)

- 同时保持FP32的模型权重和梯度副本(每个参数4字节)

- 优化器状态通常以FP32存储以保持数值稳定性

图片

图片

实践启示

如果你也在考虑训练或微调大语言模型,这项研究给出了重要的指导:

- 合理规划资源:

- 根据模型规模和可用GPU数量选择合适的并行策略

- 注意通信和计算的平衡

- 优化训练流程:

- 在可能的情况下重叠通信和计算

- 针对特定硬件布局编写定制内核

- 关注实际应用:

- 分布式训练技术不仅适用于预训练,也适用于推理和微调

- 随着AI建设者社区和模型规模的快速增长,掌握这些技术变得越来越重要

这些发现不仅帮助我们理解大模型训练的技术细节,更为未来的AI发展提供了重要指导。无论你是AI研究者、开发者还是对大模型感兴趣的普通读者,这些知识都将帮助你更好地理解和参与AI技术的发展。

如果你也对大模型训练感兴趣,不妨点赞关注,我们一起探讨更多AI技术的前沿进展!

文章标题:The Ultra-Scale Playbook: Training LLMs on GPU Clusters

文章链接:https://huggingface.co/spaces/nanotron/ultrascale-playbook

本文转载自 AI帝国,作者: 无影寺

赞

收藏

回复

回复

相关推荐