o1模型医学推理惊人,超过人类医生

在医疗领域,大模型的应用和影响力正在不断扩大。但当前对于大模型在医疗任务中的评估主要依赖于选择题基准测试,这种方式存在很多局限性,例如,高度受限、无法真实反映临床决策复杂性以及模型可能通过语义结构答题等问题。

为了更全面真实地评估大模型在医学推理任务中的实际能力,哈佛医学院、马里兰大学医学院、剑桥健康联盟、斯坦福大学等通过OpenAI的o1-preview模型,设计了一系列严谨的实验,包括鉴别诊断生成、推理展示、概率推理和管理推理等多个关键测试,并由经验丰富的专家医师用经过严格验证的测量方法,对模型输出的质量进行全面且细致的评估

结果显示,o1-preview在差异诊断生成、展示推理和管理推理等方面展现了超越人类水平的表现,尤其是在需要批判性思维的任务如诊断和管理上表现非常出色。

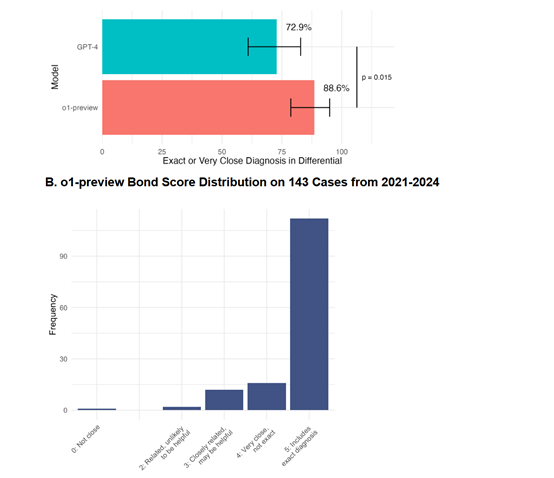

在数据收集方面,研究团队采用了多种评分系统和统计方法来评估o1-preview的表现。例如,对于鉴别诊断的质量,两位主治内科医师独立使用Bond Score进行评分,该评分系统的范围是0到5,其中5分代表包含确切目标诊断的鉴别诊断列表,0分代表与目标诊断无关的鉴别诊断列表。

对于测试计划的质量,评分使用了从0到2的Likert量表,通过将建议的测试计划与案例中实际进行的诊断进行比较。此外,研究团队还使用了线性加权Cohen's kappa来评估评分者之间的一致性,并通过讨论解决不一致的评分。

在统计分析方面,研究团队使用了R语言进行数据分析。他们比较了o1-preview与历史上的GPT-4、主治医师和住院医师的表现,并使用了McNemar's test、t-test和混合效应模型等统计方法来评估模型之间的差异。

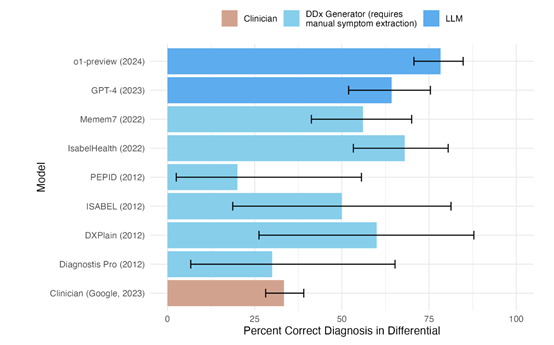

研究人员首先评估的是NEJM CPCs案例,是鉴别诊断生成器的传统标准。o1-preview在这些案例中的表现令人印象深刻。

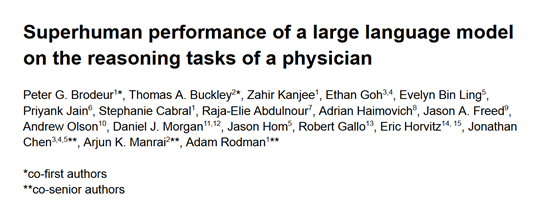

在143个案例中,o1-preview在78.3%的情况下将正确诊断包含在其鉴别诊断中,而在70个与GPT-4相同的案例中,o1-preview在88.6%的情况下提供了确切或非常接近的诊断,相较于GPT-4的72.9%有显著提升。

在评估o1-preview选择下一步诊断测试的能力时,两位医师对o1-preview生成的测试计划进行了评分。

在132个案例中,o1-preview在87.5%的情况下选择了正确的测试,11%的情况下选择的测试计划被认为有帮助,仅有1.5%的情况下会被认为无帮助。这些数据进一步证实了o1-preview在临床决策支持中的潜力。

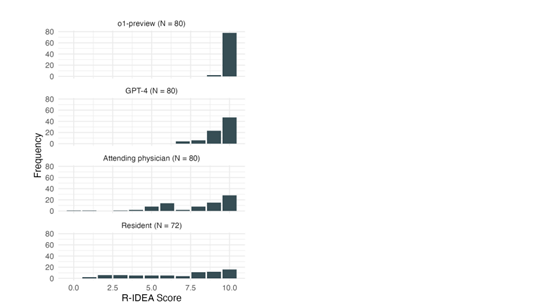

在NEJM Healer诊断案例中,o1-preview的表现同样出色。这些案例是为评估临床推理而设计的虚拟患者接触,o1-preview在80个案例中的78个达到了完美的R-IDEA评分,远高于GPT-4的47个、主治医师的28个和住院医师的16个。

R-IDEA评分是一个验证过的10点评分系统,用于评估记录临床推理的四个核心领域。这一结果表明o1-preview在展示临床推理方面的能力远超人类医师和其他同类大模型。

在基于真实案例的Grey Matters管理案例中,o1-preview的表现同样出色。在五个临床小节中,o1-preview的得分中位数为86%,高于GPT-4的42%、使用GPT-4的医师的41%和使用传统资源的医师的34%。

在与50位普通医师比较的六个Landmark诊断案例中,o1-preview的表现与GPT-4相当,中位数得分为97%,而GPT-4为92%,使用GPT-4的医师为76%,使用传统资源的医师为74%。这些数据表明o1-preview在诊断推理方面的能力与GPT-4相当,且优于人类医师。

在诊断概率推理案例中,o1-preview的表现与GPT-4相似,在估计测试前和测试后概率方面与GPT-4表现相近。然而,在冠状动脉疾病的压力测试中,o1-preview的密度更接近参考范围。这一结果表明o1-preview在概率推理方面的能力与GPT-4相当,但在某些特定情况下可能更接近科学参考概率。

本文转自 AIGC开放社区 ,作者:AIGC开放社区