大模型面经:SFT和RL如何影响模型的泛化或记忆能力? 原创

本篇分享SFT和RL在大模型训练中起到的作用。

监督微调 (SFT) 和强化学习 (RL)都是目前大模型的基础模型后训练技术,像DeepSeek-R1、kimi等的训练方法都将两种技术应用到了极致。

如何去设计训练步骤(先SFT再RL,还是直接RL)都需要对SFT和RL的能力有较深刻的了解。

本篇就以面经的形式,探讨SFT、RL两种不同的后训练范式在基于文本规则和视觉变体的情况下对模型记忆与泛化能力的作用。

下面是一个快捷目录。

一、SFT和RL分别对基座大模型的作用和影响是什么?

二、当模型包含视觉组件时,RL/SFT 如何影响其对不同视觉变体的泛化能力?

三、RL/SFT 如何影响视觉语言模型(VLM)中的视觉识别能力?

四、SFT 在 RL 训练中扮演什么角色?

五、验证迭代次数如何影响泛化能力

一、SFT和RL分别对基座大模型的作用和影响是什么?

1. SFT

1)作用

通过在特定任务,通常为指令格式的数据集上训练预训练模型,使其适应下游任务。

2)影响

- SFT 倾向于记忆训练数据,在基于规则的文本和视觉环境中都难以泛化到分布外的数据。

- SFT 对于有效的 RL 训练仍然非常重要:SFT 可以稳定模型的输出格式,使得后续的 RL 能够实现性能的提升。

2. RL

1)作用

用于使模型与人类偏好对齐,或训练基础模型来解决特定任务。

2)影响

- RL在基于规则的文本和视觉环境中均能展现出泛化能力。

- RL在复杂的、多模态任务中泛化能力强,且可以提升模型潜在的视觉识别能力,有助于增强视觉领域泛化能力。

总结就是RL 泛化,SFT 记忆。

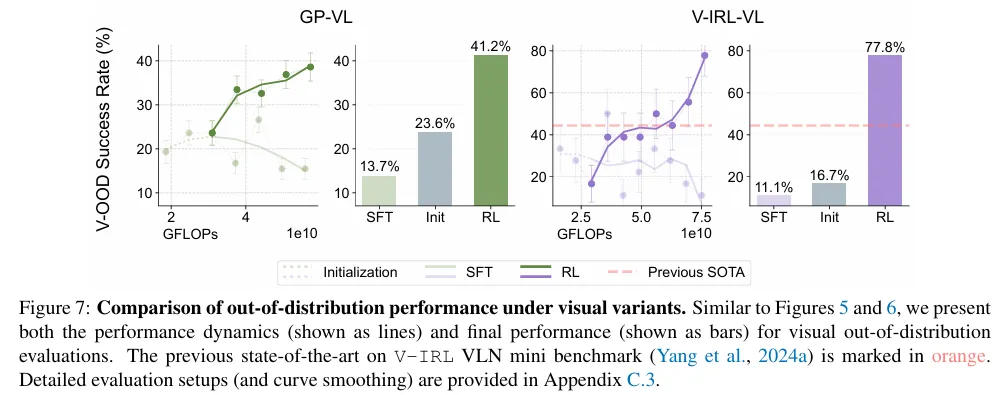

二、当模型包含视觉组件时,RL/SFT 如何影响其对不同视觉变体的泛化能力?

这块其实主要看多模态大模型中,视觉变化对分布外(OOD)泛化的影响。

从上图看,强化学习(RL)在规则变化中展现出泛化能力,而监督微调(SFT)则呈现相反的趋势。

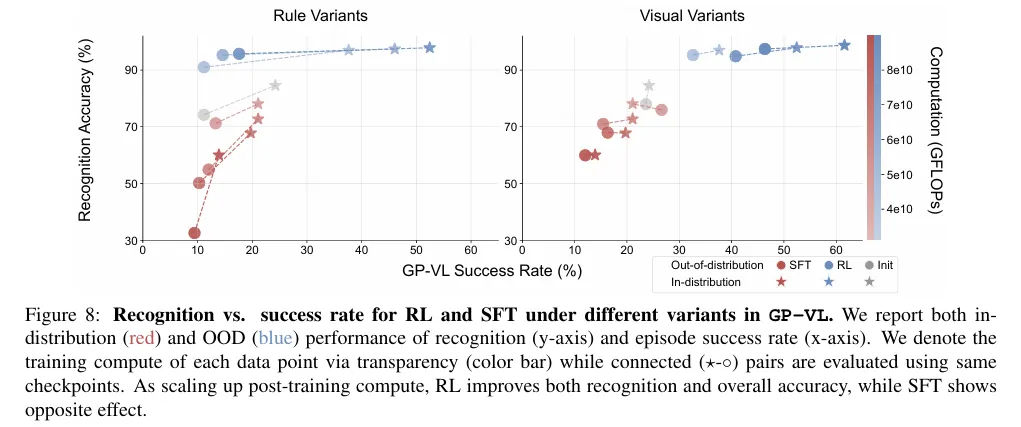

3. RL/SFT 如何影响视觉语言模型(VLM)中的视觉识别能力?

RL提高了视觉识别准确率,这也是RL提高了泛化能力的表现。

而SFT降低了视觉识别准确率和整体性能。

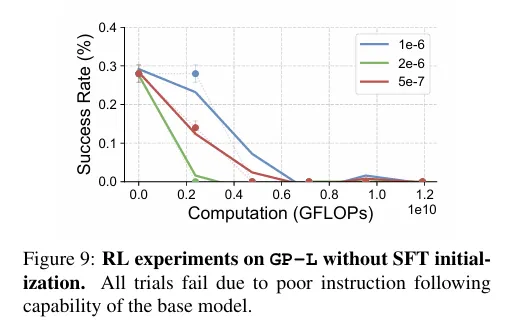

4. SFT 在 RL 训练中扮演什么角色?

实验流程是最好在 SFT 之后实例化 RL,特别是当基座模型都还没有学会模板指令的时候。

上图是一个示例,如果没有 SFT,基础模型会表现出较差的指令遵循能力,倾向于生成冗长、离题且非结构化的响应。

这个问题使得检索任务相关的信息和用于 RL 训练的奖励变得不可能。

当主干模型不遵循指令时,SFT(监督微调)对于 RL(强化学习)训练是必要的。

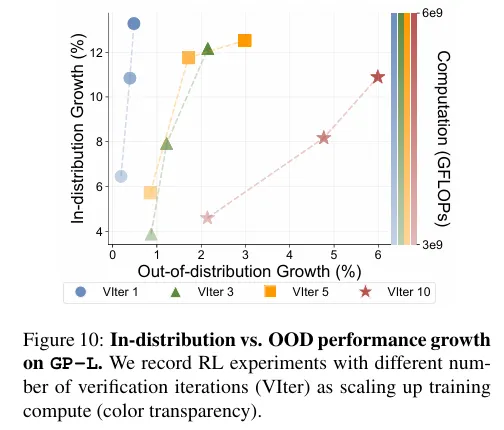

5. 验证迭代次数如何影响泛化能力

验证是多步骤训练和评估流程中的一个关键组成部分,上图表明随着验证步骤的增加,强化学习的泛化能力表现更佳。

上述研究均来自谷歌新作《SFT Memorizes, RL Generalizes: AComparative Study of Foundation Model Post-training》。

目前看起来这篇论文的研究结果跟DeepSeek以及o系列推理模型的训练报告都非常契合,特别是DeepSeek-R1的“SFT->RL->增强SFT->增强RL”这种左脚踩右脚直接起飞的操作。

看来循环利用SFT和RL,并结合一些reward模型设计、数据采用策略可以提升大模型水平,正式开始模型训练前需要储备的各种经验和trick也越来越多了,这块后续有机会分享一下~

文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷