回复

高效注意力机制与硬件优化:硬件优化的稀疏注意力,长上下文建模

研究背景与意义

在当今的语言模型研究中,长上下文建模被广泛认为是提升模型能力的关键。然而,传统的注意力机制在处理长序列时,计算复杂度高,导致显著的延迟和资源消耗。研究者们逐渐意识到稀疏注意力机制可能是解决这一问题的有效途径。本文提出了一种名为“Native Sparse Attention(NSA)”的机制,旨在通过算法创新与硬件优化的结合,实现高效的长上下文建模。

研究背景

- 长上下文建模的重要性:随着应用需求的多样化,长上下文建模成为语言模型发展的重要方向。

- 现有挑战:传统的全注意力机制在长序列处理时面临高计算成本,限制了模型的实用性。

研究意义

- 效率提升:NSA机制通过动态分层稀疏策略,结合粗粒度和细粒度的令牌选择,旨在在保持模型性能的同时显著提高计算效率。

- 创新点:该研究的创新点在于实现了端到端的训练,减少了预训练计算,同时保持了模型的性能。

研究方法与创新

NSA机制的核心在于其独特的算法设计与硬件优化,主要体现在以下几个方面:

1. 动态分层稀疏策略

- 粗粒度令牌压缩:将输入序列分块处理,通过聚合相邻令牌的信息,减少计算量。

- 细粒度令牌选择:在压缩的基础上,选择最重要的令牌进行精细计算,确保模型能够关注到重要信息。

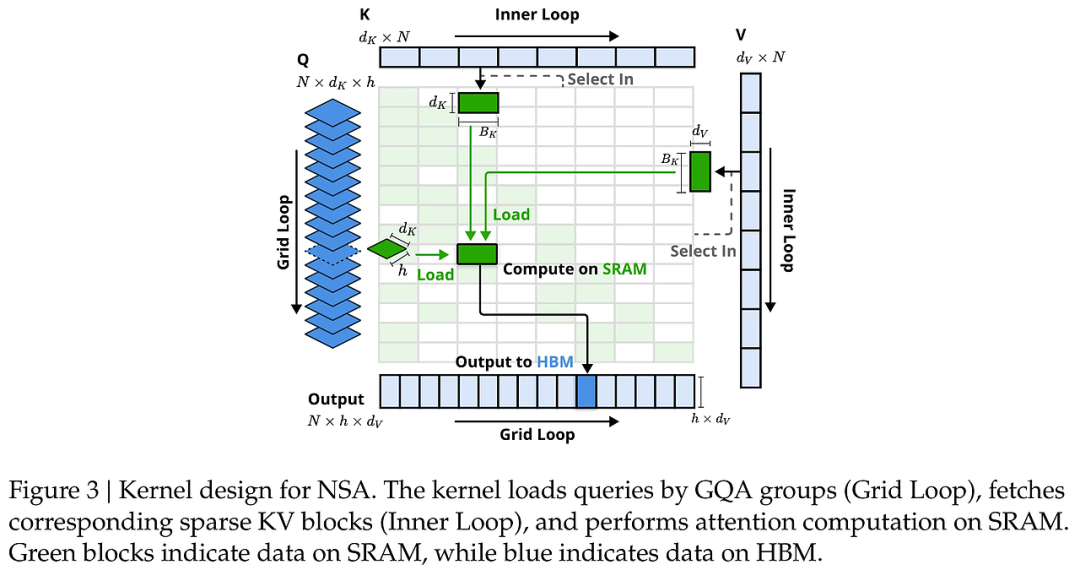

2. 硬件优化

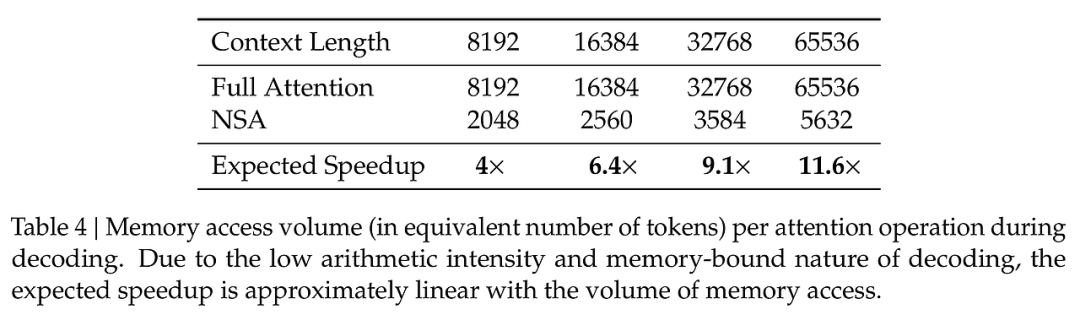

- 算法与硬件对齐:针对现代硬件进行优化,确保算法设计能够充分利用硬件的计算能力,减少内存访问延迟。

- 平衡算术强度:通过平衡计算与内存访问,优化模型的整体性能。

3. 端到端训练

- 训练感知设计:NSA支持端到端的训练,使得模型在训练过程中能够动态调整稀疏模式,提升学习效率。

实验设计与结果分析

在实验中,NSA在多个基准测试中表现出色,尤其是在长上下文任务和推理评估中。

实验设计

- 数据集:使用27B参数的Transformer骨干网络,进行260B词元的预训练。

- 性能评估:在长上下文任务和链式推理任务中,与传统的全注意力模型进行对比。

结果分析

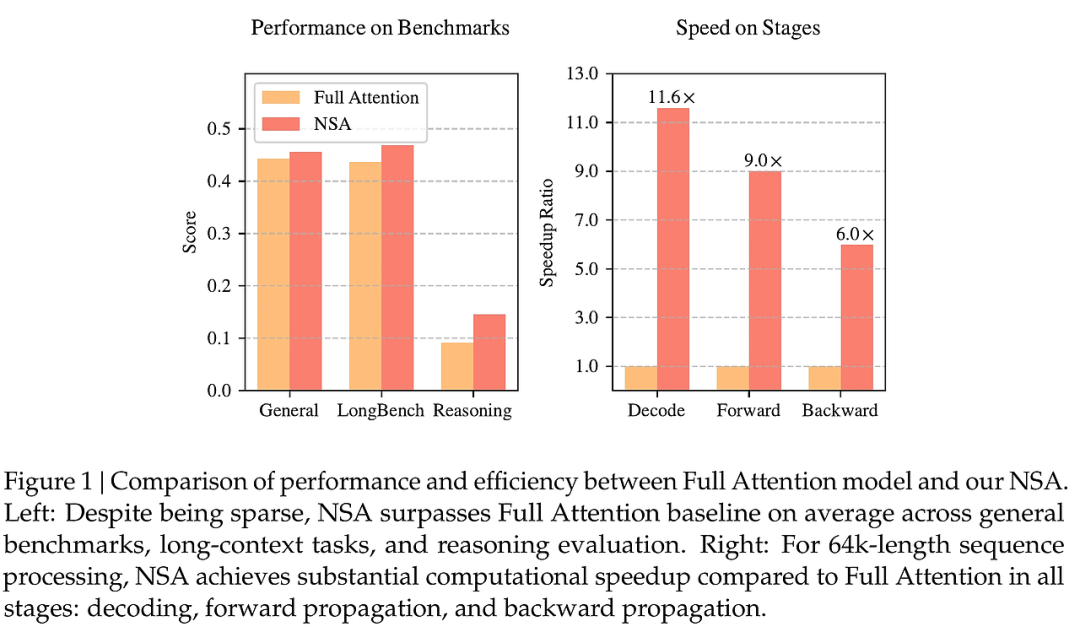

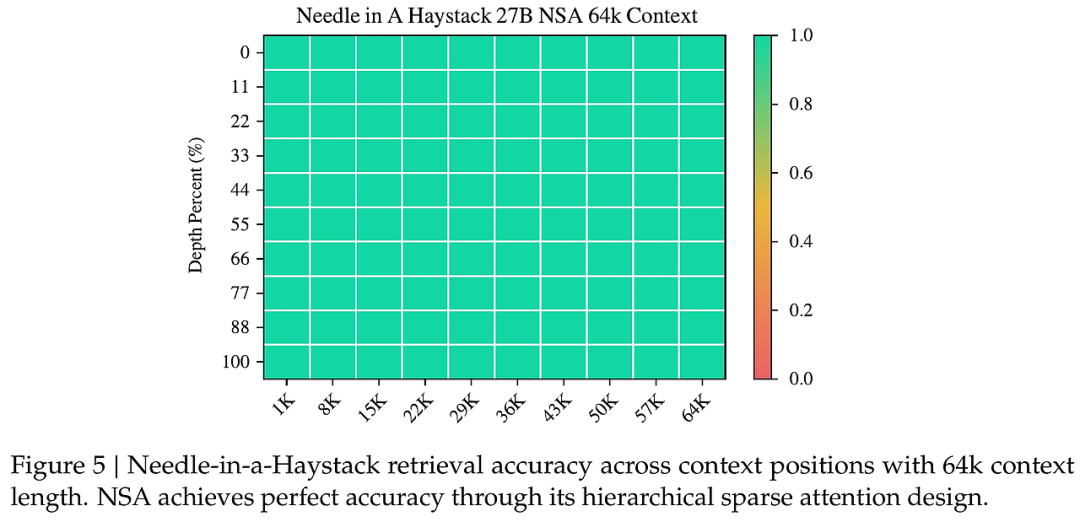

- 性能对比:实验结果表明,NSA在多个基准测试中超越了全注意力模型,尤其是在长序列处理上表现出更高的计算效率和准确性。

- 计算速度:NSA在解码、前向传播和反向传播阶段均实现了显著的速度提升,验证了其在实际应用中的有效性。

结论与展望

本文提出的NSA机制在长上下文建模中展现了优越的性能,其创新的稀疏注意力设计有效平衡了模型能力与计算效率。尽管取得了一定的成果,但仍需进一步探索在更复杂任务中的应用潜力。未来的研究可以集中在以下几个方面:

- 更广泛的应用场景:探讨NSA在多轮对话、代码生成等领域的适用性。

- 算法优化:继续优化算法以适应不断变化的硬件环境,提高模型的灵活性与适应性。

通过这些探索,NSA有望在未来的语言模型研究中发挥更大的作用。

本文转载自 AI研究前瞻,作者: 胡耀淇

赞

收藏

回复

相关推荐