大语言模型都有哪些特质?区分度达97%!DeepSeek&ChatGPT&Claude&Grok&Gemini

论文链接:https://arxiv.org/pdf/2502.12150

Git链接:https://github.com/locuslab/llm-idiosyncrasies

亮点直击

- 高准确率的模型区分:通过简单的文本嵌入模型微调,实现了高达97.1%的分类准确率,显著高于随机猜测的20.0%。

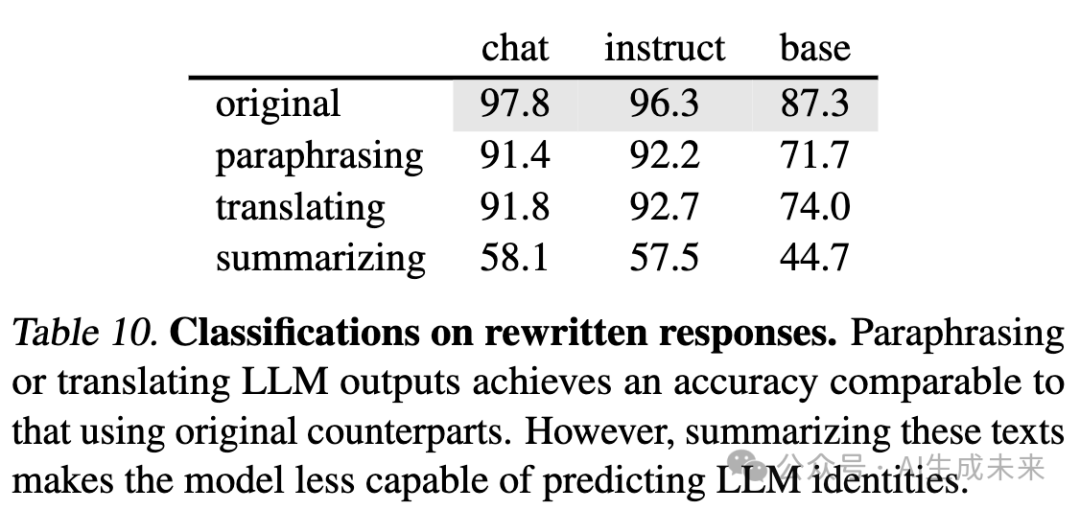

- 语义保留变换下的强鲁棒性:即使对文本进行重写、翻译或总结等语义保留变换,分类准确率仍保持在90%以上,表明LLM的独特性不仅体现在词汇层面,还体现在语义层面。

- 开放描述生成:利用LLM作为评判者,生成每个模型独特行为的详细描述,为理解不同LLM的输出模式提供了新的视角。

- 对合成数据训练的警示:研究结果表明,使用合成数据训练LLM时需谨慎,因为这些独特性可能会在训练过程中被继承,影响模型的输出行为。

总结速览

解决的问题

- 区分不同LLM生成的文本:研究旨在识别和区分不同大语言模型(LLM)生成的文本,揭示各模型的独特输出模式。

- 理解LLM的独特行为:通过分析LLM生成的文本,探讨这些模型的独特行为及其在语义层面的表现。

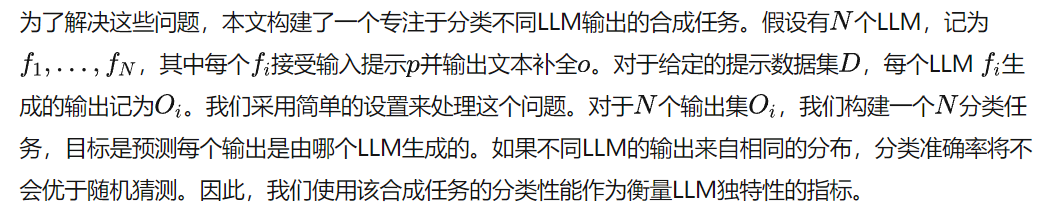

提出的方案

- 文本分类任务:设计一个简单的分类任务,通过训练分类器来预测给定文本的生成模型。

- 文本变换分析:通过对生成的文本进行随机打乱、重写、翻译和总结等变换,分析这些变换对分类准确率的影响。

- 开放描述生成:利用LLM作为评判者,生成每个模型独特行为的详细描述。

应用的技术

- 文本嵌入模型微调:对现有的文本嵌入模型进行微调,以适应LLM生成的文本。

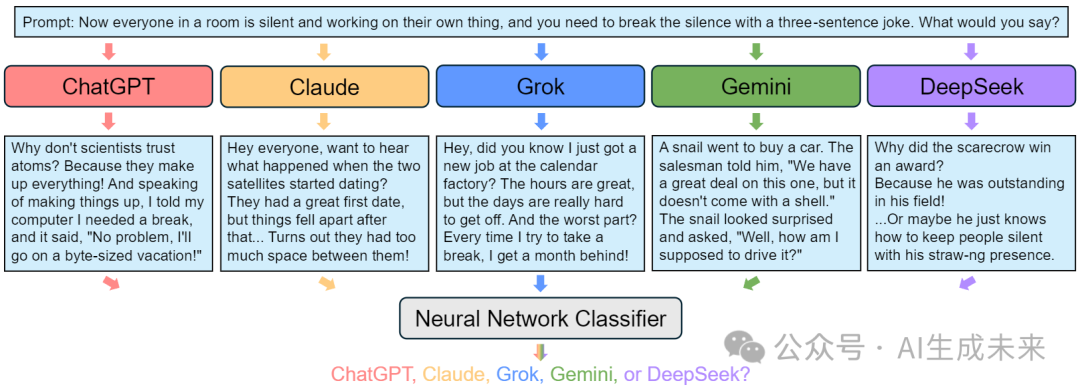

- 多模型分类:在多个LLM(如ChatGPT、Claude、Grok、Gemini和DeepSeek)之间进行多分类任务。

- 语义保留变换:通过重写、翻译和总结等技术,保留文本的语义内容,同时观察分类准确率的变化。

达到的效果

- 高分类准确率:在五分类任务中,分类器在验证数据上达到了97.1%的准确率。

- 强鲁棒性:即使在文本长度和格式受控的情况下,分类器仍能保持高准确率。

- 语义层面的独特性:即使经过语义保留的文本变换,分类准确率仍显著高于随机猜测,表明LLM的独特性也体现在语义层面。

评估LLM的独特性

大语言模型(LLMs)具有一些共同特征。首先,都采用了基于自注意力机制的Transformer架构。其次,它们使用自回归目标进行训练,即根据前面的上下文预测序列中的下一个token。最后,它们的训练数据集有显著的重叠,通常包含大量多样化的来源,如Common Crawl、Wikipedia和Stack Overflow。鉴于这些相似性,自然会问:LLMs的输出方式是否相同?如果不同,如何有效衡量它们的差异程度?

主要观察结果

神经网络在分类LLM输出时表现出惊人的高准确率。这一观察结果在不同设置下(例如,跨模型家族和规模)都具有鲁棒性。由于本文的任务本质上是一个序列分类问题,微调了一个强大的序列嵌入模型LLM2vec,并添加了一个N分类头,报告了最终的准确率。

- 对话API("chat"类):包含GPT-4o、Claude-3.5-Sonnet、Grok-2、Gemini-1.5-Pro和DeepSeek-V3,除DeepSeek外均为闭源模型。

- 指令微调LLM("instruct"类):包含Llama3.1-8b、Gemma2-9b、Qwen2.5-7b和Mistral-v3-7b四个同规模不同家族的模型。

- 基础LLM("base"类):指令微调LLM的基础版本,仅通过大规模文本预训练获得。

每类模型生成11K文本序列(10K训练,1K验证)。对话API和指令微调LLM使用UltraChat数据集,基础LLM使用FineWeb数据集生成文本。

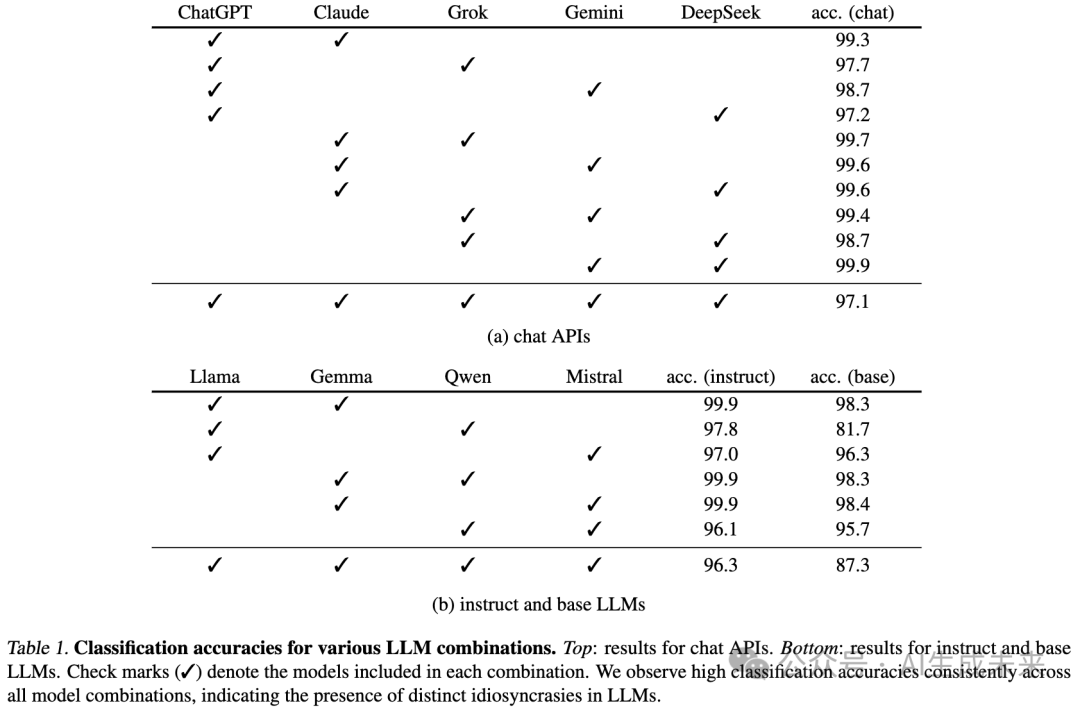

跨模型家族分类 下表1展示了不同组合的分类结果。在二分类任务中,神经网络持续保持90%以上准确率(仅个别例外),多数组合达到99%准确率。在更具挑战性的N分类任务中,分类器在三个组别均保持87.3%以上的强性能,凸显了不同LLM间的显著差异性。

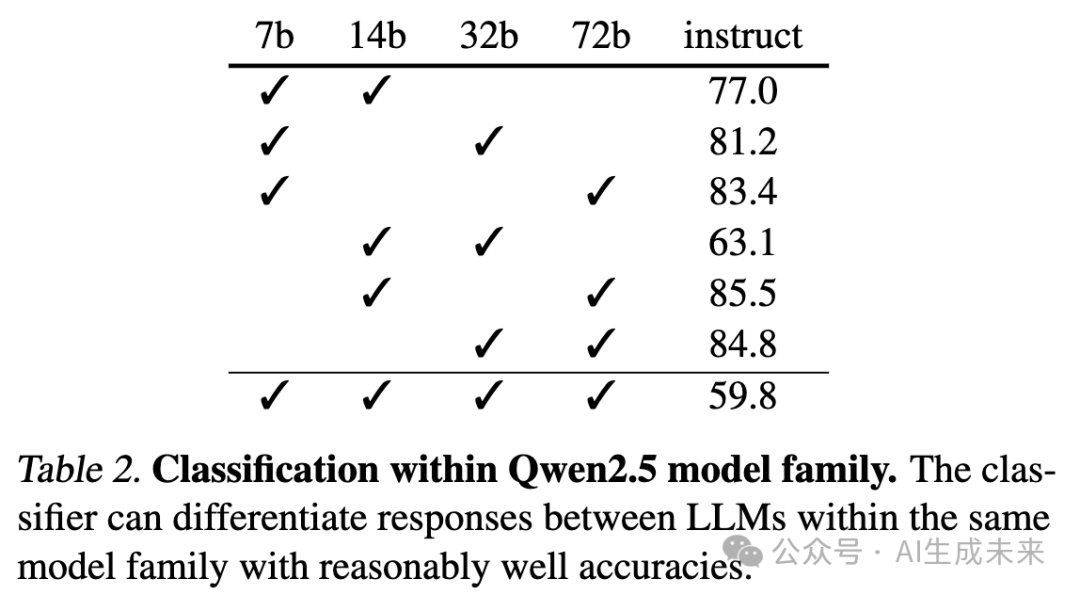

同模型家族内分类 当区分同家族模型时(如Qwen2.5系列的7B/14B/32B/72B模型),分类难度增加但仍显著优于随机水平(二分类最高85.5%,全组合59.8%)。区分同模型的基础版与指令微调版时,分类器可达96.8%准确率。

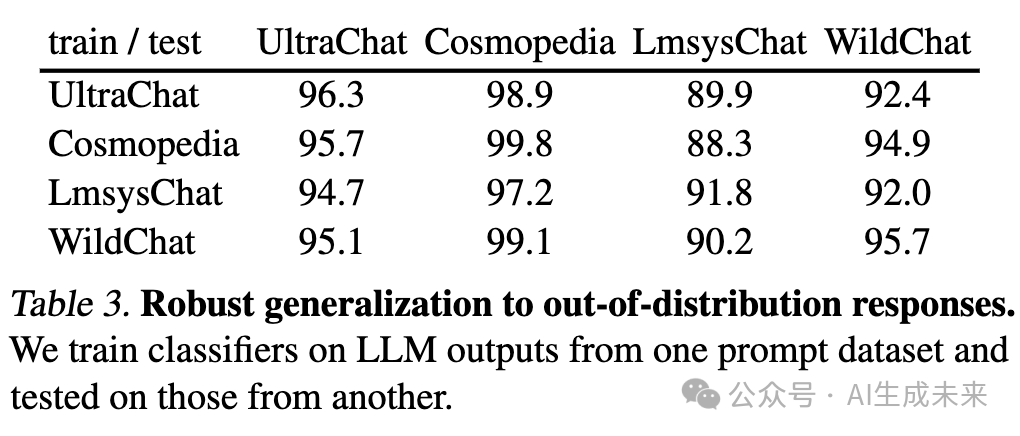

分布外响应泛化 分类器在四个不同来源的指令数据集(UltraChat、Cosmopedia、LmsysChat、WildChat)上展现出强泛化能力(下表3),表明其学习到了稳健且可迁移的模式。

控制实验

研究者们在多个控制设置下分析合成分类任务的行为特征(下文仅报告各组N分类准确率)。

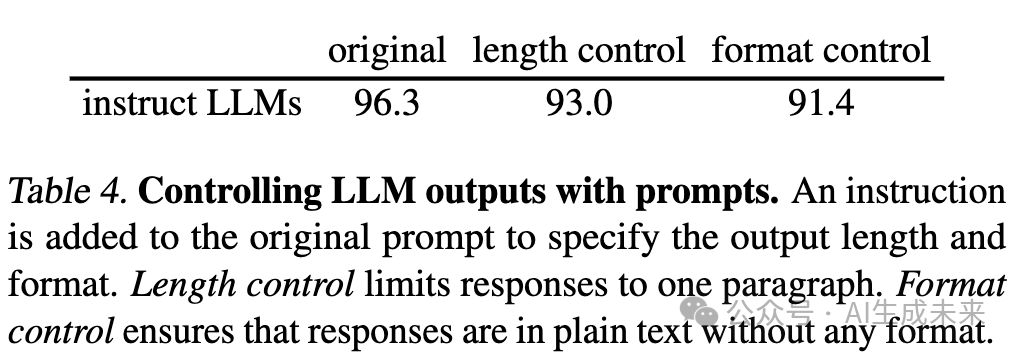

提示层面干预 通过添加长度控制("请提供简洁回答,单段不超过100词")和格式控制("请使用纯文本,避免格式token")指令,发现分类准确率仍保持高位(下表4),表明LLM特征深度嵌入于生成文本中,不受表层约束影响。

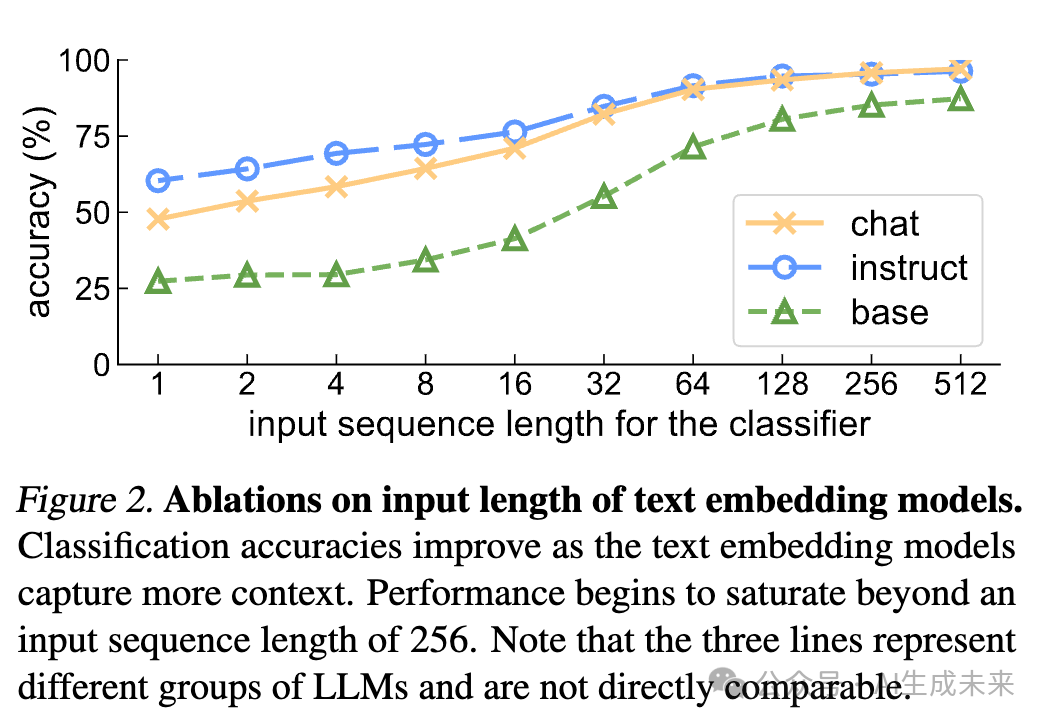

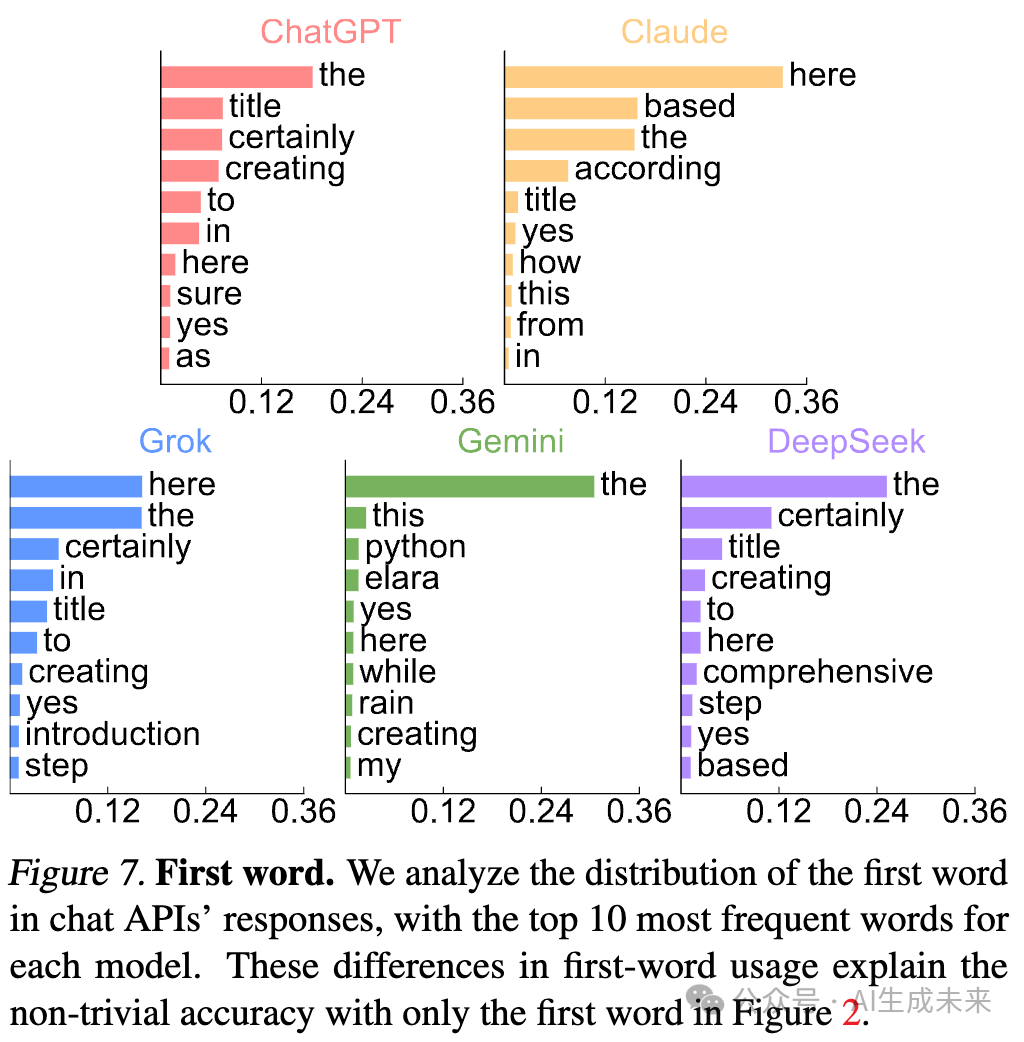

输入长度控制 下图2显示,随着输入token数量增加,分类性能逐步提升。值得注意的是,对话API和指令LLM仅需单个token即可获得约50%准确率,表明首个token已包含显著区分信号。

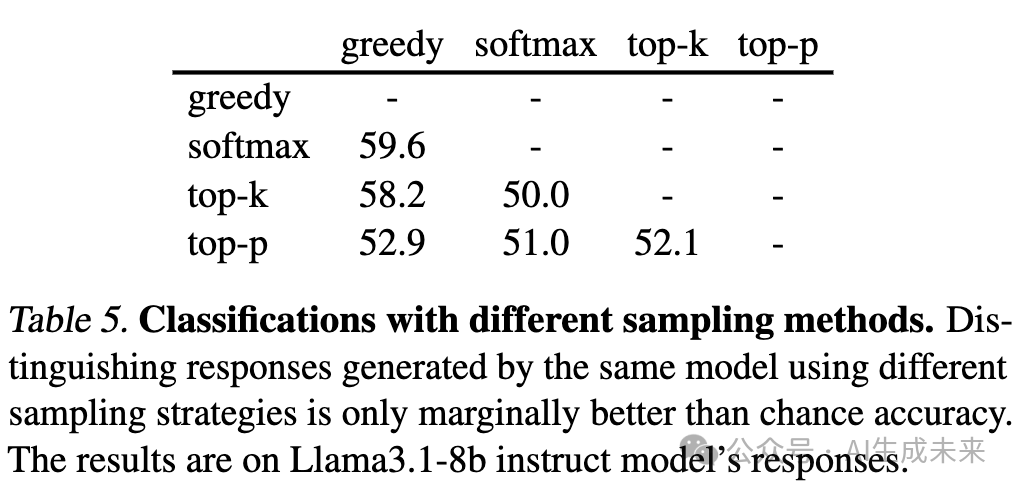

采样方法分析 下表5显示,区分同一LLM不同解码策略(贪婪解码、温度采样、top-k、top-p)生成的响应时,最高准确率仅59%。在五分类任务(不同温度softmax采样)中,准确率37.9%仅略高于20%基线,表明解码策略对输出可分性影响有限。

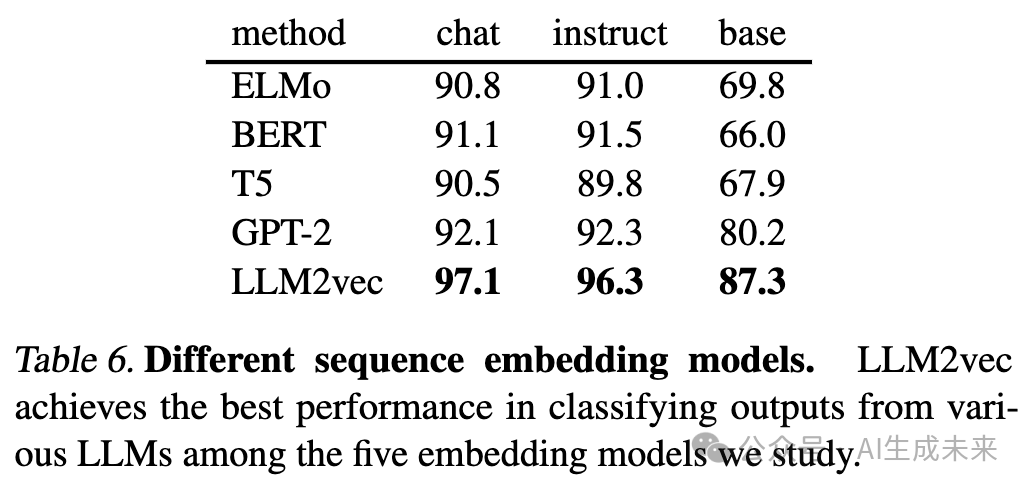

文本嵌入模型对比 下表6显示,不同世代嵌入模型(ELMo、BERT、T5、GPT-2、LLM2vec)均能实现高准确率,其中LLM2vec性能最佳(对话API 97.1%,指令LLM 96.3%,基础LLM 87.3%)。

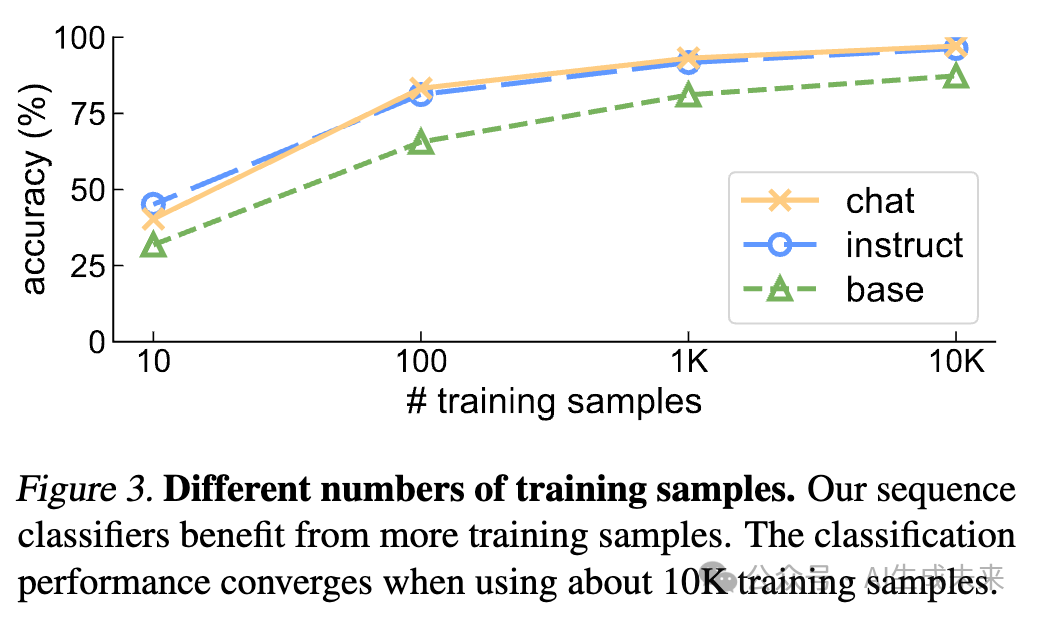

训练数据规模 下图3表明分类性能随训练样本量增加而提升,仅需10个样本即可超越随机基线(指令LLM 40.3%)。

LLM具体特有模式

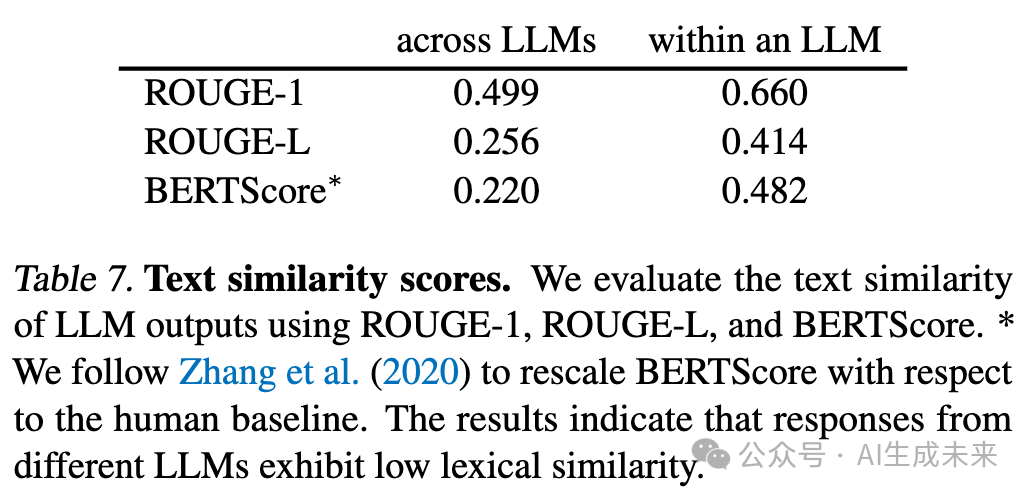

本文使用ROUGE-1、ROUGE-L和BERTScore等指标量化LLM输出的词汇差异(下表7),发现不同LLM生成的文本相似度显著低于同模型不同采样结果。以下从三个维度剖析具体特有模式:

词汇与字母

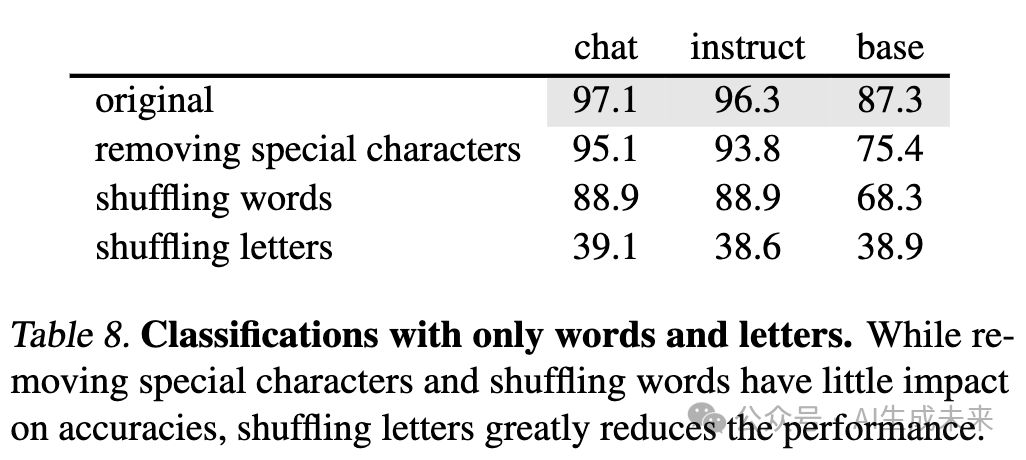

文本重组 通过去除特殊字符并进行词汇/字母级重组(下表8),发现:

- 去除特殊字符后分类准确率保持高位(对话API 95.1%,指令LLM 93.8%)

- 词汇重组仅导致小幅下降,表明特征主要编码于词汇分布

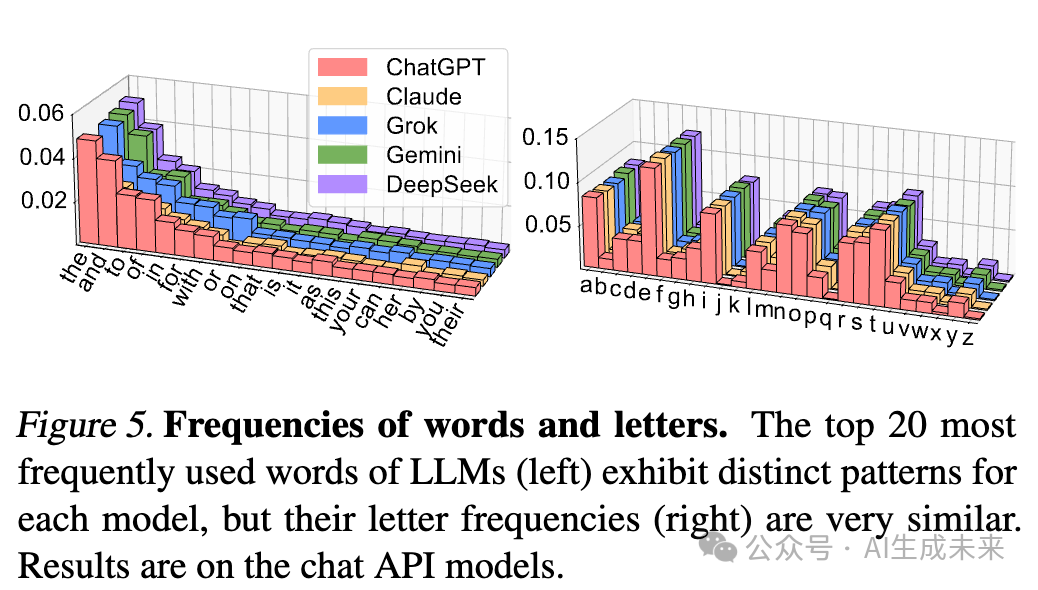

- 字母重组使准确率接近随机水平(49-56%),字母分布差异极小(下图5)

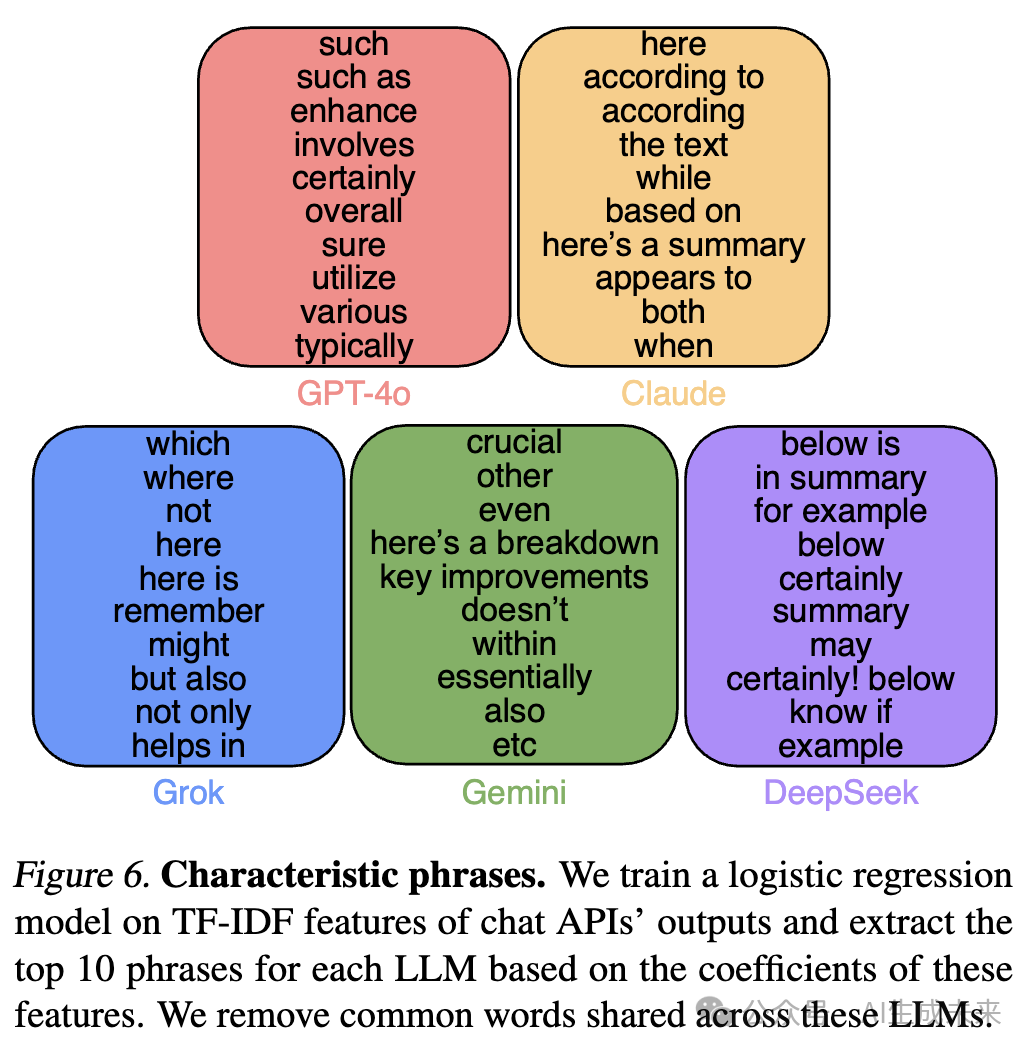

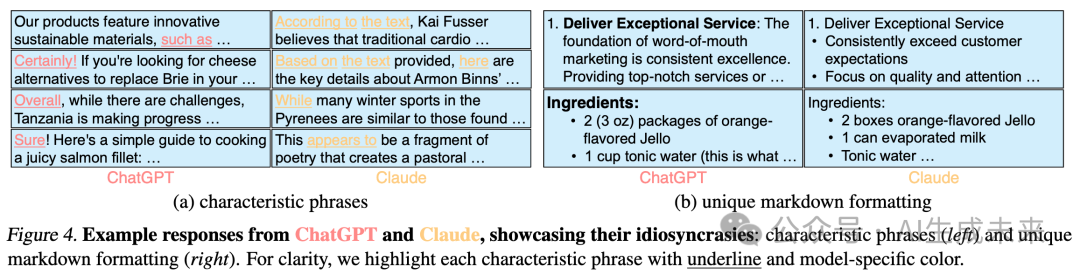

特征短语 使用TF-IDF特征训练逻辑回归模型(对话API 85.5%,指令LLM 83.7%),提取各模型top10特征短语(下图6)。例如:

- ChatGPT偏好"such as"、"certainly"等过渡词

- Claude倾向"according to"、"based on"等引用表达首词选择分布也呈现显著差异(下图7)。

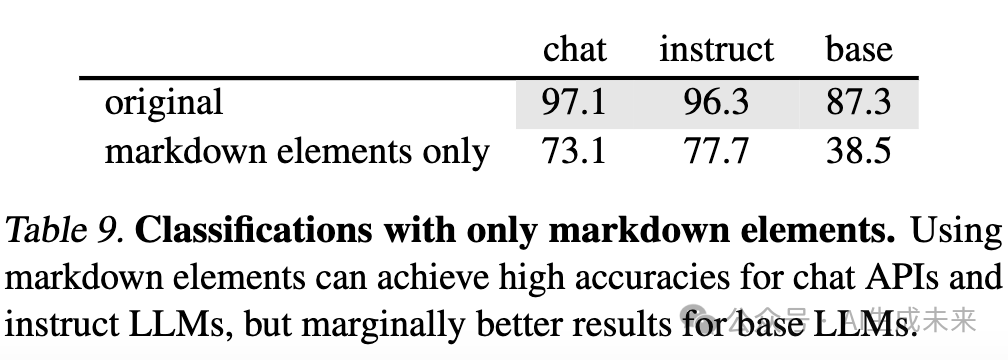

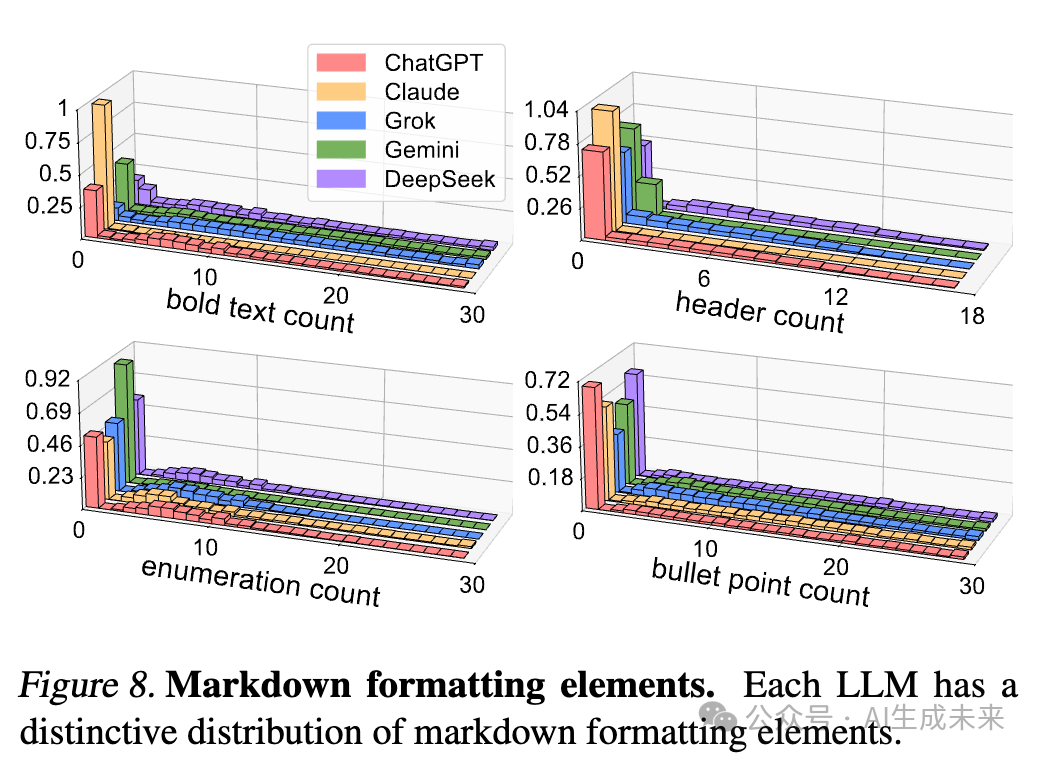

Markdown格式

保留Markdown元素(加粗、斜体、标题等)并替换文本为"xxx"后(下表9):

- 对话API和指令LLM仍保持73.1%/77.7%准确率

- 基础LLM接近随机水平(25%)各模型格式使用习惯差异显著(图8),例如:

- Claude较少使用加粗和标题

- ChatGPT偏好结构化格式(下图4)

语义层面

改写测试 使用GPT-4o mini进行改写、翻译和摘要后(下表10):

- 改写和翻译文本分类准确率与原文本相当

- 摘要文本准确率下降但仍显著优于随机表明语义信息对分类具有决定性作用。

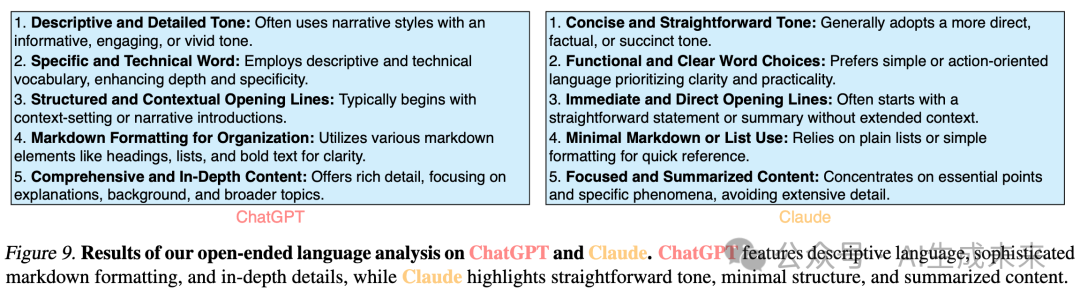

开放性语言分析 使用ChatGPT作为评估者对响应进行开放性描述(下图9),发现:

- ChatGPT偏好详细描述和复杂格式

- Claude侧重简洁表达和核心内容

研究启示

合成数据中的特有模式

在Llama3.1-8b和Gemma2-9b上使用UltraChat(ChatGPT生成)进行监督微调后:

- 模型间分类准确率从96.5%降至59.8%

- 使用合成数据微调的模型仍保留源模型特征(准确率98.9%)表明合成数据训练会传播源模型特有模式。

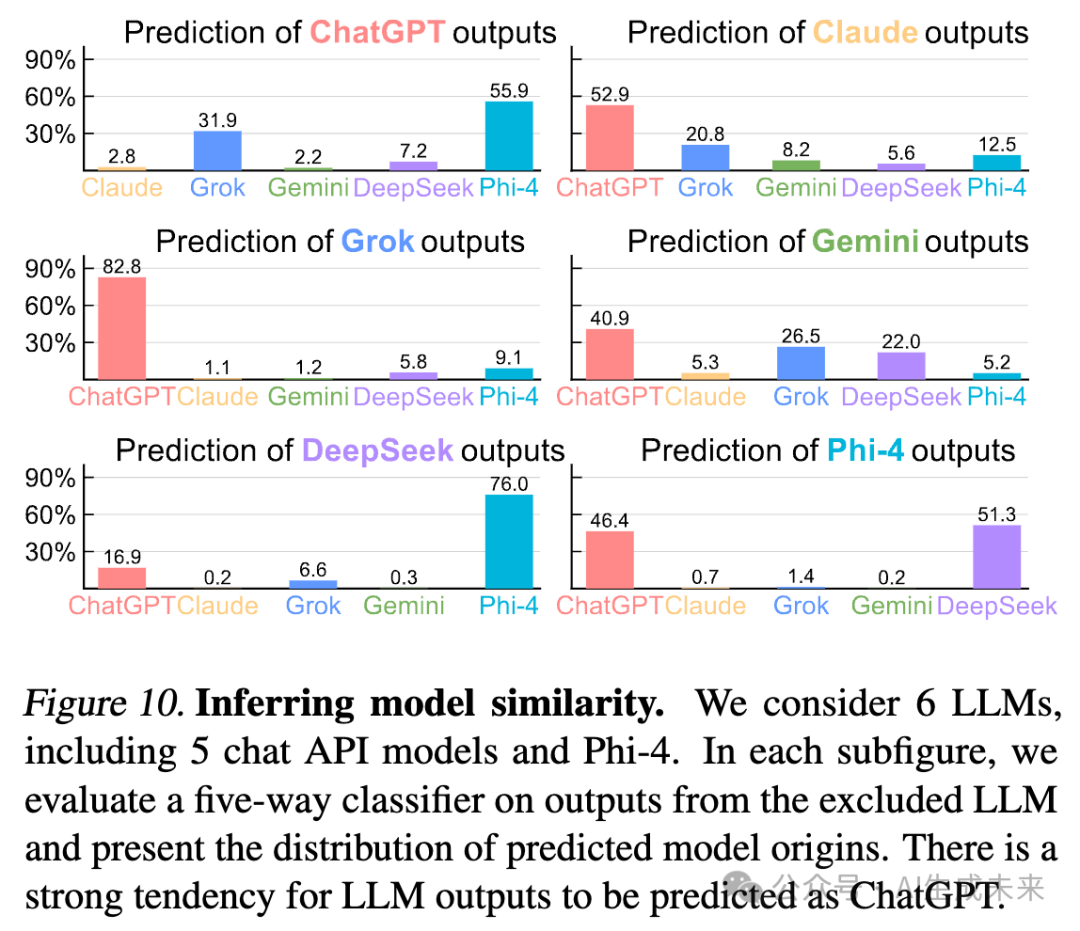

模型相似性推断

通过排除法训练分类器并评估被排除模型的响应归属(下图10),发现:

- Claude、Grok、Gemini输出常被误判为ChatGPT

- DeepSeek和ChatGPT输出与Phi-4关联密切该方法为评估前沿模型相似性提供了量化工具。

结论

本文证明了大语言模型(LLMs)中存在独特性,并研究了一种旨在量化其程度的合成任务。只需在LLM输出上微调预训练的文本嵌入模型,就能在预测文本来源时获得极高的准确率。这一现象在不同的提示数据集、LLM组合以及其他多种设置中均持续存在。本文还明确了LLM中这些独特性的具体形式。希望本文的工作能够鼓励进一步研究理解LLM中的独特性。

本文转自AI生成未来 ,作者:AI生成未来