清华、中南开源3D交互实体AI Agent LEGENT

我们常见的AI Agent都是无法看到实体的,例如,RPA、智能按键精灵、AutoGPT等。虽然它们可以自动完成一些日常工作,但你是无法看到其真实身体。

清华大学、中南大学的研究人员联合开源了一款可视化3D交互实体AIAgent模型LEGENT,使用户可以在3D虚拟空间中与实体AI代理进行互动。

「AIGC开放社区」通过在线demo体验了一下这个代理,非常有趣就像是玩一款游戏一样。只需发送特定指令就可以让AI做一些日常动作,例如,把汽车玩具放在书本上;把地上的笔捡起来给你等。

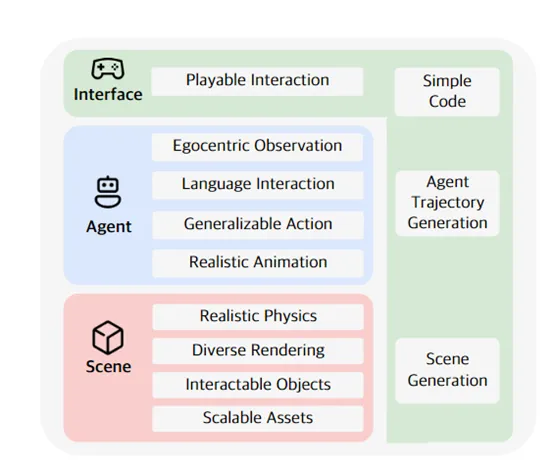

LEGENT主要由场景、智能体(Agent)和界面三大块组成,同时融入了大语言模型和多模态模型,以便更好地理解用户的文本指令。

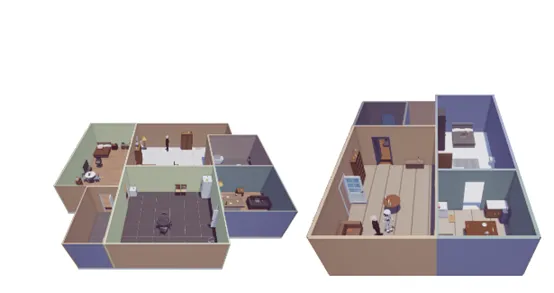

LEGENT的场景模块通过基于游戏引擎的实时物理模拟,为智能体的学习和决策提供一个逼真的3D环境。这包括精确模拟的重力、摩擦力和碰撞动力学,使得智能体能够更加自然地与环境互动,为学习和决策提供了必要的物理信息。

场景中的3D对象不仅有逼真的视觉效果,还能够进行复杂的交互操作。例如,智能体可以抓取、搬运、放置和与这些对象互动,包括动态结构如门和抽屉的操作。这种高度的交互性为智能体提供了丰富的操作体验,是学习和模拟现实世界任务的任务。

此外,研究人员还为场景模块设计了灵活的可扩展性,允许开发人员导入自定义的3D对象,包括用户设计的模型、现有数据集的对象,以及通过生成模型创建的对象,方便应用在不同的业务场景中。

为了使LEGENT的智能体更具备拟人化的能力,研究人员加入了很多智能化功能。

LEGENT的智能体具备“自我中心视觉”特性,类似于人类通过自己的眼睛观察世界。这种视觉系统使智能体能够从第一人称视角捕捉环境信息,为执行任务提供了直观的视觉输入。

在视觉的帮助下,使智能体能够执行一系列预定义的动作,例如,导航、物体操纵和通信。这些动作可以帮助智能体快速适应不同的新环境,甚至是真实世界的场景中,并且动作是连续性的操作,例如,移动一定距离或旋转特定角度,而不是简单的离散动作。

为了帮助用户更好地操作与智能体交流,研究人员将LEGENT的UI设计得像视频小游戏一样直观,可以通过键盘和鼠标直接与智能体和环境进行指令交互。

此外,LEGENT还提供了场景生成和行为轨迹生成的界面。场景生成界面支持程序生成和语言指导生成两种方式,用户可以使用JSON格式轻松定制场景。

行为轨迹生成界面则专门为训练大型多模态模型而设计,能够高效生成包括第一人称视觉观测和对应动作的训练数据集。

LEGENT的部署非常简单、高效可以在普通PC上运行,无需特定的硬件要求或复杂的配置。还支持与远程服务器的连接,便于训练和部署增强其可访问性。

开源地址:https://github.com/thunlp/LEGENT?tab=readme-ov-file

论文地址:https://arxiv.org/abs/2404.18243

本文转自 AIGC开放社区 ,作者:AIGC开放社区