4090单卡部署满血 671B DeepSeek,本地部署“成本骤降32倍”!!! 原创

最近,无论是在国内还是国外,一股 DeepSeek-R1 部署热潮正在兴起,许多人都争相在自己的本地服务器上尝试部署完整版的 DeepSeek-R1。不过,想要在本地部署一个满血版本的 DeepSeek-R1 版本,可能需要大约16张 A800 显卡,这意味着大约需要投入200万元人民币的成本。长期以来,业界对于 671B 大模型的成本问题感到困扰,迫切希望找到一种低成本的满血版 671B DeepSeek部署方案。今天,向大家推荐一个框架——KTransformers,它能够在单台配备 24GB VRAM 的 GPU 或多 GPU 以及 382G DRAM 的平台上支持满血版 Deepseek-R1 的部署,并且能够实现3到28倍的速度提升。这可能是许多朋友们一直在寻找的解决方案,如果你也感兴趣的话,不妨赶紧收藏起来。

项目地址:https://github.com/kvcache-ai/ktransformers/tree/main

1、DeepSeek-R1部署痛点梳理

最近,无论是在国际还是国内市场,DeepSeek-R1 的部署热潮正盛,许多人都争相在自己的本地服务器上安装满血版本的 DeepSeek-R1。但是,要本地部署这个满血版本的 DeepSeek-R1,通常需要配备 16个 A800 显卡,这意味着大约需要 200万元人民币的投资。这样的高昂成本无疑让许多人望而却步,尽管如此,还是有一些资金雄厚的企业不惜重金部署了满血版本的 DeepSeek-R1。

此外,许多网友反映,70B及以下的模型与满血版在性能上存在显著差距。同时,大模型微调的成本也不低。这些限制因素使得满血版大模型的能力无法广泛惠及更多人。长期以来,业界对于 671B 大模型的成本问题感到苦恼,迫切期待出现一种成本较低的满血版本 671B DeepSeek R1 部署解决方案。

2、KTransformers 框架简介

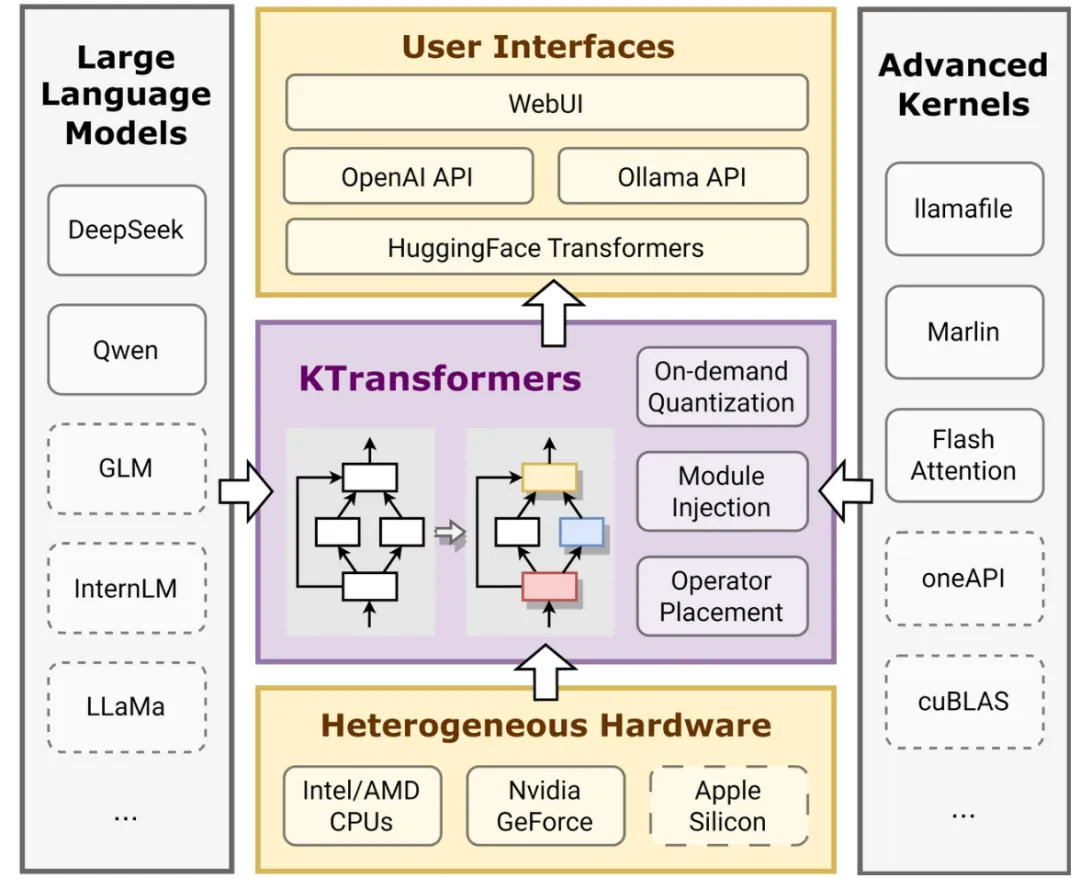

KTransformers,其发音类似于"Quick Transformers",该框架的目标是通过高级内核优化和位置并行来提升您的 Transformers 性能。

KTransformers 是一个以 Python 为重心、极具灵活性的框架,其设计理念围绕可扩展性展开。只需一行代码,用户即可集成并注入一个优化模块,从而获得与 Transformers 兼容的接口、支持 OpenAI 和 Ollama 的 RESTful API,甚至是简化版的类似 ChatGPT 的网页用户界面。作者期望 KTransformers 能够成为一个灵活的实验平台,用于探索和优化 LLMs(大语言模型)推理的新方法。

3、KTransformers 硬件配置

基于 KTransformers 的硬件配置如下:

CPU 型号:Intel (R) Xeon (R) Gold 6454S 1T DRAM (2 NUMA nodes)

GPU型号:4090D 24G VRAM

内存: DDR5-4800 server DRAM (1 TB)

模型:DeepseekR1-q4km (int4)

4、KTransformers 框架性能指标

在本地运行的 671B DeepSeek-Coder-R1:仅需14GB VRAM和382GB DRAM 即可启动其 Q4_K_M 版本。

预填充速度(令牌/秒):KTransformers 的表现为 54.21(32核)→ 74.362(双插槽,2×32核)→ 255.26(基于 AMX 优化的 MoE 内核,仅限 V0.3)→ 286.55(选择性使用6位专家,仅限 V0.3),相较于 llama.cpp 在 2×32 核上的10.31令牌/秒,速度提升了27.79倍。

解码速度(令牌/秒):KTransformers 的解码速度为8.73(32核)→ 11.26(双插槽,2×32核)→ 13.69(选择性使用6位专家,仅限V0.3),与 llama.cpp 在2×32核上的 4.51令牌/秒相比,速度提升了3.03倍。

此外,作者还预告了即将推出的优化措施,包括英特尔 AMX 加速内核和选择性专家激活技术,这些都将显著提升性能。通过使用 V0.3-preview,作者已经实现了每秒高达286个令牌的预填充速度,这使得其在局部推理上比 llama.cpp 快了28倍。具体的 wheel 文件详情待发布。

5、KTransformers 框架上手指南

更详细的细节如下所示:

https://github.com/kvcache-ai/ktransformers/blob/main/doc/en/DeepseekR1_V3_tutorial.md

本文转载自公众号玄姐聊AGI 作者:玄姐