像Sora一样,用物理模拟方式生成视频

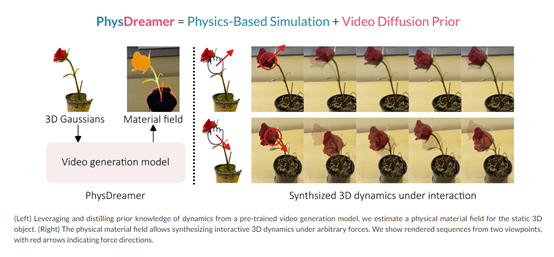

麻省理工学院、斯坦福大学、哥伦比亚大学、康奈尔大学的研究人员联合开源了创新3D交互视频模型——PhysDreamer(简称“PD”)。PD和OpenAI的Sora一样,是一个可以通过物理模拟的方式来生成视频。也就是说,PD的视频具备很多物理世界的特征。例如,用手去触摸一盆花后,花朵会左右摇摆直至缓慢停止。PD可以准确地捕捉到物体很多微妙的动态变化和复杂的交互细节,生成的视频也就更加精准、细腻。

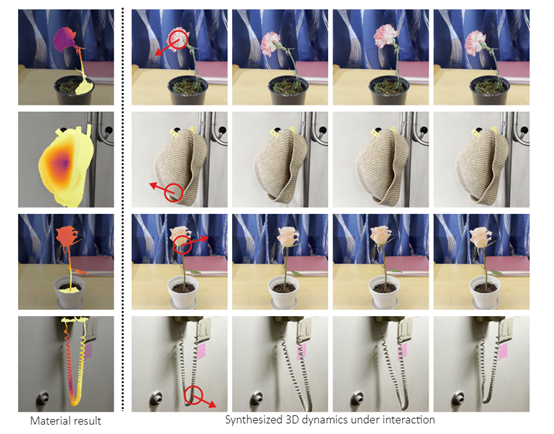

PD案例展示

PD主要通过视频生成模型学习到的动态先验知识,来评估静态3D对象的物理材质属性。在大量视频训练数据的帮助下,可捕捉到物体外观和动态之间的关系。

从而帮助PD推断出驱动物体动态行为的物理材质属性,即使在缺乏地面真实材质数据的情况下也没问题,这也体现了PD强大的物理模拟和评估能力。

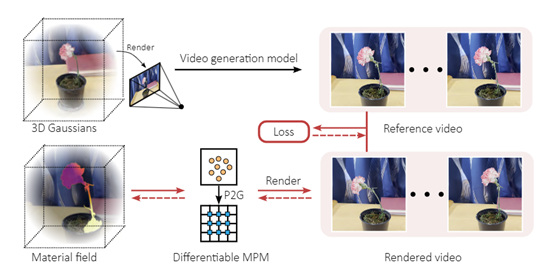

视频生成模型是PD的核心模块之一,通过学习大量视频数据中的场景外观和动力学关系,为后续的物理材质模拟,以及交互式3D动力合成提供了重要的基础知识。

视频生成模型主要是通过深度神经网络来建模视频帧之间的时空依赖关系,由编码器和解码器组成。编码器负责将输入视频帧编码为低维表示,捕捉到图像中的关键特征。

解码器则将这些低维表示解码为逼真的视频帧。通过训练过程,视频生成模型能够学习到输入视频帧与目标视频帧之间的映射关系,从而实现逐帧的视频生成。主要流程分为以下四大块。

外观建模:主要用来学习物体的外观变化模式,通过观察大量的视频数据,使PD能够捕捉到物体的纹理、颜色、形状等特征,并将它们编码为低维表示。这些编码后的表示可以用于后续的物理材料特性估计和3D动力学合成。

动力学建模:通过观察物体在视频中的运动轨迹,模型能够捕捉到物体的速度、加速度以及其他动力学特征。

先验知识提取:通过分析编码后的表示和解码后的视频帧,模型能够提取出物体外观和动力学之间的关系,包括外部力对物体的影响、物体的弹性等特征,为后续的物理材质模拟提供重要基础。

物体响应预测:可根据输入的交互刺激,预测物体的响应。通过将交互刺激与学到的外观和动力学模式结合起来,模型能够生成物体在新颖交互下的运动轨迹和形变情况。

使得PD生成的视频能够根据用户的输入,预测出静态3D物体在特定交互刺激下的逼真动态响应。

在现实世界中,物体的物理行为由其材质属性决定,例如,刚度、弹性和质量等。而在虚拟环境中模拟这些属性时,会使用“杨氏模量”来进行评估和调整,例如,一个高杨氏模量意味着材料更坚硬,低则是更软。

PD为了复现现实世界中的物理知识,使用了材质场表示来实现对3D对象物理属性的逼真模拟。材质场是一个连续的函数,为3D场景中的每个点分配了一个“杨氏模量”物理属性值。

物理材质场是通过隐式神经场来表示,这是一种可微分的模型,可以优化以匹配参考视频中的动态。这种表示方法不仅能够精确地捕捉物体的物理属性,还能够与物理模拟过程无缝集成。

例如,当用户在虚拟环境中挤压一朵虚拟花朵时,花朵的变形和回弹方式会非常接近真实世界的表现。

尤其是在缓慢运动表征方面,PD模型比DreamGaussian4D、PhysGaussian、Real Capture模型表现更好。

本文转自 AIGC开放社区 ,作者:AIGC开放社区