满血DeepSeek-R1免费用!附带数据蒸馏的一些想法!

最近DeepSeek-R1蒸馏太火了,昨天在群里跟群友们问白嫖R1接口的事情,想着多点搞免费额度蒸馏一波满血版DeepSeek-R1,来做做试验。

结果一个小伙伴,跟我讲,他们(无问芯穹)的满血版DeepSeek-R1 API是免费调用的,不仅如此,还有DeepSeek-V3、Deepseek蒸馏版本模型R1-Distill-Qwen-32b也是免费的。

当然,现在DeepSeek流量真的爆炸,公众号标题带DeepSeek流量都会更高一些,算是现象级模型了。在这里为春节期间同样努力奋斗,放出新模型的Kimi、Qwen感到可惜,流量确实没打过。

但发现跟多人有存在一个误区(应该是普通用户们),觉得R1是万能的。

但注意的一点是,满血版R1很强,蒸馏版本的就没有那么强了,并且满血版本大多数人没有资格本地部署,所以如果是个人使用,不如使用API来的是在(心疼那些花钱卖本地部署资料的朋友,我觉得关注我的应该没有吧~)。

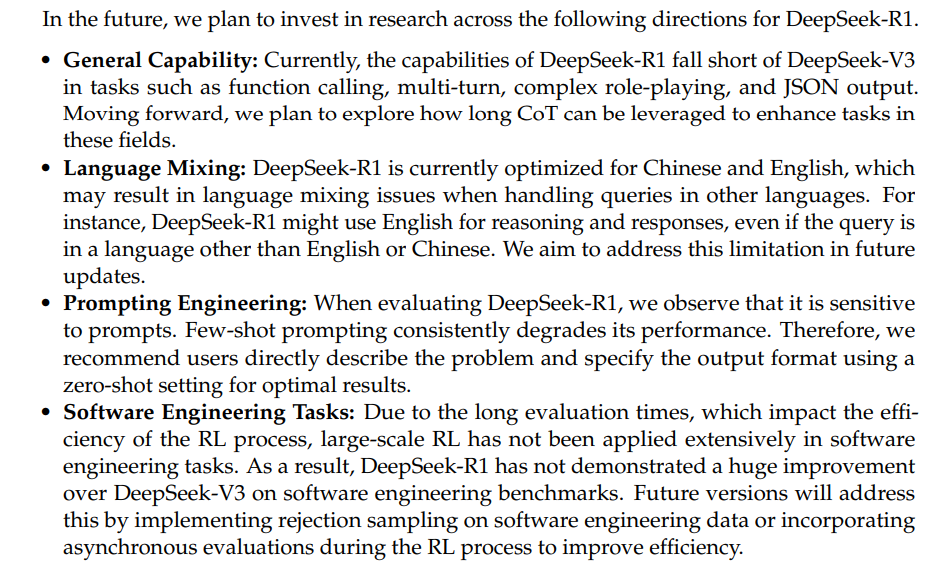

还有,DeepSeek的官方论文都指出了现在R1存在的一些限制,比如在function calling、多轮对话、复杂角色扮演、Json格式输出等方面,是不如通用模型DeepSeek-V3的。但都很强,开源社区第一确实毋庸置疑。

DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

还有就是R1到底适合什么落地场景呢?现在可以看到,代码、数学、文学创作都是一等一的强,并且R1的输出更自由(啥都敢说)。

但是个人在RAG的场景上做了相关的实验,对比R1-Distill-Qwen32B和Qwen2.5-32B-Intruct的效果,100道题(简单、复杂、总结等都有),R1-Distill-Qwen32B对了94道,Qwen2.5-32B-Intruct对了92道,基本上差不多,但推理模型输出的结果更长,响应时间更久,那么在真正工程化落地的时候,就没有性价比。(当然可以说研究使用、或通向AGI的必走之路,但我比较片面,还是在想还有哪些是非R1不可,不能用V3的)

不过,DeepSeek这一波无论是论文细节,还是开源的蒸馏模型,确实给我(很多人)很大的启发,属实良心,起码我现在不用强化学习,纯SFT也能做推理模型。

比如前两天大火的s1和LIMO都是纯SFT+一些推理trick,实现了模型推理能力的提高,AIME上也是超过o1-preview版本。

并且数据蒸馏也不是一个新鲜话题了,2023年我们SFT的数据不就是蒸馏ChatGPT嘛,为了保证数据质量,后面从GPT3.5变成GPT4...,现在推理模型,我们开始蒸馏DeepSeek-R1了,不蒸馏o1是因为之前OpenAI不开放推理过程,虽然现在开放了,但是也不是完整版,是总结版,虽然可用,但不如用R1~

你会发现,又回到了从前,开始搞数据、数据筛选、SFT(当然r1-zero也没问题哈,这里纯了SFT),只不过数据从原始通用数据,现在变成了带<think>的数据,输出从原来的512,变成了4096甚至更长~

回归正题,前面说用API来进行数据蒸馏,主要是满血版需要的部署资源太多了,对于普通人来说可望而不可即,想做点实验,还是用免费API来的实在。

从无问芯穹的官方(https://docs.infini-ai.com/),登录之后,找到“模型广场”,就可以看到有哪些模型了。

然后,在API KEY管理的地方,创建个key就可以了。

调用方式,就跟openai一样,接口是兼容的,只不过将url换成https://cloud.infini-ai.com/maas/v1即可。

结果:

关于数据蒸馏的操作,也比较简单,就是将你准备好的prompt或者试题,先调用DeepSeek-R1模型生成Response,如果需要保证生成数据的质量,可以对数学题数据进行Math-Verify工具验证一下(前提是有答案),或者再利用其他模型校验一下答案,给个分数。之前也有一些数据筛选、过滤的方法,可以参考。

- 指令微调数据的高效筛选方法-CaR(排序&聚类)

- DEITA-大模型指令微调的数据高效筛选方法

- 高质量指令数据筛选方法-MoDS

- 如何从数据集中自动识别高质量的指令数据-IFD指标的使用

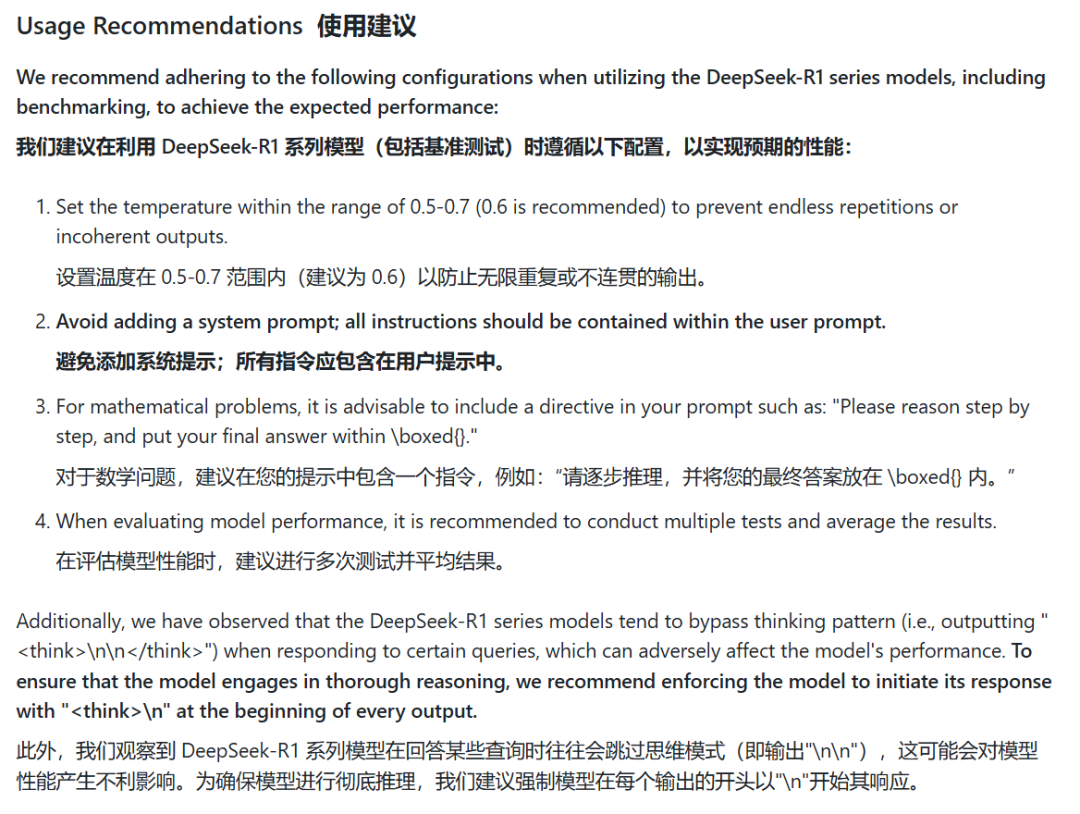

万变不离其宗,搞数据,多搞数据,多搞高质量数据,但是使用r1时也有一些注意的内容,官方Github也有提供。

下面是我用GSM8K_zh中一个样本造的数据结果,如下:

顺便说一下,现在也有一些开源的蒸馏r1的数据,但基本上都是英文数据,由于个人做中文场景较多,所以需要自己蒸馏一些中文数据来提高模型效果~

因为无问芯穹的接口跟openai一样,接口是兼容的,所以比如正常对话用chatbox、代码上对接cursor、vscode都是直接url+key替换就行。

本文转载自 NLP工作站,作者: 刘聪NLP