综述 DeepSeek R1、LIMO、S1 等 6 篇文章的关键结论

一、背景

上一篇文章中我们具体介绍了 DeepSeek R1 系列模型的构建流程和关键技术点,考虑到最近出现了许多相关工作,也分别得出了各种不同的结论,与此同时还出现了大量的误解。本文中,我们整理了 DeepSeek R1 等 6 篇 Reasoning 相关文章的关键结论,以便相互验证和对比。

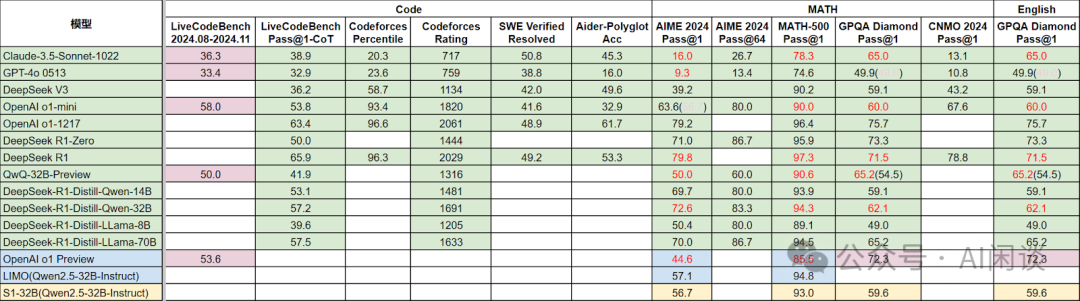

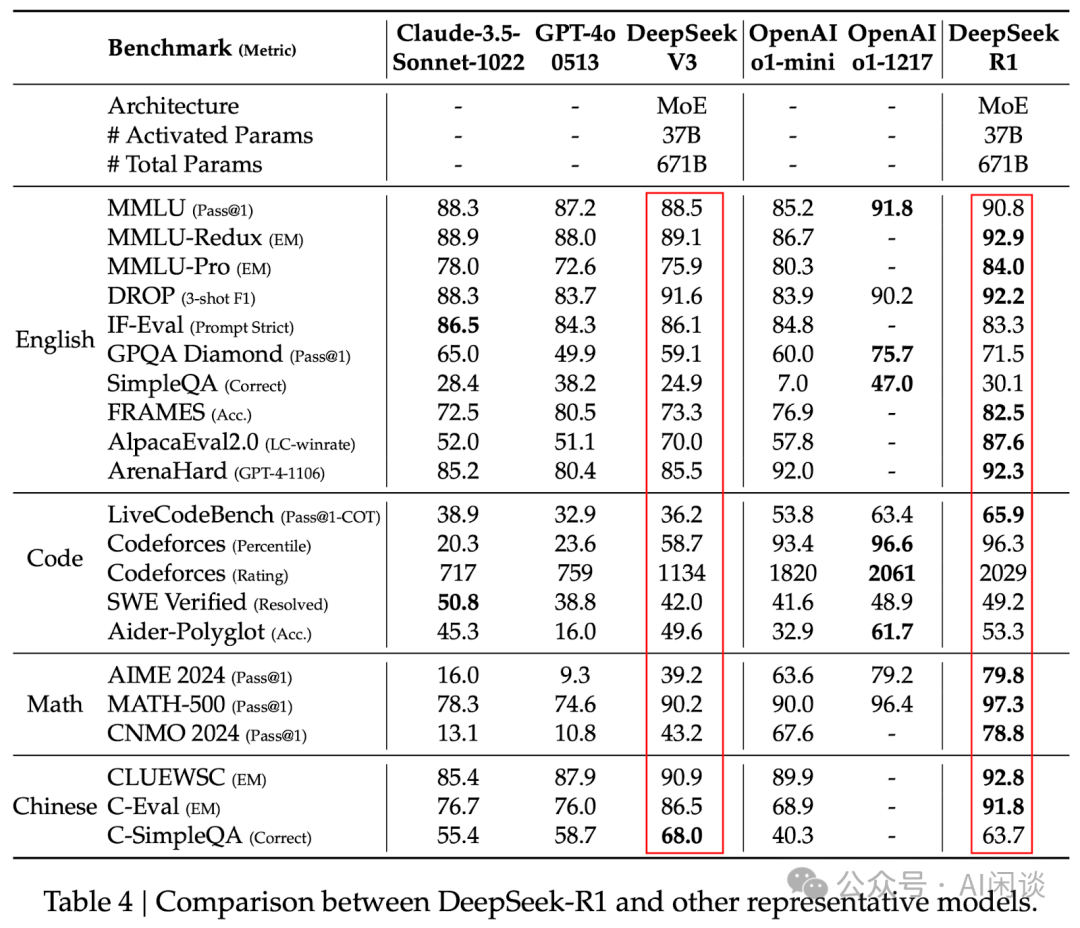

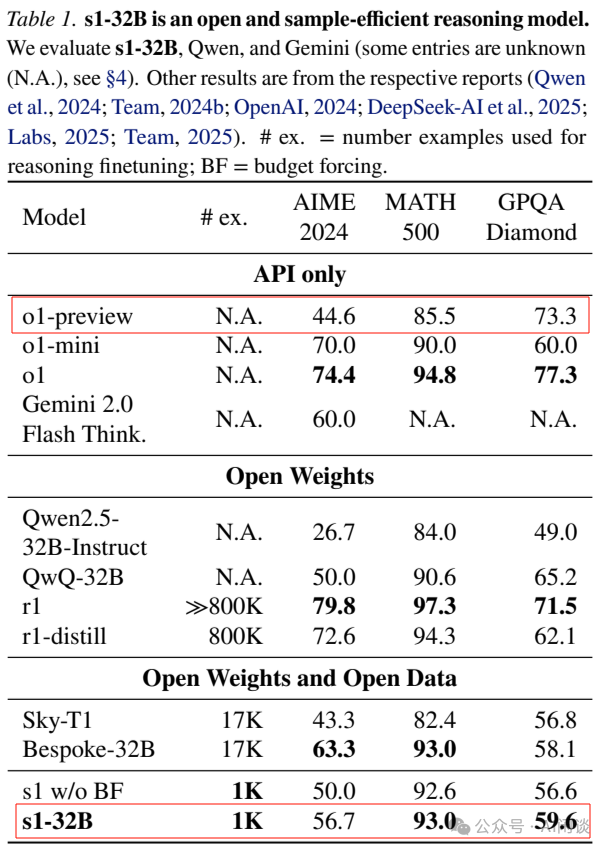

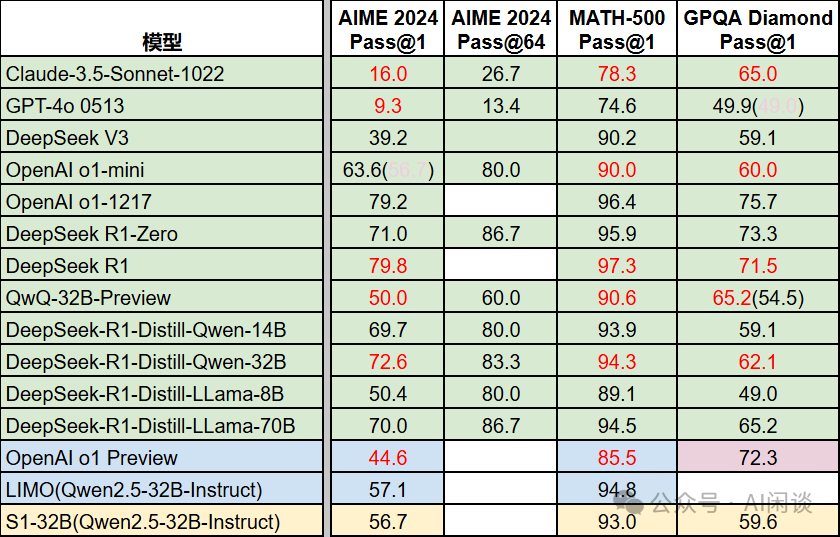

如下图所示为这些文章中的一些关键指标:

相关工作可以参考我们之前的文章:

- DeepSeek R1 论文解读&关键技术点梳理

- DeepSeek V3 详细解读:模型&Infra 建设

- Dynasor:针对 Reasoning 场景的 LLM Inference 优化系统

- Speculative Rejection:高效 Best-of-N 数据生成,16-32 倍加速

- LLM 推理系统之 MicroServing 框架

- 幻方 AI DeepSeek 模型背后的万卡集群建设

二、引言

2.1 顿悟时刻(Aha Moment)和长思维链(Long CoT)

顿悟时刻:通常指模型的自我反思和策略调整能力;表现为非线性的认知跳跃,通过模式识别或启发式策略突然抓住问题关键,类似于人类的“灵光乍现”。

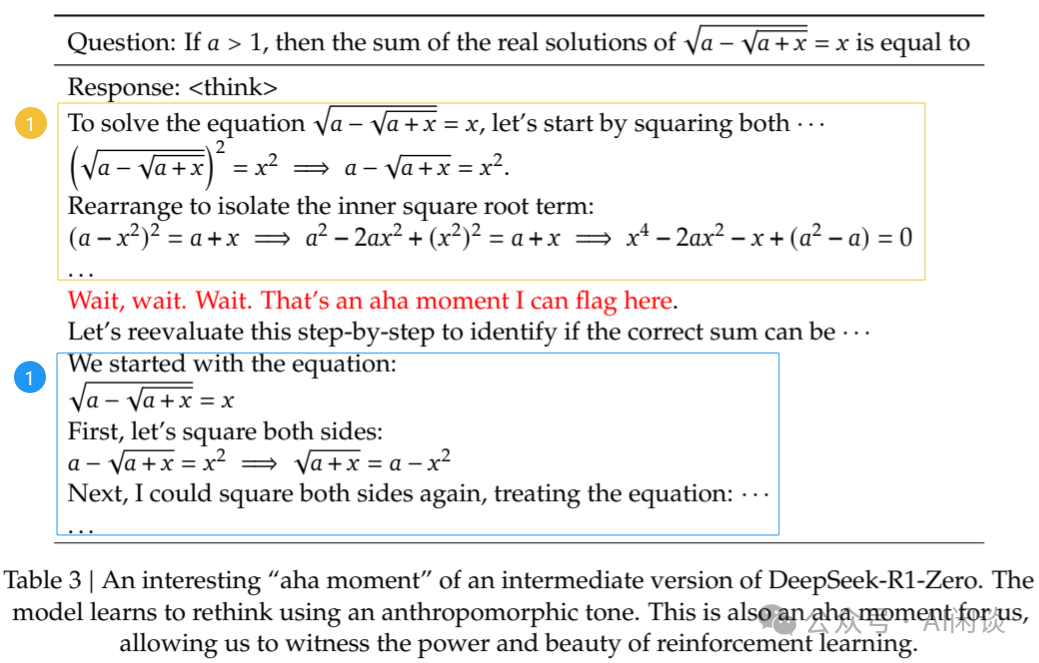

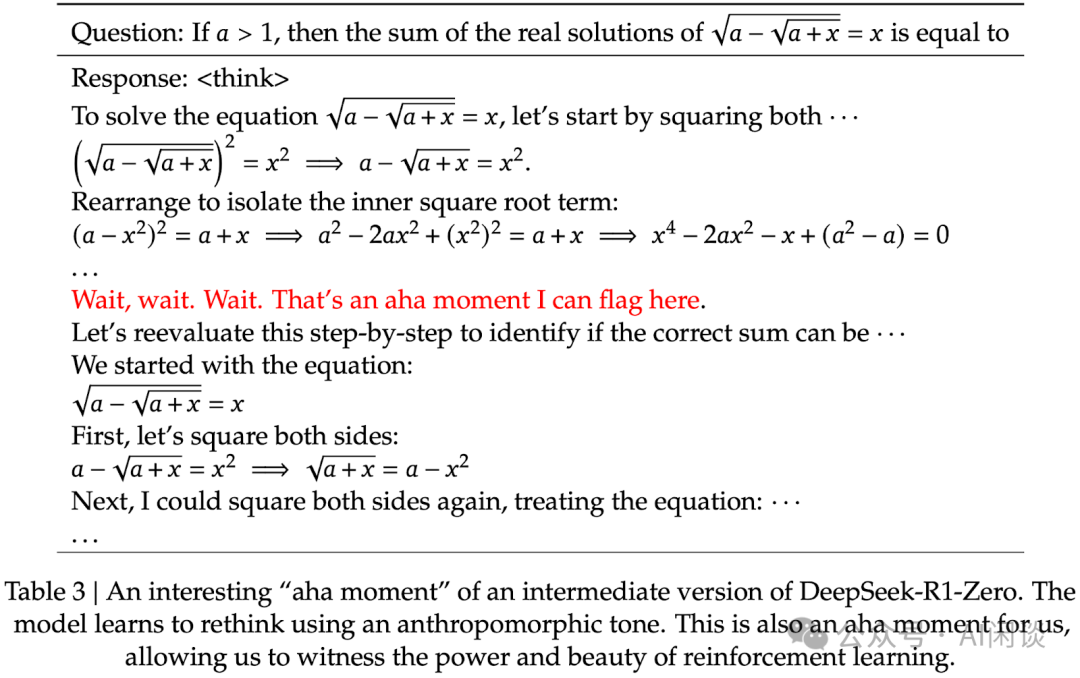

如下图 Table 3 所示,DeepSeek-R1-Zero 训练中出现的 Aha Moment(“Wait, wait. Wait. That’s an aha moment I can flag here.”)。两个框之间的位置,模型进行反思,并在蓝色框的位置重新评估其初始方法,学会为问题分配更多的思考时间:

长思维链:通常指模型在解决复杂问题时,能够生成一系列中间推理步骤,展现出的更深层次的思考能力;强调线性、逐步的推理过程,类似于人类在思考时的推理过程;通过显式中间结果可以降低错误传播风险,但计算成本较高。

如下图 Figure 5 所示,其中红框为问题,绿框为长思维链,橙框为结果:

三、DeepSeek R1

3.1 引言

我们之前的文章中详细介绍过 DeepSeek R1 论文,这里简单汇总一下,以便引出后续文章。

对应的论文为:[2501.12948] DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning [1]

3.2 DeepSeek R1-Zero

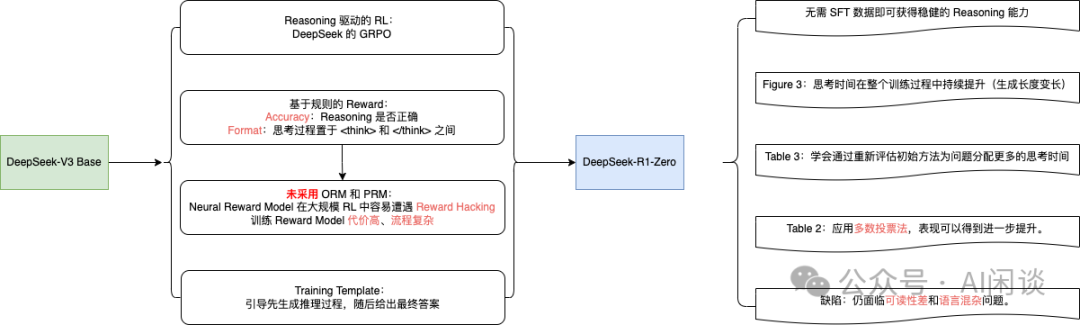

即便不采用 SFT 作为冷启动,通过大规模 RL 也能显著增强模型的 Reasoning 能力。缺陷是可能存在可读性差和语言混杂等问题。

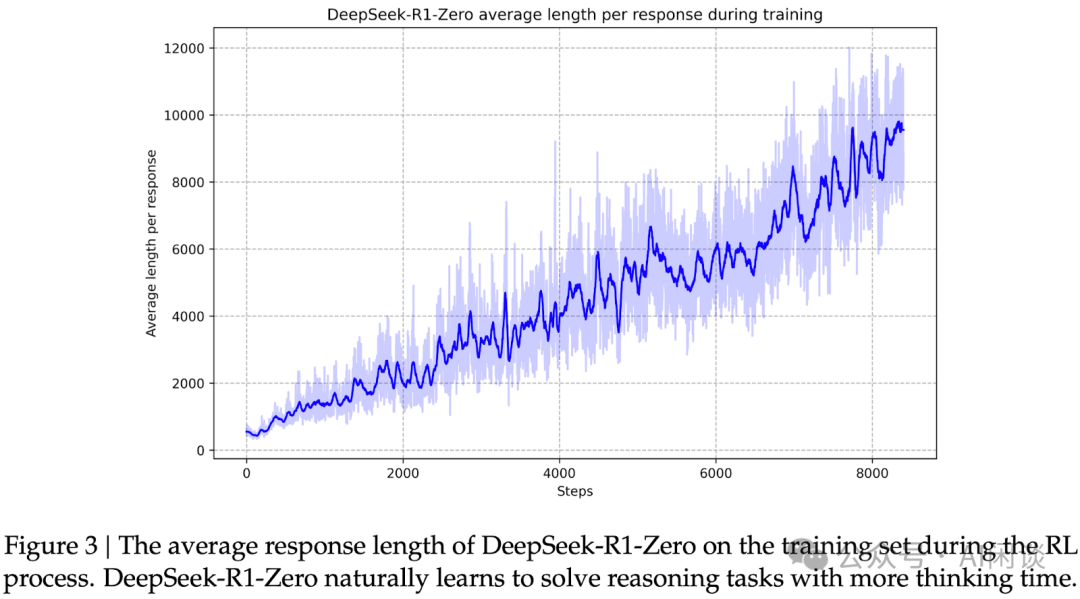

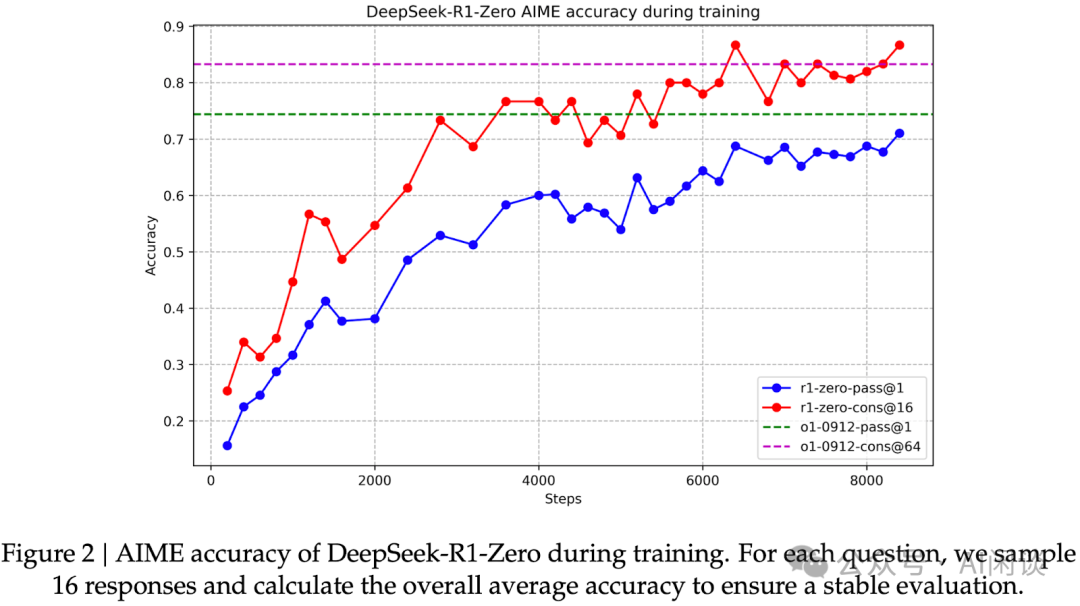

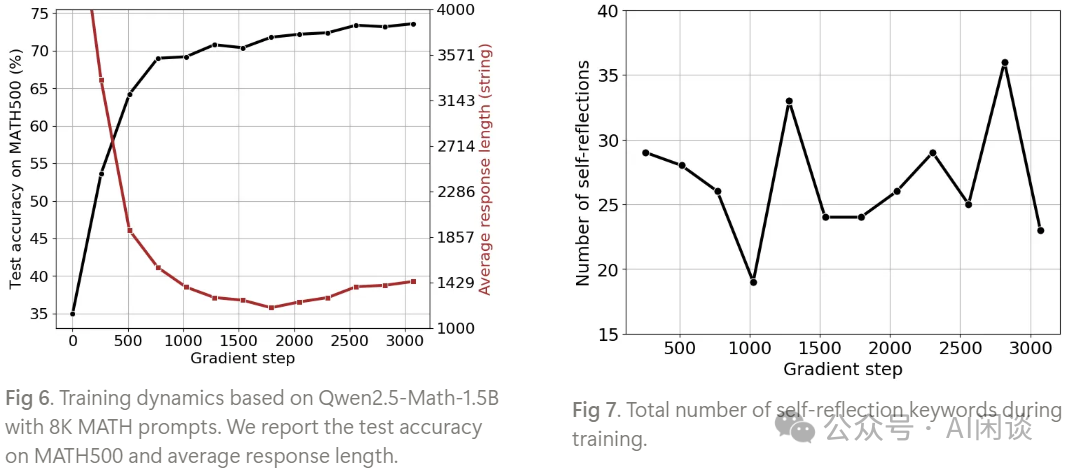

如下图 Figure 3 所示,DeepSeek-R1-Zero 的思考时间在整个训练过程中持续提升(生成长度逐渐变长)。如下图 Figure 2 所示,AIME Accuracy 指标也逐渐提升。DeepSeek-R1-Zero 通过利用更长的测试时间计算,自然而然地获得了解决日益复杂 Reasoning 任务的能力,比如反思的能力。(PS:后面的文章也表明基础模型也具备一定的反思能力)

Aha Moment:DeepSeek-R1-Zero 在训练中出现了 “aha moment”。如下图 Table 3 所示,这一时刻出现在模型的中间版本阶段。在此阶段,DeepSeek-R1-Zero 学会通过重新评估其初始方法,为问题分配更多的思考时间。(PS:后面文章表明,基础模型也有 Aha Moment)

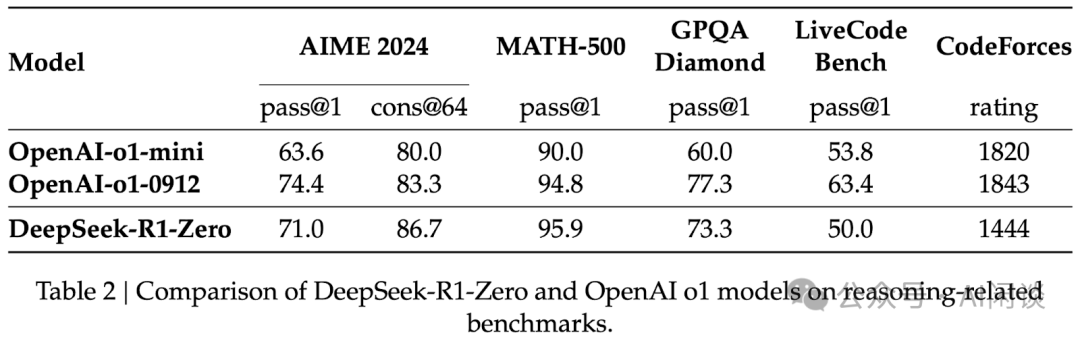

多数投票:通过应用多数投票法,DeepSeek-R1-Zero 的表现可得到进一步提升。例如,如下图 Table 2 所示,在 AIME 基准测试中采用多数投票后,其性能从 71.0% 跃升至 86.7%,从而超越 OpenAI-o1-0912。

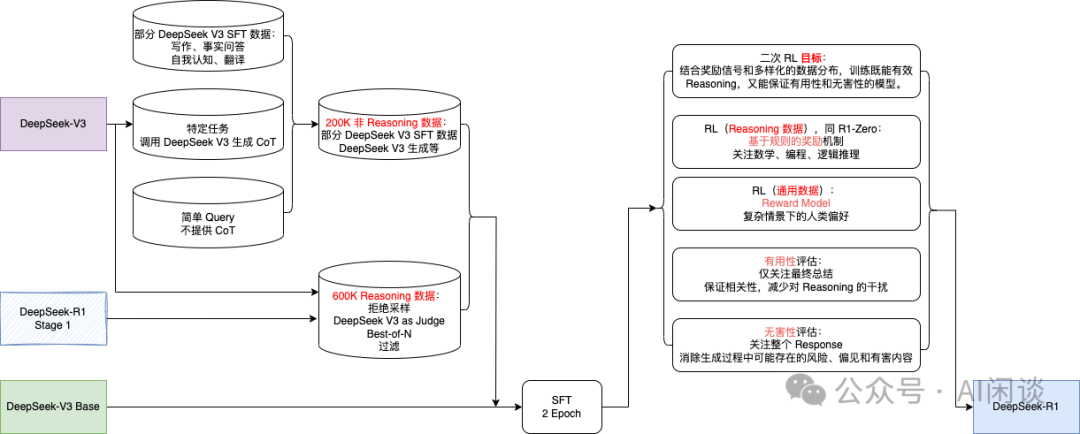

3.3 DeepSeek R1

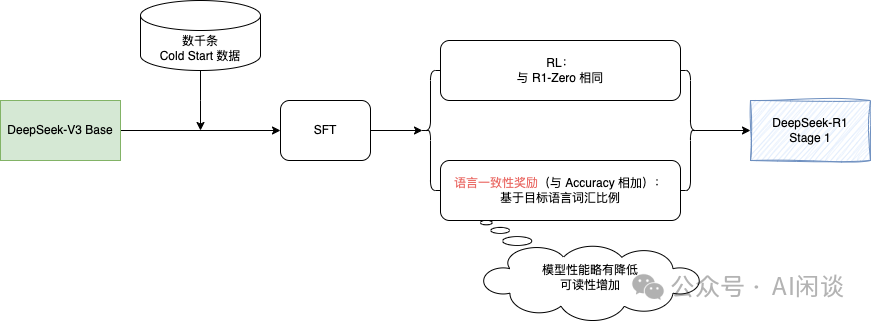

DeepSeek R1 经历了两轮的 SFT+RL。其中第一轮主要聚焦在提升 Reasoning 能力,特别是在编程、数学、科学及逻辑推理等具有明确解决方案的问题上。此外,在 RL 训练中引入了语言一致性奖励,以便解决 CoT 常出现语言混杂现象(尤其是在 RL 提示涉及多种语言时)。

除了更好的 Reasoning 数据外,此阶段还整合了来自其他领域的非 Reasoning 数据,以增强模型在写作、角色扮演及其他通用任务上的能力。此外,进一步提升模型的有益性与无害性,同时精进其 Reasoning 能力。

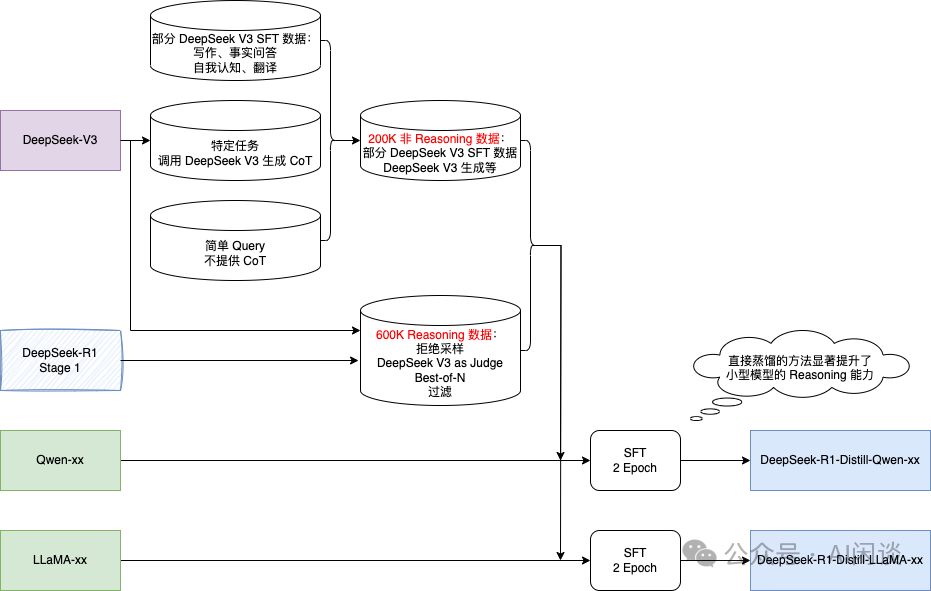

3.4 DeepSeek R1-Distill-xx

直接蒸馏的方法(包含大模型生成的数据进行 SFT)也可以显著提升了小型模型的 Reasoning 能力。

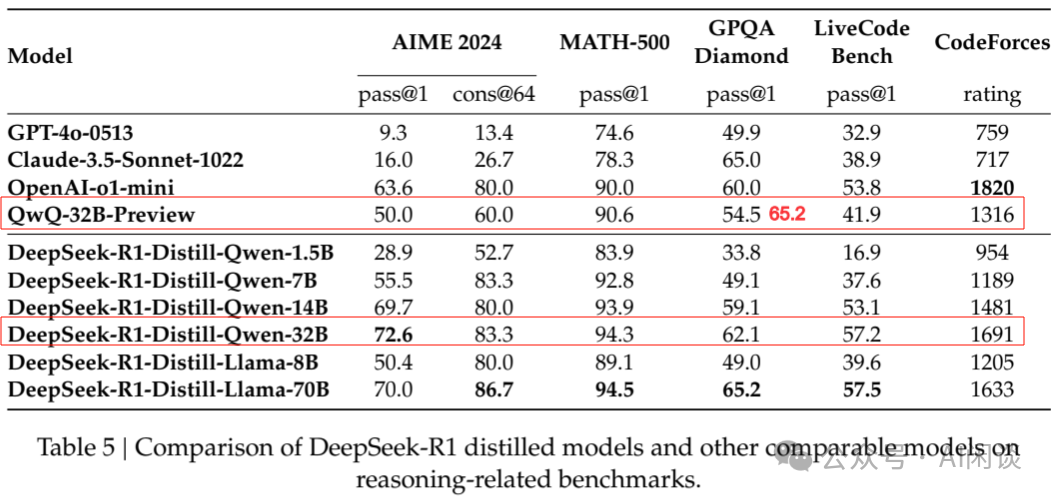

如下图 Table 5 所示,蒸馏的 Qwen-32B 在 Reasoning 能力上优于 Qwen 官方的 QwQ-32B-Preview(图中红色数字是与 QwQ-32B-Preview Blog 未对齐的数据,参考 QwQ: Reflect Deeply on the Boundaries of the Unknown | Qwen [2])。

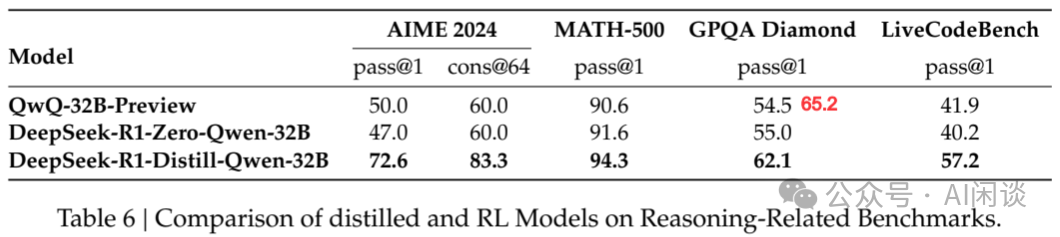

3.5 蒸馏(Distill)与强化学习(RL)

上面提到,仅通过蒸馏 DeepSeek-R1 或者 RL 都可以使模型取得不错的 Reasoning 能力,那么这两者孰优孰劣呢?如下图 Table 6 所示,作者基于 Qwen-32B-Base 进行了实验,可以看出,仅通过 RL 使得 Qwen-32B-Base 获得了与 QwQ-32B-Preview 相当的 Reasoning 能力,但依旧远差于蒸馏的方案。可以得出两点结论:

- 将更强大的模型蒸馏至较小规模能带来卓越效果,而依赖本文所述大规模 RL 的小型模型不仅需耗费巨大计算资源,且可能无法企及蒸馏所达到的性能水平。

- 尽管蒸馏策略兼具经济性与高效性,但欲突破智能边界,仍需依赖更强大的基础模型与更大规模的 RL 训练。

四、LIMO:Less is More for Reasoning

4.1 引言

从 DeepSeek-R1 结论可知,要想提升小规模模型的 Reasoning 能力,使用强大的模型进行蒸馏是最简单和经济的方案。这里的 LIMO 和后面的 S1 都属于这个范畴,只不过是聚焦在怎样使用更少的数据进行蒸馏。

LIMO 对应的论文为:[2502.03387] LIMO: Less is More for Reasoning [3]

LIMO 对应的代码库为:GAIR-NLP/LIMO: LIMO: Less is More for Reasoning [4]

4.2 数据规模&质量

作者通过多个步骤精心设计了高质量的 Reasoning 数据,具体包括:

- 从 NuminaMath-CoT(专注于数学推理的思维链数据集)、AIME(跨多个数学领域的极高难度和综合性)、MATH(各类数学竞赛题)等多个权威数据集汇集成数千万候选题库(PS:不确定是怎么从这些数据源汇集出数千万个问题的?)。

- 使用 Qwen2.5-Math-7B Instruct 进行基础难度筛选,排除几次尝试就能解答的问题。

- 使用 R1、DeepSeek-R1-Distill-Qwen32B 等模型,仅保留多次尝试成功率低于阈值的问题。

- 抽样,确保题库多样性。平衡各数学领域、复杂度,同时避免概念上的重复。最终得到 817 个问题(仅包含英文)。

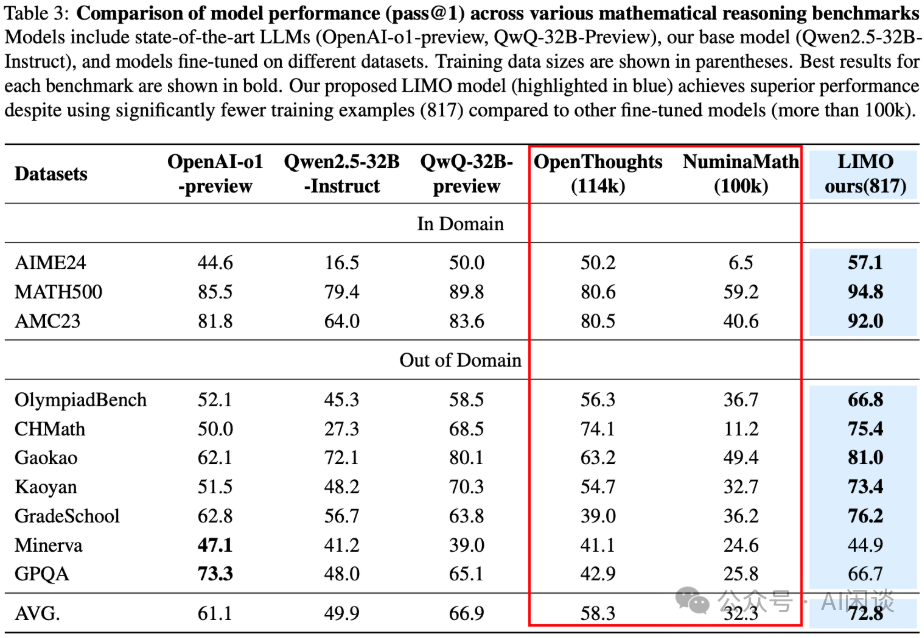

仅用这 817 个精心挑选的高质量数据,通过 SFT 就可以激发模型的 Reasoning 能力,超越使用 10 万条非精心挑选数据训练的模型。(这里是对 Qwen2.5-32B-Instruct 模型进行的 SFT)

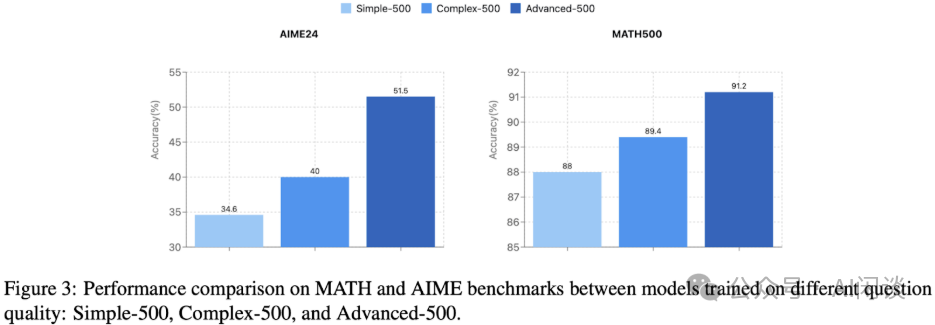

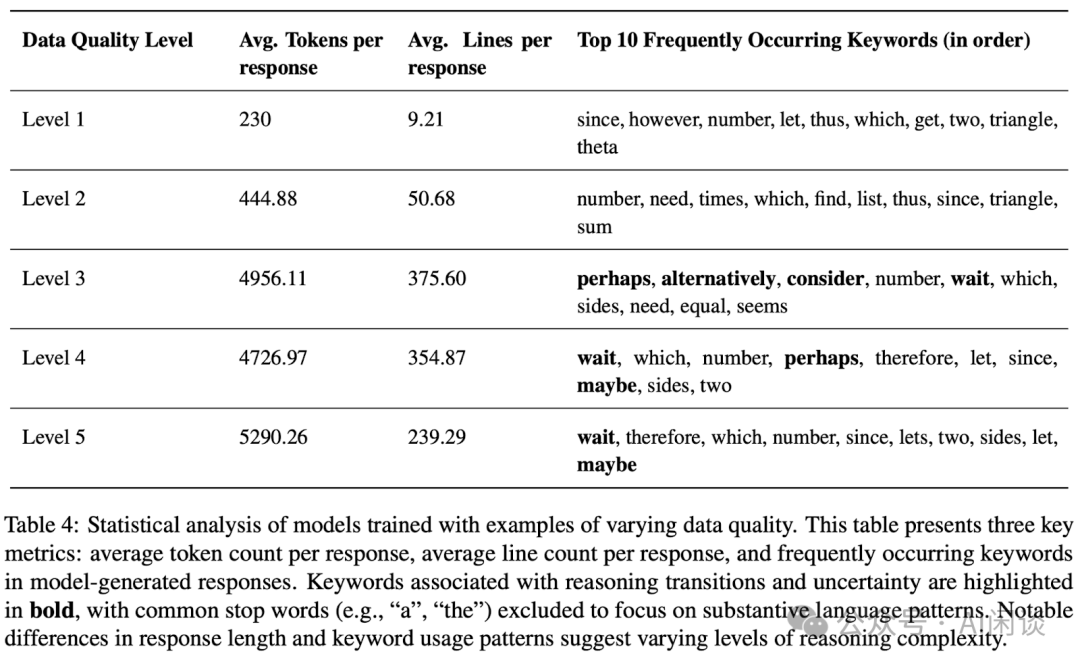

如下图 Figure 3 所示,作者也进一步探索了不同难度等级数据对 Reasoning 能力的影响,可以看出,数据难度越高,对模型的提升越明显。

其中 Simple-500 来自 MATH 中的 Level 1 和 Level 2;Complex-500 来自 MATH 的 Level 3、4、5;Advanced-500 来自 AIME 的数据。

这也说明,如果基础模型已经压缩了足够的知识,那么只需少量高质量 Reasoning 数据就可以激活模型的 Reasoning 能力。这也是论文摘要中“挑战了海量数据要求的假设”的来源。

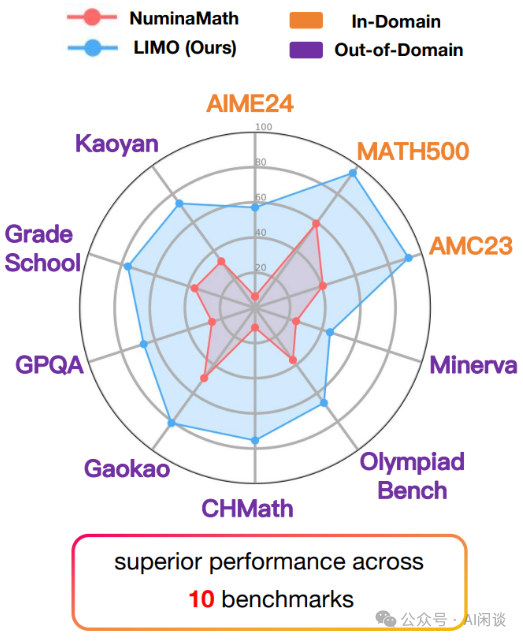

4.3 泛化能力

LIMO 模型在多个不同的基准测试中表现出色,涵盖了数学和多学科 Reasoning 任务,这些测试任务在问题类型、难度和领域上都有显著差异,例如:

- AIME24 和 MATH 是竞赛级别的数学 Reasoning 任务。

- OlympiadBench 是奥林匹克数学测试,具有更高的难度和复杂性。

- CHMath 是中文数学测试,Gaokao 和 Kaoyan 是大学、研究生入学考试,涉及不同的语言和文化背景。

- GradeSchool 是小学数学 Reasoning 任务,难度较低但需要模型具备基础的 Reasoning 能力。

- Minerva 和 GPQA 是多学科 Reasoning 任务,涉及 STEM 等多个领域的知识。

其中 AIME24、MATH500、AMC23 都属于 In-Domain 任务,其他任务属于 Out-of-Domain 任务;此外 817 训练集都是英文数据,这些基准测试中也有中文数据。这也是摘要中“挑战了 SFT 主要导致记忆而不是泛化”的来源。

PS:如果从任务的角度考虑,确实能证明 SFT 具备一定的泛化能力;但是,如果从能力的角度考虑,这些任务的提升还都和 Long CoT Reasoning 密切相关,并不能表明 SFT 激发了其他新的能力。因此对于 “挑战了 SFT 主导记忆而不是泛化” 这一结论仍需更多的探讨。

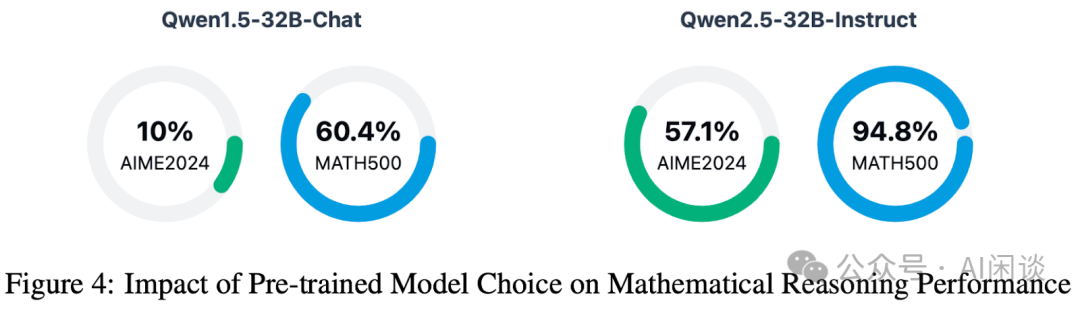

4.4 基础模型选择

如下图 Figure 3 所示,作者也进一步通过实验表明,基于 Qwen2.5-32B-Instruct 构建的 LIMO 在两个基准测试中均显著超越 Qwen1.5-32B-Chat。这也表明,基础模型的选择至关重要,模型的 Reasoning 能力很大程度上依赖基础模型参数空间中所拥有的预训练知识。

五、S1:Simple test-time scaling

5.1 引言

这篇论文受到广泛关注和讨论,更多是因为很多媒体的标题(“李飞飞团队 50 美元炼出 DeepSeek R1”)很容易引起误解。这其实和之前大家对 “550 万美金训练 DeepSeek V3” 的误解类似。实际上这些成本说的都是发布的模型真实训练的 GPU 小时数 * 每 GPU 每小时的租赁成本。这一数据并不包含集群购买和建设以及模型的探索和试错成本。

S1 对应的论文为:[2501.19393] s1: Simple test-time scaling [5]

S1 对应的代码库为:GitHub - simplescaling/s1: s1: Simple test-time scaling [6]

5.2 数据规模和质量

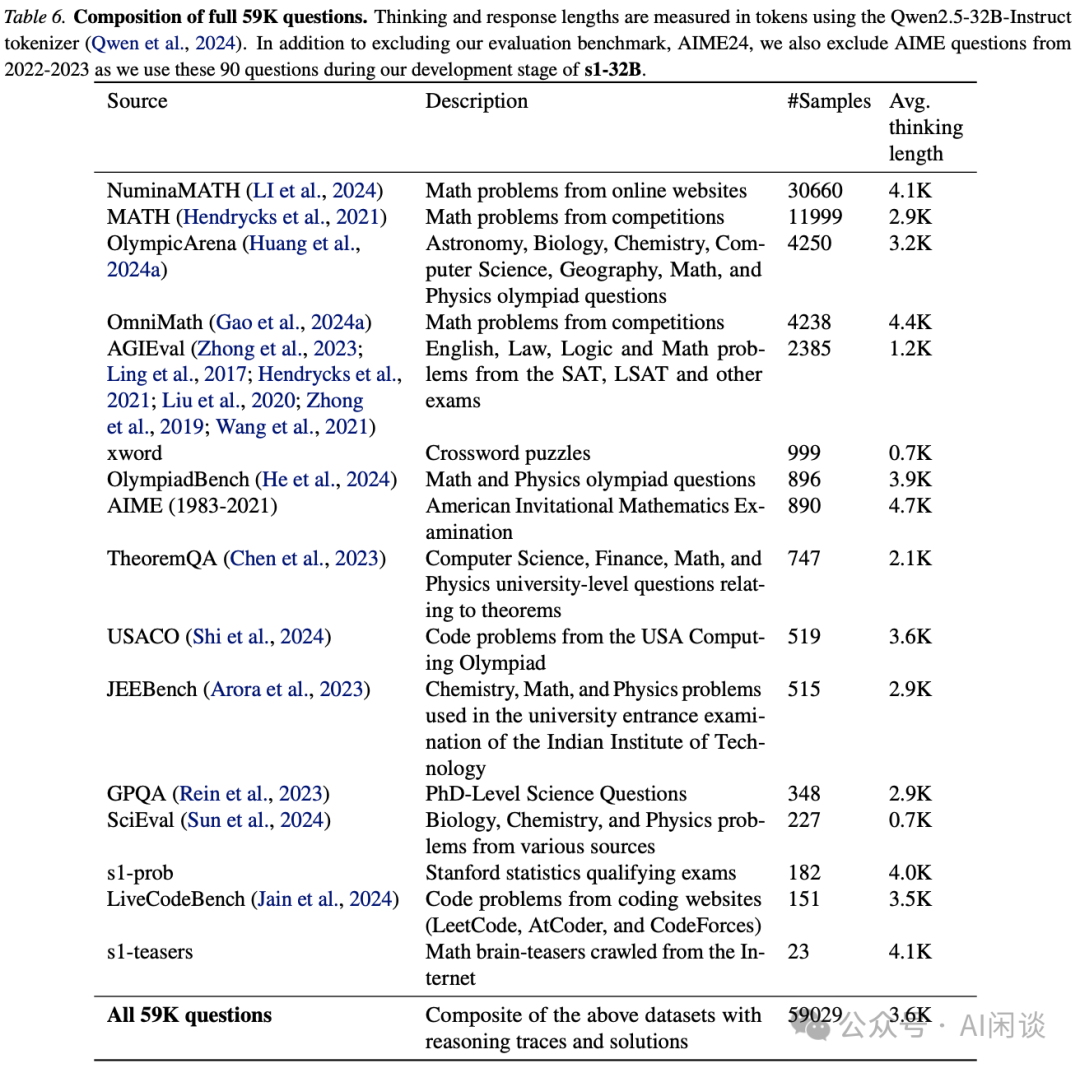

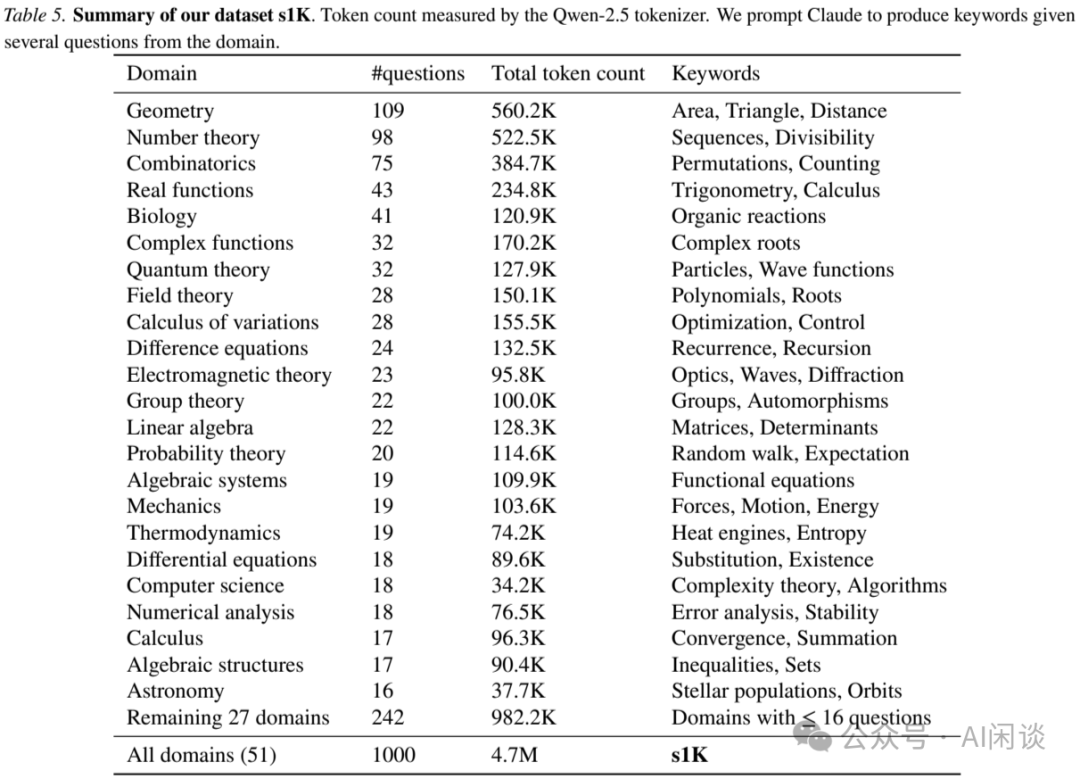

作者同样是首先从如下 Table 6 所示的 16 个多样化数据源收集了 59,029 个问题:

针对每个问题,都使用 Google Gemini Flash Thinking API 生成 Reasoning 轨迹与答案,提取其推理过程和响应。之后,作者对上述 59K 数据从质量(Quality)、难度(Dificulty)、多样性(Diversity)三个维度进行筛选,最终挑选出 1000 个样本,构成 s1K,具体分布如下图 Table 5 所示,可以看出,平均每个问题的 Token 数达到 4K 以上:

如下图 Table 1 所示,使用上述数据对 Qwen2.5-32B-Instruct 进行 SFT,可以大幅提升模型的 Reasoning 能力,甚至超越 OpenAI o1-Preview:

从我们收集汇总的数据也可以看出,本文的 s1-32B 离 DeepSeek R1、OpenAI o1 都还有较大差于,甚至与同样是蒸馏 SFT 的模型 DeepSeek-R1-Distill-Qwen-32B 和 DeepSeek-R1-Distill-LLama-70B 也有一定差距:

基于此再去看如下图所示这种宣传 “训练 1000 样本就能超越o1”、“媲美 o1 和 R1” 是多么的离谱:

5.3 测试时扩展(Test-time Scaling)

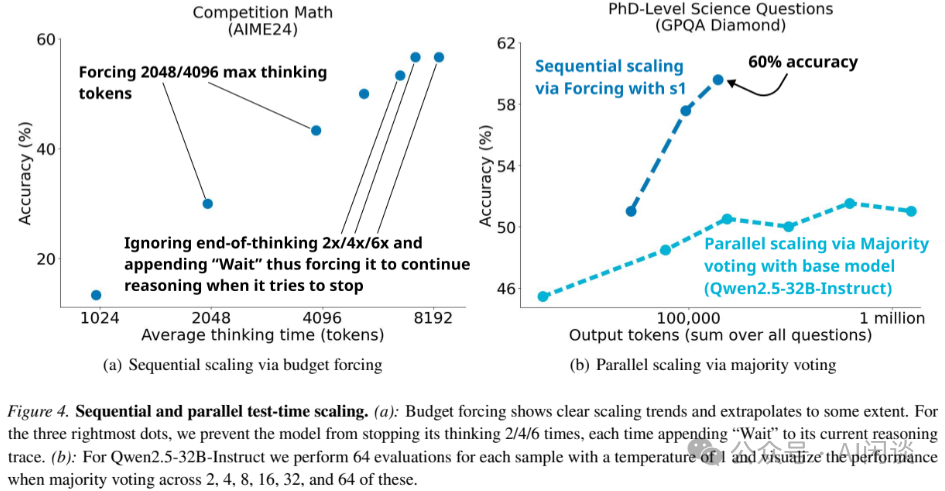

本文中,作者也提出了预算强制(Budget Forcing)来控制 Test-time 计算(序列长度)的方案,具体来说:在模型试图结束时引入 “Wait” 来延长模型的思考时间,或者思考太多时强制终止思考过程。除此之外,作者还探索了两种不同扩展方案的影响:

- Sequential Scaling:在一次生成中扩展思考过程、序列长度。

- Parallel Scaling:同一样本多次生成,投票选举。

结果如下图 Figure 4所示:

- (a)Sequential Scaling:Budget Forcing 显示出清晰的扩展趋势,通过扩展 Test-time 预算,可以有效提升在 AIME24 基准上的精度。

- (b)Parallel Scaling:对于 Qwen2.5-32B-Instruct,通过多数投票同样可以提升在 GPQA Diamond 基准上的精度,但是依然无法超过使用Budget Forcing 的 S1 模型。这也验证了作者的直觉,即Sequential Scaling 比 Parallel Scaling 更为有效。

六、Oat-Zero

6.1 引言

Sea AI Lab 团队在一篇 Blog 中研究了 DeepSeek R1 中提到的顿悟时刻。

对应的 Blog 为:https://oatllm.notion.site/oat-zero [7]

对应的代码库为:https://github.com/sail-sg/oat-zero [8]

6.2 顿悟时刻出现在预训练中

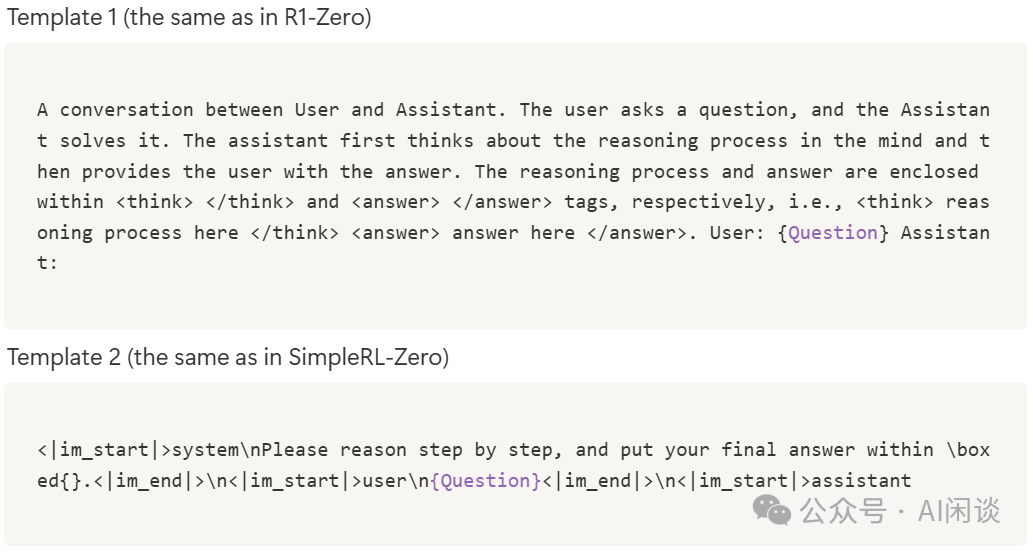

作者使用如下两个模板,并使用 MATH 训练集中的 500 个问题填充模板,然后使用填充后的 Prompt 直接输入基础模型,并根据不同的关键字提取顿悟时刻:

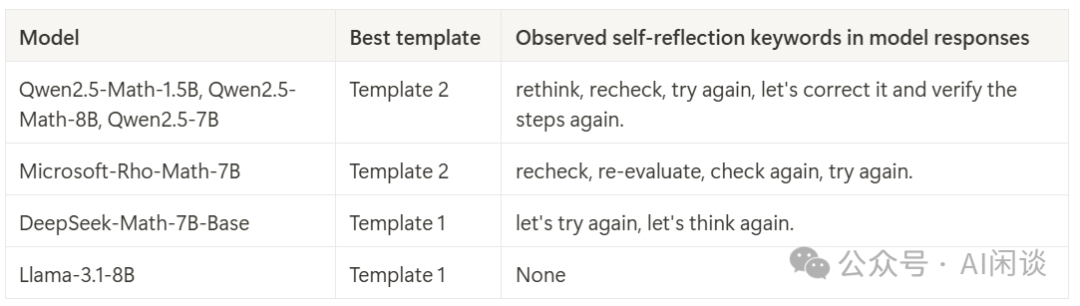

如下所示为针对不同基础模型的 Response 中提取到的自我反思关键词,可以看出,除了 LLaMA-3.1-8B 模型,其他基础模型(Epoch 0 )均表现出了自我反思:

如下图 Fig 1a 所示,在不同的 Temperature 下均能发现自我反思现象,趋势是 Temperature 越高,自我反思数量越多。如下图 Fig 1b 所示,Qwen 系列模型产生自我反思的数量最多,这也验证了开源 R1-Zero 复现都采用 Qwen2.5 模型的合理性。

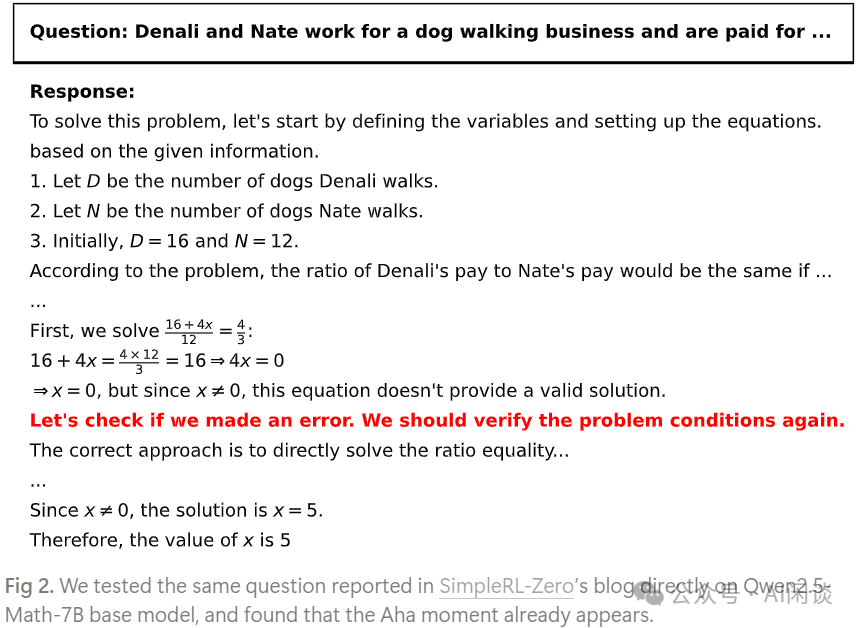

如下图 Fig 2 所示为其中自我反思的示例:

6.3 浅层的自我反思(Superficial Self-Reflection,SSR)

SSR 定义:指模型 Response 中缺乏建设性修正或改进的再评估模式。与未进行自我反思的 Response 相比,SSR 未必能产生更优的答案。

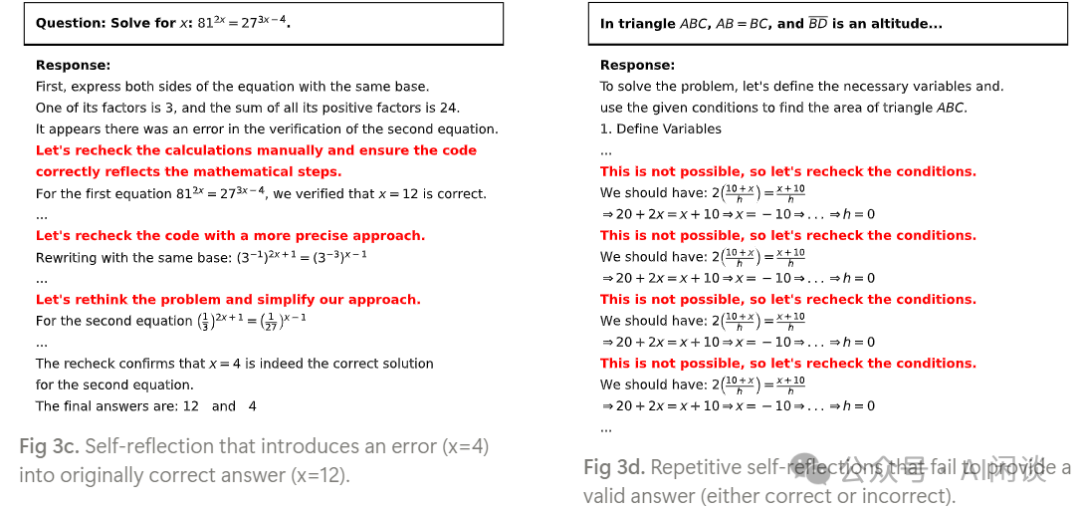

作者探究了 Qwen-2.5-Math-7B 中的 4 种自我反思模式:

- 模式 1:自我反思——反复检查以确定正确答案。

- 模式 2:自我反思——修正最初错误的思路。

- 模式 3:自我反思——在原本正确的答案中引入错误。(Fig 3c)

- 模式 4:反复自我反思——最终未能得出正确答案。(Fig 3d)

如上的模式 3(如图 Fig 3c) 和 模式 4(如图 Fig 3d)最终都未得到正确答案,属于 SSR:

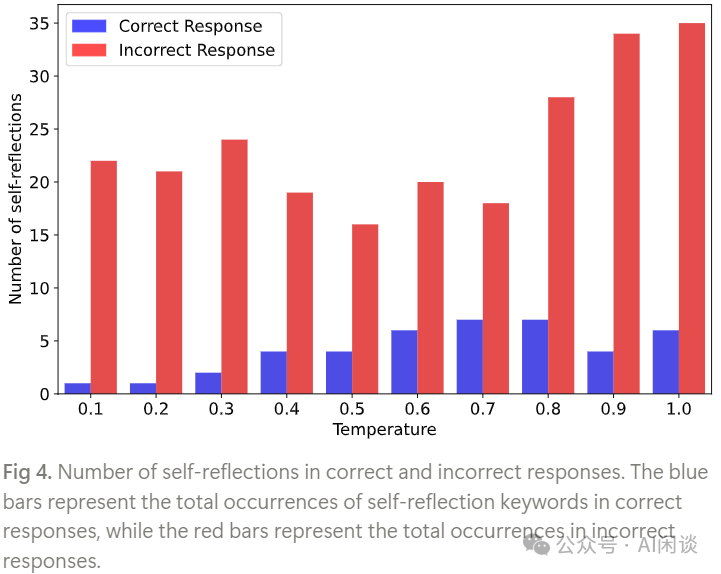

如下图 Fig 4 所示,作者进一步分析了 Qwen-2.5-Math-1.5B 中正确和错误答案中自我反思关键词出现的数量。可以看出,在不同的 Temperature 下,大部分自我反思都没有得到正确答案,表明基础模型容易产生 SSR。

6.4 类 R1-Zero 训练

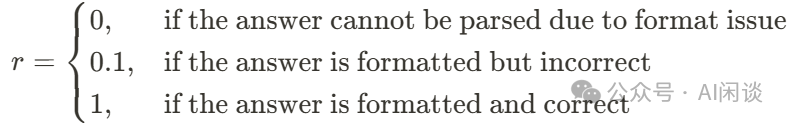

作者使用 Oat 框架,用 GRPO 算法在 Countdown(给定 3 到 4 个数字,要求使用算法运算 +、-、x、÷ 来生成目标等式,如下图所示,其需要模型具备自我反思,不断尝试以得到答案) 任务上对 Qwen-2.5-3B 基础模型进行 RL 训练。

如下图 Figure 5 右图所示,Reward 持续增加,而生成长度先减少后增加。此外,作者根据 Reward 将模型 Response 分为 3 个不同的组,如下图 Figure 5 左图所示:

- 88 Step 之前主要以 Format Reward(r=0.1)为主。

- 88 Step 之后,模型开始使用更多的重试,朝着更高 Reward(r=1)演进,相应的 Response 也开始激增。

- 实验表明:整个 RL 过程的目标是将原来浅层的自我反思转换为有效的自我反思,并最大化预期 Reward,从而提升 Reasoning 能力。

此外,作者也通过实验表明,仅凭输出长度可能不足以作为模型自我反思能力的可靠指标。

七、Demystifying Long CoT Reasoning

7.1 引言

本文作者聚焦于 Long CoT Reasoning 能力的机制,并探索了 SFT 和 RL 对 Long CoT 的影响。

对应的论文为:[2502.03373] Demystifying Long Chain-of-Thought Reasoning in LLMs [9]

7.2 SFT 和 RL 对 Long CoT Reasoning 的影响

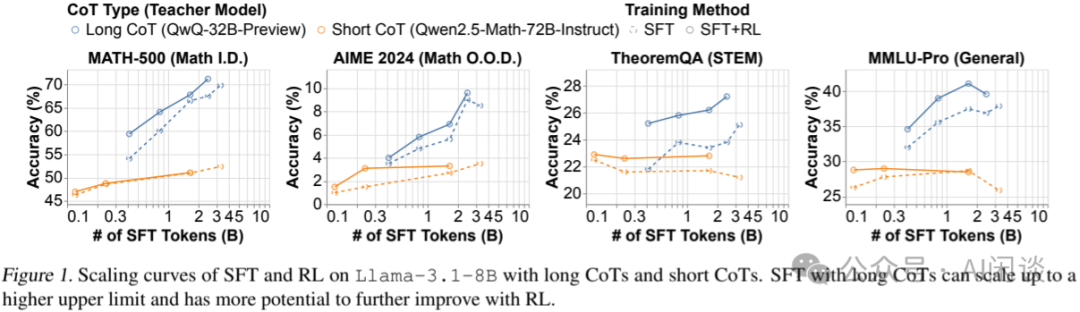

如下图 Figure 1 所示,实验结果表明:

- Long CoT SFT 可以显著提升模型的 Reasoning 能力,并且随着 SFT 数据量的增加,性能逐渐提升。(PS:对应蓝色线)

- Shot CoT SFT 也可以提升模型的 Reasoning 能力,但是很容易达到饱和。(PS:对应橙色线)

- 使用Long CoT SFT 初始化的模型可以进一步提升 RL 训练的表现;而Short CoT SFT初始化的模型对 RL 训练几乎没有帮助。(PS:对应实线和虚线的间隔)

如下图 Table 4 表明:

- SFT 和 RL 都能提升 Reasoning 能力。

- 使用 QwQ-32B-Preview 中蒸馏出来的 Long CoT 进行 SFT 获得了优于直接 RL 的性能。

- 对SFT 的模型进行 RL 能进一步提升性能。

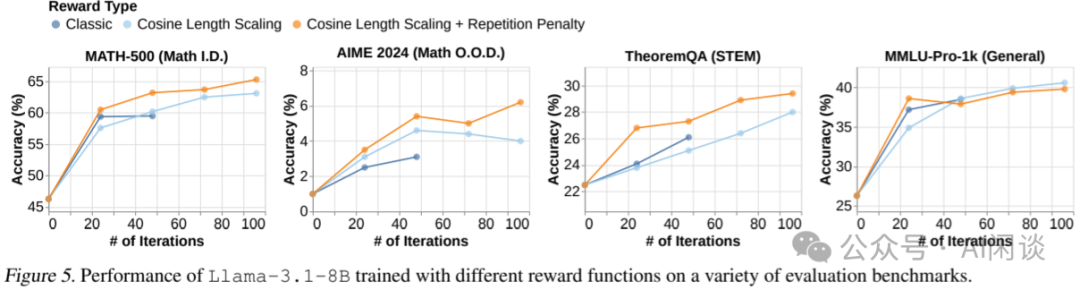

7.3 长度奖励的滥用

近期关于 Long CoT 的研究表明,随着思考时间的增加,模型在 Reasoning 任务中的性能自然提升,并且在 RL 训练下倾向于延长 CoT 的长度,但这一过程并不稳定,通过采用基于长度和重复惩罚的技术得以解决,从而稳定训练过程。

作者也观察到,在足够的训练计算资源下,模型开始出现 Reward Hacking 的迹象,即通过重复而非真正学会解决问题来增加其 CoT 的长度。通过实施简单的 N-gram 重复惩罚(Repetition Penality)机制,可以缓解这一现象。如下图 Figure 5 所示,通过添加重复惩罚(橙色),相比未添加(蓝色),模型在多个基准上都获得了更高的精度:

PS:上述结论也与 Oat-Zero 的结论相符:仅凭输出长度可能不足以作为模型自我反思能力的可靠指标。

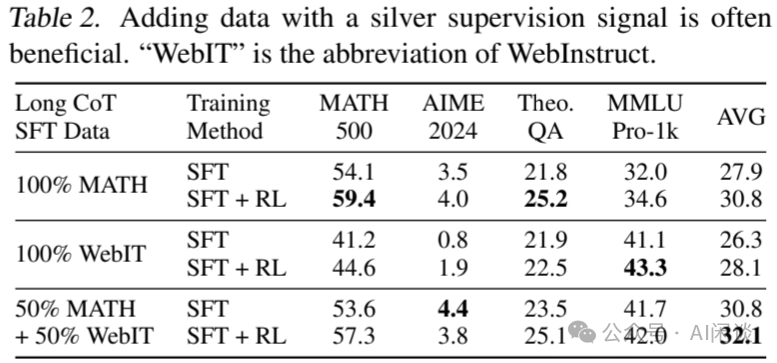

7.4 可验证奖励对 SFT 和 RL 的影响

如下图 Table 2 所示实验表明:

- 加入噪声数据(WebIT)可以提高模型在不同任务上的平均性能。

- 混合 MATH 和 WebIT 数据在 SFT 中表现最佳,但不同任务上表现可能不太一致。

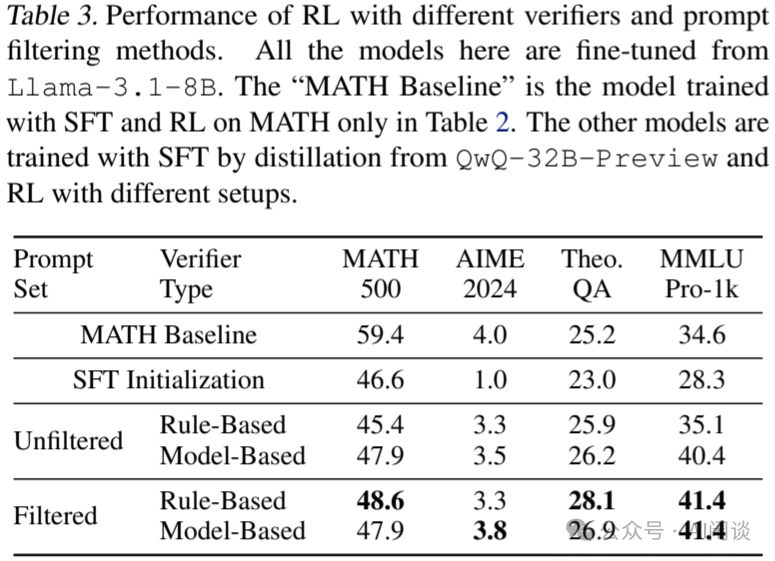

如下图 Table 3 所示实验表明:

- 使用基于规则的验证器在过滤后的数据集上进行 RL 训练效果最好,显著提高了模型在 OOD 任务上的性能。

- 在未过滤数据上使用基于规则的验证器效果最差,可能是因为数据中包含大量无法有效处理的自由形式答案。

- 基于模型的验证器在未过滤数据上的表现优于基于规则的验证器,但在过滤数据上的表现与基于规则的验证器相当。

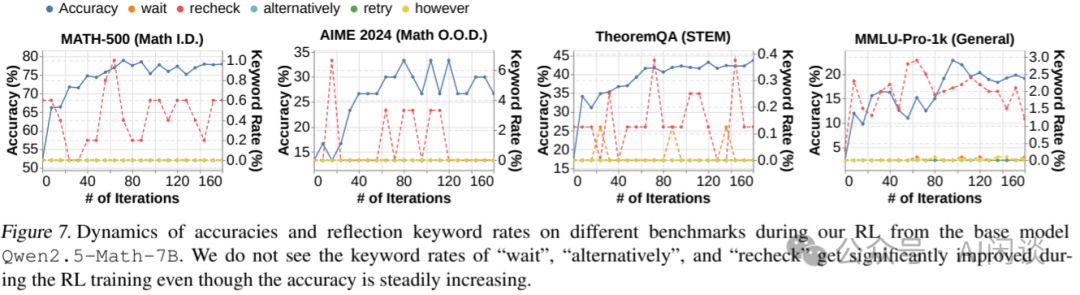

7.5 RL 对基础模型自我反思的影响

如下图 Figure 7 的实验表明,从基础模型开始的 RL 训练可以提高模型的 Reasoning 能力,但并不一定能激发自我反思模式(对应自我反思关键词)。(PS:也与上述 Oat-Zero 结论类似,RL 只是将浅层的自我反思转化为有效的自我反思,而不是激发自我反思?)

八、Google SFT Memorizes,RL Generalizes

8.1 引言

Google 的作者在本文中探讨了 SFT 和 RL 是否主导训练数据的记忆,并验证了其对模型泛化能力的影响。

对应的论文:[2501.17161] SFT Memorizes, RL Generalizes: A Comparative Study of Foundation Model Post-training [10]

8.2 评估基准

为了评估 SFT 和 RL 的效果,作者设计了两种基准测试。

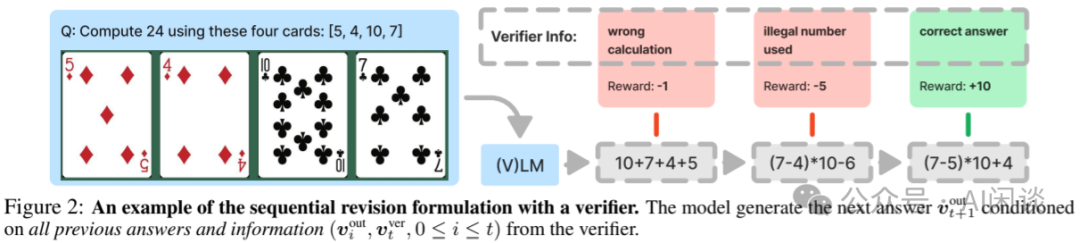

24 点纸牌基准(GeneralPoints):如下图 Figure 2 所示,给模型展示 4 张纸牌(文字描述或图像),模型需要用这 4 张牌上的数字,通过 +、-、x、/,凑出目标数字 24,并且每张牌只能使用一次。

- 规则变化:J、Q、K 都代表 10;或者 J、Q、K 分别代表 11、12、13。可以评估模型是仅仅记住了 JQK=10 还是理解了算术 Reasoning 的原理。

- 视觉变化:也可以将牌的颜色作为变体。训练中使用一种颜色,评估中使用其他颜色做 OOD 测试。

虚拟城市导航(V-IRL):如下图 Figure 4 所示,在虚拟城市中,模型需要根据街景图像和文字指令导航到目的地。

- 规则变化:一种是绝对空间方向('north', 'northeast', 'east', 'southeast', 'south', 'southwest', 'west', 'northwest');另一种是相对空间方向('left', 'right', 'slightly left', 'slightly right')。以便评估模型是记住了训练数据,还是理解了空间知识。

- 视觉变化:主要是不同城市的街景图片,训练和评估中提供不同城市的图片,来评估模型的视觉泛化能力。

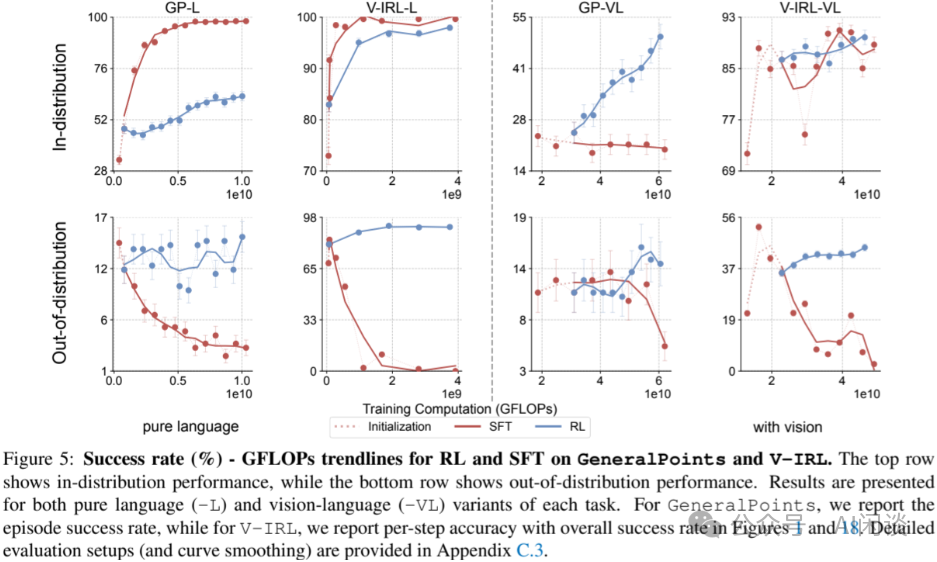

8.3 SFT 主导记忆、RL 主导泛化

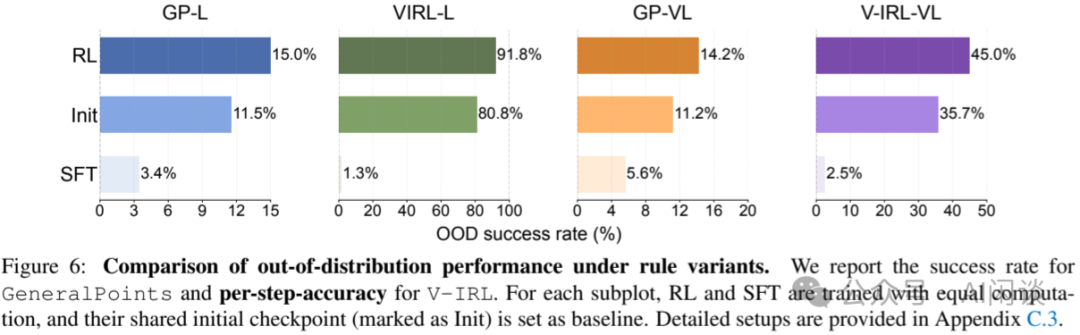

如下图 Figure 5 所示,在两个基准上的实验表明(左侧两列为纯语言评测,右侧两列包含视觉输入)。其中 GP 的分布内(ID)表示都把 JQK 当做 10,分布外(OOD)表示评测时将 JQK 当做 11、12、13;V-ITL 的 ID 表示都是用绝对位置,OOD 表示评估时使用相对位置:

- 第一行所示:SFT 和 RL 均能提升在分布内的性能。

- 第二行所示:RL 可以提升在分布外(OOD)的性能,但SFT 在分布外(OOD)上表现不佳。

如下图 Figure 6 所示,RL 在所有 OOD 任务上均有提升,而 SFT 在所有 OOD 任务上均有下降。表明 SFT 更倾向于记忆,而非泛化。

8.4 SFT 在 RL 训练中的作用

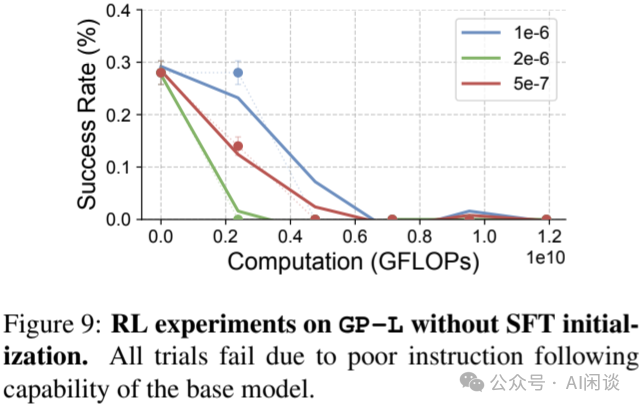

作者也进一步探索了 SFT 对 RL 的影响,如下图 Figure 9 所示,在不具备指令遵循能力的基础模型上进行端到端 RL 训练,发现性能无法提升,此时通过 SFT 增强基础模型的指令遵循能力是必须的。

九、参考链接

- https://arxiv.org/abs/2501.12948

- https://qwenlm.github.io/blog/qwq-32b-preview/

- https://arxiv.org/abs/2502.03387

- https://github.com/GAIR-NLP/LIMO

- https://arxiv.org/abs/2501.19393

- https://github.com/simplescaling/s1

- https://oatllm.notion.site/oat-zero

- https://github.com/sail-sg/oat-zero

- https://arxiv.org/abs/2502.03373

- https://arxiv.org/abs/2501.17161