斯坦福大学团队使用多智能体强化学习训练社交推理语言模型

社交推理游戏是一类需要玩家通过交流和推理来达成目标的游戏,典型的例子是我们熟悉的《狼人杀》,这些游戏要求玩家在有限的信息下,通过与其他玩家的交流和互动,推断出某个隐藏角色的身份。假如让多智能体玩狼人杀,这些智能体可以合作、竞争或者两者兼而有之。研究多智能体环境不仅有助于理解智能体之间的互动,还能为开发更智能、更协调的系统提供理论基础。

在多智能体环境中,使用自然语言进行交流是一种强大的工具。它不仅能让独立的智能体在部分可观察的环境中共享信息,还能实现与人类的零样本协调。然而大多数先前的研究存在局限性,要么依赖于大量人类演示的训练,要么缺乏生成自然和有用交流策略的能力。在这项工作中,斯坦福大学的研究团队探索了一种无需人类演示的方法,通过训练语言模型,使其能够使用自然语言就环境进行富有成效的讨论。2 月 11 日,他们的研究论文《Training Language Models for Social Deduction with Multi-Agent Reinforcement Learning》发表于 arXiv 平台。

研究团队将沟通问题分解为倾听和说话两个方面。他们的主要思想是利用智能体的目标来预测有关世界的有用信息,作为指导沟通的密集奖励信号。具体来说,通过训练模型根据讨论预测有关环境的信息来提高模型的倾听技能。同时,通过多智能体强化学习,根据模型对其他智能体的影响奖励消息,从而提高模型的说话技能。

他们研究的核心问题是如何在没有人类示范的情况下,训练语言模型使其在多智能体环境中进行有效的交流。研究团队探讨了如何利用智能体的目标预测世界的有用信息,作为密集奖励信号指导交流。研究团队以《我们之间》这款社交推理游戏为实验平台,通过多智能体强化学习,分析智能体在复杂社交环境中的表现和行为。研究团队的主要目标是展示智能体在没有大量任务特定数据的情况下,通过自我改进提升其交流和推理能力,并最终提高游戏胜率。

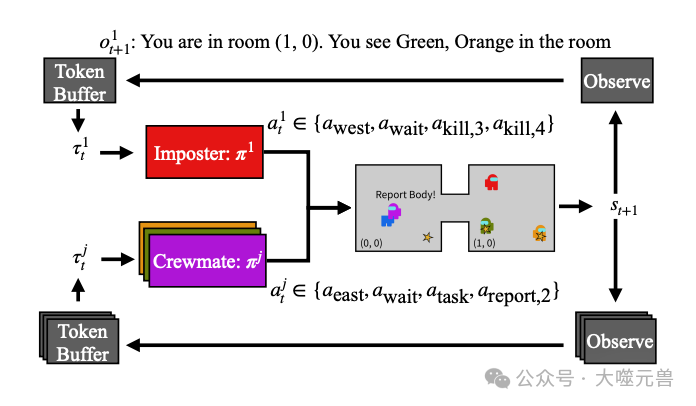

图1:《我们之间》的游戏和讨论阶段示例。在游戏过程中,所有代理都在2D网格环境中导航(在这种情况下是1乘2的网格,在(0,0)和(1,0)处有两个房间),代理可以在同一个房间里看到所有内容。在这里,红色、绿色和黄色的试剂在房间(1,0),紫色和蓝色的试剂在空间(0,0)。船员可以执行任务(由星星表示——在这个例子中有3个任务),而冒名顶替者会杀死船员。在这里,橙色和绿色的特工正在执行任务。特工也可以报告尸体,就像紫色特工目前正在做的那样,这将启动讨论阶段。在讨论阶段,代理利用大型语言模型生成自由形式的消息,这些消息由我们的框架指导,鼓励机组人员有效地进行口语和听力交流,并最终投票选出疑似冒名顶替者。右侧显示的示例讨论基于我们训练的模型生成的讨论。

研究团队由斯坦福大学的四位研究人员组成,他们在人工智能和多智能体系统研究方面具有丰富的经验。Bidipta Sarkar 主要研究多智能体系统和强化学习,Warren Xia 专注于语言模型在多智能体环境中的应用,C. Karen Liu 的研究领域涵盖机器人学和人工智能,特别是多智能体协作与协调,而 Dorsa Sadigh 则专注于机器人与人类互动、多智能体系统中的学习与推理。他们的共同努力不仅推动了本研究的顺利进行,也为多智能体系统和自然语言处理的交叉研究提供了宝贵的见解。

相关工作

突现交流研究

突现交流是多智能体强化学习(MARL)中的一个重要主题,特别是在参考游戏和重复参考游戏的背景下。在这些游戏中,一方的发言者知道问题的真实答案(例如,从一组图像中选出特定图像),然后需要向倾听者传达该信息,倾听者随后需要选择所指项目。早期研究表明,人类能够迅速适应这些任务,利用心智理论推理来理解发言者的意图。Hawkins等人展示了语言模型通过持续学习能够适应人类的惯例。然而这些研究主要集中在明确知道答案的情况下,而在社交推理游戏中,所有代理都需要通过交流来集体学习答案,这使得挑战更为复杂。突现交流研究为理解和改进多智能体之间的交流机制提供了宝贵的见解。

语言模型代理

在任务规划和决策中,大型语言模型(LLM)凭借其对互联网规模数据的访问能力表现出色。在机器人学领域,先前的研究探索了如何使用语言模型根据自然语言指令规划一系列高级操作。在虚拟游戏环境中,Park等人使用ChatGPT模拟虚拟小镇的成员,尽管这些代理没有特定的任务或训练机制,但他们展示了利用长时记忆流存储超出语言模型上下文长度的记忆,形成社会网络。这种外部记忆的使用后来被用于单人环境中的技能学习和多智能体环境中的协调。语言模型能够在各种环境中控制代理,这对研究团队在社交推理游戏中直接使用语言模型作为强大起点具有重要意义。

基础模型与强化学习结合

一些研究将语言模型与强化学习相结合,展示了其在提升代理表现方面的潜力。例如,Cicero是一个用于《外交》游戏的AI,通过对话条件动作模型结合人类行为训练对话自由模型,并通过强化学习选择动作。Cicero使用意图嵌入连接对话生成和策略推理组件,使其能够以自然的方式与其他代理交流。然而,这种方法限制了RL模型直接控制生成的消息的能力,可能在消息质量方面有所不足。此外,该方法需要大量人类示范,这在许多环境中不实用。

在提供奖励和作为策略基础模型方面,基础模型也表现出色。例如,Hu和Sadigh利用语言模型作为奖励信号来训练单独的网络,以遵循特定的协调策略。研究团队同样使用LLM在讨论阶段提供更密集的奖励,但研究团队直接训练LLM本身,而不是单独的策略。强化学习在人类反馈中的应用也显著提升了LLM的聊天能力。Ouyang等人展示了通过人类反馈进行强化学习的有效性,通过PPO算法的修改微调LLM,提升其表现。Yuan等人进一步允许LLM成为自己的奖励模型,生成自己的数据进行自我改进。尽管如此,研究团队的奖励模型设计仍然依赖于环境,以确保逻辑错误的纠正和训练过程的高效性。

《我们之间》游戏的设计

在这项研究中,研究团队以流行的社交推理游戏《我们之间》(Among Us)作为实验平台,通过设计一个多智能体环境来评估语言模型在复杂社交环境中的表现。他们的目标是创造一个能够使智能体基于环境中的证据进行讨论的环境,从而训练语言模型在没有人类示范的情况下进行富有成效的交流。

图2:游戏循环示意图。环境首先同时向所有代理发送观察结果,并在每个时间步从一组有效操作中收集标记化的操作。

角色分配

《我们之间》的游戏角色分为冒充者和船员。游戏开始时,每个玩家被分配为冒充者或船员。船员不知道其他玩家的身份,而冒充者则从一开始就知道所有玩家的身份。在研究团队的设置中,通常有一个玩家被分配为冒充者,而其他玩家则是船员。船员被分配了一组任务,这些任务分散在整个游戏环境中,要求船员在完成任务的过程中识别出冒充者。

游戏阶段

游戏阶段分为游戏阶段和讨论阶段。在游戏阶段,玩家在一个二维网格环境中移动,通过观察环境并采取行动来完成任务或进行交流。所有代理可以在相邻的房间之间移动,完成任务,或报告死亡的船员。冒充者可以在同一房间内杀死船员,但需要在冷却时间步之间等待。

讨论阶段是游戏的核心部分。玩家在这个阶段可以自由聊天,交流他们的观察和推测,以识别冒充者。每个玩家轮流说一句话,讨论结束后进入投票阶段。所有玩家投票选择要驱逐的嫌疑人,得票最多的玩家被驱逐。如果冒充者未被驱逐,游戏继续进行,船员可以继续完成任务,直到所有任务完成或冒充者被驱逐。

奖励结构

《我们之间》本质上是一个团队零和游戏,奖励结构基于船员或冒充者的胜利情况。如果所有任务被完成或冒充者被驱逐,船员获胜,获得正向奖励。相反,如果冒充者的数量大于或等于船员数量,则冒充者获胜,船员获得负向奖励。

这种奖励机制强调了团队协作的重要性,要求船员在游戏过程中有效地交流和合作,而冒充者则需要巧妙地隐藏身份并误导船员。通过这种设计,研究团队能够在实验中评估智能体在复杂社交推理环境中的表现,探索如何通过多智能体强化学习提高语言模型的交流和推理能力。

增强船员交流能力

在《我们之间》的游戏中,有效的交流对于船员识别冒充者至关重要。为了超越基础的强化学习(RL)模型,研究团队重点研究了如何提高船员在游戏中的听力和表达能力,使他们能够在复杂社交环境中进行更有意义的讨论。

冒充者预测的听力训练

首先,研究团队提出了一种利用环境的真实答案提高船员推理能力的方法。在多智能体环境中,船员需要理解环境观察和其他船员的信息,以便在讨论阶段做出准确的判断。通过直接训练船员利用环境提供的关于冒充者身份的真实答案,可以提高他们的推理能力。研究团队使用了在讨论消息之间的时间步作为训练信号。这些时间步不需要人类示范数据,代理可以通过任意回滚缓冲区学习观察和信息。

在每个时间步,当船员被要求提供对冒充者身份的信念时,研究团队将其作为听力训练的损失项。这样,船员可以根据游戏阶段的观察和讨论消息,提高对冒充者身份的判断力。这一过程不仅使讨论更有意义,还能够使船员在讨论阶段通过监督学习任务,理解消息的含义,从而准确投票驱逐冒充者。

强化讨论学习的表达训练

除了提高听力能力,研究团队还探讨了如何通过强化学习提高船员在讨论中的表达能力。研究团队的关键思路是基于船员信念变化的奖励机制来训练模型。具体来说,研究团队根据每个消息后其他船员对冒充者身份信念的变化,给予发言船员奖励。这个奖励机制模拟了每个消息在预测正确冒充者任务中的因果效果,最有效的消息应该能够说服其他船员投票驱逐真正的冒充者。

为了综合应用听力和表达损失,研究团队设计了一个综合策略。该策略结合了RL的强化学习损失和听力损失,使模型在优化行动的同时,提高识别冒充者的能力。此外,研究团队还加入了对表达的奖励机制,使代理能够区分有用和无用的消息,从而在讨论中发送更有效的消息。

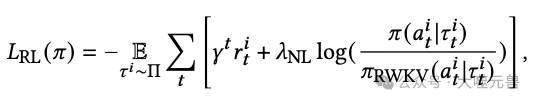

为了训练语言模型在没有专家演示的情况下采取更有效的行动,我们可以转向强化学习。由于Among Us已经为获胜提供了奖励,我们可以直接对其进行优化,以生成一个模型𝜋RL,最大限度地减少以下损失:

动态设置下的训练

在训练智能体时,仅依赖固定的对手可能会导致智能体策略的单一化和缺乏鲁棒性。为了提升智能体在复杂多变环境中的表现,研究团队采用了自我对弈算法。这种算法允许智能体在训练过程中不断与不同版本的自己进行对抗,从而学习到更为全面和灵活的策略。

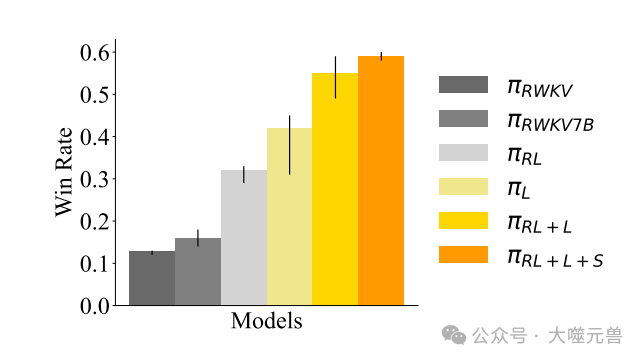

图3:在“基础”环境中,使用不同算法训练的机组人员的胜率:2×2的房间网格,每个机组人员4个任务,5名玩家。误差条表示使用不同种子进行三次独立训练的跑步的最大和最小预期获胜率。

通过迭代自我对弈,可以逐步提高智能体的鲁棒性。每一轮训练后,智能体都会面临更强大的对手,这促使其不断优化自己的策略。最终,经过多轮迭代训练,智能体能够在各种情境下表现出较高的胜率,适应不同的游戏变化和对手策略。这种方法不仅提高了智能体的整体性能,也增强了其在面对不确定性和对手变化时的适应能力。

在训练过程中,为了确保队友的多样性与合理性,研究团队采用了N-Agent临时团队设置。具体来说,研究团队在每一轮训练中冻结一个船员的策略,使其不随其他智能体的策略变化而改变。这种做法避免了所有智能体同时退化到某种简单的、不可行的策略,例如在讨论阶段不发言或在起始房间不移动。通过保持一个固定的船员,其他智能体必须在更多样化和合理的环境中学习和适应,从而提高整体团队的表现。

此外,为了进一步提升智能体的适应能力,研究团队在训练中引入了环境参数的随机化。这意味着在每一轮训练中,环境配置可能会有所变化,例如环境布局、任务数量和玩家数量等。这种随机化训练使得智能体能够在不同的环境中有效表现,避免了过度拟合某一特定环境配置。实验结果表明,智能体在不同环境配置下的表现趋势大致相同,证明了这种方法的有效性。

在训练过程中,研究团队观察到最好的方法是引入世界建模损失。这一损失项确保了模型在训练中保留其语言建模能力,并帮助其在自己的讨论中匹配观察中体验的模式。具体来说,世界建模损失通过记录和预测环境状态的变化,帮助智能体在讨论中生成更相关和合理的消息,从而提高整体表现。

结果分析

研究团队通过多次实验和详细分析,评估了不同训练方法在《我们之间》游戏中的表现。以下是对这些实验结果的全面解读。

合作训练的性能评估

在合作训练中,研究团队首先评估了基础模型的表现。使用1.5B RWKV模型进行的实验表明,基础模型在游戏中的胜率较低,而参数较多的7B模型表现略好,但胜率仍然不足20%。通过强化学习(RL)训练,性能显著提高,甚至超过了7B模型。然而,未添加听力损失的RL模型在识别冒充者方面表现不佳,即使从听力策略πL开始也迅速失去了辨别能力。

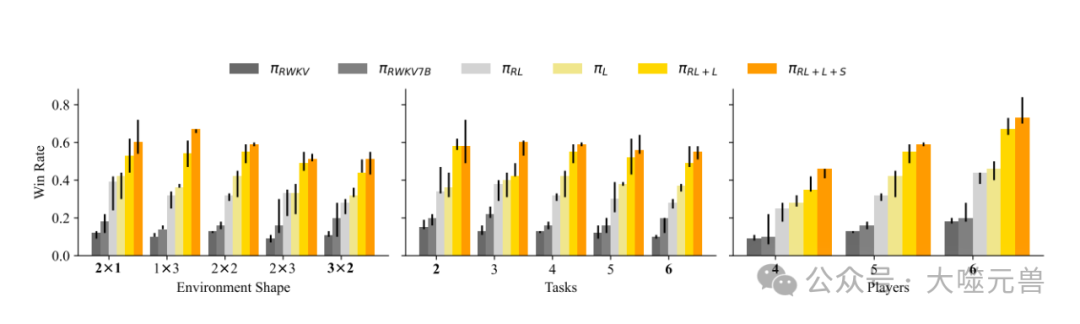

图4:在不同环境配置下,通过修改环境形状、任务和玩家数量,使用不同算法训练的机组人员的胜率。

仅使用听力训练(损失项为LL),模型虽然不知道如何采取有效行动,但在预测冒充者身份方面表现出色。结合RL和听力损失的策略使成功率显著提高,而进一步加入密集的表达奖励(RL+L+S)后,模型能在训练中区分有用和无用的消息,使胜率翻倍。尽管没有明确的表达奖励,语言模型仍然能够生成连贯的消息,在讨论中分享怀疑,使得讨论间接得到改进。

环境变化对模型表现的影响

研究团队测试了不同环境配置下的模型表现,发现环境形状对胜率影响较小,较小的环境由于冒充者难以在不被目击的情况下杀人而胜率更高。任务数量增加使得通过完成任务获胜更难,而船员数量增加则显著提高了胜率。这表明,语言模型能够在面对不同环境变化时,保持较好的适应性和鲁棒性。

消息模式的评估

基础RWKV模型的消息通常不集中,经常虚构更多上下文,而改进后的RL+L+S模型则直接指控冒充者,或者在消息中提及冒充者。一般来说,提及特定代理使得其他代理更可能投票反对他们。此外,船员分享类似环境观察的信息帮助判断冒充者身份,例如提到某个玩家离开发现尸体的房间。然而,有时船员也会撒谎,以最具说服力的陈述获取足够的票数驱逐冒充者。

冒充者的鲁棒性

通过多轮自我对弈实验,分析船员策略对抗训练冒充者的表现。结果显示,即使面对对抗性训练的冒充者,船员策略依然有效。冒充者尝试将责任转移给其他玩家,通过反指控其他船员来迷惑对手,模拟船员的讨论模式,有时成功欺骗船员。语言模型的上下文学习能力使冒充者能够模仿之前发言的船员,进行对抗性讨论。

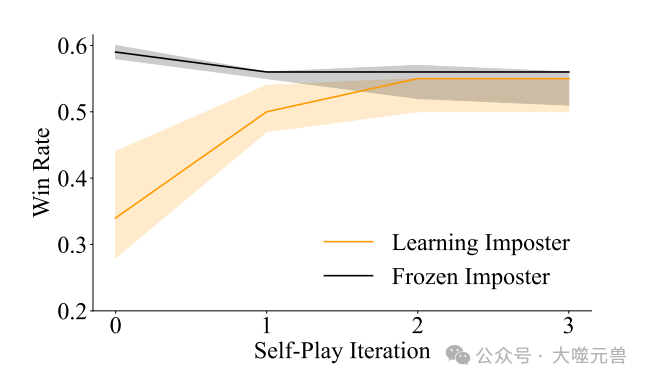

图5:在基础环境中评估的自玩迭代策略的可利用性曲线。橙色线表示对抗经过对抗训练的冒名顶替者的预期获胜率。黑线表示针对本次迭代的冒名顶替者进行专门优化的船员的预期获胜率。请注意,迭代0指的是基础模型,而迭代1指的是合作训练部分的机组人员策略。阴影区域代表了使用不同种子进行三次独立训练的跑步的最大和最小获胜率。

训练中的失败模式与解决方案

在实验过程中,研究团队遇到了一些失败模式并提出了解决方案。首先,讨论容易脱离自然语言,需要仔细调整强化学习中的软KL约束以保持语言生成的正常。当约束权重过低时,RL训练模型在几轮后就会偏离自然语言,输出随机标记,导致性能停止提高。

其次,同时训练所有船员会导致退化解决方案,例如仅输出换行符或停留在起始房间不移动。通过冻结一个船员不学习,避免了这种策略退化问题。最后,RL训练模型在讨论中使用动作标记而非自然语言,为解决此问题,研究团队引入了世界建模损失,确保模型保留语言建模能力,并帮助其在讨论中匹配观察中体验的模式。

讨论

在这项研究中,研究团队展示了一种利用多智能体强化学习训练语言模型的方法,使其在社交推理游戏中能够进行有效的讨论和交流。通过在《我们之间》游戏中的实验,研究证明了即使在没有大量任务特定人类数据的情况下,语言模型依然能够自我改进,提升在多智能体环境中的表现。

本研究的重要贡献在于展示了自我改进LLM在社交推理游戏中的巨大潜力。通过多智能体强化学习方法,模型不仅学会了在复杂的社交环境中进行有效的交流,还能够从讨论中提取有用信息,进一步提升游戏的胜率。研究团队的实验结果表明,智能体在面对对抗性训练的冒充者时,依然能够保持协作和协调,未被破坏讨论过程。这一发现为未来的多智能体系统应用打开了新的大门,展示了在新任务中实现多智能体交流的可能性。

然而,尽管取得了显著成果,本研究也存在一些局限性。一个主要的局限在于研究团队的场景预测技术依赖于特定任务。在《我们之间》中,讨论与预测冒充者身份之间有自然的联系,但这种结构未必适用于所有的社交推理游戏和现实世界环境。未来研究的一个有趣方向是探索让智能体自主识别场景中与特定任务相关的方面,而不是依赖于手动指定。

此外,研究团队注意到在讨论过程中,船员并不总是诚实,他们倾向于选择最具说服力的陈述。这种行为在《我们之间》这样的沙盒环境中或许是可接受的,但在其他应用场景中可能会带来潜在风险。因此,优化讨论中的诚实性成为未来研究的重要方向。确保智能体在交流过程中不仅有效,还能够传达真实和准确的信息,对于多智能体系统的实际应用至关重要。

总之,研究不仅提供了一种新的训练方法,还为未来的多智能体强化学习和语言模型研究提供了重要的启示和参考。尽管存在局限性,我们相信,通过进一步的研究和改进,这一领域将会取得更多突破性进展,推动智能体系统在各种复杂环境中的应用和发展。(END)

参考资料:https://arxiv.org/pdf/2502.06060

本文转载自 独角噬元兽,作者: FlerkenS