强化学习与大模型后训练:DeepSeek R1 如何获得推理能力? 精华

DeepSeek 正在通过其开源模型 DeepSeek-R1 革新 AI 产业,尽管资源有限,却能媲美 OpenAI 的能力。通过让前沿大模型更广泛地开放,DeepSeek 推动了全球的创新与合作。其创新的基于强化学习(RL)的后训练技术可增强大模型的推理能力和对齐性,使大模型在实际应用中更加高效且易用。在本文中,我们将重点分析 DeepSeek R1 推理模型背后的关键 RL 后训练技术。本文由MoPaaS 的创始人鲁为民博士最初以英文的形式发表(点击文章末尾“阅读原文”),这次翻译出来供朋友和合作伙伴参考。

目录

- 引言

- 提升 LLM 推理与对齐能力的后训练

- 数据准备与生成

- 强化学习(RL)与推理型 LLM 后训练

- 基于 RL 的后训练(I): DeepSeek R1 系列模型案例

- 基于 RL 的后训练(II): OpenAI o-系列模型案例

- RL 规模法则与 LLM 推理能力的涌现

- 讨论与结论

- 参考文献

1. 引言

中国人工智能(AI)初创公司DeepSeek 的崛起,标志着 AI 产业向开源化发展的重大转变。这一变革对开源社区及整个 AI 生态系统具有深远影响。

DeepSeek 的旗舰模型 DeepSeek-R1 是一个开源推理模型,尽管其训练所用的计算资源远少于 OpenAI 的 o1,但在性能上却能与之媲美。这一事实挑战了“最先进的 AI 研发必须依赖海量资金和计算资源”的传统观念。通过开源其模型,DeepSeek 使前沿 AI 技术得以普及,让全球的开发者、研究人员和机构能够基于其技术进行创新。这种模式不仅推动了 AI 应用开发的加速,还促进了协作式知识共享生态的建立。

大语言模型(LLM)通常基于海量互联网文本语料进行预训练,以提供基础的语言理解与推理能力。虽然这些模型在处理一般任务时表现良好,但在实际应用中往往存在局限性。许多现实世界的应用场景需要更强的推理能力和更高的对齐性,使 LLM 能够具备更强的交互性、适应性、目标导向能力以及高级推理能力。

本文探讨了一种新兴的 LLM 训练方法——基于强化学习(RL)的后训练,该方法可增强推理型 LLM(如 R1)的多步推理能力及安全对齐效果。尽管后训练本身已极具价值,但基于 RL 的方法尤其重要,它能够进一步优化 LLM 的推理能力,使其能够更精准地匹配用户需求,并更好地对齐人类价值观。与预训练相比,这些方法能够在大幅降低计算资源消耗的同时,显著提升推理效果。例如,V3/R1 和 o1/3 这样的 LLM能够通过这些技术生成更符合现实需求的推理、规划和行动输出,从而使基于 LLM 的 AI 代理更智能、更实用、更值得信赖。

在本文中,我们将重点分析 DeepSeek R1 推理模型背后的关键 RL 后训练技术。部分内容最初发表于《大语言模型时代的智能体:系统综述》的第 7 章和第 9 章,并在此基础上进行了修订和更新,以提高清晰度和完整性。

2. 后训练以增强 LLM 的推理与对齐能力

2.1 预训练 LLM 与推理 LLM

与通用基础 LLM 相比,推理 LLM需要在推理和对齐方面表现更为出色,以便在需要强大推理和对齐能力的特定领域中更高效地应用。此类模型的关键特点包括:

- 推理与规划:

能够进行结构化思维,理解智能体、环境和目标之间的关系;

支持基于环境变化动态调整任务目标的优先级;

促进多步推理、实时适应以及特定任务能力(如长期记忆和多轮对话);

通过针对关键任务定制专用模型,解决通用 LLM 在效率和性能上的不足。

- 对齐与用户偏好:

- 通过严格遵守政策和优先考虑用户目标,确保符合明确的目标和安全原则;

- 提供上下文感知的响应,并根据用户特定数据和偏好,个性化交互,提升用户体验。

- 鲁棒性与可扩展性:

- 在动态和不确定的环境中高效运作,采用概率推理和回溯策略寻找替代方案;

- 支持多智能体系统,通过高效的沟通、协作和冲突解决机制,提升整体协作效果。

推理模型代表了确保在日益复杂的环境中高效运作的重要进展。通过增强推理和规划能力,优化任务特定挑战,确保在动态环境中的鲁棒性,并对齐伦理原则,这些模型为开发更强大、高效且值得信赖的智能体奠定了基础。其中,推理与规划对模型的成功至关重要。

最近,OpenAI o1/o3、DeepSeek R1、阿里巴巴的 Marco-o1、Google Gemini 2 和 Microsoft Phi 4 等模型体现了这一趋势。这些以推理为核心的模型利用先进的预训练技术提供强大的基线模型,并通过强化学习后训练提升推理能力。例如,广泛使用 CoT 推理使这些模型能够模仿人类逐步解决问题的路径,从而在生成响应之前完成复杂的多步推理。这些进展显著提升了推理能力,并与人类价值观和原则对齐。

这些模型解锁了 STEM 领域的新应用,往往在数学和编程任务中超越了早期模型。在某些情况下,它们甚至解决了之前无法解决的数学证明,展示了它们作为科研助手的潜力。

强大的基线模型为进一步提升推理能力提供了坚实的基础,确保后续优化有一个稳固的起点。结合测试时计算,这些模型已成为智能体的理想基础模型。

2.2 LLM 的推理与对齐后训练

随着通用 LLM 的规模不断扩大,并逐步引入特定能力的数据,它们的通用能力,特别是智能体所需的推理、规划和决策能力,继续提升。然而,为了提高智能体在推理过程中需要验证和修正的任务效率,并在测试阶段提升计算可扩展性,有必要对具备推理能力的 LLM 进行微调。

在 LLM 的预训练阶段,可以直接针对这些能力进行优化,以改善模型的输出分布。然而,预训练数据变得日益稀缺,且能力提升的速度与计算投入相比逐渐放缓。预训练的 LLM 通常依赖于从示例中反向推导出理想行为,导致数据利用效率低下和决策边界不清晰,从而导致推理和安全能力不尽如人意。因此,后训练逐渐成为提升模型性能、提高推理准确性、对齐人类价值观,并适应用户偏好的关键方法,且相比于预训练,其计算需求显著降低。例如,通过 LLM 后训练微调现有的开源预训练 LLM(如 LLaMA、Mistral、GLM 和 Qwen),可以开发专为智能体设计的 LLM,从而增强智能体所需的推理、规划和决策能力。

当前的后训练方法主要围绕强化学习(RL),包括对基础模型的监督微调(SFT)和策略模型的 RL 训练。基础模型的 SFT 可以提供语言生成和对话能力上的流畅性和一致性;虽然 SFT 也能引入一定的推理能力,但由于错误累积和探索数据有限,它在需要多步推理的任务中往往表现不足。强化学习(RL)方法通过生成长链的 CoT,帮助模型获取推理能力。结合 SFT,RL 方法已成为目前后训练LLM 的标准方式,尤其适用于需要复杂决策和自适应学习的场景。这些方法广泛应用于模型对齐和性能优化,尤其适用于在复杂动态环境中运作的智能体。

3. 数据准备与生成

数据准备是后训练管道中的关键组成部分。训练数据集可以由人工策划、由 AI 生成,或通过多种方法的组合来创建。

3.1 数据策划

特定智能体的 LLM 需要精心策划的数据集进行预训练和/或后训练微调,以提供智能体所需的能力。这通常涉及适当增加与特定能力相关的数据比例(例如,数学和编程)到训练数据集中。例如,使用具有挑战性的数学数据集(如 MATH 数据集)微调预训练的基础模型,可以提升大型语言模型在复杂数学推理方面的能力。无论是从头开始进行预训练,还是微调预训练模型,智能体专用的 LLM 都是通过分配特别策划的数据集来注入能力,并且预训练或后训练能够优化 LLM 的输出分布,进而产生相关的结果。

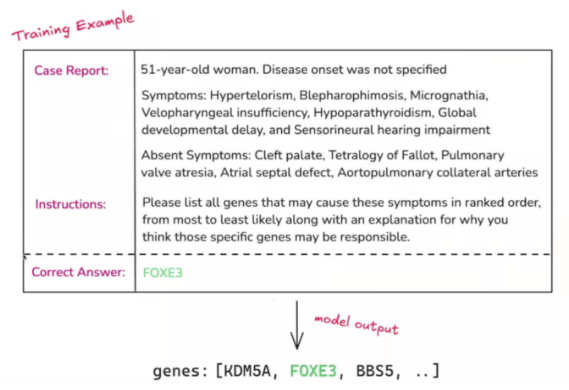

在后训练管道中,训练数据集会为 SFT 和 RL 优化阶段进行策划,在 RL 阶段,还需要策划奖励模型的训练数据集(如有需要)和 RL 策略模型。与通用 LLM 需要大量数据和资源进行预训练不同,推理 LLM 通常可以通过在较小数据集上进行后训练来构建。例如,OpenAI 的 o1 模型通过利用专门策划的数据集进行预训练或微调,展示了强大的推理和对话能力(如图1 所示)。这些数据集包括:

- 推理数据: 包含推理和科学文献等关键组成部分的公开可用的网络和开源数据集,用于增强模型执行复杂推理任务的能力。

- 专有数据: 高价值的非公开数据集,如付费内容、专业档案和其他领域特定的数据集,用于深入了解行业特定的知识和实际应用。

- 数据过滤与精炼: 数据经过严格过滤,以确保质量并减少潜在风险,特别是避免训练数据中的个人信息、有害内容或敏感材料。

Figure 1. A Training Dataset Sample for OpenAI o3 RL Fine-Tuning (OpenAI, 2024)

3.2 合成数据生成

通过微调将推理能力注入到 LLM 中,需要足够的推理分布实例,并且需要相关的长上下文。一般数据集中与推理相关的特定能力比例和质量,往往难以有效满足 LLM 为智能体配备专业技能的需求。高质量的推理数据通常通过特定的 LLM 生成。

合成数据旨在模仿真实世界数据的属性。这类数据可以使用生成模型或设计用来复制自然现象的算法生成。例如,生成代码数据集时,可以选择各种编程任务或提示作为种子任务,并使用模型生成与这些任务相关的问题。对于每个问题,模型会从生成的回答中抽取多个潜在解决方案,使用拒绝采样(SR)方法,只有通过相关测试或正确执行的解决方案才会被包含进训练数据集中,从而有效过滤掉低质量样本。

以这种方式生成的合成数据占据了像 OpenAI o1/o3 和 DeepSeek R1 等模型的预训练和后训练数据集的很大一部分。另一方面,这些模型能够生成长链 CoT 推理轨迹,其中包含如迭代与递归问题解决、假设探索、回溯、反思、验证和自我修正等重要特征。

为了构建用于训练模型的长 CoT 实例,可以结合 LLM 和树搜索方法,例如使用带有步骤级别动作空间的 MCTS(蒙特卡洛树搜索)生成高质量的 CoT 数据。为此,构建一个推理树,根节点表示问题,每个节点代表一个推理步骤。如果节点错误,则进行回溯,通过过程级奖励模型来评估节点的正确性,从而将错误的步骤纳入推理过程,构建长链 CoT 轨迹。

然而,在 LLM 后训练中扩展这种方法面临几个挑战。首先,不像围棋或国际象棋有相对明确的搜索空间,生成 token 涉及的是一个指数级增长的搜索空间,这对计算资源提出了挑战。其次,生成的质量高度依赖于价值模型,因为它引导搜索过程的每一步。训练一个细粒度的价值模型本身就非常困难,因此迭代优化成为一个巨大的挑战。尽管 AlphaGo 的成功依赖于精心训练的价值模型来逐步提升性能,但由于 token 生成的固有复杂性,将这一原则复制到生成过程中非常困难。

蒸馏方法也提供了一种经济高效且可靠的方式来获取高质量的合成数据;高级(期望的)LLM 被提示生成带有必要长 CoT 格式的详细推理轨迹。例如,OpenAI o3 和 DeepSeek V3/R1 从早期版本的推理模型中蒸馏出了高质量的回答;考虑到 o1的复杂推理能力,对其认知机制进行蒸馏是生成和策划用于新模型复制或后训练的合成数据的可行方法。此外,对于具有可验证解决方案的推理任务,蒸馏可以结合拒绝采样实现,从而提取和验证高级 LLM 的推理过程,以生成更高质量的数据。

例如,对于训练 OpenAI o3 模型,合成数据集的生成始于收集包含所需推理行为的提示,并通过提示基础推理模型来收集包含理想 CoT 的完成项,接着使用一个“评判者”奖励模型对收集到的完成项进行过滤,筛选出高质量的结果,最终生成一组(提示、CoT、输出)元组,作为后训练的数据集。

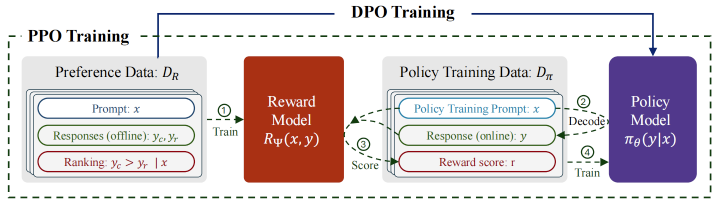

同样,在 R1(如图 2 所示)中,为了构建训练模型所需的 CoT 实例,可以为 LLM 设计结构化提示,以生成包含推理过程的输出,最后给出答案。

Figure 2: Prompt Template for DeepSeek-R1 (DeepSeek, 2024)

合成数据生成通常不是一次性任务,因为使用的生成模型可能不如训练中的模型先进,可能无法产生完美的结果。然而,如果生成的完成项能够经过验证,那么它们可以被过滤以确保符合期望的行为。这一过程可以与 RL 优化一起迭代执行。每个 RL 训练模型的新检查点都可以用来生成更多的数据批次,进一步优化训练过程。

4. 强化学习与推理型 LLM 后训练

4.1 强化学习(RL)

给定一个初始的预训练大语言模型(LLM),可以通过在精心策划的数据集(包括筛选后的合成数据集)上对基础LLM进行后训练,从而获得用于代理的推理LLM,使得模型能够输入一个提示并输出包含期望的推理链(CoT)的完成(见第3.2节)。

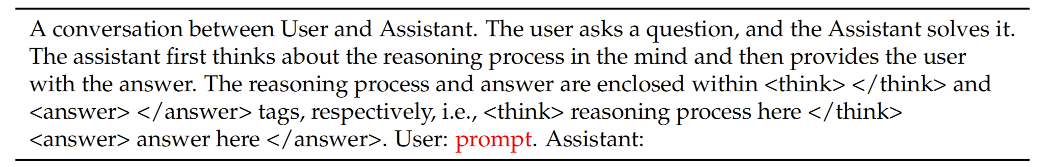

后训练的核心技术是强化学习(RL)。在LLM的上下文中,RL是一种训练方法,通过使用反馈信号(通常以奖励的形式)对模型进行微调,从而优化其行为,使其与用户的偏好对齐。这个过程通过反复从与环境的交互中学习,通过奖励模型(见图3)使模型能够改善推理能力、安全性、与人类偏好的对齐以及任务特定的目标。

Figure 3: Reinforcement Learning with Verifiable Reward (Lambert et al., 2024)

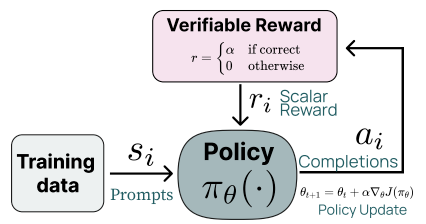

有多种强化学习(RL)技术旨在优化LLM,使其根据环境、用户和AI代理的反馈对齐用户偏好。这些技术包括:

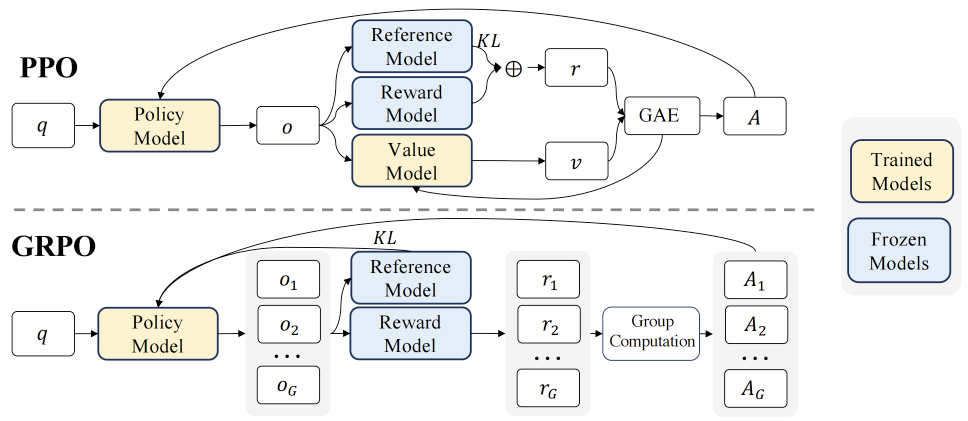

- 近端策略优化(PPO)

- 群体奖励策略优化(GRPO)

- 直接偏好优化(DPO)及其它们的变种(见图4)。

Figure 4: PPO v.s. DPO (Ivison et al., 2024)

特别地,基于PPO的偏好反馈学习方法首先通过偏好数据训练一个奖励模型,该模型用于对策略模型生成的响应进行评分,然后通过PPO算法根据响应的奖励得分训练策略模型。GRPO是PPO的扩展,见图5,它放弃了价值模型,而是通过群体评分估计基线,从而大大减少了训练资源。另一方面,DPO允许直接在偏好数据上训练策略模型,而无需构建奖励模型或在线从活动策略中采样。

Figure 5. PPO v.s. GRPO: GRPO Foregoes the Value Model (Shao et al, 2024)

基于RL的后训练方法,包括数据生成(例如,从RL模型和其他策划数据中采样的推理数据)、基础模型的监督微调(SFT)、RL优化等,可以反复微调LLM,使其掌握代理的期望推理行为(见图6和图7)。随着RL训练的进展,模型(包括奖励模型和/或策略模型)会不断演化,并可以利用这些模型生成新的训练数据并评估过程和结果。随后,参考模型会更新以对齐策略模型,该模型会进一步通过精炼后的奖励模型进行训练,确保持续改进和对齐。

在一些复杂的情况下,可以使用蒙特卡洛树搜索(MCTS)来结合RL技术寻找最佳推理链,以实现最佳策略。RL使得LLM能够从成功和不成功的轨迹中学习,从而增强它们在多步推理任务中的泛化能力。

4.2 奖励模型

在强化学习(RL)中,奖励作为训练信号的来源,决定了RL的优化方向。因此,奖励模型在引导训练模型最大化期望结果方面发挥着至关重要的作用。在RL训练过程中,奖励模型会为LLM生成的响应分配分数,引导模型生成更符合人类期望的输出。这一过程提高了LLM在生成连贯、相关和人类化响应方面的表现。

在LLM对齐的上下文中,奖励模型通常通过来自人类或其他来源的反馈进行训练。这包括收集对各种模型输出的判断,并使用这些数据来教会奖励模型预测新输出的可取性。经过训练的奖励模型会在LLM的RL训练过程中提供实时评估,促进生成更符合人类偏好的输出。

奖励模型可以通过过程监督训练,生成过程奖励模型(PRMs),或通过结果监督训练,生成结果奖励模型(ORMs)。PRMs被认为对于多步推理任务具有优势,因为它们提高了模型推理与人类逻辑的对齐,同时促进了更安全的行为。

尽管使用ORM或PRM来引导RL生成符合预定推理CoT模式的响应是非常可行的,但神经奖励模型在大规模RL过程中容易遭遇奖励破解;此外,训练这样的神经奖励模型需要大量的计算资源,并使整个训练流程更加复杂。由于这些原因,近年来的做法倾向于使用更简单的奖励模型,而不是像PRM或ORM这样的神经奖励模型。如在后训练DeepSeek R1中所示,推理导向的RL算法采用了一种不同的奖励系统,包含三种主要类型的奖励:

- 准确性奖励:这些奖励评估响应是否正确。例如,在确定性结果的数学问题中,模型需要以指定的格式(例如,用框框围住)呈现最终答案,从而允许可靠的基于规则的正确性验证。同样,对于LeetCode问题,可以使用编译器根据预定义的测试用例生成反馈。

- 格式奖励:使用格式奖励模型确保模型将推理过程放在和标签之间。

- 语言一致性奖励:这是在RL训练过程中引入的一个度量,用于解决在推理链(CoT)中出现的语言混用问题,特别是当提示涉及多种语言时。它衡量目标语言单词在CoT中的比例,鼓励一致使用目标语言。

此外,在后训练过程中,奖励模型还可以作为质量COT轨迹搜索算法中的验证器或拒绝采样方法的验证器,或者作为过滤SFT训练数据的拒绝采样算法。在后者的情况下,模型会在每个搜索步骤提供自我批判性反馈,以优化决策,这对于具有稀疏信号的长期任务尤其有价值。此机制使得模型能够生成多样的推理路径、自我验证并选择最佳解决方案,从而提高推理能力和任务可靠性。

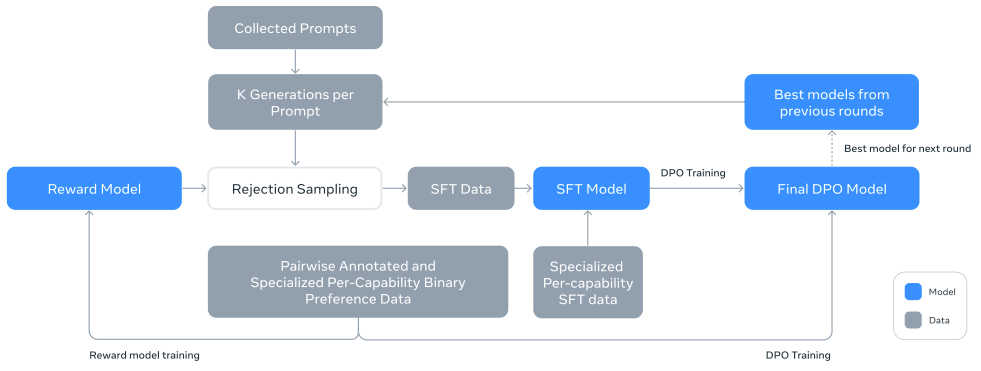

4.3 基于RL的大语言模型后训练流程

以下,我们将重点讨论后训练过程。总体后训练策略通常涉及数据集准备(公共数据集(如MATH)、人工制作或通过拒绝采样生成的AI数据等)、基础模型的监督微调(SFT)和在策略模型上的RL优化(PPO或DPO)。在某些情况下(例如InstructGPT),后训练仅包括由SFT、RM和RL-PPO组成的前向路径。增强推理的后训练的最新发展涉及围绕合成数据生成、SFT和RL优化(例如PPO、GRPO、DPO及其变体)的反馈循环,并通过多个迭代过程进行优化,如LLaMa-3的后训练方法(见图6)。这一迭代过程不断提高模型的性能。例如,Llama 3据报道进行了6轮后训练,并在此之前进行了多轮指令调优。DeepSeek R1则进行了3轮后训练,其中包括最初的R1-Zero(见图7)。

Figure 6: The Post-Training Strategy for Llama 3 (Meta, 2014)

5. 基于强化学习的后训练:以DeepSeek R1系列模型为例

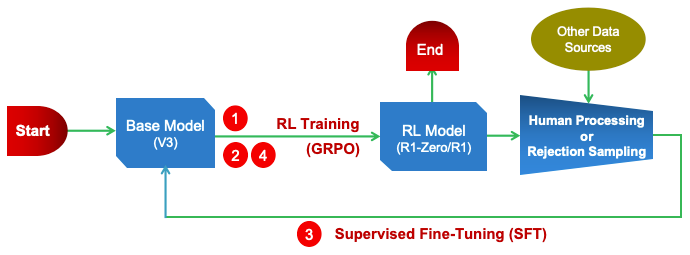

基于强化学习(RL)的后训练方法通过利用迭代数据收集和微调策略,在提高多步推理性能方面展现出了显著效果。DeepSeek R1后训练采用了一种结构化的训练流程,结合了监督微调(SFT)和RL,以增强其推理能力(见图7)。在初始的R1-Zero阶段之后,流程开始通过使用精心策划的数据集对基础模型进行SFT,从而播种初步的推理技能。然后,R1的两个RL阶段被实施:第一个阶段侧重于发现改进的推理模式,第二个阶段将模型的输出与人类偏好对齐。这种组合方法使得模型能够通过试错自我完善推理,通过奖励机制激励准确和连贯的输出。

Figure 7. DeepSeek R1 Post-Training Pipeline (DeepSeek, 2025)

DeepSeek R1的后训练是通过3轮RL迭代完成的,包括最初的没有SFT的R1-Zero阶段,具体步骤如下:

步骤1:训练R1-Zero提供SFT V3基础模型的冷启动数据

DeepSeek R1-Zero通过大规模的强化学习(RL)进行训练,且不使用监督微调(SFT)作为初步步骤。RL模型通过RL过程自我进化,发展推理能力,而不使用任何监督数据。使用内部的群体相对策略优化(GRPO)算法来训练模型(见图5);GRPO放弃了通常与策略模型大小相同的价值模型,而是通过群体评分来估算基线,从而减少训练资源。此外,准确性和格式一致性使用基于规则的奖励。

R1-Zero用于生成一小部分长CoT数据,以便微调模型作为初始的RL行为者。为此,构建了具有长CoT示例的少样本提示,直接提示R1-Zero生成并收集带有反思和验证的详细答案,并通过人工后处理和标注进行结果的优化。

SFT推理链的“冷启动”旨在通过将模型建立为一个指令调优模型来改善最终的R1模型,避免了R1-Zero中出现的如生成中途语言切换的问题。此外,这将成为迭代训练的一部分,提供了一种更好的推理模型训练方法。

步骤2:面向推理的RL训练

在SFT V3基础模型的冷启动数据上之后,采用类似于步骤1中R1-Zero使用的大规模RL过程来增强推理能力,涵盖编码、数学、科学和逻辑推理等任务,这些任务涉及明确的问题。为了避免CoT响应中的语言混用,引入了语言一致性奖励,计算CoT中目标语言单词的比例。推理任务的准确性奖励与语言一致性奖励结合,通过将它们相加形成最终的奖励。RL训练在微调后的V3基础模型上持续进行,直到其收敛。

步骤3:拒绝采样引入通用能力

拒绝采样(RS)是一种广泛使用的偏好微调方法。它通过生成新的候选指令,使用训练过的奖励模型过滤这些候选指令,然后仅在最优的完成结果上对原模型进行微调。

R1利用拒绝采样通过生成并过滤高质量的回应来重新引入模型的通用能力,用于推理任务的训练数据。R1使用从早期RL训练阶段生成的检查点通过拒绝采样生成推理轨迹。数据集进一步扩展,包含通过生成奖励模型评估的额外数据,其中基准和模型预测被输入到DeepSeek-V3进行判断。对于非推理任务,如写作、事实问答、自我认知和翻译,R1遵循DeepSeek-V3管道,重用DeepSeek-V3的部分SFT数据集。

此过程生成了总计80万个完成,其中包括60万个推理任务和20万个通用对话问题。然后使用这80万个样本的策划数据集,对DeepSeek-V3基础模型进行微调,训练两轮。

步骤4:最终RL训练

为了进一步将模型与人类偏好对齐,实施了第二个RL阶段,以增强模型的有用性、无害性和推理能力。该阶段集成了奖励信号和多样化的提示分布。对于推理任务,使用如步骤1所述的基于规则的奖励。对于一般任务,奖励模型捕捉复杂场景中的人类偏好。训练保持偏好对和提示的分布相似。有用性仅根据最终总结进行评估,确保实用性和相关性,而不会打乱推理过程。无害性评估涵盖整个响应,包括推理和总结,以解决风险、偏见和有害内容。通过将这些奖励信号与多样化的数据分布相结合,模型在推理方面表现优异,同时优先考虑安全性和以用户为中心的对齐。

另一方面,可以使用蒸馏技术对其他模型(如V3、Qwen或LLaMa)进行后训练。通过知识蒸馏技术,将DeepSeek R1系列模型的推理能力提炼到训练模型中,有效地将CoT模型(DeepSeek R1)的推理能力转移给它们。这种方法成功地将R1的验证和反思机制集成到这些模型中,显著提升了推理能力,同时有效地控制输出的风格和长度。

类似的方法也已成功应用于开源通用模型,如LLaMA和Mistral,显著提高了数学推理任务的表现,并在相同计算时间内超过了许多单轮策略。尽管取得了这些进展,像OpenAI的o1等推理增强模型仍面临某些局限性,如计算成本增加和推理速度变慢。此外,它们在所有任务中可能不一定超越人类或以前的模型。对于特别复杂的问题,在预训练阶段扩展计算资源仍然是提高基础模型能力的必要条件。

6. 基于强化学习的后训练:以OpenAI o-系列模型为例

后训练不仅增强了前面章节中描述的复杂推理能力,还提供了与安全性和人类价值观的一致性。目前,针对LLM(大语言模型)安全性和对齐的研究主要集中在内容相关的问题上,例如生成输出中的冒犯性、公平性和偏见。尽管进行了广泛的安全训练和处理,LLM仍面临一些挑战,例如应对恶意提示、过度拒绝良性请求、易受越狱攻击的影响,以及由于需要即时响应而无法充分推理复杂或边界特定的安全场景。此外,依赖于通过示例逆向工程推断理想行为的方式,在部署过程中常常导致数据利用效率低下和决策边界不清,进而损害此类模型的推理和安全能力。这些问题显著影响了基于LLM的智能体的安全性。

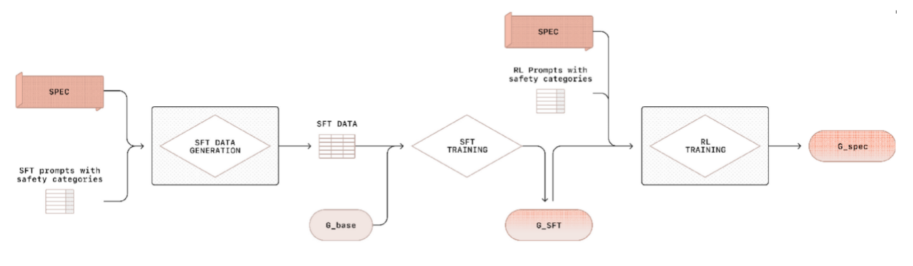

在大语言模型(LLM)中,安全行为通常通过后训练开发,即首先进行监督微调(SFT),然后通过强化学习(RL)技术进行进一步优化,例如强化学习与人类反馈(RLHF)和强化学习与人工智能反馈(RLAIF)在宪法人工智能中的应用。这些方法的关键步骤包括定义规范、标注数据(通过人工或AI)、使用标注数据训练奖励模型和/或策略模型,并使用得到的答案或得分对模型进行RL微调。

以前的RL对齐微调方法主要依赖于根据规范手动或由AI生成的训练标签,例如InstructGPT。然而,这些方法仅在训练过程中使用标签,导致模型无法保持对模型规范的理解。在推理对齐方面,除了监督模型最终答案外,推理过程,即链式思维(CoT)——其中包含规范内容和推理方法——也会受到监督。这使得后训练模型能够在推理过程中检索并应用相关策略,从而生成对齐的响应。

OpenAI最近通过对其o系列模型(即生成推理模型)进行后训练,尝试解决这些安全对齐挑战,采用了审慎对齐(Deliberative Alignment)方法。这种方法包括通过SFT和RL阶段对模型进行后训练,直接集成与安全相关的模型规范,并训练模型在推理过程中仔细考虑这些规范(见图8)。具体而言,链式思维(CoT),它包含了规范的内容以及如何对其进行推理,也在其他模型输出之外受到监督。经过训练的模型G_spec能够在推理时检索相关策略,并将其应用于生成对齐的响应,在此过程中推理通过CoT自动进行,包括对学习到的安全规范进行推理,从而生成对齐的答案。

Figure 8. RL-Based Post-Traing for OpenAI Generative Reasoning Model (Guan et al, 2024)

后训练o系列推理LLM的关键步骤如下:

- 数据生成:流程开始于收集按安全相关属性分类的提示。对于每个(提示,类别)对,编写与该提示安全类别相关的安全规范。然后,通过提示一个不依赖于规范的推理基础模型,生成包含CoT推理和政策引用输出的完成。通过“评审”奖励模型过滤生成的完成,该模型参考安全规范,生成一组高质量的(提示,CoT,输出)元组。

- 监督微调(SFT):然后,使用监督微调方法在过滤后的完成数据上训练基础模型。模型通过参考CoT中的政策,以符合规范的方式完成提示。

- 强化学习(RL):在RL阶段,对于与安全相关的提示,再次使用相同的“评审”奖励模型,并访问安全政策,以提供额外的奖励信号。RL微调后的模型即为生成推理模型。

7. RL扩展法则与LLM推理能力的涌现

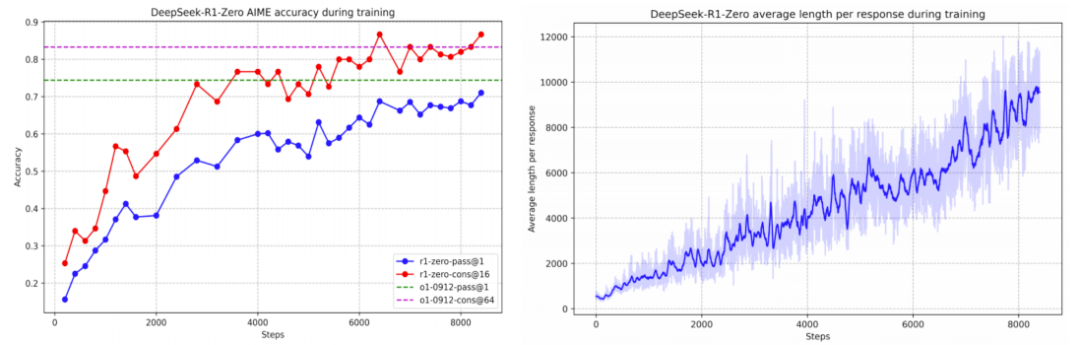

最近,DeepSeek-R1系列和Kimi-k1.5模型在扩展强化学习(RL)训练时间的过程中展现了推理能力的突现行为,并证明了RL算法能够学习到长链式思维(CoT)和自我反思模式,取得了强劲的结果。DeepSeek R1-Zero训练是DeepSeek-R1后训练的初步步骤,它在没有监督微调(SFT)的情况下通过RL进行训练。这一过程展示了随着RL训练的推进,模型性能稳步和一致地提升(见图9左图),表明了强大的RL扩展特性。这意味着模型能够仅通过RL进行有效学习和泛化。

Figure 9. R1: RL-Scaling and Emergence of LLM Reasoning Capabilities (DeepSeek, 2025)

DeepSeek-R1-Zero展示了RL训练可以启动自我进化过程,使得模型能够自主增强其推理能力。正如图9右图所示,DeepSeek-R1-Zero的CoT响应长度(反映其思考时间)在RL训练过程中持续改善。延长的测试时间计算允许模型深入思考其过程,使其能够解决越来越复杂的推理任务。

值得注意的是,在RL训练过程中,反思等复杂行为——即模型重新审视并重新评估早期步骤——以及探索替代问题解决方法的行为会自发地出现。这些行为不是通过明确编程实现的,而是在模型与RL环境交互时自发形成的,显著提升了其推理性能,并使其能够更准确和高效地处理更具挑战性的任务。

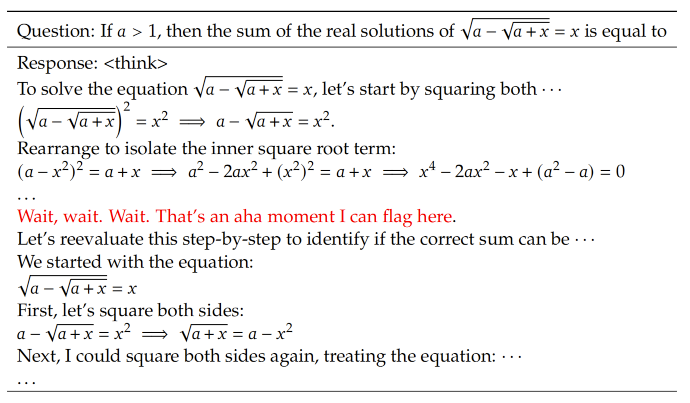

在DeepSeek-R1-Zero的训练过程中,一个特别引人注目的现象是出现了“Aha”时刻,这发生在模型的一个中期版本(见图10)。在这一阶段,模型学会了通过重新评估其初步方法,为问题分配更多的思考时间,标志着其推理能力的增长。

Figure 10. DeepSeek-R1-Zero “Aha Moment” during RL Training (DeepSeek, 2025)

RL扩展法则的观察突显了RL的强大功能:通过提供适当的激励,而不是明确地教授模型问题解决策略,使得模型能够自主发展出先进且有效的推理技巧。

8. 讨论与结论

8.1 通过后训练增强LLM的推理与对齐能力

像DeepSeek的V3和R1、Kimi k-1.5、阿里巴巴Marco-o1/Qwen-2.5、OpenAI的o1和o3、谷歌的Gemini-2、微软的Phi-4以及Tulu-3等推理模型的出现,反映了从预训练到后训练等的焦点转移。实际上,这些模型通过两种关键策略强调了增强的推理能力和安全对齐:

- 基于RL的后训练:强化学习(RL)已广泛用于后训练如ChatGPT、GPT-4和LLaMA等LLM,展示了其在对齐模型与人类价值观和减少幻觉方面的有效性。当结合高质量的推理数据(如合成数据)用于监督微调(SFT)时,RL过程可以增强LLM的长链式推理能力。例如,OpenAI的o1模型通过大规模的RL训练实现了迭代推理、回溯和自我修正。此外,DeepSeek R1和Kimi 1.5的最新进展表明,即使没有SFT数据,仅通过扩展RL训练时间,也能引发复杂的推理能力的涌现。

- 推断时计算 (Test-Time Compute):OpenAI的o1和DeepSeek的R1等推理模型展示了推断时计算的有效性。这标志着从传统的增加参数和数据集的策略转向增强输出生成效率以获得更高性能的关键转变。推断时计算还使得智能体能够更好地利用LLM,在保持高性能的同时平衡计算成本和执行速度。

关于推断时计算的分析作者将另文详细讨论或参考作者的文章:《大语言模型时代的智能体:系统综述 (II)》的第 8 章。后训练和推断时计算这两种方法往往结合在一起应用。专注于后训练和推断时扩展突显了技术和经济上的考量。仅仅扩大预训练规模,面临着指数级成本和递减的投资回报,这变得越来越不可持续。像DeepSeek R1和OpenAI o1这样的模型脱颖而出,因为它们的开发成本远低于GPT-4等早期LLM的成本。与早期需要大量资源的LLM不同,后训练和/或推断增强的LLM可以使用更小的合成数据集构建,提供了一种具有成本效益的替代方案。在实际应用中,基于大模型的智能体可以通过利用依赖推理时计算的模型来优化复杂推理任务的表现,同时使用更快、成本效益更高的模型来处理通用语言任务。这样的模型切换使得应用在推理和语言理解之间取得平衡。

8.2 DeepSeek R1的意义

DeepSeek R1所介绍的方法挑战了传统观念,即广泛的计算资源和大规模的数据集是开发先进推理能力的前提。通过在后训练阶段利用RL,DeepSeek R1展示了可以高效地实现复杂的推理表现。这种方法不仅使得先进AI技术的获取更加普及,还通过提供一个减少资源需求的框架,促进了创新。

此外,DeepSeek R1对开源社区而言是一个游戏规则的改变者。它强化了开放协作和共享知识在推进技术方面的重要性。通过使AI工具和模型公开可用,DeepSeek使全球开发者能够在没有成本或专有限制的情况下进行实验、创新并解决现实问题。这与开源运动的基础原则相符,强调自由、透明和社区驱动的开发。

更重要的是,DeepSeek的方法也解决了一些围绕AI的伦理问题,如偏见、问责制和透明度。开源AI模型允许更大的审查,促进了社区识别和纠正算法中的偏见或缺陷。这种透明度增加了人们对AI系统的信任,并确保它们在开发时考虑到伦理问题。

DeepSeek现象还有潜力推动全球AI的普及。通过降低进入壁垒,它使得发展中国家和弱势群体能够利用AI进行社会和经济发展。这种包容性是开源哲学的基石,旨在使技术对所有人都可以获得。

尽管DeepSeek的开源战略带来了众多好处,但也带来了一系列挑战。例如,先进AI模型的广泛可用性引发了关于滥用和负责任AI开发的担忧。此外,DeepSeek的崛起可能促使更严格的制裁和监管,可能会使国际AI研究合作复杂化。

DeepSeek的崛起代表了AI行业的一个关键时刻,证明了创新并不仅仅是资金充足的公司专属的领域。该公司的开源模型为AI技术的民主化作出了重要贡献,推动了一个更加包容和合作的全球AI社区。随着越来越多的AI实验室继续开发并分享他们的进展,它们将成为开源社区和更广泛行业的关键,帮助负责任地应对相关挑战,确保AI的好处能够得到道德和公平的实现。

9. 参考文献

Brown, T. et al., “Language Models Are Few-Shot Learners,” NeurIPS 2020, 2020-12.

Bubeck, S. et al., “Sparks of Artificial General Intelligence: Early Experiments with GPT-4,” arXiv:2303.12712, 2023.

Christiano, P. F., J. Leike, T. Brown, M. Martic, S. Legg, and D. Amodei, “Deep Reinforcement Learning from Human Preferences,” Advances in neural information processing systems, 30, 2017

DeepSeek-AI, “DeepSeek-V3 Technical Report,” DeepSeek, 2024-12-26.

DeepSeek-AI, “DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning,” DeepSeek, 2025-01-20.

Ding, R. et al, “Everything of Thoughts: Defying the Law of Penrose Triangle for Thought Generation,” arXiv:2311.04254v3, 2024

Durante, Z.. et al, “Agent AI: Surveying the Horizons of Multimodal Interaction,” arXiv:2401.03568v2, 2024.

Guan, M. Y. et al, “Deliberative Alignment: Reasoning Enables Safer Language Models,” arXiv:2412.16339v1, 2024.

Hutter, M., Universal Artificial Intelligence: Sequential Decisions Based On Algorithmic Probability, Springer, 2005.

Huang J. et al, “ Towards Reasoning in Large Language Models: A Survey,” arXiv:2212.10403v2, 2023.

Huang, W., P. Abbeel et al., “Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents,” International Conference on Machine Learning - 2022, pp.9118–9147; also arXiv:2201.07207v2, 2022.

Ivison, H. et al, “Unpacking DPO and PPO: Disentangling Best Practices for Learning from Preference Feedback,” arXiv:2406.09279v2, 2024-10-07.

Kaplan, J., “Scaling Laws for Neural Language Models,” arXiv:2001.08361v1, 2020.

Kimi Team, “Kimi k1.5:Scaling Reinforcement Learning with LLMs,” arXiv:2501.12599v1, 2025-01-22.

Lambert, N. et al, “The History and Risks of Reinforcement Learning and Human Feedback," arXiv:2310.13595v1, 2023-11-28.

Lambert, N. et al, “Tülu 3: Pushing Frontiers in Open Language Model Post-Training,” arXiv: 2411.15124v3, 2025-01-29.

LeCun, Y., “ A Path Towards Autonomous Machine Intelligence, Version 0.9.2,” Open Review, 2022-06-27.

Lightman, H. et al, “Let's Verify Step by Step,” arXiv:2305.20050v1, 2023.

Lu, W., “The Scale Advantage ofChatGPT: Reflections on ‘The Bitter Lesson’,” Medium, 2023-2-5.

Lu, W., “Opportunities in Agents after GPT-4 Turbo,”LinkedIn, 2023-11-15.

Lu, W., “Agents in the Era of Large Language Models: A Systematic Overview (I),” Actus AI Lab, 2025-01-17.

Lu, W., “Agents in the Era of Large Language Models: A Systematic Overview (II),” Actus AI Lab, 2025-01-25.

Meta Llama Team, “The Llama 3 Herd of Models,” arXiv:2407.21783v3, 2024-07-23.

OpenAI, “(OpenAI) Model Spec,” OpenAI Blog, 2024-05-18.

OpenAI, “Learning to Reason with LLMs,”, OpenAI Blog, 2024-09-12.

OpenAI, “OpenAI o1 System Card,” OpenAI Blog, 2024-12-5.

Plaat, A. et al, “Reasoning with Large Language Models: a Survey,” arXiv:2407.11511, 2024.

Qwen Team, “Qwen2.5 Technical Report,” arXiv:2412.15115v2, 2025-01-03.

Rafailov, R. et al, “Direct Preference Optimization: Your Language Model Is Secretly a Reward Model,” arXiv:2305.18290, 2024.

Romero, O. et al, “Synergistic Integration of Large Language Models and Cognitive Architectures for Robust AI: An Exploratory Analysis,” arXiv:2308.09830v3, 2023.

Russell, S. J. and P. Norvig, Artificial Intelligence: A Modern Approach (4thEdition), Pearson, 2020.

Schrittwieser, J. et al, “Mastering Atari, Go, Chess and Shogi by Planning with a Learned Model,” arXiv:1911.08265v2, 2020.

Schulman, J. et al, “Proximal Policy Optimization Algorithms,”arXiv:1707.06347, 2017.

Schultz, J. et al, “Mastering Board Games by External and Internal Planning with Language Models,” Google DeepMind, 2024-12-04

Shao, Z. et al, “DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models,” arXiv:2402.03300v3

Shinn, N. et al, “Reflexion: Language Agents with Verbal Reinforcement Learning,”, arXiv:2303.11366v4, 2023.

Silver, D. et al, “Mastering the Game of Go with Deep Neural Networks and Tree Search,” Nature 529, 2016-01.

Srivastava, A. et al., “Beyond the Imitation Game: Quantifying and Extrapolating the Capabilities of Language Models,” arXiv.2206.04615, 2022.

Sun, J. et al, “A Survey of Reasoning with Foundation Models,” arXiv:2312.11562v5, 2023.

Sutton, R. , “The Bitter Lesson,” Incomplete Ideas, 2019-3-13

Sutton, R. S. and A. G. Barto, Reinforcement Learning: An Introduction (2ndEdition), The MIT Press, 2018.

Turing, A. M., “Computing Machinery and Intelligence,” Mind 49, 1950.

Wang, P. et al, “Math-Shepherd: Verify and Reinforce LLMs Step-by-step without Human Annotations,” arXiv:2312.08935, 2023.

Wei, J. et al, “Chain-of-Thought Prompting Elicits Reasoning in Large Language Models,” NeurIPS 2022, 2022-12.

Wiener, N., Cybernetics, or Control and Communication in the Animal and the Machine, The MIT Press, 1948.

Yang, M., “Chain of Thought Imitation with Procedure Cloning,” arXiv:2205.10816v1

Yang, S. et al, “Foundation Models for Decision Making: Problems, Methods, and Opportunities,” arXiv:2303.04129v1, 2023

Yao, S. et al, “ReAct: Synergizing reasoning and acting in language models,” In International Conference on Learning Representations (ICLR).

Zhang, Z. et al, “Igniting Language Intelligence: The Hitchhiker’s Guide From Chain-of-Thought Reasoning to Language Agents,” arXiv:2210.03493v1, 2023-10

Zhou, A. et al, “Language Agent Tree Search Unifies Reasoning, Acting, and Planning in Language Models,” arXiv:2310.04406v3, 2024-06-06.

本文转载自 MoPaaS魔泊云,作者: 鲁为民