DeepSeek-R1-Zero激发了推理Scaling Law

本文将散落在近期多篇文章中笔者围绕激发推理Scaling Law的思考做了一下整理。

方向

MIT对大模型数理原理的强有力证明中总结:

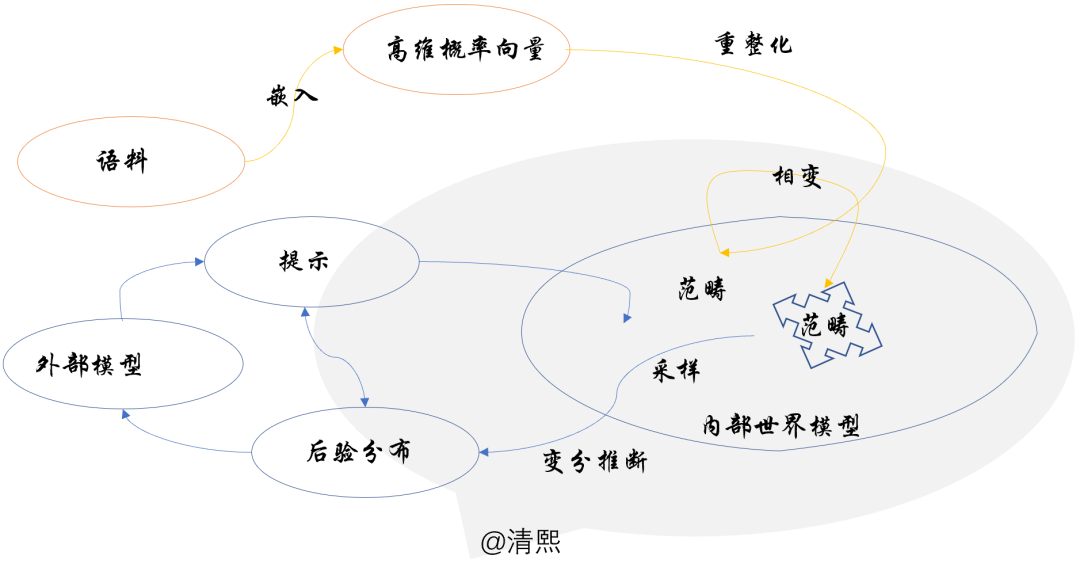

基于宏大的人类知识提取出来丰富范畴,形成众多领域的本体知识结构,这是大模型通过预训练已经构建的内部世界模型;提高推理采样的机制,通过训练达成学习推理的scaling law,是大模型下一步努力提升的方向。

相比传统方法,新的大模型机理,具备更高维度的新颖性、对能力和技术细节的探索,可以通过揭示隐藏的联系建立更广泛有用的创新框架。AI 知识图驱动的跨学科研究可能会成为科学和哲学探索的有力工具。

框架

DeepSeek R1 与 Kimi 1.5 的推理强化学习中梳理了整体框架:

在已训练的LLM世界模型的基础上,进行专注推理策略的第二阶预训练,给LLM构建完整的“大脑皮层”,进而皮层指挥LLM推理生成:

图片

图片

1. 积累推理语料:目前人类推理被“语料化”最多的领域,笔者能想到的还是注释的代码、LLM自己积累的人类提示的思维链、应试答题步骤、科学文献中的推导、逻辑与哲学的思辨等,欢迎大家补充;

2. 预训练推理策略生成器:有针对性地基于这些推理语料做预训练,从中“重整化”提炼出特殊的“推理范畴”,作为整体世界模型采样变分推理的策略生成器(直接从整体范畴中分离并精调“推理范畴”或许亦可行);

3. 策略驱动世界模型变分推理:依据预训练的推理策略生成器生成的最佳策略,在LLM内部整体范畴上,也就是内部世界模型上,做范畴内或跨范畴采样变分推理。

策略

重新思考 MoE 进一步解读 “MoE 其实 = 推理采样策略” :

MoE里的“专家”是一种拟人的形象化的说法,如果全文替换成“特定范畴”,读者会发现MoE其实本质上是基于某种人类先验“知识”或“策略”的“跨范畴采样”:

“在外部感官输入下(被提示置于某种上下文),大模型内部将限定在相应的高维语言概率空间的子空间内推理;推理是在子空间中采样,类比时跨范畴采样”。

目前 MoE 可以理解为一种分布式采样策略,可以GShard硬编码,或进一步DeepSeekMoE细分,也可以如MoDE基于噪声更灵活调节策略,亦或引入某种优化器(类似SQL优化器),并最终依赖推理的scaling law涌现出策略。

技术

通往ASI的大模型推理,详细分析了支撑LLM推理涌现的技术:

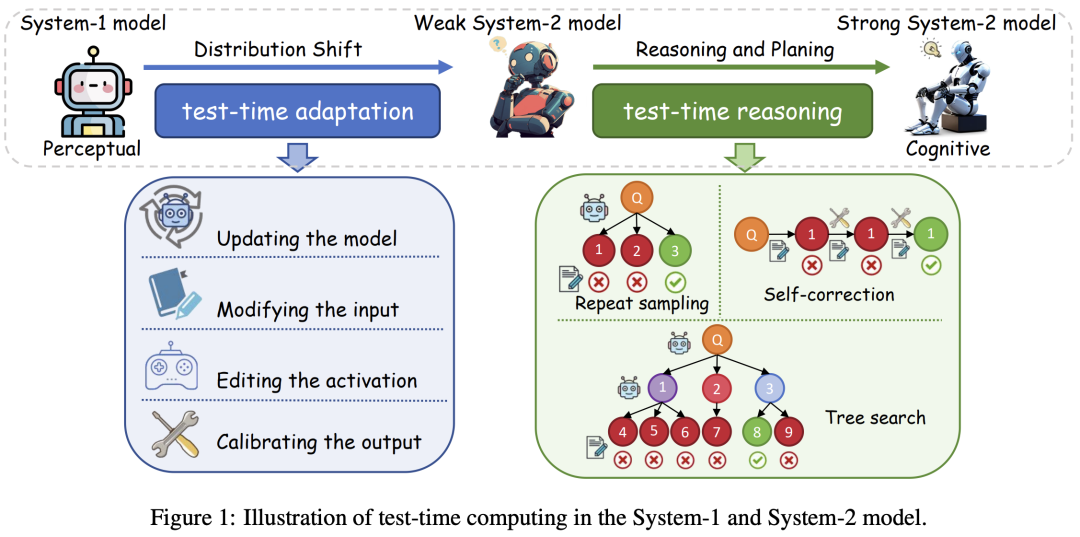

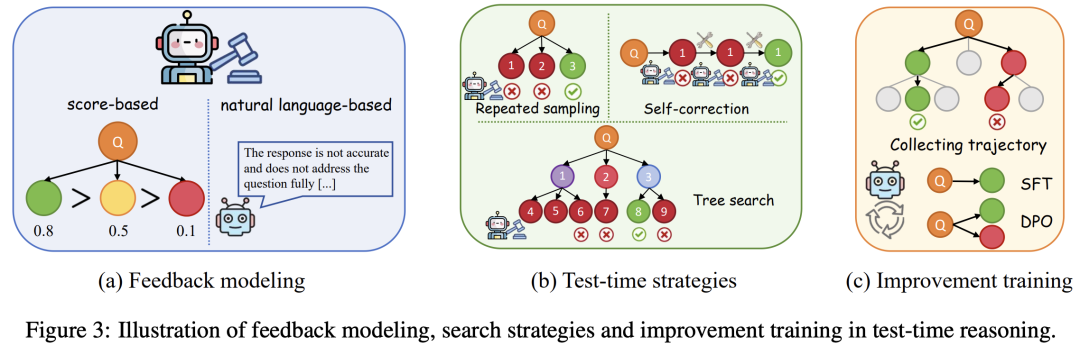

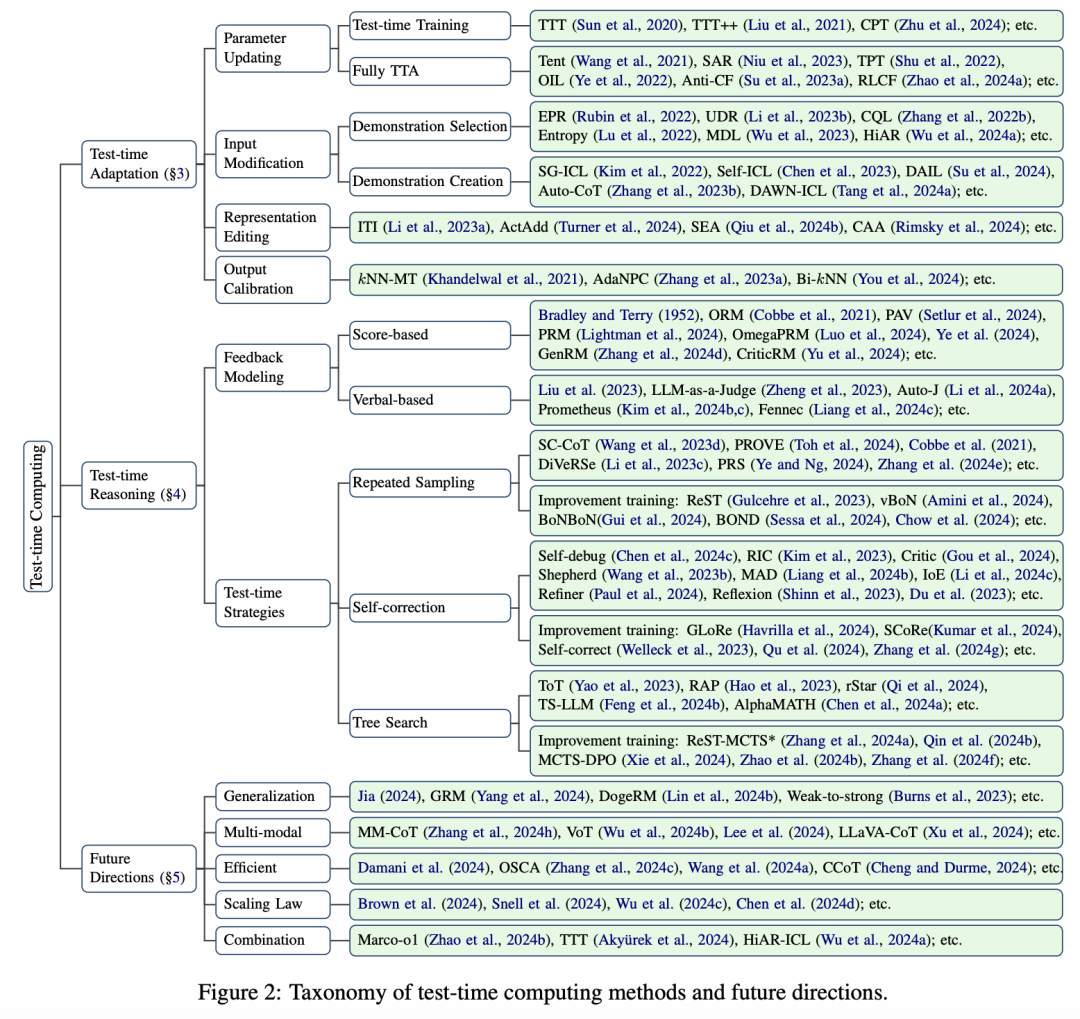

测试时计算(Test-time Computing)也被寄予厚望。苏州大学、新加坡国立大学和蚂蚁集团的研究人员探索了测试时计算,追踪了其从 System-1 到 System-2 模型的演变。

测试时计算最初应用于 System-1 模型,通过参数更新、输入修改和输出校准来解决分布偏移并增强稳健性,现在使用重复采样、自我校正和树搜索等策略加强了 System-2 模型中的推理。

测试时适应(TTA)在推理过程中使用测试样本信息微调模型。关键考虑因素包括学习信号、参数更新和确保效率。测试时训练 (TTT) 学习信号使用辅助任务,而完全测试时适应 (FTTA) 利用内部反馈(如熵最小化)。

笔者认为,测试时计算模型更新,等于利用测试样本信息在推理阶段进一步微调了模型参数,使模型能够适应测试分布。这样不仅学了更多的内容(测试语料),还反复推敲学习如何采样变分用于推理,本质是积累了推理的范畴。

测试时计算的训练方式,如果推广到更大范围的语料(甚至重复利用预训练时期的语料),可以积累更多推理范畴,从而提升推理能力。预训练的语料中,也有大量类似的推理场景,针对此类场景,采用测试时适应,或类似的测试时计算的策略,在预训练时就可以同时积累推理的范畴,即推理内化成内部世界模型中的一部分。

突破

DeepSeek R1 与 Kimi 1.5 的推理强化学习, 简要分析了DeepSeek强化学习变体:

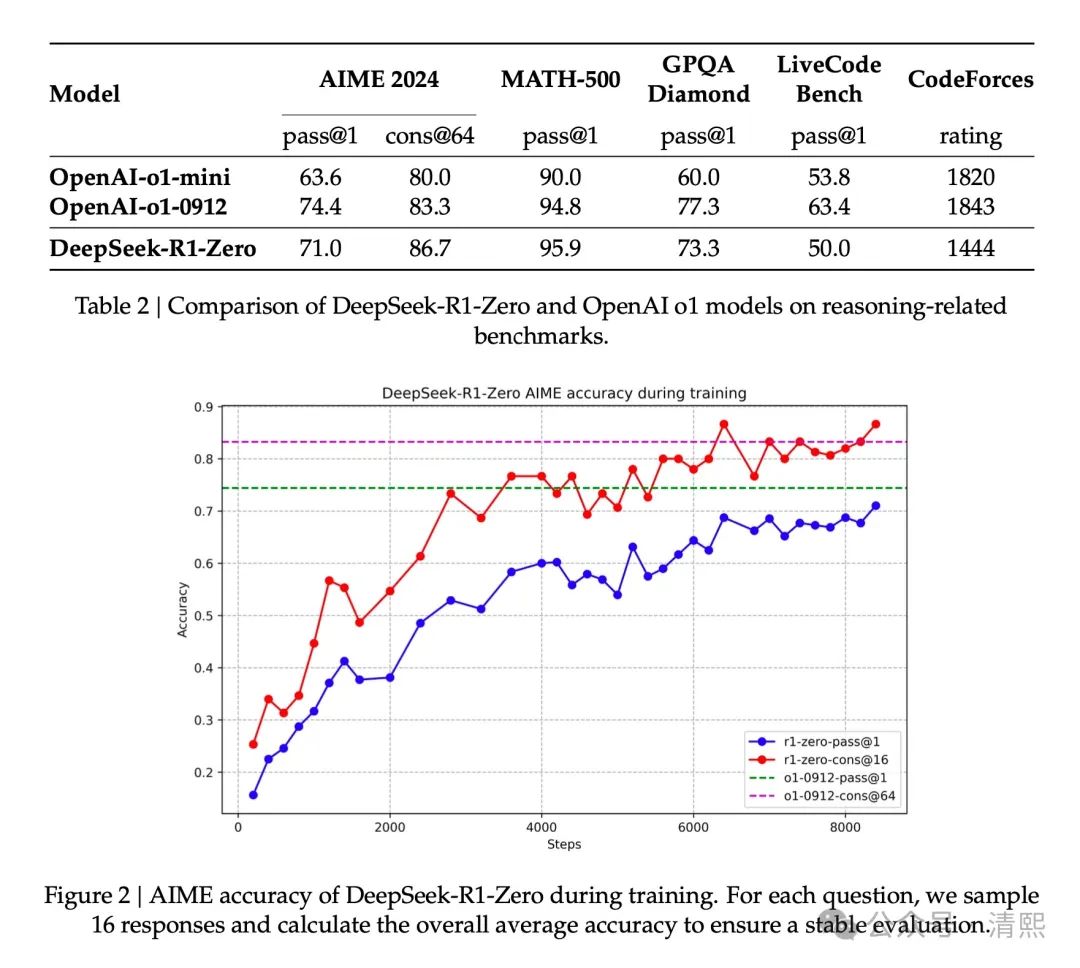

DeepSeek R1没有使用监督微调(SFT)作为冷启动,转而通过大规模强化学习(RL)提升大模型推理能力。DeepSeek-R1-Zero 没用任何SFT数据,直接将RL应用于基础模型,DeepSeek-R1则是从经过数千个长链式推理(CoT)示例微调的检查点开始应用RL。

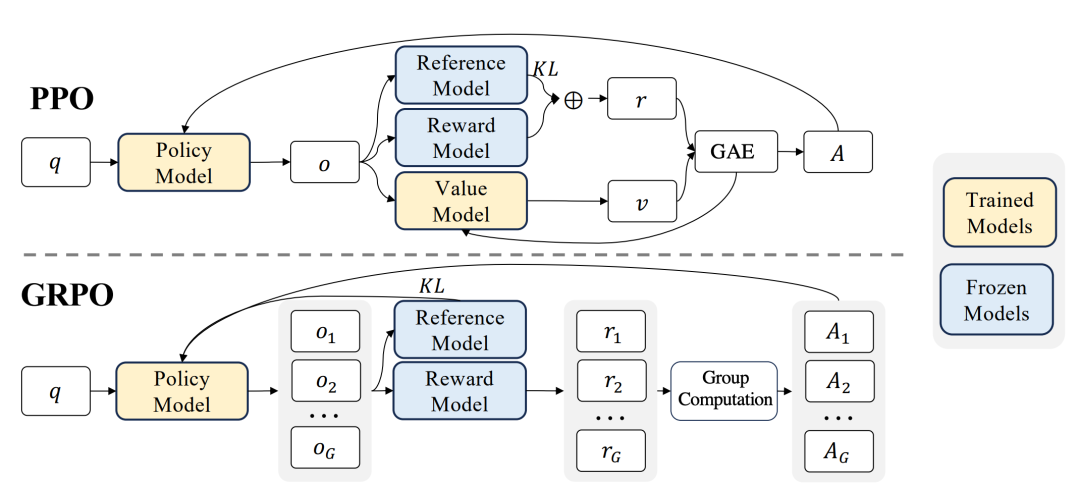

DeepSeekMath的组相对策略优化(GRPO)是R1成功的关键。GRPO是近端策略优化(PPO)的变体,PPO是广泛用于LLM 微调阶段的演员-评论家(actor-critic)强化学习算法。

PPO中使用的价值函数通常是另一个与策略模型规模相当的模型,会带来巨大的内存和计算负担,而且在LLM上下文中,通常只有最后一个token会被奖励模型分配奖励分数,而在每个token上训练一个准确的价值函数很困难。

因此,GRPO摒弃了通常与策略模型规模相同的评论家模型,而是使用针对同一问题生成的多个采样输出的平均奖励作为基线。

DeepSeekMath不仅引入GRPO,而且给出极具深度的洞察:监督微调(SFT)、奖励微调(RFT)、直接偏好优化(DPO)、近端策略优化(PPO)、组相对策略优化(GRPO)在迈向统一的范式。

监督微调(SFT):在人类筛选的 SFT 数据上对预训练模型进行微调。

拒绝采样微调(RFT):RFT 在基于 SFT 问题从 SFT 模型采样的过滤输出上进一步微调 SFT 模型。RFT 根据答案的正确性对输出进行过滤。

直接偏好优化(DPO):DPO 通过使用成对 DPO 损失在从 SFT 模型采样的增强输出上微调 SFT 模型,进一步优化模型。

在线拒绝采样微调(在线 RFT):与 RFT 不同,在线 RFT 使用 SFT 模型初始化策略模型,并通过从实时策略模型采样的增强输出进行微调来优化模型。

PPO/GRPO:PPO/GRPO 使用 SFT 模型初始化策略模型,并通过从实时策略模型采样的输出进行强化学习来优化模型。

原理

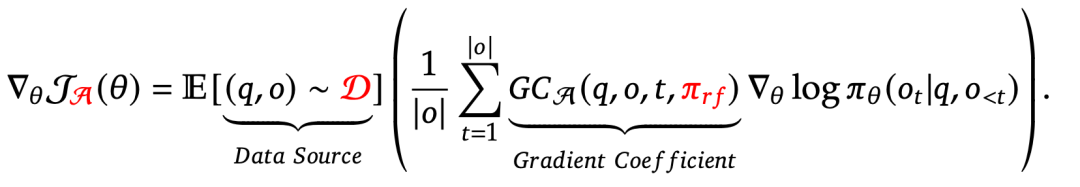

GRPO 是DeepSeek魔法的源泉 阐述了GRPO本质:

组内多采样与大数定理:

GRPO平均奖励的有效性可能直接源于大数定理,作为概率基础理论支撑,大数定理可以确保奖励基线估计的统计合理性。

近似实现最优输运:

GRPO通过采样同一问题的多个输出(组内样本),计算其平均奖励作为基线,并对奖励进行归一化(减去组均值,除以标准差)。这一过程本质上是在对齐组内输出的经验分布,使其向高奖励区域集中。

将组内样本的原始奖励分布视为源分布,高奖励区域视为目标分布。GRPO的归一化操作类似于OT中的分布归一化,旨在减少分布间的统计差异。通过优化策略使生成分布向目标分布传输,隐式利用了Wasserstein距离的特性。

GRPO舍弃大规模价值模型,利用组内样本统计量降低计算复杂度,组内归一化基线估计与OT中的小批量近似或切片Wasserstein距离思路一致,通过有限样本近似全局分布特性。优势函数仅依赖组内相对奖励,类似OT中局部耦合的构造,减少高维空间的计算负担。

实践

DeepSeek-R1与R1-Zero通过创新强化学习技术,突破传统LLM依赖监督微调(SFT)的局限,成功实践并开创了推理能力自我进化的新范式。

R1-Zero完全跳过SFT阶段,摒弃传统PPO算法中的价值模型,直接在基础模型DeepSeek-V3-Base上应用GRPO纯强化学习方法训练。模型自发学会延长思维链、重新评估初始答案并修正错误,甚至出现类似人类“顿悟时刻”的行为。

模型实际推理能力惊人,在AIME 2024数学竞赛中的Pass@1准确率从15.6%跃升至71.0%,多数投票后达86.7%,媲美顶尖闭源模型。

R1优化改进了R1-Zero可读性差、语言混合等问题,通过冷启动SFT、多阶段强化学习、拒绝采样与蒸馏等策略实现训练效率与推理能力的平衡。

R1系列的突破不仅体现在性能上,更揭示了LLM通过自我迭代不断增强推理能力的可能,笔者认为其技术路径的成功实践,是通往AGI的重要里程碑。

扩展

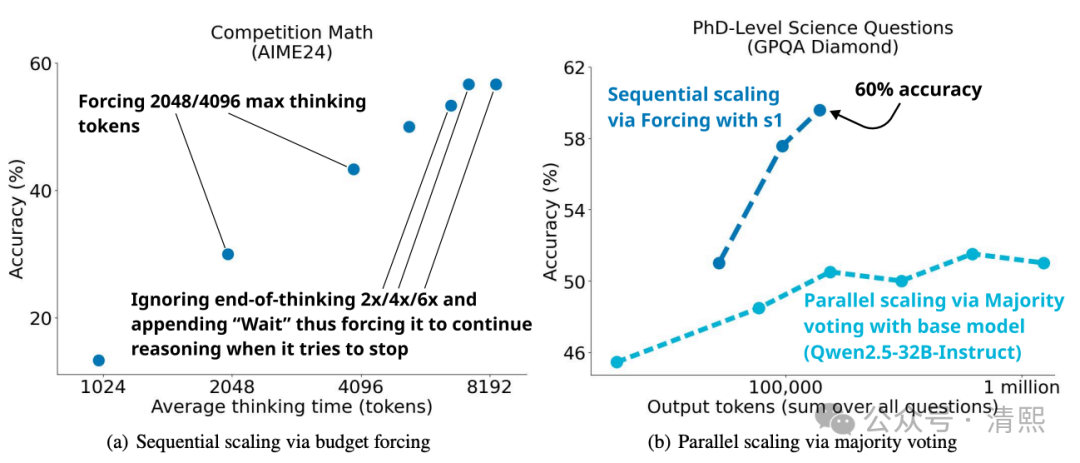

更近一步,斯坦福近期提出了一种名为"s1:简单测试时扩展"的方法,在语言建模中实现了测试时计算的高效扩展[文献1] 。

通过仅使用1000个样本的监督微调,结合预算强制技术,显著提升了模型的推理能力,尤其在数学竞赛任务中超越了OpenAI的闭源模型o1-preview,展现出极高的样本效率。

学者们构建了包含1000个问题的小型数据集s1K,问题覆盖难度、多样性和质量三个维度,通过消融实验验证其有效性。

然后通过预算强制技术控制模型的思维过程,实现测试时计算的动态扩展,包括强制终止并输出当前最佳答案,多次追加"Wait"指令延长思考,迫使模型回溯推理步骤,修正错误路径等。

基于Qwen2.5-32B-Instruct模型,在s1K数据集监督微调并应用预算强制技术后,数学竞赛MATH和AIME24上的表现超过o1-preview最高达27%。进一步扩展测试时计算量后,无干预时AIME24准确率从50%提升至57%。

这是样本效率的革命,传统方法需依赖数以万计的微调示例(如R1使用近百万样本强化学习),而s1仅用1000样本即达到同等水平。

简单测试时扩展,验证了模型预训练阶段已具备推理潜力,微调仅需"激活"这一能力。这类似笔者在“框架”部分提到的“直接从整体范畴中分离并精调“推理范畴”。

文献1,s1: Simple test-time scaling,https://arxiv.org/abs/2501.19393