DeepSeek核心架构-MLA:剖析低秩联合压缩优化KV缓存、提升推理效率的技术细节

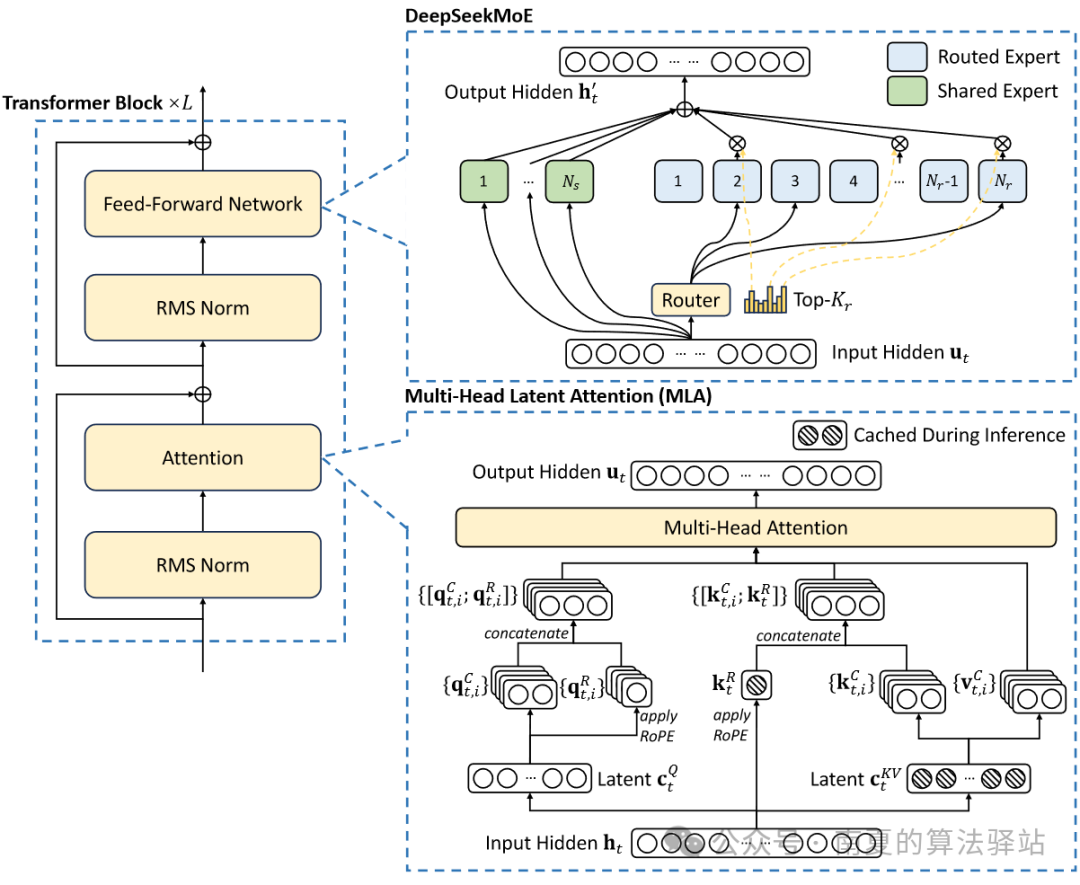

DeepSeek的基本架构仍然在Transformer框架内,每个Transformer模块由一个注意力模块和一个前馈网络组成。为实现更高效的推理和更经济的训练,在注意力和前馈网络部分,设计并使用了创新的MLA(Multi-Head Latent Attention)和DeepSeekMoE 架构。

本文将从MLA的提出背景、技术原理、解耦RoPE策略及MHA与MLA的缓存对比方面进行详细阐述。

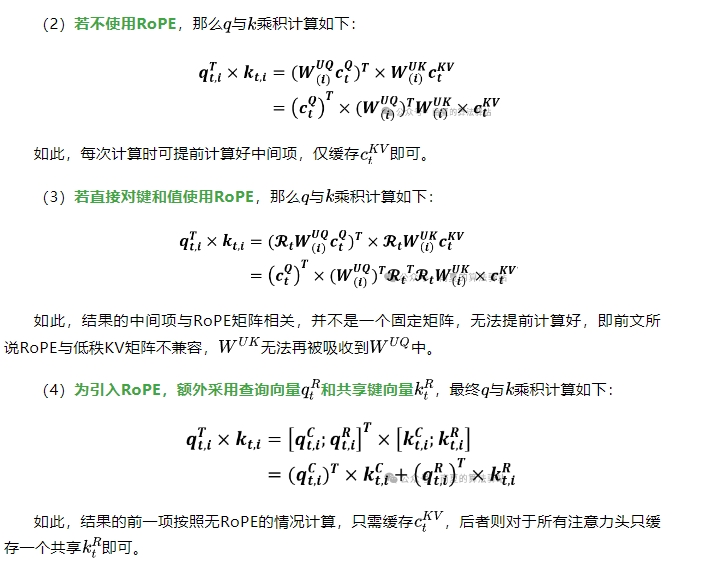

MLA是对多头自注意力机制(MHA)的改进,其核心是对键(Keys)和值(Values)进行低秩联合压缩,生成压缩的潜在向量,以降低推理阶段的KV缓存。

1.MHA

(1)MHA的详细原理。

(2)在自注意力机制中,每个位置的查询Q需要与序列中所有位置的键(K)进行相似度计算得到注意力分数,然后加权值(V)获得最终的输出值。Transformer模型生成序列时采用自回归方式,即在生成当前Token时需依赖所有之前生成的Token。因此,对于每个时间步,都需要与之前所有Token进行注意力计算。为避免重复计算之前所有Token的键和值,从而需要缓存所有的键和值来加速计算。

(3)MHA在推理过程中需要缓存所有的KV来加速推理,但是在模型部署中,这种量级的KV缓存带来了高显存占用问题,限制了最大Batch size的大小和序列长度。

2.MLA原理

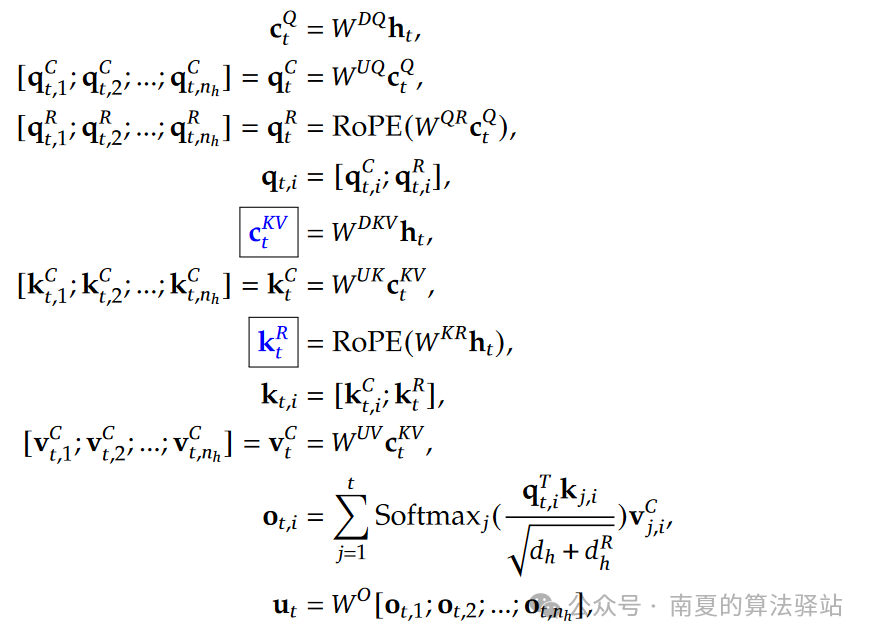

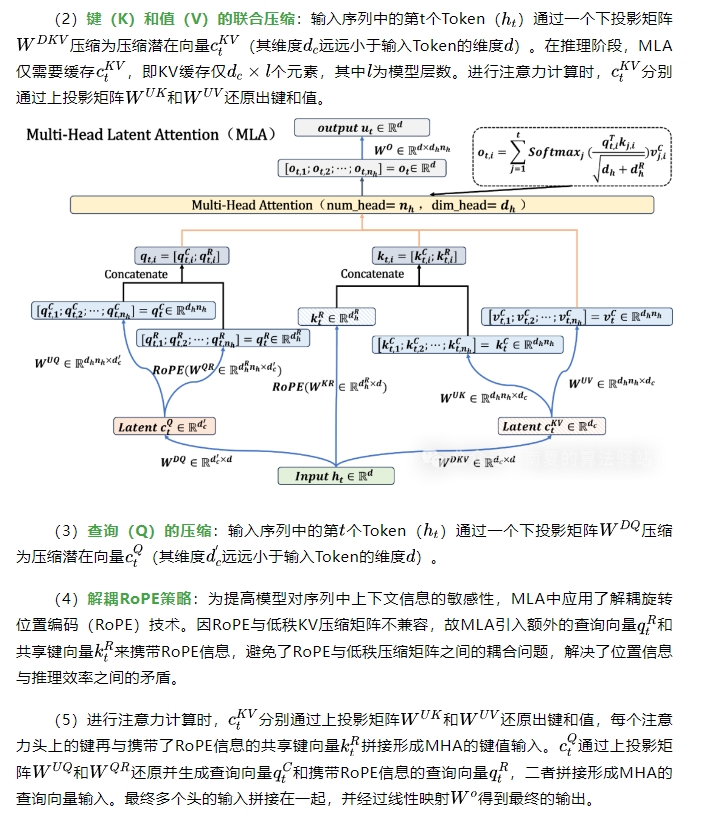

(1)MLA的完整计算公式和维度变化示意图如下,可对照查看。

图片

图片

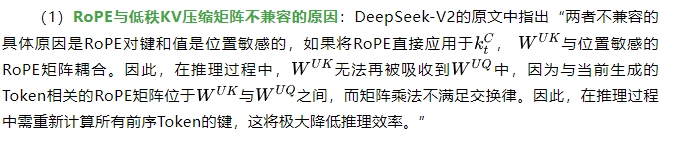

3.解耦RoPE策略详解

备注:矩阵吸收计算是指利用矩阵乘法的结合律或低秩分解等线性代数技巧,重新组合某些矩阵因子,使原本需要独立计算的矩阵乘积合并在一起,从而降低计算复杂度和内存开销的过程。

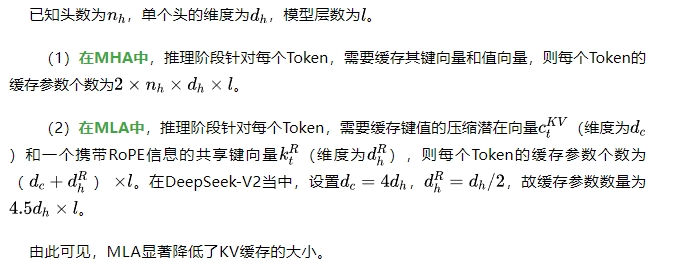

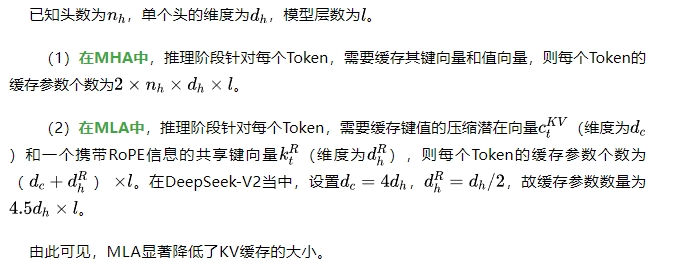

04|MHA与MLA的缓存对比

本文转载自 南夏的算法驿站,作者: 南夏的算法驿站