一文搞懂 DeepSeek - 强化学习和蒸馏 原创

这个春节,DeepSeek 实在太火爆了。

DeepSeek-R1 在其论文(https://arxiv.org/abs/2501.12948)引言部分指出,R1 模型通过融合冷启动数据、多阶段训练流程以及纯粹的强化学习策略,显著增强了大型语言模型的推理能力。这使得 R1 模型在性能上与 OpenAI 的 o1 系列模型持平,并且通过蒸馏技术,成功地将这种推理能力传递给了更小型化的模型。

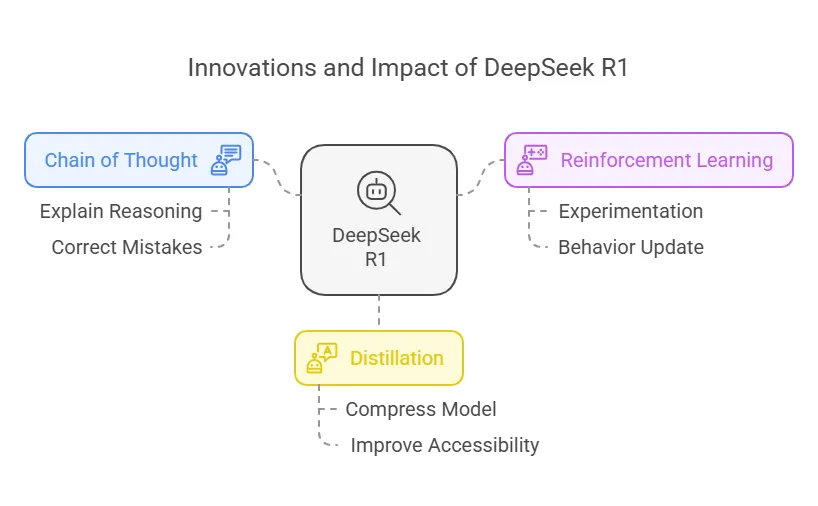

在 DeepSeek-R1 的“贡献”章节中,着重强调了以下两点创新:

1.模型训练完成后:对基础模型实施了大规模的强化学习训练。通过这种方式,DeepSeek-R1 在基础模型的基础上,成功培育出了自我验证和长思维链等高级推理能力。

2.蒸馏技术:小型模型也能具备强大能力。本研究还证明了,大型模型的推理模式可以有效地通过蒸馏技术转移到小型模型中,从而显著提高小型模型的性能。

1、Post-Training:大规模强化学习

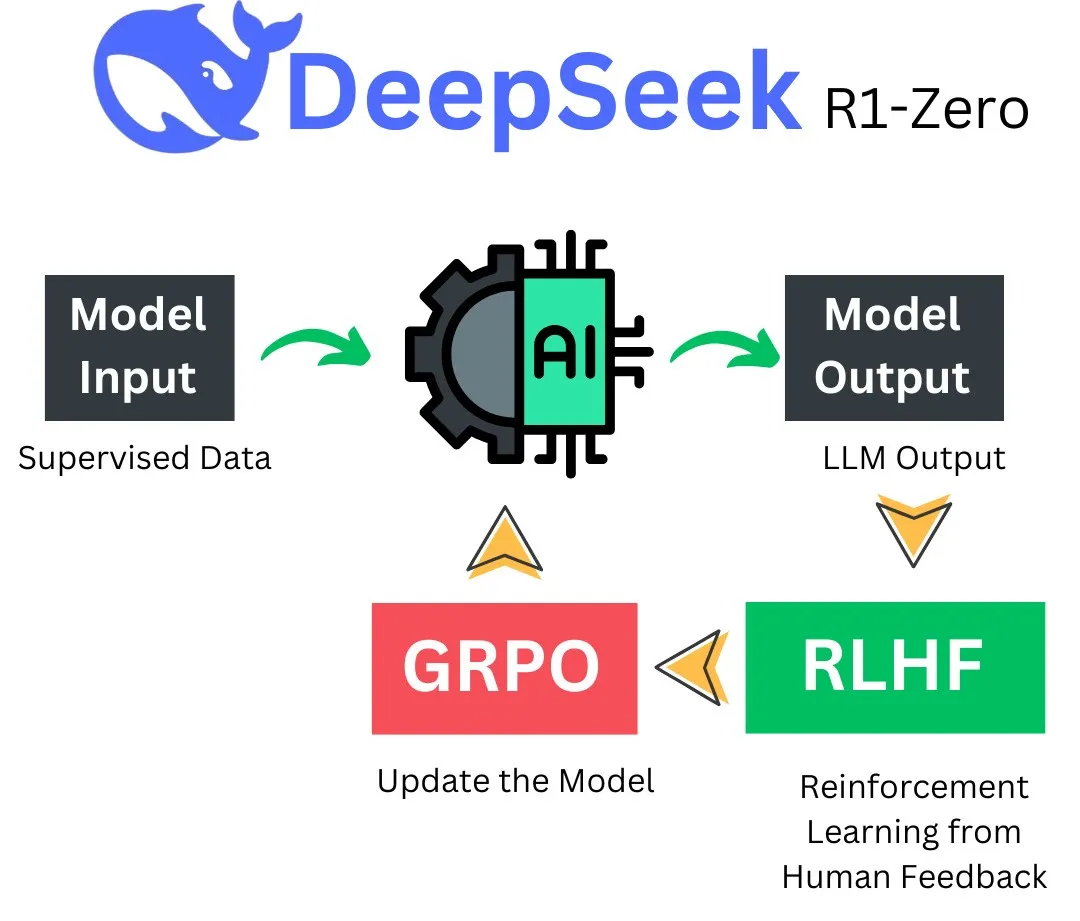

DeepSeek-R1-Zero 揭示了,大语言模型(LLMs)的推理能力能够仅依靠强化学习得到提升,无需进行监督微调。DeepSeek 采取的策略是在基础模型上直接实施强化学习,跳过了监督微调这一预备步骤。这种做法使得模型能够深入探索解决复杂问题的思维链,进而孕育出具备自我验证、反思以及长思维链生成能力的 DeepSeek-R1-Zero,为学术研究树立了一个重要的里程碑。通过纯粹的强化学习手段,而非监督微调,DeepSeek 成功激发了 LLMs 的推理潜能,这一技术革新为领域的发展开辟了新路径。中国的这一 0-1技术创新令硅谷震动,甚至导致英伟达市值大幅波动。

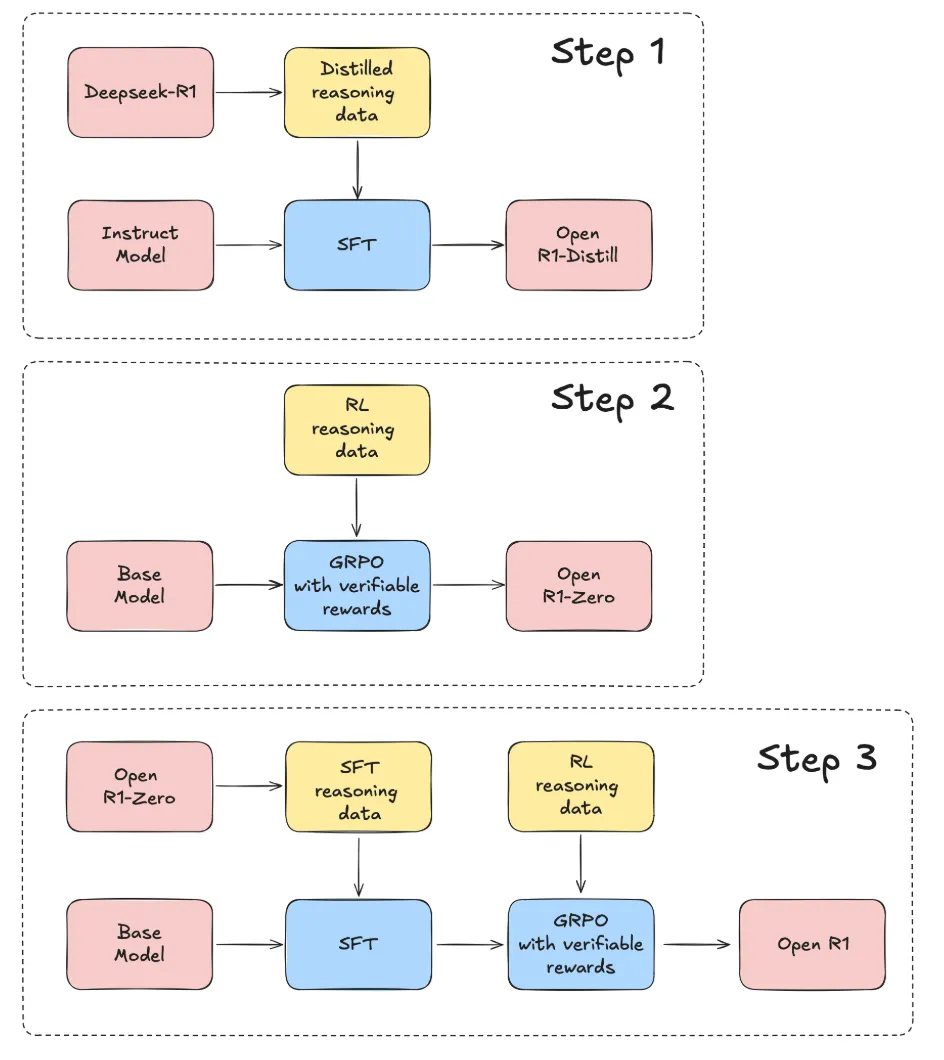

DeepSeek-R1 的开发流程是怎样的?R1 的开发流程涉及两个强化学习阶段,目的是发掘更优的推理模式,并与人类偏好相契合。此外,流程中还包含两个监督微调阶段,这些阶段构成了模型推理和非推理能力的基础。DeepSeek 坚信,这一流程将有助于构建更出色的模型,从而为整个行业带来益处。

2、蒸馏:小模型同样强大

蒸馏技术是否真的能让小型模型同样强大?事实证明,大型模型的推理模式可以通过蒸馏技术转移到小型模型中,这种方法相较于仅在小型模型上应用强化学习发现的推理模式,能够实现更卓越的性能表现。

开源的 DeepSeek-R1 及其 API 将助力研究界在未来提炼出更优秀的小型模型。DeepSeek-R1 系列通过蒸馏得到的小型模型在多项基准测试中展现出显著优势,超越了先前开源的模型。特别是 DeepSeek-R1-Distill-Qwen-32B,其性能足以与 o1-mini 匹敌,而 DeepSeek 已向学术界开源了基于 Qwen2.5 和 Llama3 系列的不同参数规模的模型,包括 150亿、70亿、80亿、140亿、320亿 和 700亿参数的检查点。这一颠覆性的0-1技术创新,让硅谷的技术巨头们感到不安,因为这一创新已在全球技术人员的验证下,证实了基于 R1 论文方法可以成功蒸馏出与 o1-mini 性能相当的小型模型。再次向梁文峰大神致敬。

那么,如何蒸馏出 DeepSeek-R1-Distill-Qwen-32B 呢?以下是详细的蒸馏步骤:

第一步、确定模型角色

1、教师模型:选取表现卓越、知识渊博的DeepSeek-R1作为指导。

2、学生模型:选择参数适中、适合蒸馏的Qwen-32B作为学习对象。

第二步、准备数据集

1、数据收集:整合跨领域的高质量文本数据,为蒸馏打下基础。

2、数据预处理:对数据集进行严格筛选和处理,确保蒸馏效果不受数据质量影响。

第三步、模型训练与蒸馏

1、教师模型推理:DeepSeek-R1提供软标签和中间层特征,作为Qwen-32B的学习标准。

2、学生模型训练:Qwen-32B模仿DeepSeek-R1的行为,吸收其知识和经验。

3、损失函数设计:使用KL散度或交叉熵等,衡量学生模型与教师模型之间的差异。

4、优化算法选择:采用SGD或Adam等算法,优化学生模型参数,降低损失函数值。

第四步、模型评估与调优

1、模型评估:使用独立的测试数据集,比较学生模型与教师模型的表现,以评估蒸馏效果。

2、模型调优:根据评估结果,调整超参数、优化损失函数等,以提高蒸馏效果。

本文转载自公众号玄姐聊AGI 作者:玄姐