9B参数吊打GPT-4V!NVIDIA开源新模型(Eagle 2),竟靠“透明数据”逆袭? 原创

01、概述

近年来,视觉-语言模型(VLMs)在人工智能领域的迅猛发展,极大拓展了机器处理多模态信息的能力。然而,在这项技术的进步背后,依然存在着一些亟待解决的挑战。像 GPT-4V 和 Gemini-1.5-Pro 这样的专有模型虽然表现出色,但它们的透明度较低,这限制了它们的适应性和开放性。而开放源代码的替代模型常常因数据多样性、训练方法和计算资源的限制,难以与这些专有模型抗衡。此外,关于后期训练数据策略的文献资料相对匮乏,使得这些模型的复制和改进变得困难。

为了解决这些问题,NVIDIA AI 推出了 Eagle 2,一款采用结构化、透明的数据策划和模型训练方法的视觉-语言模型(VLM)。Eagle 2 提供了一个全新的视角,让开放源代码社区能够在不依赖专有数据集的情况下,构建具有竞争力的 VLM。

02、Eagle 2:以透明为核心的数据策略

Eagle 2 的最大亮点在于它的开放数据策略。与大多数仅提供训练权重的模型不同,Eagle 2 详细介绍了数据收集、过滤、增强和选择的整个过程。这一做法的目标是为开放源代码社区提供一套完整的工具,使得社区成员可以在透明的框架下开展自己的 VLM 开发工作,而不再依赖于封闭的专有数据集。

Eagle2-9B 是 Eagle 2 系列中最先进的模型,其性能已经能够与一些拥有 70B 参数的模型媲美,证明了在优化后期训练数据策略的同时,不必消耗过多的计算资源。

03、Eagle 2 的三大创新亮点

Eagle 2 的成功,离不开以下三大创新:

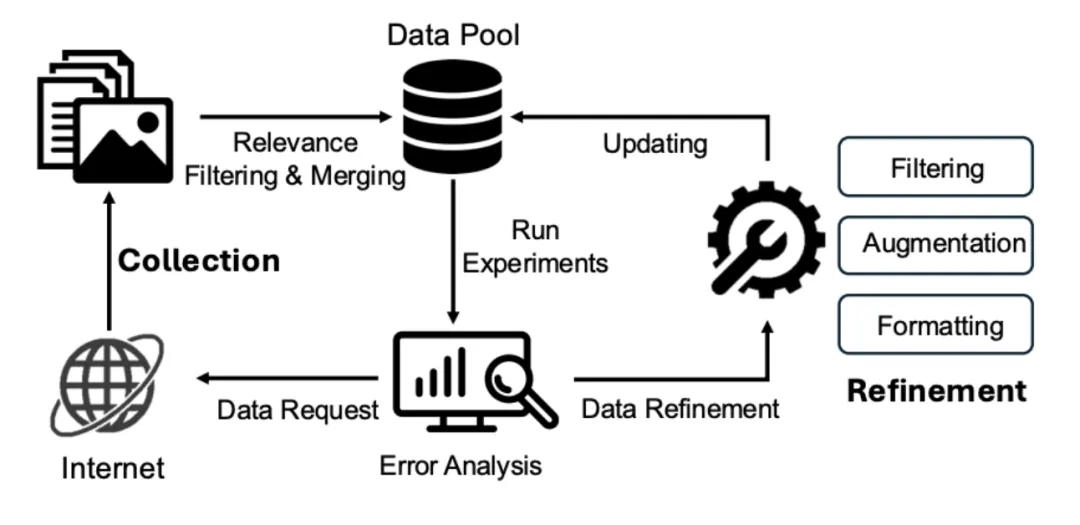

1) 数据策略:多样性优先,质量为先

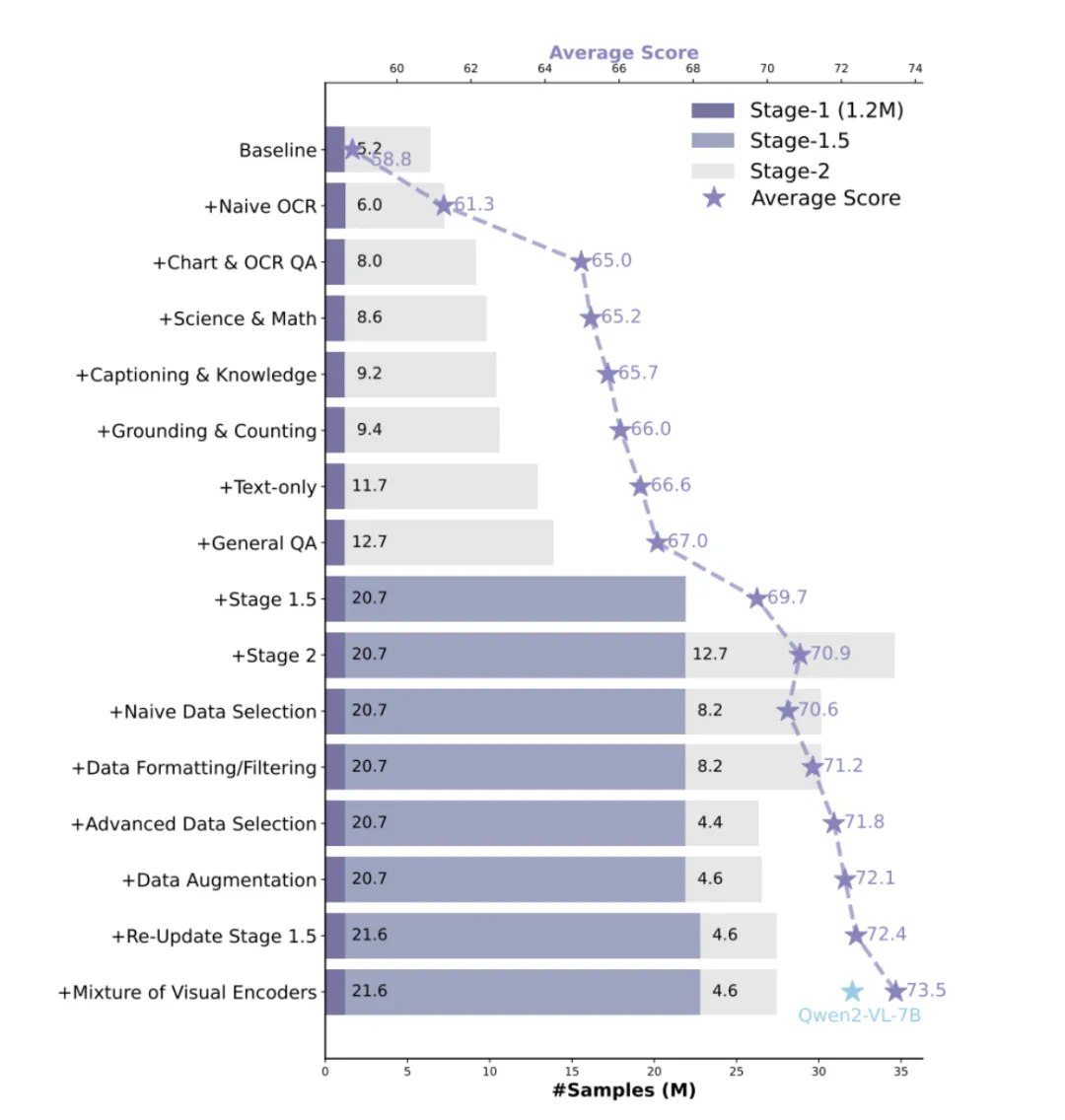

Eagle 2 的数据策划遵循 “多样性优先,质量为先” 的原则。首先,从超过 180 个数据源中采集数据,随后通过筛选和选择进行精炼。在这个过程中,Eagle 2 引入了详细的数据处理流程,包括错误分析、链式思维(CoT)推理、基于规则的问答生成以及数据格式化,旨在提高训练效率。

2) 三阶段训练框架:逐步提升模型能力

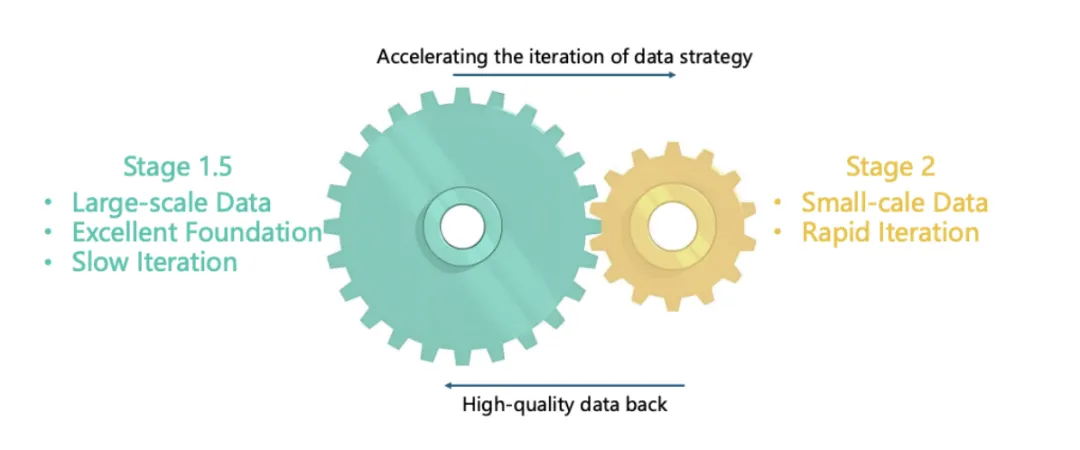

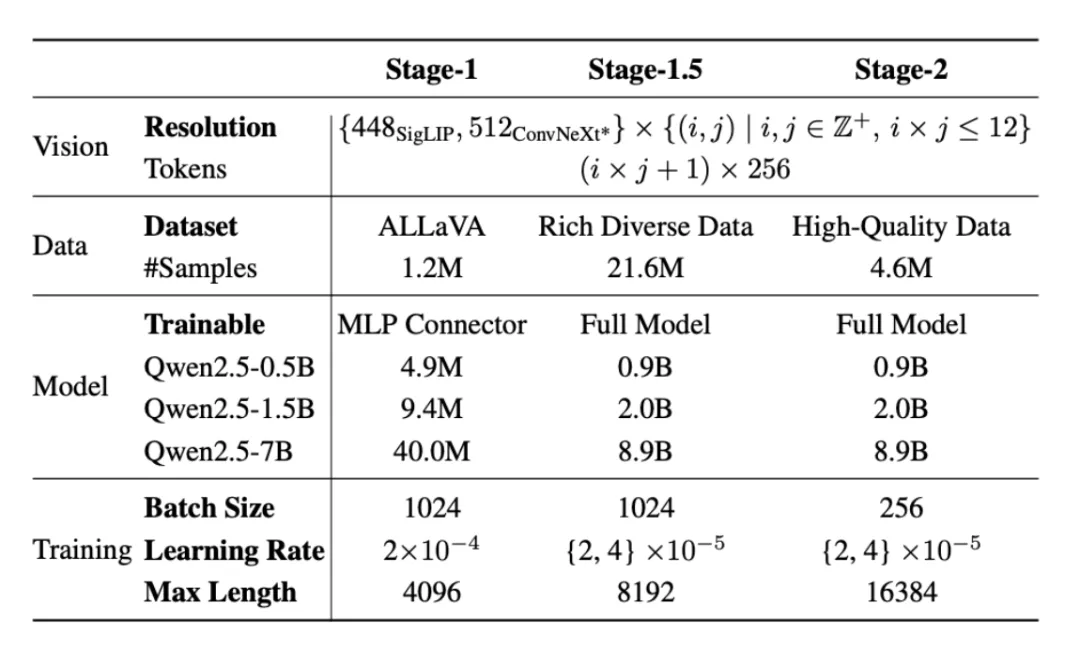

Eagle 2 的训练方法分为三个阶段,每个阶段都在强化模型的不同能力:

- 阶段 1:通过训练多层感知器(MLP)连接器,调整视觉和语言的跨模态对接。

- 阶段 1.5:引入更大规模的数据,进一步夯实模型的基础。

- 阶段 2:使用高质量的指令调优数据集对模型进行微调,提升其在实际应用中的表现。

3) Tiled Mixture of Vision Encoders(MoVE)架构

Eagle 2 采用了两种视觉编码器——SigLIP 和 ConvNeXt,结合高分辨率的切片方法确保在处理图像时,能够高效地保留细粒度的图像细节。此外,Eagle 2 还通过一种平衡意识的贪心背包方法优化了数据打包,提高了样本效率,同时减少了训练成本。

04、Eagle 2 的性能与基准测试

Eagle 2 经历了严格的性能测试,展现了出色的多项基准测试表现:

- DocVQA:Eagle2-9B 在该任务中达到了 92.6% 的准确率,超越了 InternVL2-8B(91.6%)和 GPT-4V(88.4%)。

- OCRBench:在该任务中,Eagle 2 取得了 868 分,超越了 Qwen2-VL-7B(845)和 MiniCPM-V-2.6(852),展示了其在文本识别方面的强大能力。

- MathVista:Eagle 2 的表现较基准提升了超过 10 个点,进一步验证了三阶段训练方法的有效性。

- 多模态推理任务(如 ChartQA 和 OCR QA):Eagle 2 在这些任务中也表现出色,超越了 GPT-4V。

此外,Eagle 2 的训练过程经过优化,采用了先进的子集选择技术,将数据集的规模从 1270 万样本减少至 460 万样本,同时保持了准确性,并提高了数据利用效率。

05、总结:Eagle 2 —— 更具透明度和开放性的 VLM 解决方案

Eagle 2 的发布,标志着在使高性能视觉-语言模型更加可访问和可复制方面迈出了重要一步。通过强调透明的数据驱动方法,Eagle 2 在开放源代码社区与专有模型性能之间架起了桥梁。它在数据策略、训练方法和视觉架构上的创新,使其成为研究人员和开发者的理想选择。

通过公开分享其方法论,NVIDIA AI 不仅促进了一个协作的人工智能研究环境,还使得社区成员可以在此基础上进一步创新,而不必依赖封闭的源代码模型。随着人工智能技术的不断演进,Eagle 2 将成为思考数据策划和训练策略如何推动 VLM 发展的典范。

本文转载自公众号Halo咯咯 作者:基咯咯

原文链接:https://mp.weixin.qq.com/s/OI0ykpgOR9v6h2RawYW-6Q