带你一文读懂爆火的 DeepSeek-R1 新模型技术,为何震动了全球 AI 圈 原创 精华

这个春节,DeepSeek 实在太火爆了。

短短一个月不到,DeepSeek 再次震撼了全球人工智能领域。

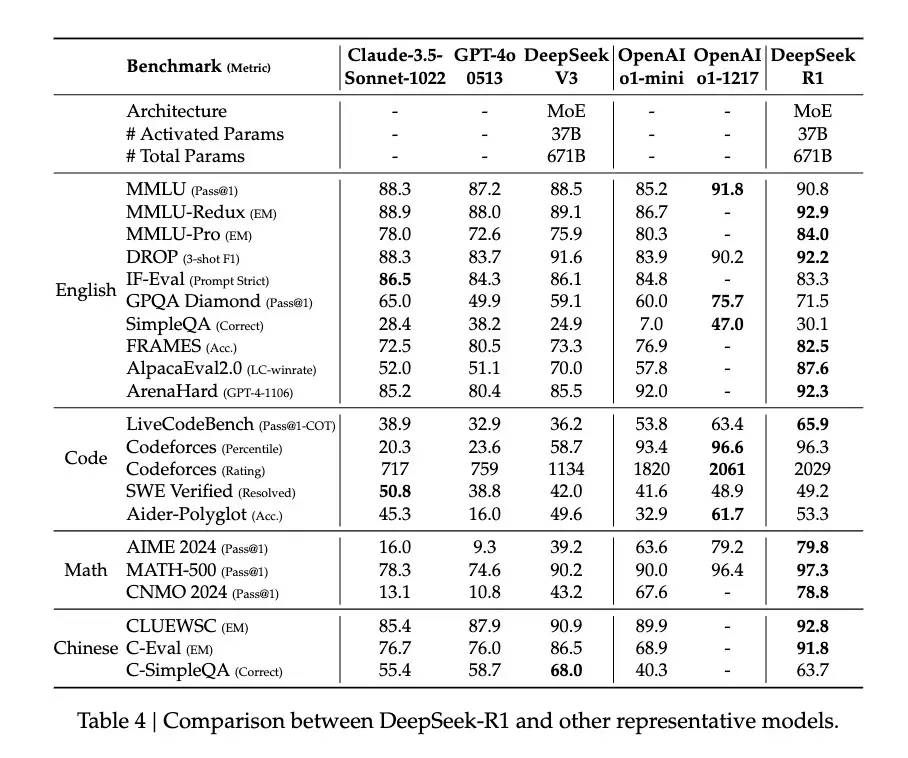

在去年12月,DeepSeek 推出的 DeepSeek-V3 在全球 AI 界引起了轩然大波,它凭借极低的训练成本,达到了与 GPT-4o、Claude Sonnet 3.5 等顶级模型媲美的性能表现。

与之前不同的是,此次推出的 DeepSeek-R1 模型不仅在成本上更具优势,而且在技术层面实现了质的飞跃,更重要的是,它是一款开源模型。

新模型 DeepSeek-R1 继承了高性价比的特点,仅需十分之一的成本就能达到 GPT-o1 级别的性能。因此,许多行业人士纷纷宣称“ DeepSeek 有望取代 OpenAI”。

举例来说,前 Meta AI 员工、著名 AI 论文推特博主 Elvis 指出,DeepSeek-R1 的论文堪称珍宝,因为它深入探讨了提升大语言模型推理能力的多种途径,并揭示了其中的显著涌现特性。

英伟达 GEAR Lab的项目主管 Jim Fan 在 Twitter 上提及,DeepSeek-R1 利用硬编码规则计算出的实际奖励,从而规避了使用易于被 RL 破解的学习奖励模型。这种方法促成了模型自我反思和探索行为的自然涌现。

Jim Fan 甚至表示,DeepSeek-R1 实现了 OpenAI 本应采取的行动——开源。

那么,他们提及的纯粹基于 RL 方法训练的模型究竟指的是什么?

模型展现的“顿悟时刻”(Aha Moment)又是如何证明 AI 已经具备了涌现能力的?

我们更感兴趣的是,DeepSeek-R1 的这一创新对人工智能领域未来的发展方向,究竟蕴含着怎样的意义?

1、用最简单的配方,回归最纯粹的强化学习

自 o1 模型发布以来,推理强化成为了行业内的焦点方法。

通常情况下,一个模型在训练过程中会采用一种固定的训练方法来增强其推理能力。

然而,DeepSeek 团队在 R1 模型的训练中,大胆尝试了三种截然不同的技术路线:直接强化学习训练(R1-Zero)、多阶段逐步训练(R1)以及模型蒸馏,并且都取得了成功。这两种训练方法和模型蒸馏都蕴含了众多创新元素,对整个行业产生了深远的影响。

尤其令人振奋的是直接强化学习这条路径。DeepSeek-R1 成为了首个验证这一方法有效性的模型。

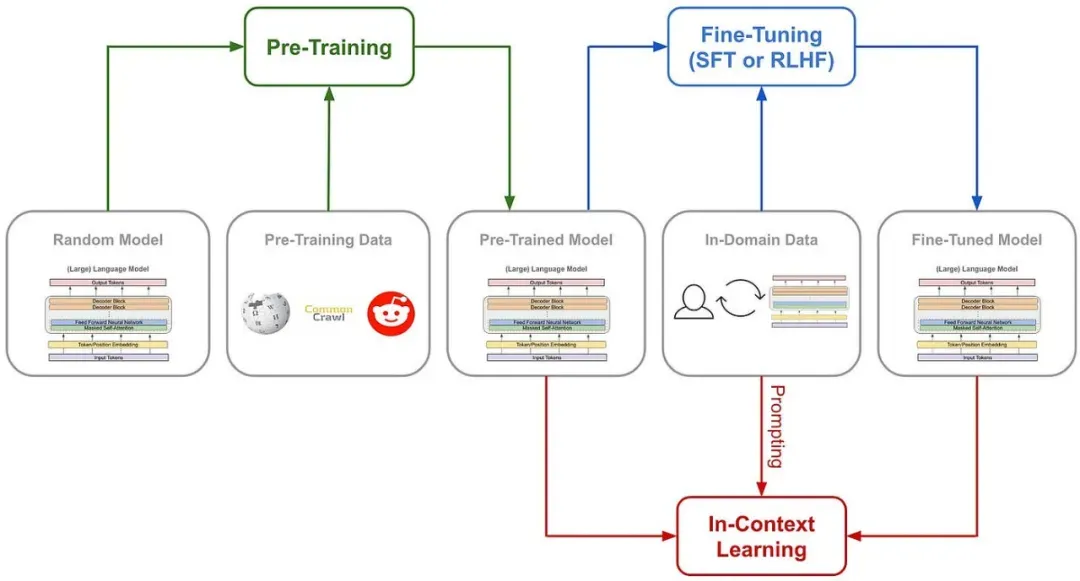

让我们先来探讨一下,传统训练 AI 推理能力的常用方法是什么,如下图所示:通常是在监督式微调(SFT)中引入大量的思维链(COT)示例,通过示例和复杂的神经网络奖励模型,如过程奖励模型(PRM),来教会模型如何进行思维链式的思考。

有时还会结合蒙特卡洛树搜索(MCTS),使模型能够在多种可能性中寻找最佳答案。

DeepSeek-R1-Zero 采用了前所未有的策略,即“纯”强化学习路径,完全摒弃了预先设定的思维链模板(Chain of Thought)和监督式微调(SFT),仅通过简单的奖励和惩罚信号来优化模型的行为。

这好比是让一个天才儿童在没有范例和指导的情况下,仅通过不断的尝试和接收反馈来自学解题。

DeepSeek-R1-Zero 仅配备了一套基础的奖励系统,旨在激发 AI 的推理能力。

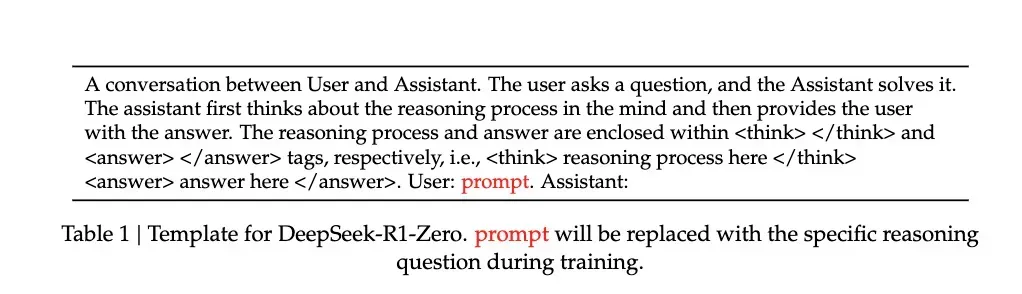

这套系统的规则非常简单,只有两条:

准确性奖励:模型根据其响应的正确与否来获得奖励或惩罚。正确回答得到加分,错误回答则扣分。评估标准也很直接:例如,在数学问题中,模型需要以特定的格式(如分数和小数)提供最终答案;在编程问题中,则通过编译器根据预设的测试用例来生成反馈。

格式奖励:模型必须将其思考过程放在特定的标签之间,以获得格式奖励。未能这样做会扣分,反之则加分。

为了更准确地观察模型在强化学习(RL)过程中的自然发展,DeepSeek 甚至刻意将系统提示词(如下图所示)限制在这种结构化的格式上,以避免任何针对特定内容的偏见——比如强制模型进行反思性推理或推广特定的解题策略。

正是基于这样一套简化的规则,A I能够在 GRPO(Group Relative Policy Optimization)的框架下进行自我采样和比较,从而实现自我提升。

GRPO 的方法论相当直接,它通过比较组内样本来计算策略梯度,这样不仅有效减少了训练过程中的不稳定性,还提升了学习效率。

换句话说,可以将其类比为老师出题,模型对每个问题给出多个答案,然后根据之前提到的奖励和惩罚规则对每个答案进行评分,模型根据追求高分、避免低分的逻辑进行自我更新。

整个流程大致如下:

输入问题 → 模型产生多个答案 → 规则系统进行评分 → GRPO计算相对优势 → 模型更新

这种直接的训练方法带来了几个明显的优势。首先,训练效率得到了显著提升,整个流程可以在更短的时间内完成。其次,资源消耗减少,因为省去了SFT和复杂的奖励模型,计算资源的需求大幅降低。

更为关键的是,这种方法确实让模型学会了如何思考,并且是通过“顿悟”这种方式来学习的。

2、用自己的语言,在“顿悟”中学习

我们是如何判断模型在这样一套“原始”方法下真正学会了“思考”的呢?

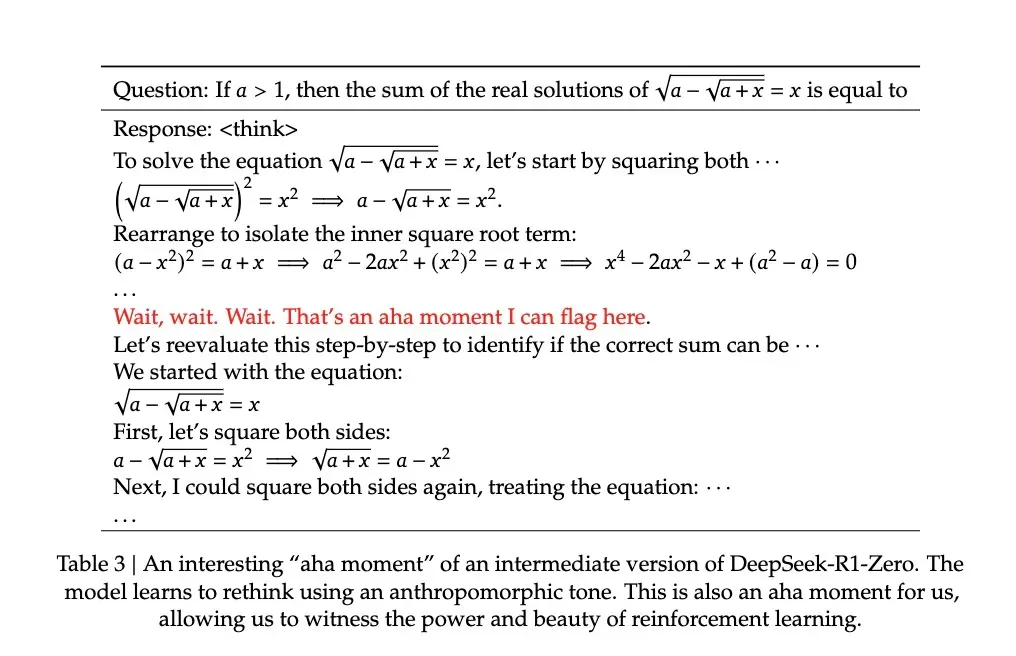

研究论文中记录了一个令人瞩目的例子:在解决一个包含复杂数学表达式 √a - √(a + x) = x 的问题时,模型突然停下来并说道:"Wait, wait. Wait. That's an aha moment I can flag here"(等等、等等,这是一个值得标记的顿悟时刻),然后它重新审视了整个解题过程。这种类似于人类顿悟的行为是自发产生的,而非预先编程的结果。

这种顿悟通常标志着模型思维能力的飞跃。

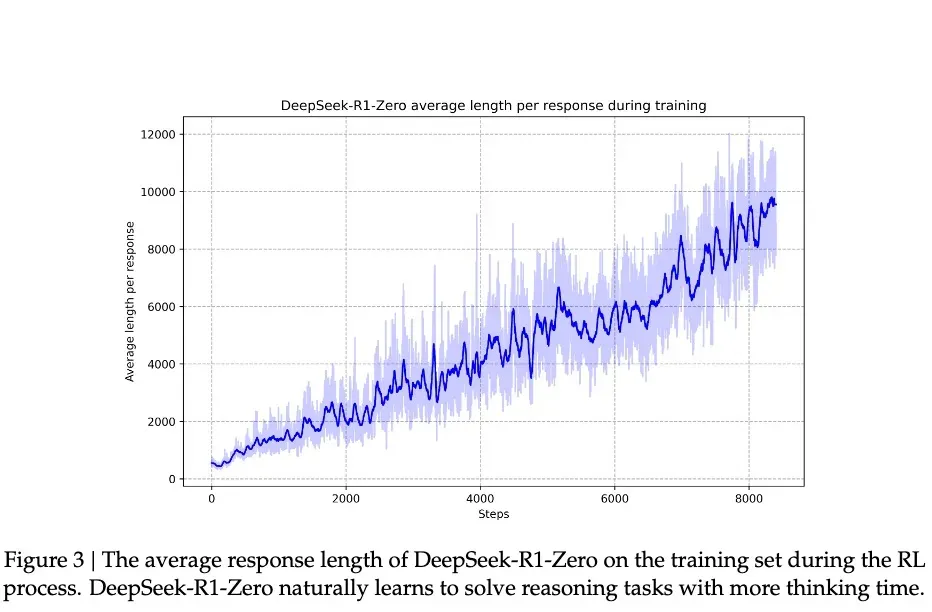

根据 DeepSeek 的研究,模型的进步并非平滑渐进的。在强化学习的过程中,模型的响应长度会突然显著增加,这些“跳跃点”往往伴随着解题策略的本质变化。这种模式与人类长时间思考后突然的领悟相似,暗示着某种深层的认知突破。

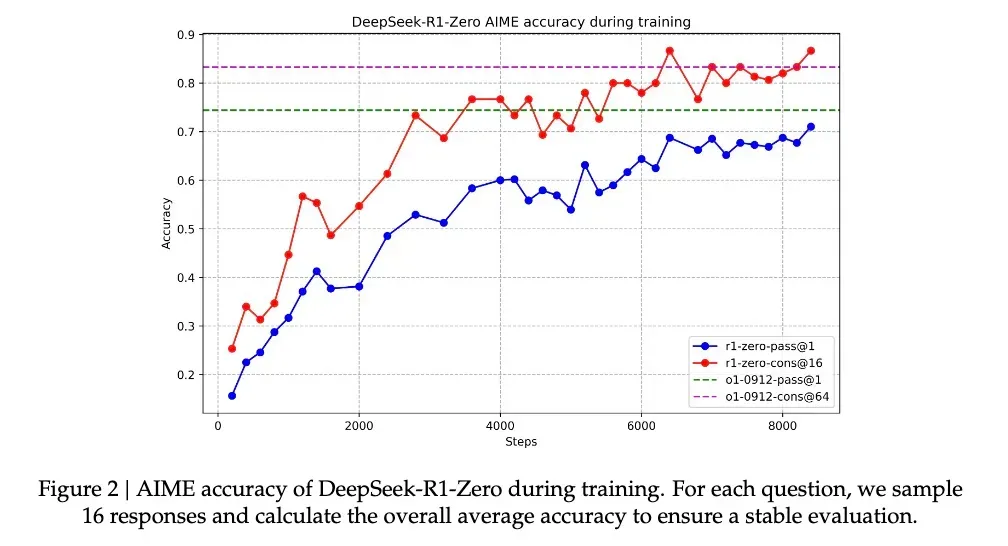

在这种伴随顿悟的能力提升下,R1-Zero 在备受数学界推崇的 AIME 竞赛中的正确率从最初的 15.6% 飙升至 71.0%,而在对同一问题进行多次尝试后,准确率甚至达到了 86.7%。这不仅仅是看过问题就能解决那么简单—— AIME 的题目需要深入的数学直觉和创造性思维,而非机械的公式应用。模型的这种提升表明它必须具备推理能力。

另一个证明模型确实通过这种方法学会了推理的核心证据是,模型响应的长度会根据问题的复杂度自然调整。这种自适应行为显示,模型并非简单套用模板,而是真正理解了问题的难度,并相应地投入更多的“思考时间”。就像人类在处理简单加法和复杂积分时会自然调整思考时间一样,R1-Zero 展现出了类似的智慧。

或许最有说服力的是模型展现出的迁移学习能力。在完全不同的编程竞赛平台 Codeforces 上,R1-Zero 达到了超过 96.3% 的人类选手水平。这种跨领域的表现说明,模型并非只是在记忆特定领域的解题技巧,而是掌握了某种普遍适用的推理能力。

3、一个聪明,但口齿不清的天才

尽管 R1-Zero 展现了令人瞩目的推理技能,但研究人员很快便发现了一个重大缺陷:其思维过程对人类来说往往晦涩难懂。

论文中直言不讳地提到了这个完全通过强化学习训练出来的模型存在“可读性差”和“语言混杂”的问题。

这一现象不难理解:R1-Zero 完全依赖奖励和惩罚信号来优化其行为,没有人类提供的“标准答案”作为参照。这就好比一个天才儿童发明了一种独特的解题方法,虽然有效,但在向他人解释时却显得语无伦次。它在解题时可能会混用多种语言,或者创造出一种独特的表达方式,这些都使得其推理过程难以追踪和理解。

为了解决这个问题,研究团队开发了改进版的 DeepSeek-R1。通过引入传统的“冷启动数据”和多阶段训练流程,R1 不仅保留了强大的推理能力,还学会了以人类容易理解的方式表达其思维过程。这就像为那位天才儿童配备了一位沟通教练,指导他如何清晰表达自己的想法。

经过这样的训练之后,DeepSeek-R1 展现出了与 OpenAI o1 相媲美甚至在某些方面更胜一筹的性能。在 MATH 基准测试中,R1 达到了 77.5% 的准确率,与 o1 的 77.3% 不相上下;在更具挑战性的 AIME 2024上,R1 的准确率达到了 71.3%,超过了 o1 的 71.0%。在编程领域,R1 在 Codeforces 的评测中达到了 2441分,超越了 96.3% 的人类参与者。

然而,DeepSeek-R1 Zero 的潜力似乎更为巨大。在 AIME 2024 测试中,当使用多数投票机制时,其准确率达到了 86.7%,这个成绩甚至超越了 OpenAI 的 o1-0912。这种“多次尝试后准确性提高”的特性暗示 R1-Zero 可能掌握了一种基础的推理框架,而不仅仅是记忆解题模式。

论文中的数据显示,从 MATH-500 到 AIME,再到 GSM8K,模型展现了稳定的跨领域性能,特别是在那些需要创造性思维的复杂问题上。这种广泛的性能表明 R1-Zero 可能确实培养出了一种基础的推理能力,这与专注于特定任务优化的传统模型形成了鲜明对比。

因此,尽管表达不够清晰,但或许 DeepSeek-R1-Zero 才是真正理解推理的“天才”。

4、纯粹强化学习,也许才是通向 AGI 的意外捷径

DeepSeek-R1 的发布之所以令业界瞩目,并将焦点转向纯强化学习方法,是因为它实质上为 AI 的进化开辟了一条新道路。

R1-Zero——这个完全依赖强化学习训练而成的 AI 模型,展现了令人瞩目的通用推理能力。它不仅在数学竞赛中取得了卓越成绩,更重要的是,R1-Zero 并非仅仅在模仿思考,而是真正培育出了一种推理能力。

在传统的训练方法中,尤其是在监督式微调中,使用预先训练好的神经网络来评估输出质量时,模型可能会学会触发奖励模型的特定模式,生成符合奖励模型“口味”的内容,而非真正提升推理能力。换言之,AI 系统可能找到了一种获得高奖励但同时偏离训练目标的方法。这就是我们所说的奖励欺骗(reward hacking)。然而,R1-Zero 通过极其简单的奖励规则,几乎避免了奖励欺骗的可能性——规则太过简单,没有“口味”可以模仿。在这种情况下,模型发展出的推理能力更加可靠,也更加自然。

这一发现可能会颠覆我们对机器学习的传统认知:传统的 AI 训练方法可能一直在犯一个根本性的错误,我们过于专注于让 AI 模仿人类的思维方式,而业界或许需要重新审视监督学习在 AI 发展中的角色。通过纯强化学习,AI 系统似乎能够发展出更加原生的问题解决能力,而不是局限于预设的解决方案框架。

尽管 R1-Zero 在输出的可读性上存在显著不足,但这个“不足”本身可能正反映了其思维方式的独特性。就像一个天才儿童创造了自己的解题方法,却难以用常规语言表达一样。这提示我们:真正的通用人工智能可能需要一种完全不同于人类的认知方式。

这才是强化学习的真正精髓。正如著名教育家皮亚杰所提出的理论:真正的理解来自于主动建构,而非被动接受。

本文转载自公众号玄姐聊AGI 作者:玄姐

原文链接:https://mp.weixin.qq.com/s/PzgzuiO3qvb6_n26vte8Yw

感谢科普,已关注公众号