【PaperDaily】谷歌推出AlphaGeometry2,超过金牌选手,称霸IMO

1. Gold-medalist Performance in Solving Olympiad Geometry with AlphaGeometry2

我们推出了 AlphaGeometry2,这是对 Trinh 等人在 2024 年提出的 AlphaGeometry 的重大改进版本,如今它在解决奥林匹克几何问题方面的能力已经超过了普通金牌得主。为了实现这一突破,我们首先对原有的 AlphaGeometry 语言进行了扩展,使其能够处理涉及物体运动的更难题型,以及包含角度、比例和距离的线性方程的问题。这些改进以及其他新增内容,显著提高了 AlphaGeometry 语言对 2000 - 2024 年国际数学奥林匹克(IMO)几何题的覆盖率,从 66% 提升到了 88% 。 。

AlphaGeometry2 的搜索过程也有了极大改进,我们采用了 Gemini 架构以实现更优的语言建模,还运用了一种将多个搜索树结合起来的全新知识共享机制。再加上对符号引擎和合成数据生成的进一步优化,我们大幅提升了 AlphaGeometry2 的整体解题率,在过去 25 年的所有几何问题上,解题率从之前的 54% 提升到了 84%。AlphaGeometry2 还是在 2024 年国际数学奥林匹克中达到银牌水平的系统的一部分,详情见https://dpmd.ai/imo-silver 。

论文: https://arxiv.org/pdf/2502.03544

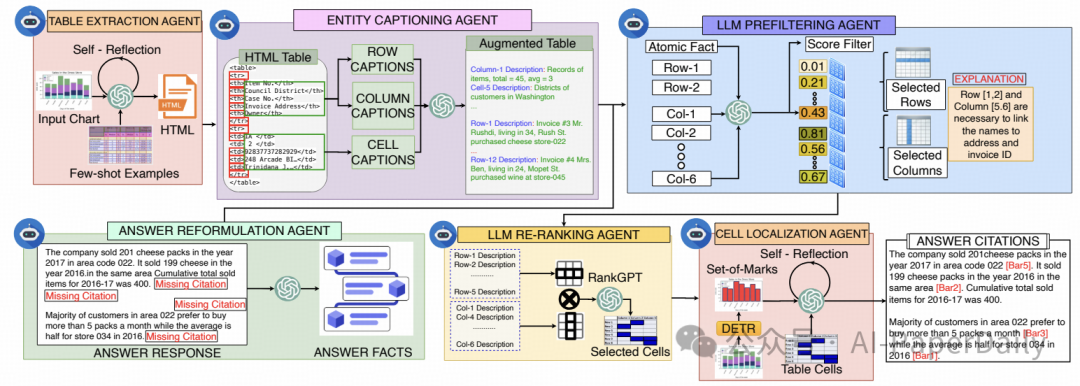

2. ChartCitor: Multi-Agent Framework for Fine-Grained Chart Visual Attribution

大语言模型(LLMs)能够执行图表问答任务,但常常会生成未经核实的虚假回复。由于视觉语义上下文有限、复杂的视觉 - 文本对齐要求,以及在复杂布局中进行边界框预测存在困难,现有的答案归因方法难以将回复与源图表建立关联。

我们推出了 ChartCitor,这是一个多智能体框架,它通过识别图表图像中的支撑证据,提供细粒度的边界框引用。该系统协调大语言模型智能体执行从图表到表格的提取、答案重新组织、表格扩充、通过预过滤和重排序进行证据检索,以及从表格到图表的映射。

在不同类型的图表中,ChartCitor 的表现均优于现有的基线模型。定性用户研究表明,ChartCitor 通过增强大语言模型辅助图表问答的可解释性,有助于提升用户对生成式人工智能的信任,还能让专业人士提高工作效率。

论文: https://arxiv.org/pdf/2502.00989

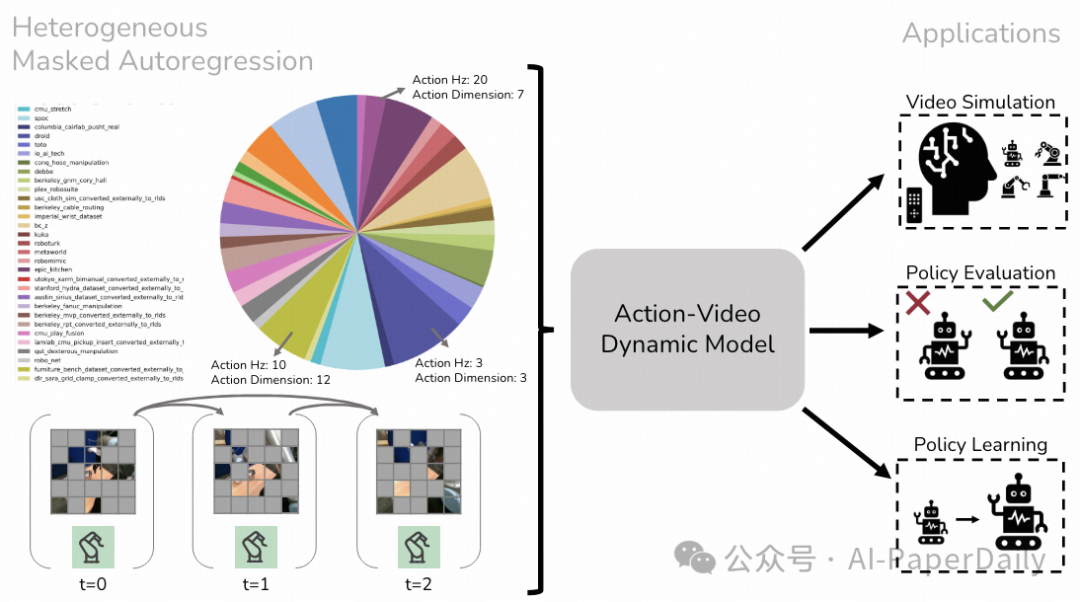

3. Learning Real-World Action-Video Dynamics with Heterogeneous Masked Autoregression

我们提出了异构掩码自回归(HMA)方法,用于对动作视频动态进行建模,以生成高质量数据,并在拓展机器人学习中开展评估工作。由于既要应对各种不同场景,又要保持计算效率以实现实时运行,因此构建适用于机器人技术的交互式视频世界模型和策略颇具挑战。

HMA 利用来自不同机器人实体、领域及任务中的观测数据和动作序列,进行异构预训练。它借助掩码自回归生成量化或软令牌,以实现视频预测。与以往的机器人视频生成模型相比,我们的模型(HMA)视觉保真度和可控性更佳,在现实世界中的运行速度更是快了 15 倍。经过后期训练,该模型可用作视频模拟器,接受低层级动作输入,以评估策略并生成合成数据。如需更多信息,请访问此链接:https://liruiw.github.io/hma 。

论文: https://arxiv.org/pdf/2502.04296

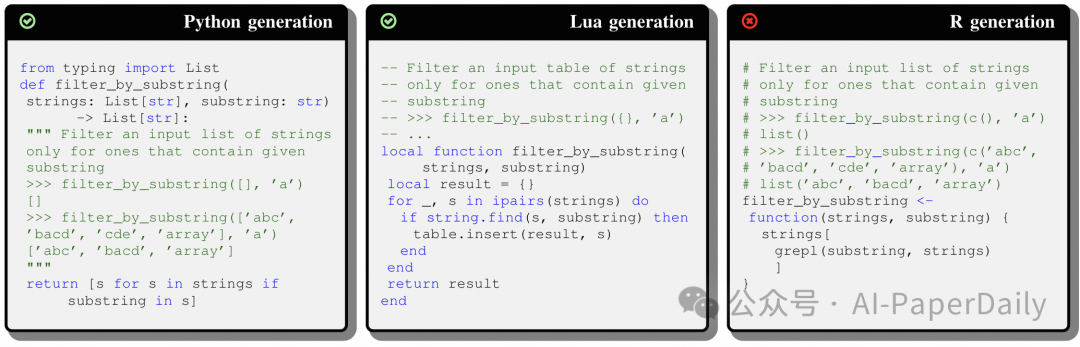

4. Enhancing Code Generation for Low-Resource Languages: No Silver Bullet

大语言模型(LLMs)的出现极大地推动了自动化代码生成领域的发展。大语言模型依赖大量多样的数据集来学习编程语言的语法、语义及使用模式。对于低资源语言(即那些因训练数据稀缺而小众的编程语言)而言,此类数据的有限可用性限制了模型的有效泛化能力,导致其代码生成性能相较于高资源语言要差。因此,人们一直在探寻能够缩小这一性能差距的技术。

我们开展了一项实证研究,探究几种提升大语言模型在低资源语言上性能的方法的有效性,具体如下:(i)经典的微调方法,但由于训练数据稀缺,其规模受限;(ii)三种上下文学习变体,通过精心设计提示,为大语言模型提供关于低资源语言的额外信息(例如,展示目标语言特性的少样本示例);(iii)一种预训练目标,教会模型如何在高资源语言和低资源语言之间进行翻译。

我们的研究以两种低资源语言(R 语言和 Racket 语言)以及六种不同架构和规模的大语言模型为背景。研究结果表明,对于规模较小的大语言模型,微调通常是最佳选择,这可能是因为即使是少量数据集也足以训练其有限数量的参数。随着模型规模的增大,上下文学习变得越来越有效,是一种稳妥且成本较低的策略(即它总能起到一定作用,只是程度有所不同)。然而,对于超大规模的大语言模型,进行微调时,它们在低资源语言上的性能可能会下降,这可能是由于缺乏足够的数据来有效更新其权重。

论文: https://arxiv.org/pdf/2501.19085

本文转载自 AI-PaperDaily,作者: AI-PaperDaily