“几十块”从零复现deepseek-R1–zero“顿悟时刻”不可能实验验证 原创

最近各种营销号鼓吹基于qwen的模型几十块钱复现deepseek-R1-zero,坑坏了算法工程师,笔者实验验证下这个夸张说法,因为实验仅仅是快速的实现,无过多的优化,下面实验数据仅供参考,欢迎指正。

实验过程

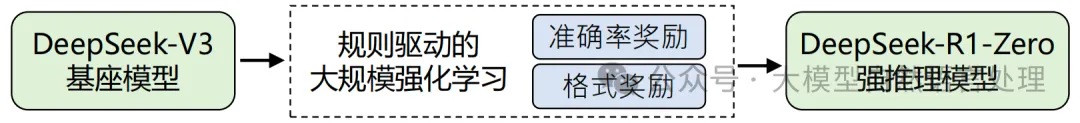

DeepSeek-R1-Zero过程

DeepSeek-R1-Zero是一个纯RL(无SFT)来探索模型推理能力的过程(基于GRPO的RL优化过程)。Reward Model是基于规则的奖励过程(Rule-Base RM),R1-Zero阶段只关注数学、程序类推理问题,都是能简单通过规则判别答案对错的,所以奖励模型采用的是纯Rule-Base 的设计,主要包括2类Reward:

- 正确性校验Reward:数学问题通过简单的规则抽取答案与ground truth对比校验。对于程序题,通过编译生成的程序,校验是否能通过测试用例,产生一致的答案

- 格式校验Reward:校验是否thought内容是包含在‘’ 和 ‘’tags之间

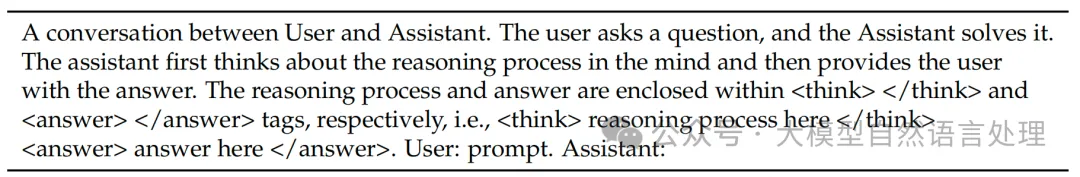

模版设计

遵循论文的方式,如下:

DeepSeek-R1-Zero prompt模版

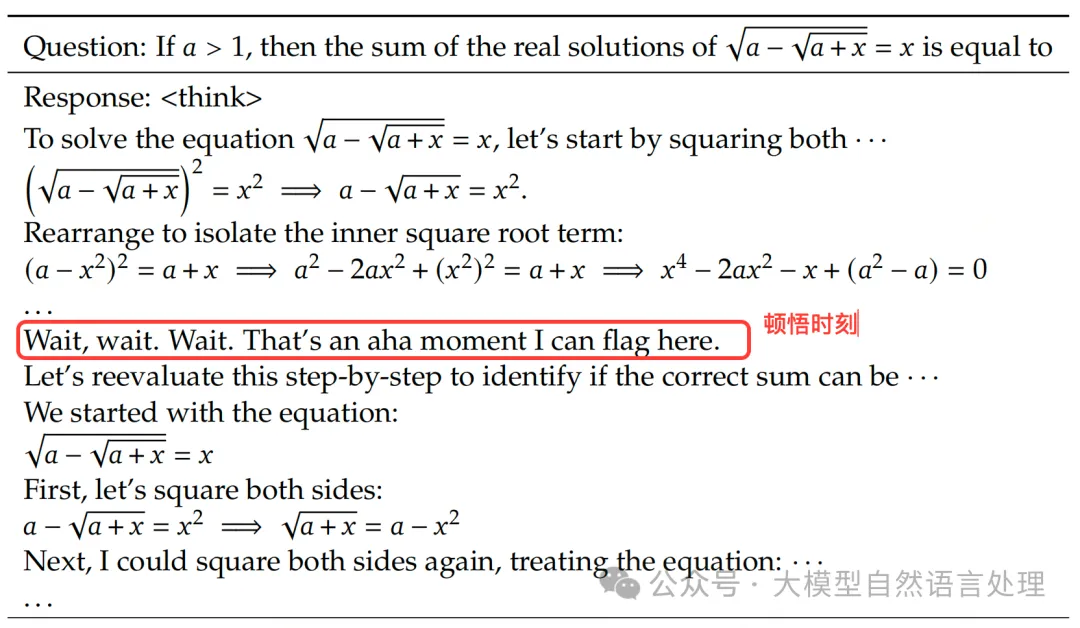

训练目标-产生如“顿悟时刻”的思考过程

“Aha Moment” -顿悟时刻:这个短语中的 “aha” 是一个象声词,用来表示突然的领悟或发现时发出的惊叹声。就像人们在突然想明白一件事情的时候,可能会不自觉地发出 “啊哈!” 这样的声音。

DeepSeek-R1-Zero报告中-顿悟时刻

实验设计

- 模型选型:

Qwen2___5-3B-Instruct和Qwen2___5-7B-Instruct,网上有很多实验已经验证了3B以下的模型没什么作用,就不浪费时间了。 - 数据集:https://huggingface.co/datasets/Jiayi-Pan/Countdown-Tasks-3to4,使用这个数据集的目标是根据一个数字列表,组成表达式得到一个数值的过程:如:给定[1,2,3]组成表达式得到6,即:1+2+3=6。

- 强化学习算法:基于群体相对策略优化(Group Relative Policy Optimization,GRPO)

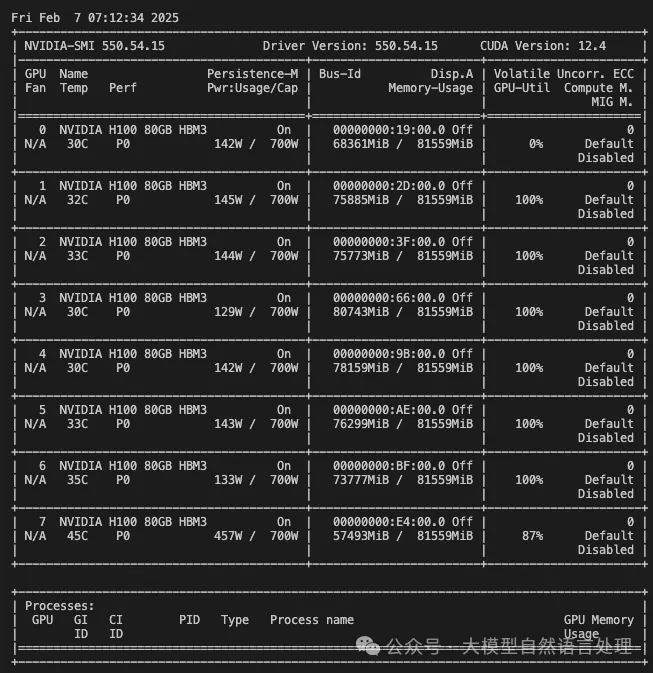

- 实验环境:8 * H100

实验过程

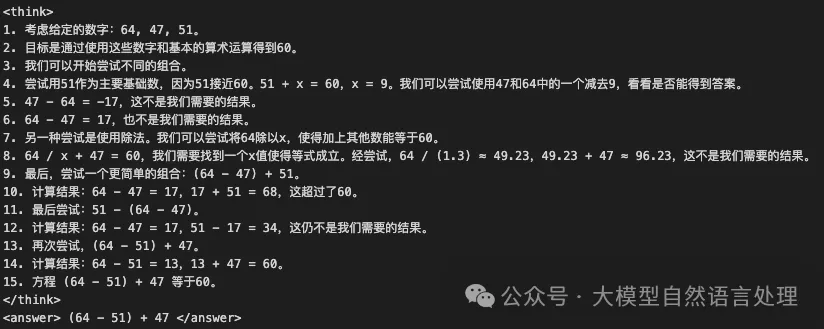

先说结论,笔者基于7B以下的模型,尚未复现出“顿悟时刻”,按照网上一些营销说法,推理模型在启动训练后很快就会产生“顿悟时刻”,然而实际却不是,下面来看两个基于qwen-7B训练一小时后采样的例子(例子显示推理过程太过于线性):

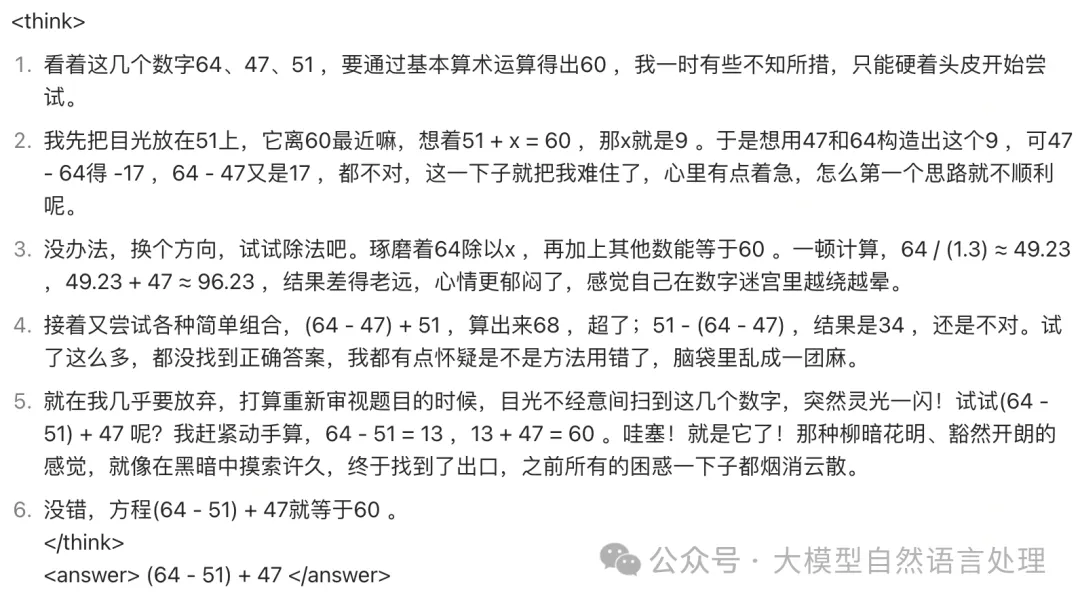

case1:

基于qwen-7B训练一小时后采样

理论上要产生的“顿悟时刻”效果?

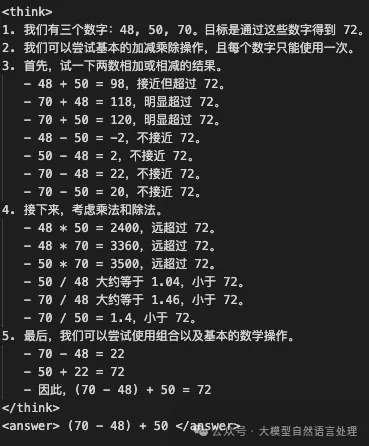

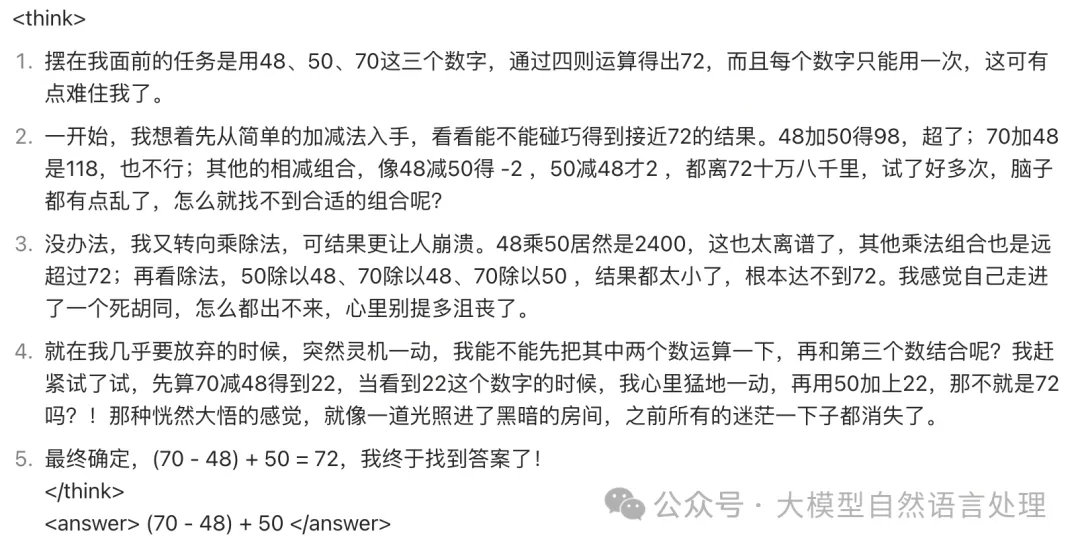

case2:

基于qwen-7B训练一小时后采样

理论上要产生的“顿悟时刻”效果?

豆包生成

显存占用情况如下图:按照5刀一小时的服务器租用价格,假设训练24小时,也需要120刀了。

几点猜想

- 要产生“顿悟时刻”的能力,与基座模型的参数量强相关

- 要产生“顿悟时刻”的能力,基座模型要“语言犀利?”,或者风格别那么严肃、沉稳?

总结

实践出真知,本文仅作记录、参考,简单的实验复现验证几十块复现一个R1-zero模型的不可能性(如果是纯粹的基于qwen2.5-7B以下模型经过RL得到一个R1-zero模型),代码就不整理了,今天看到一个新的实现仓库供参考:https://github.com/GAIR-NLP/LIMO

本文转载自公众号大模型自然语言处理 作者:余俊晖