1.8秒完成90帧视频重建,相比加速1000 倍!颜水成团队提出NutWorld:渲染速度可达450FPS 精华

论文链接:https://arxiv.org/pdf/2502.03465

git链接:https://github.com/Nut-World/NutWorld

亮点直击

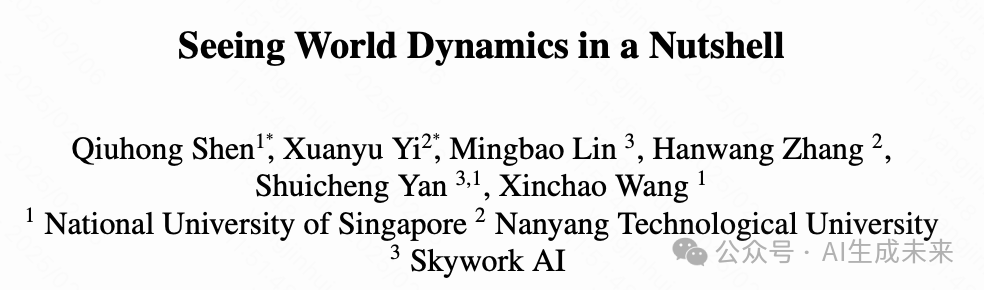

- 首次提出了一个框架,可以通过单次前向传播,将随意拍摄的单目视频中的世界动态高效表示为动态Gaussian Splatting(Dynamic Gaussian Splatting)。

- NutWorld 框架结合了 STAG 表示、精心设计的前向重建网络,以及用于从随意视频中实现空间和时间一致性恢复的有效正则化策略。

- 在视频重建和多种下游任务上的大量实验,验证了 NutWorld 在时空一致性和多功能性方面的表现。

总结速览

解决的问题

现有方法在表示随意拍摄的单目视频时,因缺乏时间一致性和显式3D结构,难以处理复杂运动、遮挡和几何一致性。如何高效地以空间和时间一致的方式表示单目视频,成为亟待解决的问题。

提出的方案

提出了 NutWorld 框架,通过单次前向传播,将单目视频动态高效地表示为动态3D Gaussian Splatting(Dynamic Gaussian Splatting)。核心方案包括:

- STAG(空间-时间对齐高斯)表示:无需优化即可建模场景,提供高效的动态表示。

- 深度与流正则化策略:增强空间和时间一致性。

- 精心设计的前向重建网络:提升重建效率和质量。

应用的技术

- 时空连续的高斯原语流表示:以3D形式表示单目视频,解决时间一致性问题。

- STAG 表示:引入结构化的空间-时间对齐表示,提升建模效率。

- 正则化策略:通过深度和流正则化,增强几何一致性和动态场景的建模能力。

- 单次前向传播:实现高效的视频到动态3D表示的转换。

达到的效果

- 高保真视频重建:在视频重建质量上表现卓越,解决复杂运动和遮挡问题。

- 时空一致性:在空间和时间一致性方面显著优于现有方法。

- 多功能性支持:支持多种实时下游应用,展现出强大的适应能力和实用性。

方法

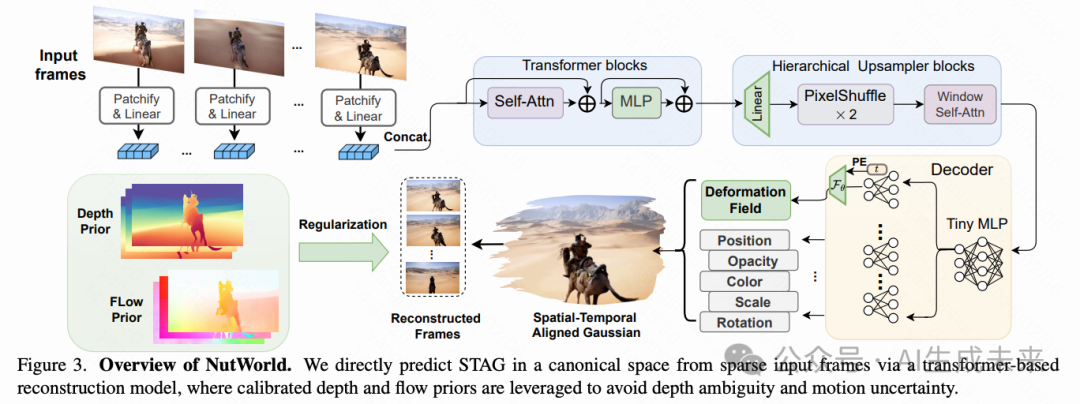

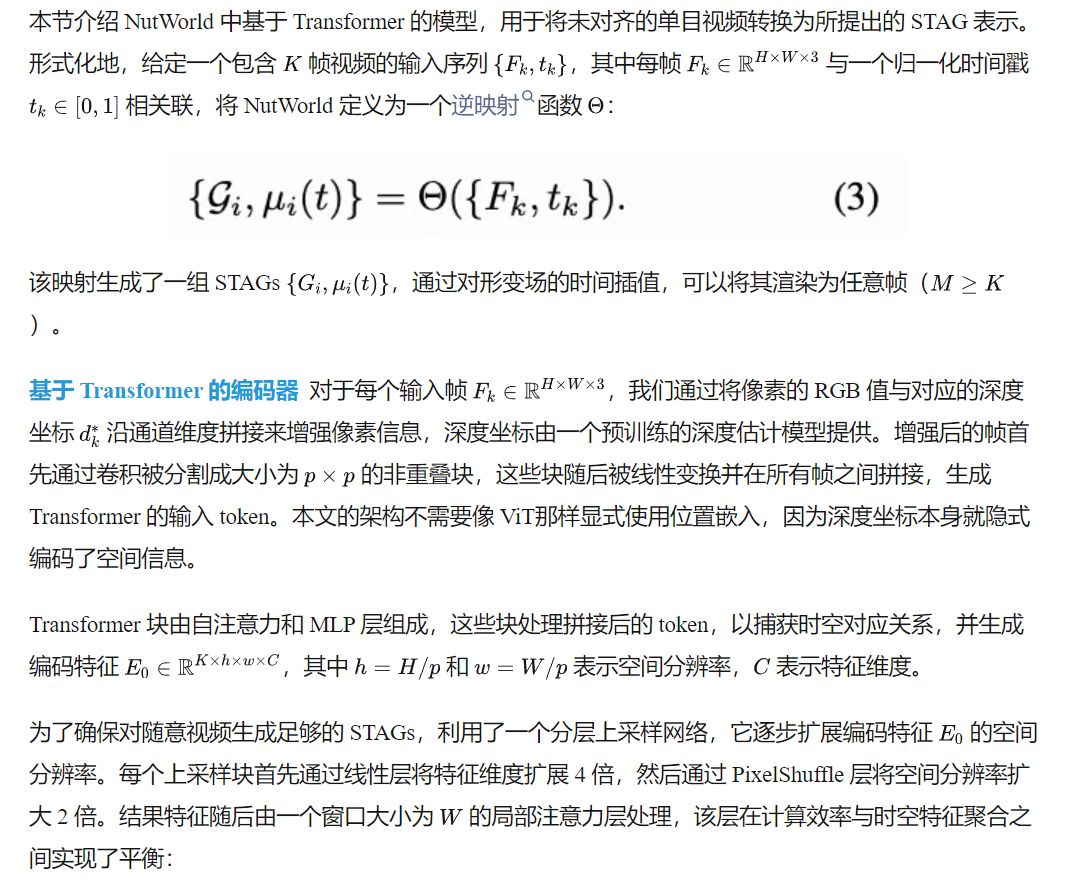

本文提出了一个框架,用于以前向传播的方式高效地从单目视频中表示世界动态。如下图3所示,首先介绍了时空对齐Gaussian Splatting(STAG) 表示。为了能够通过单次前向传播将视频映射到STAG,详细说明了基于Transformer的网络,该网络结合了校准的深度和光流先验。最后,讨论了处理长视频片段的整体训练目标和协议。

时空对齐高斯

规范化相机空间 给定一个未经配准的单目视频,采用正交相机坐标系统,而不是绝对的3D世界坐标系统。这一选择主要基于两个关键挑战:

- 在动态场景中获得一致的相机轨迹的困难;

- 前向3D重建模型中固有的尺度歧义问题,其中透视投影将物体的尺度与其距离相机的远近耦合在一起。

通过采用沿z轴固定姿态的正交投影,消除了显式相机姿态估计的必要性,同时在统一的规范化空间中无尺度歧义地建模相机和物体的运动。

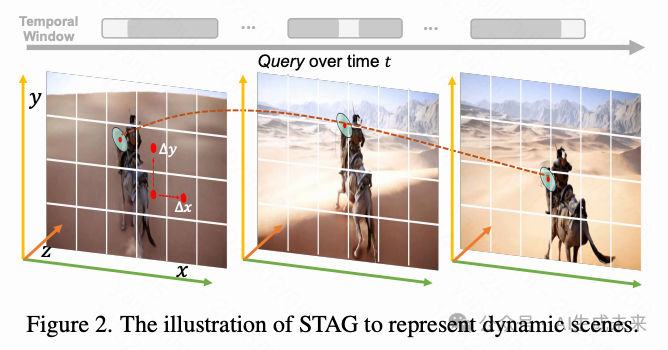

结构化动态高斯 为了克服动态高斯喷射中不结构化的特性,并促进神经网络的集成,在规范化相机空间中引入了时空对齐Gaussian Splatting(STAG)。与之前通过可变形场在正交时空中预测无约束高斯的方法不同,STAG将每个动态高斯约束到特定的像素位置和时间戳。

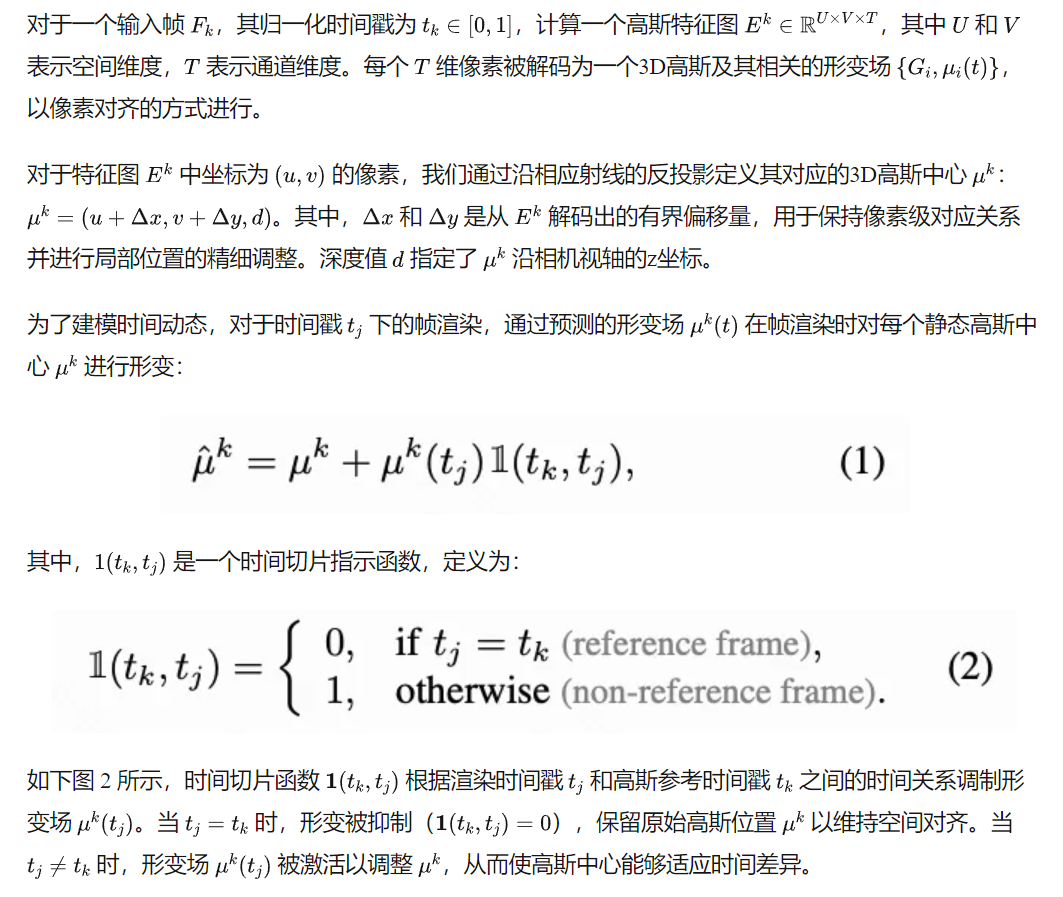

对于一个输入帧 ,其归一化时间戳为 ,计算一个高斯特征图 ,其中 和 表示空间维度, 表示通道维度。每个 维像素被解码为一个3D高斯及其相关的形变场 ,以像素对齐的方式进行。

在“Nutshell”中封装动态

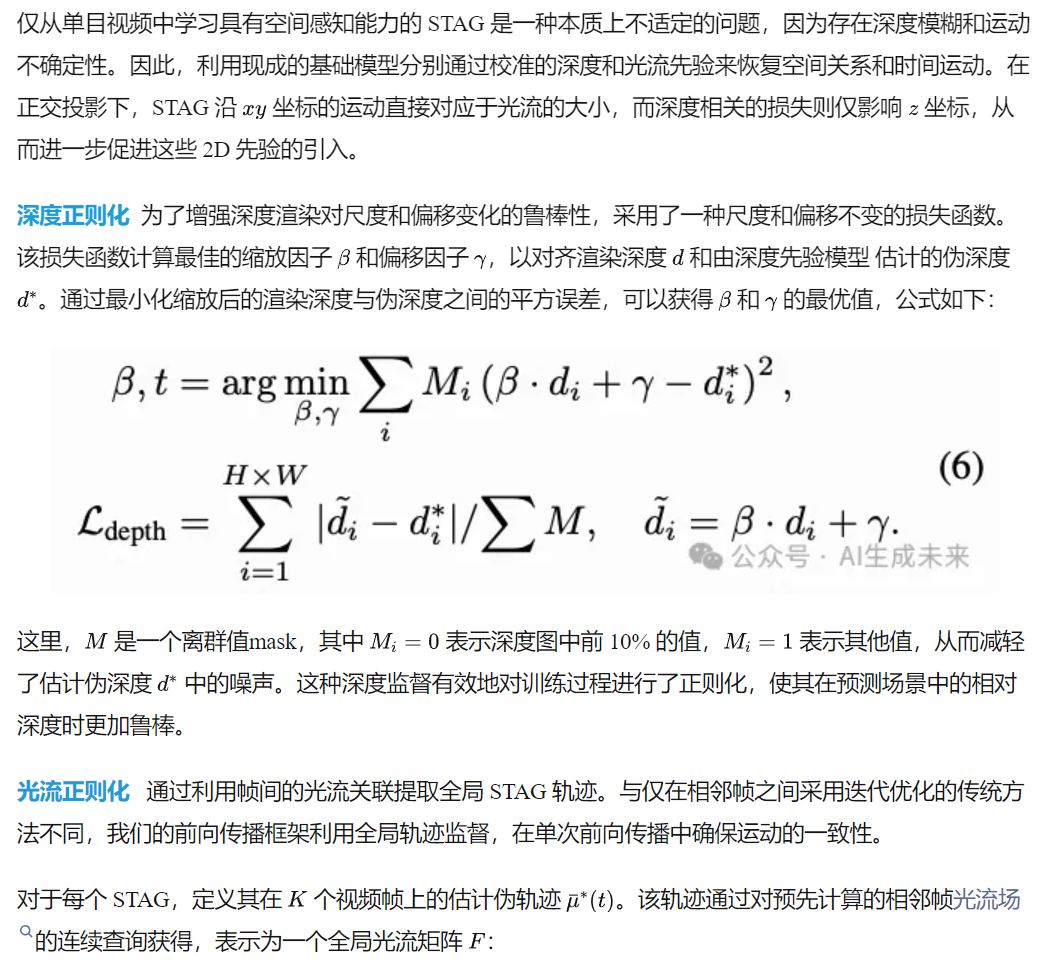

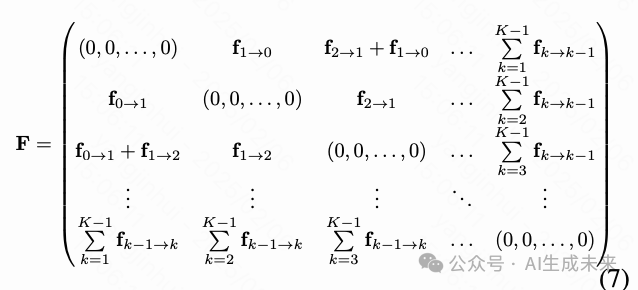

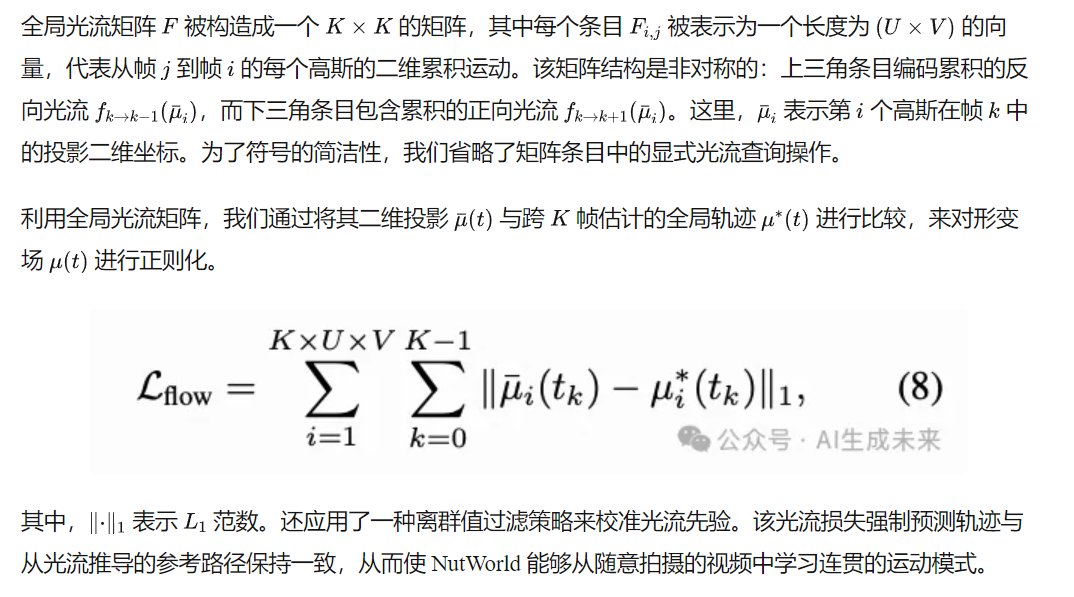

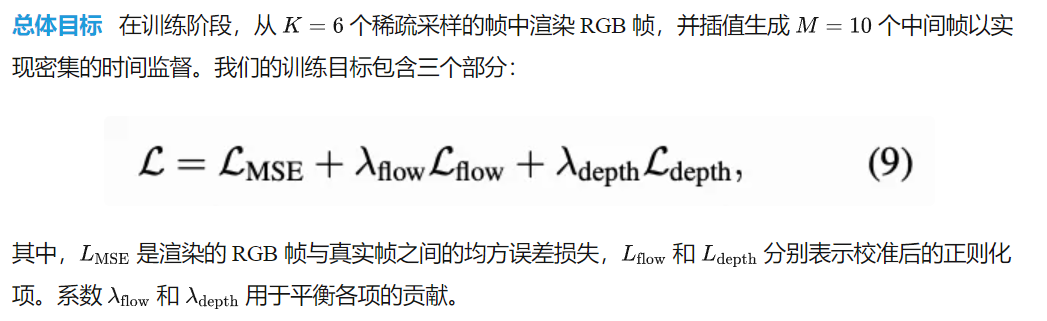

校准的 2D 先验正则化

训练和推理

基于分段的长视频推理 为了处理包含数百帧的随意拍摄视频,在推理阶段提出了一种简单但有效的基于分段的策略。输入视频被划分为重叠的片段,相邻片段共享一个帧。由于我们基于像素级的时空表示,高斯轨迹可以通过这些共享帧在片段之间无缝传播,从而使 NutWorld 能够在保持时空一致性的同时处理任意长度的视频。

实验

实验设置

训练数据集 NutWorld 在 MiraData 和 RealEstate10K 数据集上进行了预训练。

MiraData 是一个高质量的视频数据集,主要由3D引擎生成的场景和电影片段组成,具有多样的运动模式。RealEstate10K 数据集包含室内房屋导览视频,展示了各种建筑场景和相机运动模式。

在预处理过程中,将原始视频分割成视频块,每个视频块包含10帧连续帧,作为基本处理单元。

实现细节 NutWorld 在 32 张 NVIDIA A100 (80GB) GPU 上进行训练,批量大小为 256,训练时间约为 4 天。为了提高计算效率,集成了 Flash-Attention-v2、梯度检查点 和 BF16的混合精度训练。

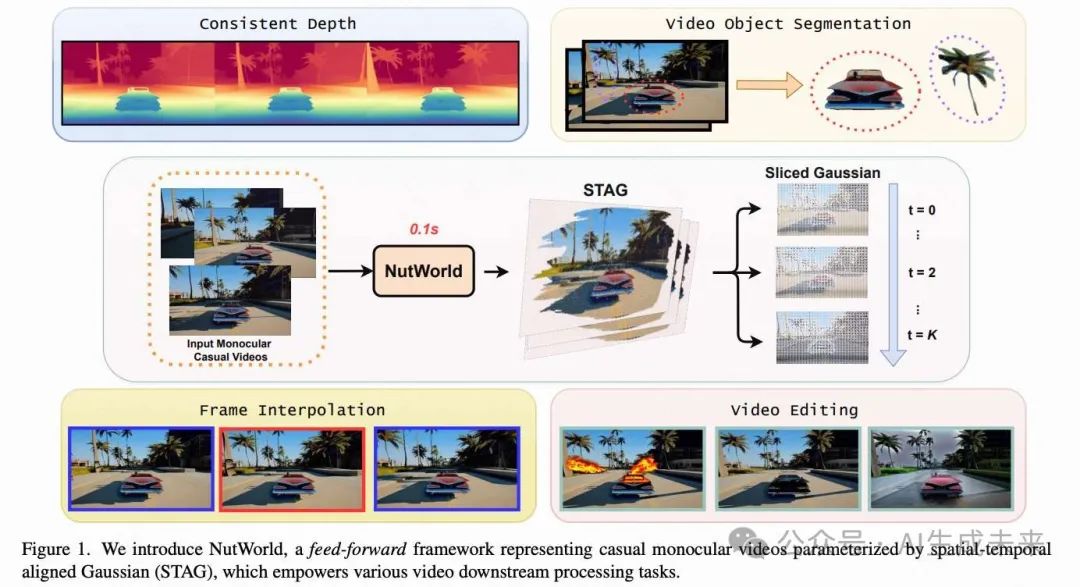

视频重建

实验协议 在 RealEstate10K 和 MiraData 数据集上随机选择了 50 个测试视频片段(默认长度为 90 帧),通过标准重建质量指标(PSNR、SSIM 和 LPIPS)评估 NutWorld 的视频重建性能。由于目前没有其他基于动态高斯的前馈方法,我们与基于优化的方法进行了比较,包括 Splatter-a-Video (SaV)、4DGS、RoDynRF 和 CoDeF,这些方法是最相关的基线。为了公平比较,所有方法都结合了受限的标准空间、深度和光流监督。对于大多数方法,我们使用了官方实现,而 SaV 是根据其论文中提供的实现细节重新实现的。

与基线方法的比较 通过定性和定量实验评估了 NutWorld 表示的有效性。在下图4中可以看出,预训练的 NutWorld 能够有效捕获空间细节和时间动态,在重建质量上优于基于高斯的 SaV和基于 NeRF 的 CoDeF。这种优越性能归因于 STAG 精心设计的可变形场和位置约束,与 SaV 的傅里叶级数和 CoDeF 的二维标准表示相比,提供了更具表现力和更鲁棒的时间建模能力。

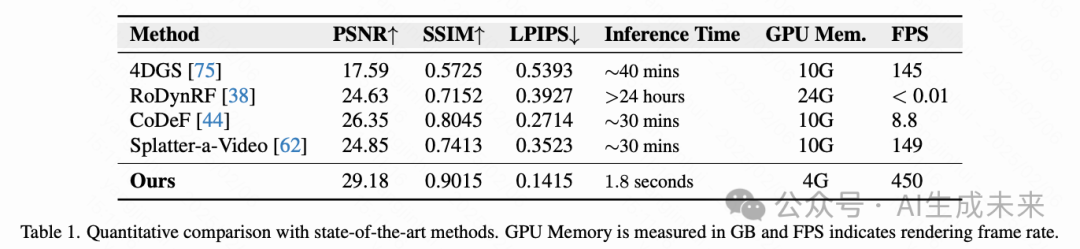

如下表1所示,NutWorld 在重建质量和计算效率方面实现了两者的最佳平衡。值得注意的是,NutWorld 在仅 1.8 秒内就完成了 90 帧视频的重建,相比基于优化的方法实现了 1000 倍的加速。通过基于分段的推理策略限制每段的高斯数量,NutWorld 达到了 450 FPS 的渲染速度,显著超过了 SaV 的 149 FPS,而后者需要大约 个高斯来处理同一视频。

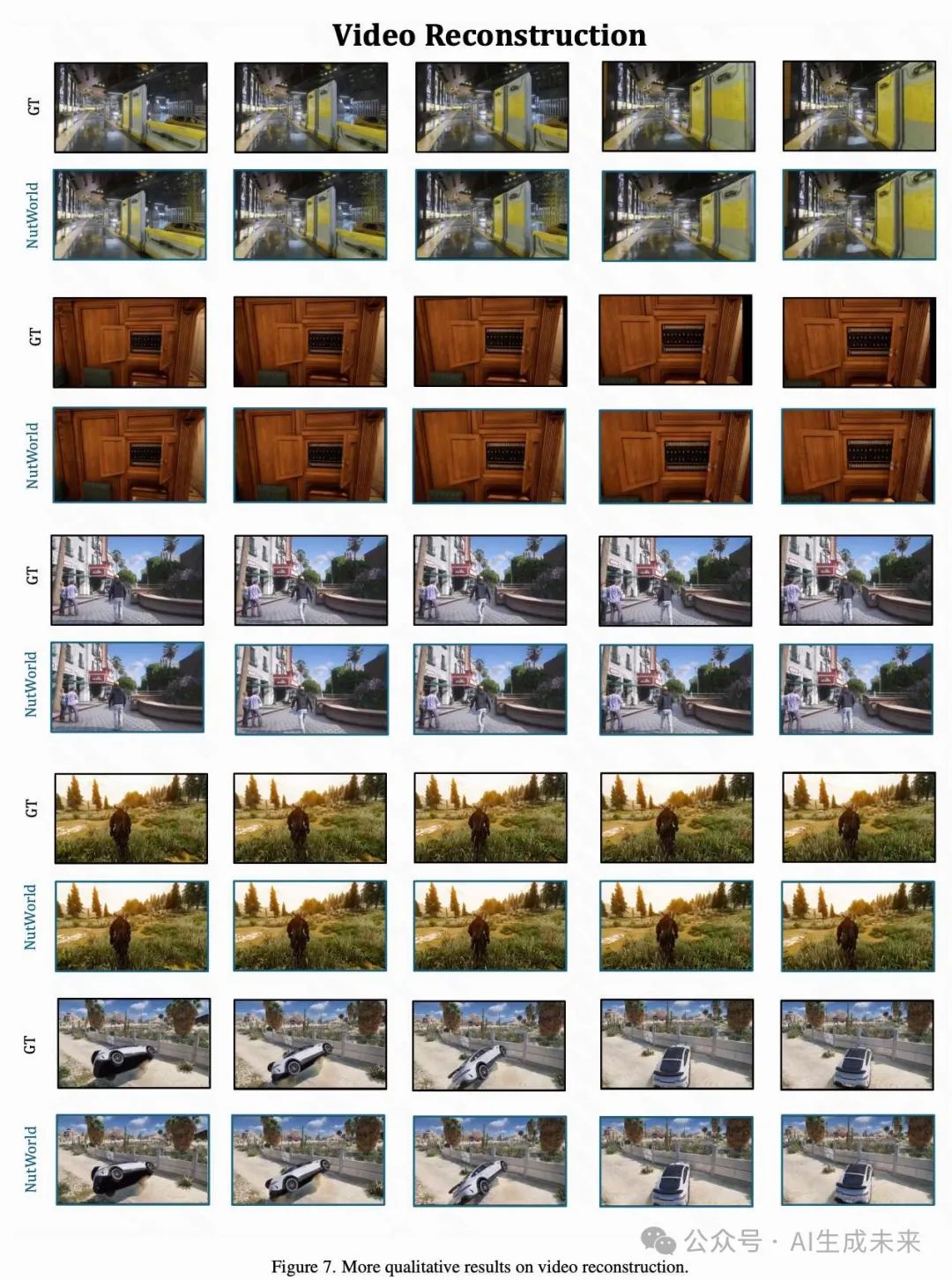

视频下游任务

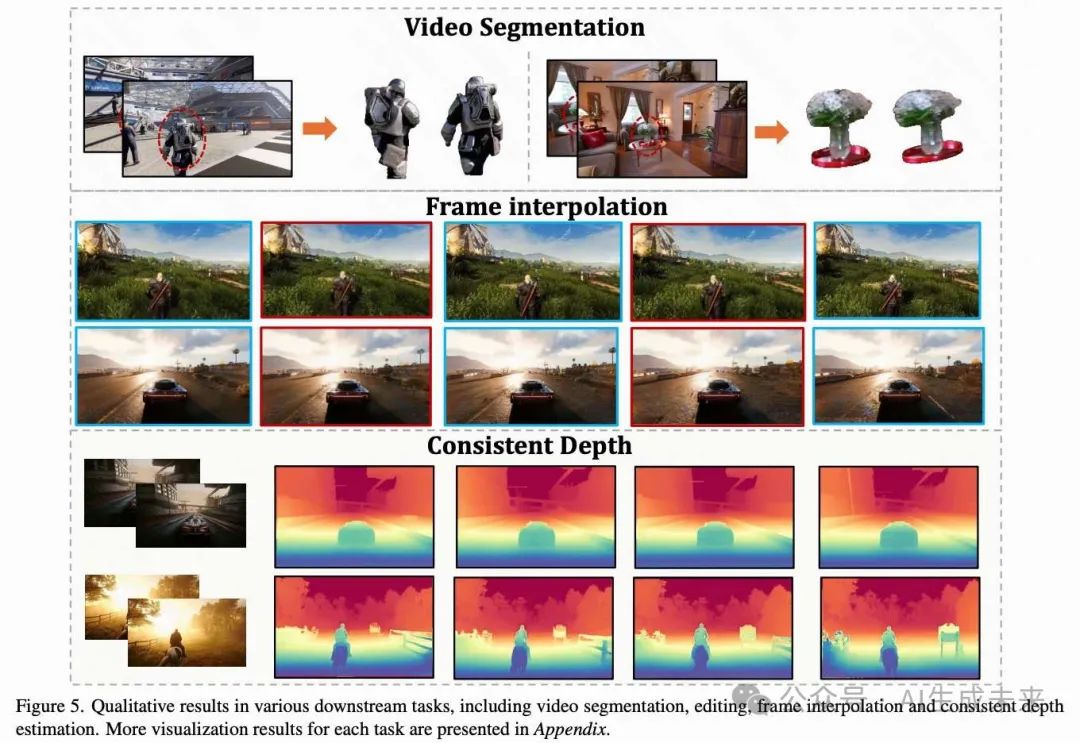

经过大规模预训练的 NutWorld 支持多种视频应用,包括目标分割、帧插值、视频编辑、新视角合成以及一致性的深度预测。在下图5中展示了具有代表性的定性结果。

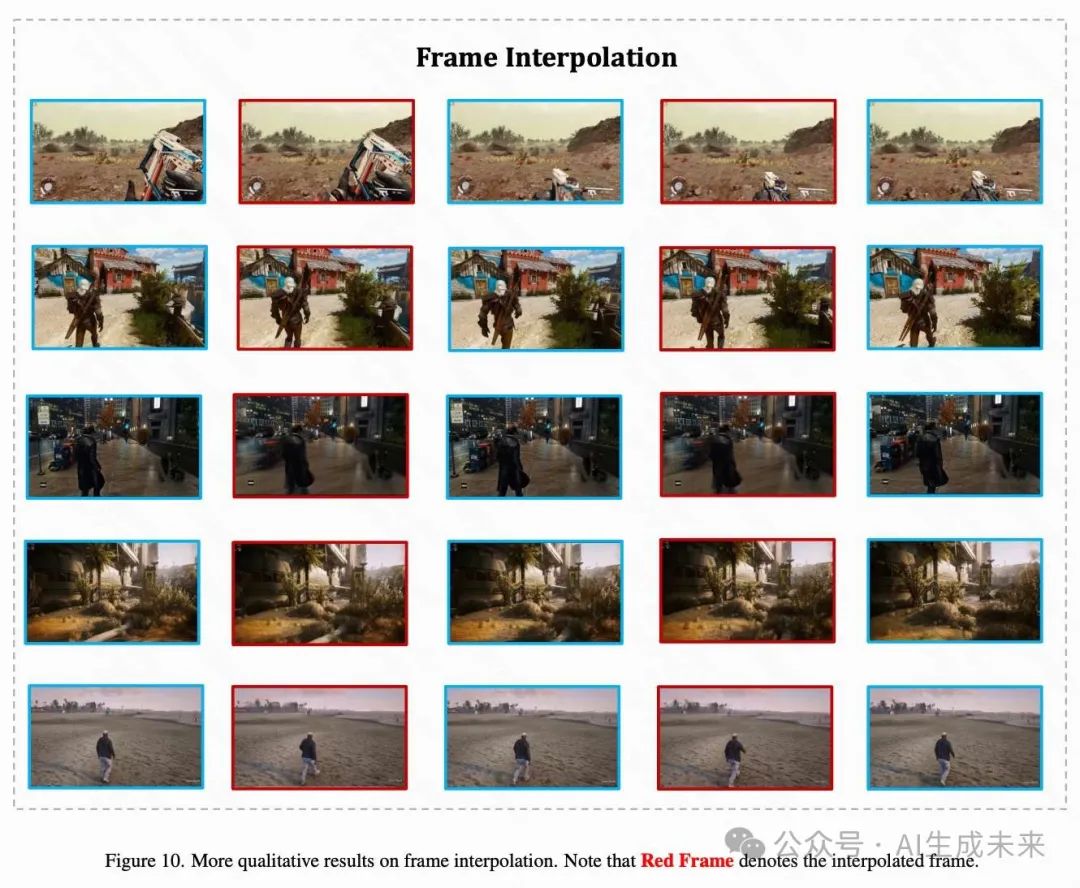

帧插值 通过校准光流正则化学习到的 STAG 连续轨迹,NutWorld 能够以任意 FPS 插值场景动态。这些插值后的 STAG 具有平滑变化的动态属性,能够支持中间帧的渲染,这种能力超出了逐帧方法的范围。

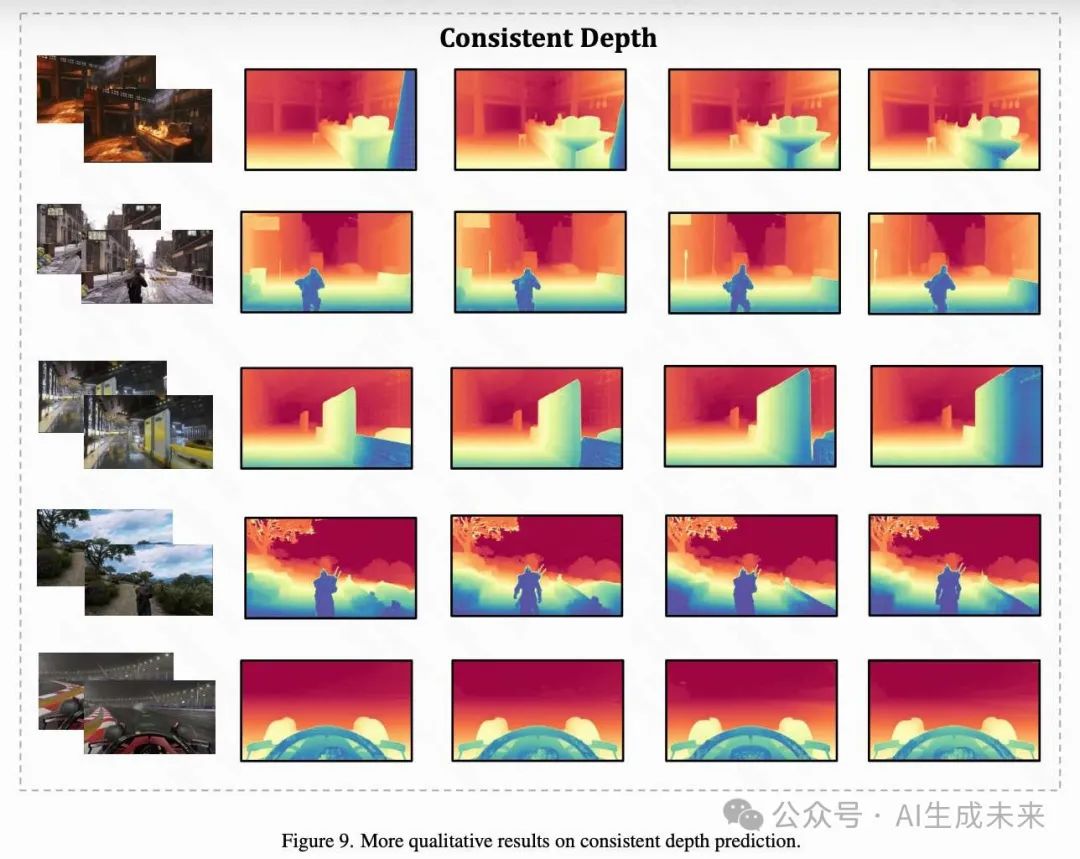

一致性深度预测 校准的深度正则化防止了深度坍缩,同时在场景几何中保持了时间一致的空间配置。此外,NutWorld 展示了蒸馏其他图像特征(如 SAM 和 CLIP)的潜力,我们认为这是未来工作的一个有前途的方向。

视频编辑 通过与 MLLM 指导的编辑模型集成,NutWorld 能够通过优化切片的 STAG 表示,实现精确的逐帧绘画和风格化。这些编辑在时间上可以传播,同时保持视频序列的视觉一致性。

新视角合成 通过结合深度先验以减轻空间歧义,NutWorld 在实际范围内实现了新视角合成。相机外参调整支持新视角渲染,而相机内参调整则允许实现如推拉变焦(dolly zoom)等效果。

消融研究

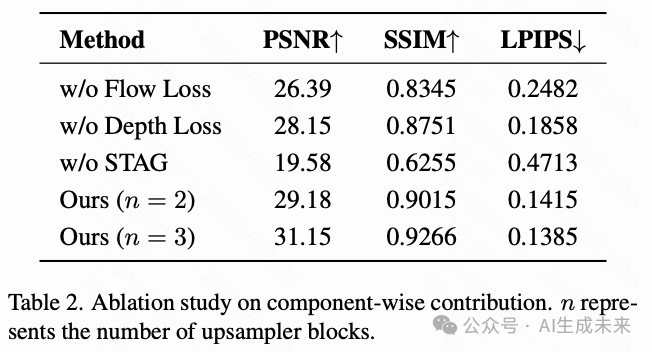

通过对50个选定的视频片段进行消融研究,分析了NutWorld的设计选择。如下表2所示,实验表明,从多组件流水线中移除任何一个组件都会导致显著的性能下降。

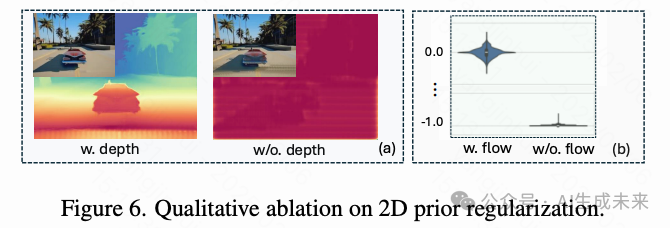

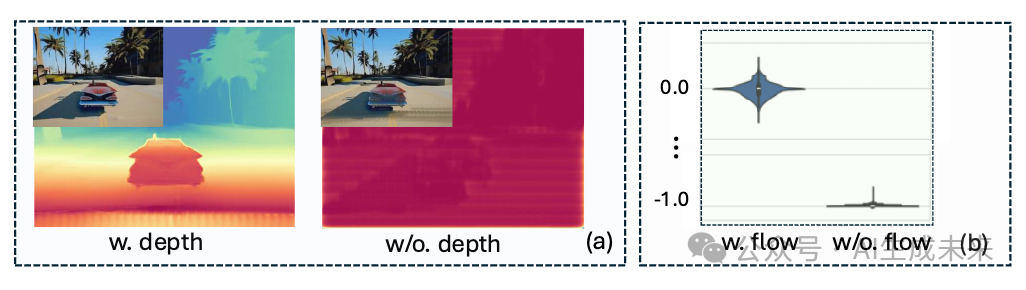

关于流先验的消融实验。 为了评估流先验(Eq. 8),训练了一个没有流监督的NutWorld变体进行对比。通过小提琴图(如下图 6(b))可视化了跨越帧的形变场的分布。在没有流监督的情况下,模型表现出较大的形变值且方差较低,导致STAGs在非参考帧中偏离了Eq. 2中定义的标准空间。这表明,没有流监督的变体倾向于通过将每一帧表示为独立的STAGs来学习一种不理想的捷径,进而导致时间不连续性。相比之下,在有流监督的情况下,形变场的分布集中在接近零的位置,且具有适当的方差,这表明NutWorld能够通过流先验恢复时间运动,从而有效地防止这种捷径行为。此外,上表2中的定量实验表明,时间不连续性会导致重建质量下降,尤其是在处理复杂运动时表现尤为明显。

结论

本文提出了NutWorld,这是一种通过动态高斯投影高效表示随意单目视频的新框架。通过引入结构化的STAG表示并结合有效的深度和光流正则化,本文的方法成功解决了单目视频表示中的多个基本挑战,在无需逐场景优化的情况下实现了空间和时间的一致性。全面的实验表明,NutWorld不仅能够实时实现高保真的视频重建,还支持多种下游应用。在未来,将丰富的视觉特征(例如,SAM、CLIP)蒸馏到STAG表示中,以及将表示范式适配于视频生成任务,都是值得探索的方向。

本文转自AI生成未来 ,作者:AI生成未来