Falcon 3:阿联酋技术创新研究所推出世界上最小、最强大的人工智能模型 原创

01、概述

近年来,大型语言模型(Large Language Models,LLMs)的发展成为人工智能领域的核心议题。而作为这一领域的先行者之一,位于阿布扎比的科技创新研究院(Technology Innovation Institute, TII)再次推出其重磅产品——Falcon3 系列。作为一组参数规模在10亿以下的解码器(Decoder-only)大型语言模型,Falcon3系列不仅在性能和训练效率上取得了重要突破,还彰显了TII致力于推动开放、可访问的基础模型的决心。

02、Falcon3 系列的亮点与演进

Falcon3 是对其前代模型的自然演进,重点提升了模型在科学、数学和代码领域的能力。这一系列包含五个基础模型:

- Falcon3-1B-Base

- Falcon3-3B-Base

- Falcon3-Mamba-7B-Base

- Falcon3-7B-Base

- Falcon3-10B-Base

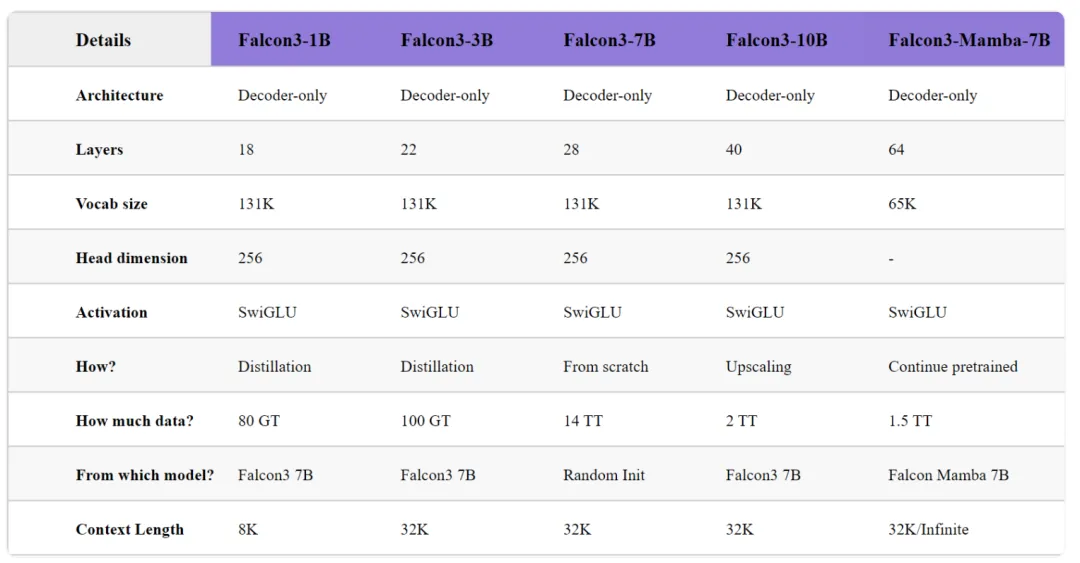

这些模型通过一系列创新技术实现了高效训练和卓越性能,以下是Falcon3在开发过程中实现的关键技术进展:

1) 大规模预训练:

在开发Falcon3-7B模型时,研究团队使用了1024颗H100 GPU芯片,并基于14万亿个高质量多语言数据(涵盖Web内容、代码及STEM领域),进行了一次大规模的预训练。

2) 模型深度扩展:

通过对冗余层的复制和2万亿高质量数据的进一步训练,研究团队将7B模型扩展为10B参数的Falcon3-10B-Base,成功提升了零样本(Zero-shot)和少样本(Few-shot)任务性能。

3) 知识蒸馏技术:

为开发更加紧凑高效的小模型(如Falcon3-1B和Falcon3-3B),团队采用了剪枝和知识蒸馏技术,利用不到100GB的精选数据完成预训练,显著提升了效率。

4) 强化数学推理能力:

Falcon Mamba 7B模型通过额外训练1.5万亿高质量数据,形成了Falcon3-Mamba-7B-Base版本,大幅提升了推理和数学任务的表现。

5) 丰富的模型变体:

所有Falcon3基础模型均提供多种变体,包括 Instruct、GGUF、GPTQ-Int4、GPTQ-Int8 等,满足多样化的应用需求。

03、性能与评估:Falcon3如何脱颖而出?

Falcon3 系列在常见基准测试中展现了超强实力,特别是在小型和中型模型领域中,其性能备受瞩目。

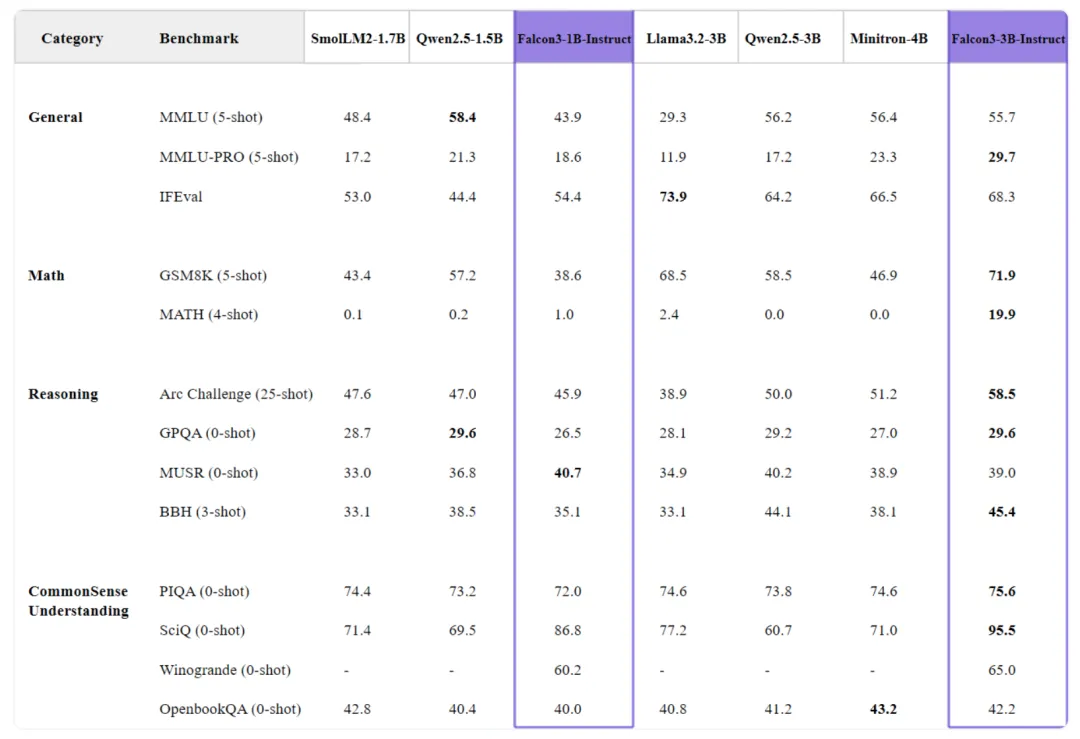

1) 小模型的惊人表现:

Falcon3-1B-Base:在对比中超越了SmolLM2-1.7B,并与gemma-2-2B的表现相当。

Falcon3-3B-Base:在性能上优于规模更大的Llama-3.1-8B和Minitron-4B-Base,充分体现了知识蒸馏的训练优势。

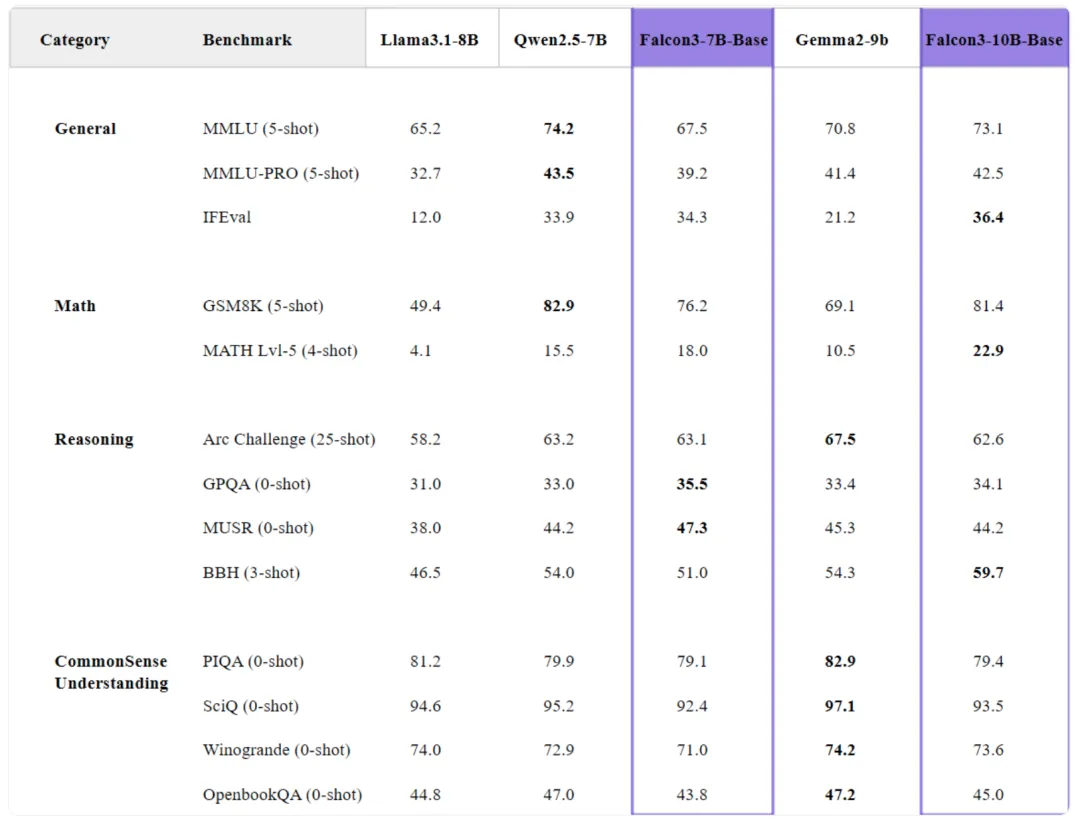

2) 中型模型的卓越性能:

Falcon3-7B-Base:与Qwen2.5-7B在7B规模模型中旗鼓相当,在数学和推理任务中表现尤为突出。

Falcon3-10B-Base:作为13B以下规模模型中的佼佼者,在多项基准测试中取得领先。

3) Mamba模型的优异表现:

Falcon3-Mamba-7B在State Space Language Model(SSLM)领域继续引领潮流,支持最长32K的上下文长度,同时保持卓越性能,适合用户无缝集成。

04、扩展能力:科学、数学与编程的多领域突破

Falcon3的研发重点在于提升科学、数学和编程领域的能力,以下是一些关键评估数据:

1) 数学能力

Falcon3-10B-Base 在复杂数学任务中得分:MATH-Lvl5 22.9,GSM8K 83.0,表现极为亮眼。

2) 编程能力

在编程相关任务中,Falcon3-10B-Base 在 MBPP 上获得 73.8 的高分,而其 Instruct 版本在 Multipl-E 上得分 45.8,展现了强大的代码通用化能力。

3) 推理能力

Falcon3-7B 和 Falcon3-10B 在 BBH 测试中分别得分 51.0 和 59.7,证明其在复杂推理任务上的优势。

4) 科学知识扩展

MMLU 基准测试结果显示:Falcon3-7B-Base 和 Falcon3-10B-Base 分别在 MMLU 和 MMLU-PRO 中得分 67.4/39.2 和 73.1/42.5,反映了其在专业知识领域的强大能力。

05、技术细节与创新架构

模型架构优化:

Falcon3 系列基于解码器(Decoder-only)结构,18到40层的Transformer深度,以及SwiGLU激活函数使其在FlashAttention-3优化下拥有高效的推理能力。

Falcon3-7B-Base采用了最大量的数据训练,覆盖了广泛的概念和知识,为通用任务提供了出色的表现。

Falcon3-Mamba-7B 特有64层架构,专为数学和科学任务优化。

上下文长度扩展:

除1B模型支持8K上下文外,其他模型均支持长达32K的上下文,使其在大规模文本处理任务中表现优越。

Falcon3 的开放承诺

TII一贯致力于推动AI的开放与合作,Falcon3 系列模型也不例外。所有模型均采用 Falcon LLM许可证 开源,鼓励全球AI社区进行研究、应用开发和实验。更重要的是,Falcon3不仅是这一系列的高光时刻,更是其持续创新之路的延续。

值得期待的是,2025年1月,TII将发布支持图像、视频及音频的多模态增强版本,同时公布详细的技术报告,为AI领域贡献更多智慧。

06、结语

Falcon3系列的推出标志着AI技术的一次重要跨越。通过其在性能、效率和灵活性上的全面提升,Falcon3 不仅为开发者和研究人员提供了强大的工具,更开启了一个更开放、更高效的AI未来。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯

原文链接:https://mp.weixin.qq.com/s/Q0ndlsdetJmwAiZmX0PW1Q