抱抱脸团队(HF)发布多模态大模型Idefics2,8B参数 原创

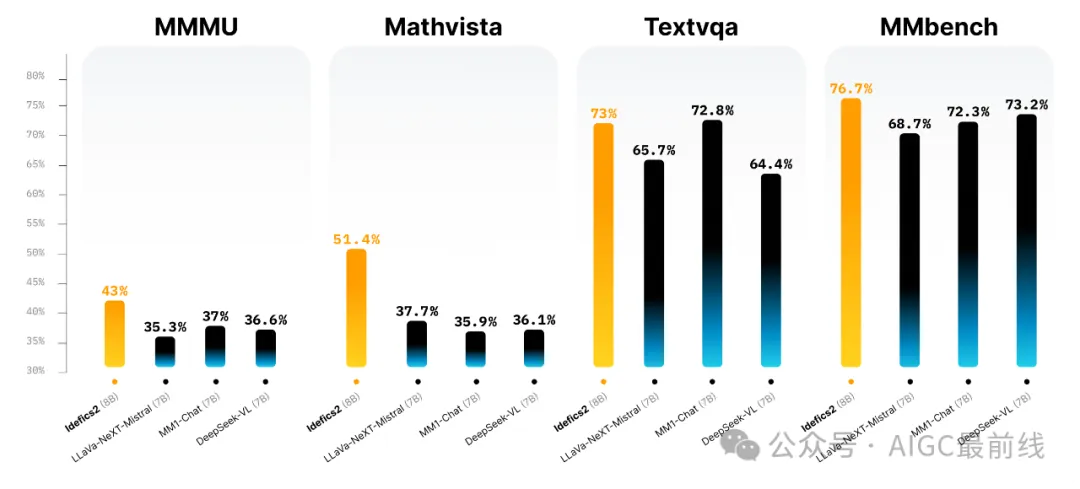

近日,抱抱脸团队(HF)发布Idefics2,一个通用的多模态大模型,可以接受任意文本和图像序列作为输入,并生成文本响应。它可以回答关于图像的问题,描述视觉内容,创建基于多个图像的故事,从文档中提取信息,并执行基本算术运算。Idefics2改进了Idefics1:具有8B参数、开放许可(Apache 2.0)和增强的OCR(光学字符识别)功能,Idefics2是多模态工作社区的坚实基础。它在视觉问答基准上的表现居于同类模型的前列,并与LLava-Next-34B和MM1-30B-chat等更大的模型竞争。

训练数据

Idefics2在预训练过程中使用了一系列公开可用数据集进行训练:交错的网页文档(维基百科、OBELICS)、图像-标题对(公共多模态数据集、LAION-COCO)、OCR数据(PDFA(英文)、IDL和渲染文本)以及图像到代码数据(WebSight)。交互式可视化允许探索OBELICS数据集。根据基础模型社区的通行做法,HF进一步对基础模型进行了面向任务的训练。然而,这些数据通常是以不同的格式存在,并分散在各个地方。对于社区来说,收集这些数据是一个障碍。为了解决这个问题,HF发布了一直在准备的多模态指令微调数据集:Cauldron,这是一个开放的、由50个手动策划的数据集的合集,格式化为多轮对话。HF使用The Cauldron和各种文本微调数据集的串联来对Idefics2进行了指令微调。

改进

- HF按照NaViT策略处理图像的原生分辨率(高达980 x 980)和原生宽高比。这样就避免了将图像调整为固定大小的正方形的需要,因为这在计算机视觉界一直是历史性的做法。此外,HF遵循了SPHINX的策略,并(可选地)允许子图像分割和传递非常大分辨率的图像。

- 通过整合需要模型转录图像或文档中的文本的数据,显著增强了OCR功能。我们还通过适当的训练数据,改进了在图表、图形和文档上回答问题的能力。

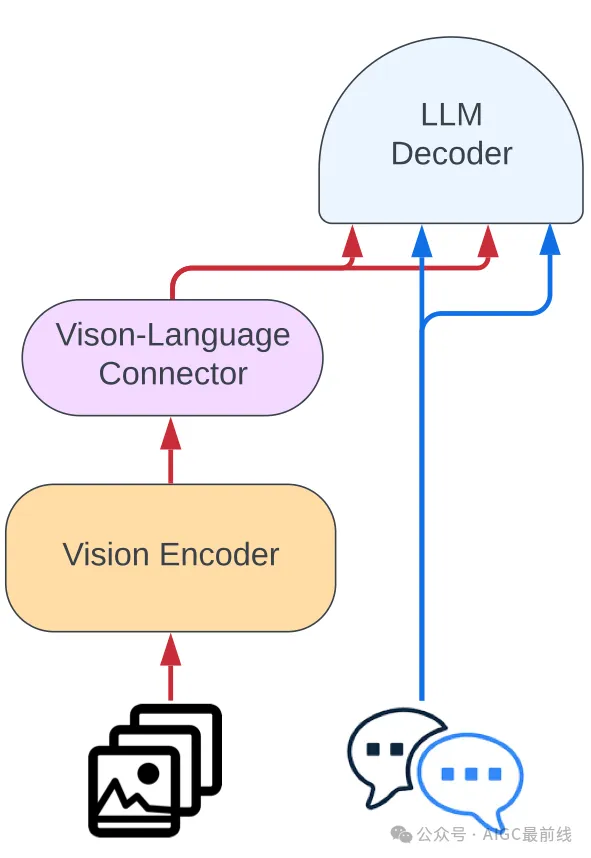

- 摒弃了Idefics1的架构(门控交叉关注)并简化了将视觉特征整合到语言骨干中的过程。图像被输入到视觉编码器中,然后是一个学习的Perceiver池化和一个MLP模态投影。然后将这个池化序列与文本嵌入拼接起来,得到一个(交错的)图像和文本序列。

所有这些改进加上更好的预训练骨干,使性能大幅提高,而模型的大小只增加了10倍。

Idefics2体系结构

开始使用Idefics2

Idefics2可在Hugging Face Hub上获得,并在最新的transformers版本中受支持。

译自(有删改):https://huggingface.co/blog/idefics2

本文转载自公众号AIGC最前线