小红书 NoteLLM-2:用于推荐的多模态表征

一、背景

本文中我们继续介绍小红书用于多模态场景笔记推荐的 NoteLLM-2。

对应的论文为:[2405.16789] NoteLLM-2: Multimodal Large Representation Models for Recommendation [1]

二、摘要

LLM 在文本理解方面展现了卓越能力,现有研究也已探讨了其在文本 Embedding 任务中的应用,然而,利用 LLM 辅助多模态表征任务的研究尚不多见。本文作者旨在探索 LLM 在多模态 Item-to-Item(I2I)推荐中增强多模态表征的潜力。

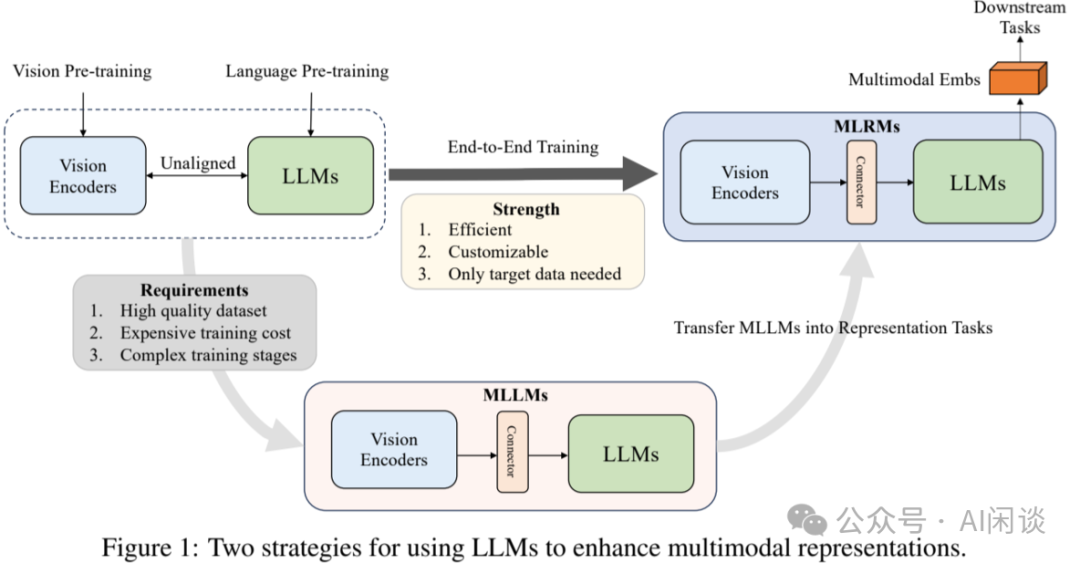

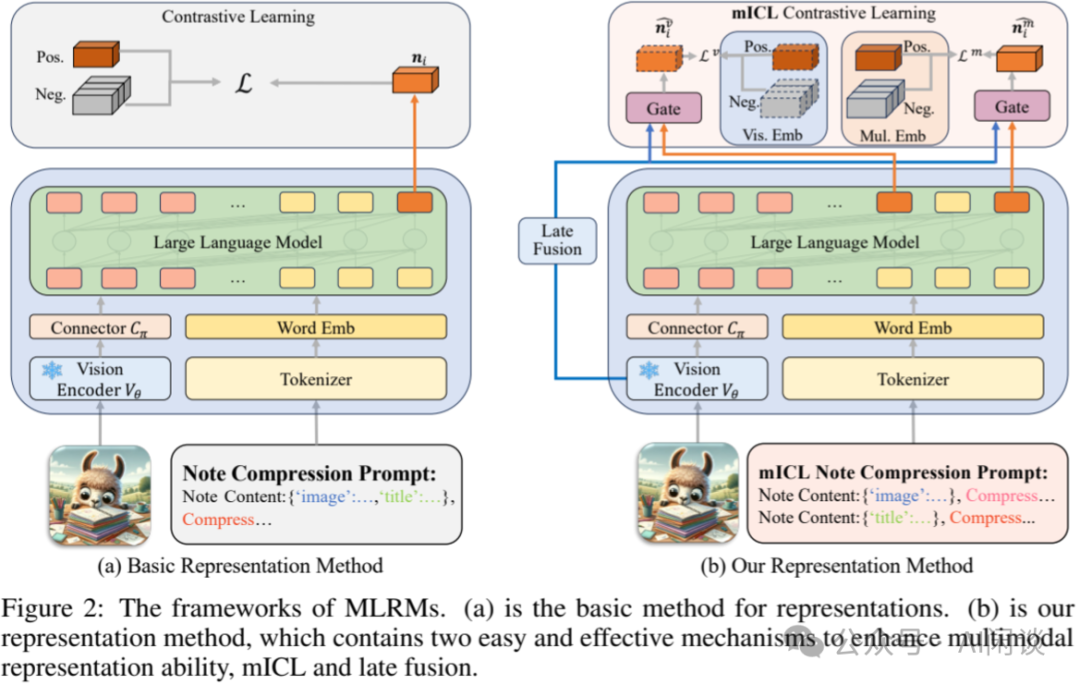

如下图 Figure 1 所示,一种可行的方法是将多模态大模型(MLLM)迁移至表征任务中(Figure 1 下部分)。然而,预训练 MLLM 通常需要收集高质量、大规模的多模态数据,导致训练过程复杂且成本高昂。这使得社区高度依赖开源 MLLM,阻碍了针对特定表征场景的定制化训练。

因此,作者设计了一种端到端的训练方法(Figure 1 上部分),能够整合任何现有的 LLM 与 Vision Encoder,以构建高效的多模态表征模型(Multimodal Large Representation Model,MLRM)。

初步实验表明,采用端到端方法微调的 LLM 往往会忽视图像内容。为克服这一挑战,作者提出 NoteLLM-2,专为多模态表征设计。作者提出了两种增强视觉信息关注度的方法:

- 第一种基于 Prompt 视角,将多模态内容分离为视觉内容与文本内容,采用多模态 In-Content Learning(ICL)方法,指导 LLM 同时关注两种模态并聚合关键信息。

- 第二种方法从模型架构出发,利用 Late Fusion 机制直接将视觉信息融入文本信息。

大量实验已证实提出方法的有效性。

三、引言

3.1 问题定义

与针对文本场景的 NoteLLM 类似,NoteLLM-2 主要用于多模态 I2I Note 推荐任务。Note Pool 为 N={n1, n2, …, nm},其中 m 表示 Note 数量。每条 Note 包含:标题(Title)、主题(Topic)、文本内容(Content)和图像(Image)。ni=(ti, tpi, cti, vi) 表示第 i 条 Note。该任务目标是从 N 中选出与 Query Note 相似的前 k 条 Target Note。

3.2 数据集构建

和 NoteLLM 类似,采用共现(co-occurrence)机制基于用户行为构建相关 Note 对。该机制基于一个假设:经常一起阅读的 Note 可能是相关的。具体来说,作者统计了用户查看 Note nA 后点击 Note nB 的次数。同时,为了区分不同用户共现的贡献,为不同的点击分配了不同的权重。具体的计算方式如下所示:

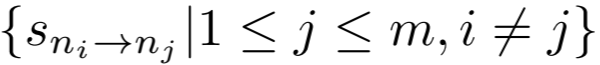

其中 SnA -> nB 表示从 Note nA 到 Note nB 的共现得分,Nu 表示用户 u 点击的 Note 集合的数量。归一化可以防止活跃用户可能的无差别点击而导致的误导。在计算完所有的 Note 对共现得分后,就可以构成共现得分集合Sni:

随后,从集合 Sni 中过滤掉得分超过上限 up 和低于下限 low 的异常 Note。最后,从过滤后的集合中选出共现得分最高的 t 条 Note,作为与 Note ni 的相关 Note。

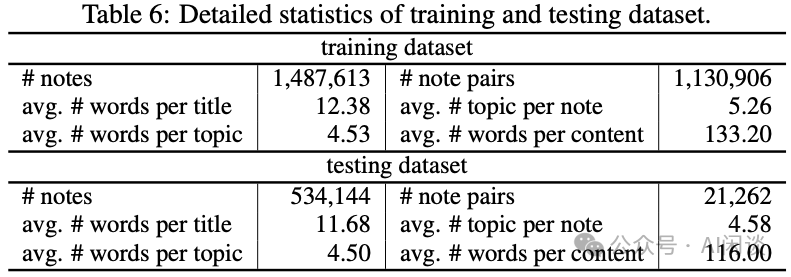

作者从平台获取了一个真实世界的多模态 I2I 数据集。从两周内收集的用户行为数据中随机选取相关 Note 对,用于构建训练数据集。训练数据集中 10% Note 对用于验证集。然后,从接下来一周的 Note 中随机选取,形成测试集的 Note Pool,排除任何已存在于训练数据集中的 Note。训练集包含 150 万条 Note 和 110 万对 Note 对。测试数据集包含 50 万条 Note 和 2.1 万对 Note 对。如下图 Table 6 为其详细的统计信息:

为更准确地评估 MLRM 的多模态表征能力,而非过度依赖文本模态,作者在测试数据集中收集了包含简短 Note 的配对数据。将 Token 长度少于 50 的 Note 定义为 Short Note,这类 Note 约占测试 Note 总数的 10%。并进一步分类:

- 将包含短 Query Note 的对定义为Short Query Pair,数量为 5620 对。

- 将包含短 Target Note 的对定义为Short Target Pair,数量为 5582 对。

- PS:如果 Query 和 Target Note 都比较短,那么该 Note 对会同时位于两个类别中?

3.3 Note 压缩提示构建

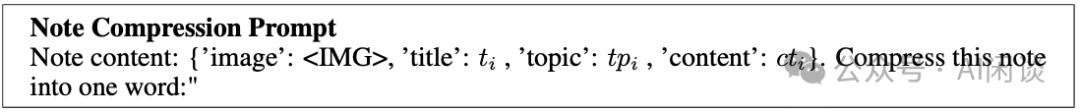

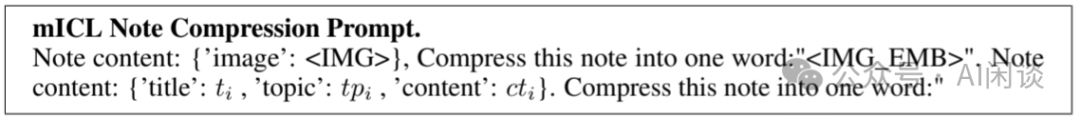

和 NoteLLM 类似,Note 压缩 Prompt 如下图所示,只不过多了 <IMG> placeholer,在实际使用时需要替换为对应的 Vision Embedding:

四、方案

作者发现未经 Pretrain 而 End2End 训练的 MLRM 表现欠佳,主要原因在于 LLM 处理后容易忽略 Vision 信息。因此,作者的设计更加关注 Vision 信号,为此,作者提出 NoteLLM-2,该框架包含两种从不同角度考量的方法:

- 第一种:从 Prompt 视角出发,称为mICL。此方法通过调整 Prompt 来改变对 Vision 信息的 Attention 模式。

- 第二种:从模型架构角度出发,将 Late Fusion 与 Vision Prompt 相结合。通过延迟 Vision 信息的融合,增强 Vision 信息对最终 Representation 的影响。

改进后的整体框架如下图 Figure 2(b) 所示。具体而言,给定 Note ni,mICL 机制并不尝试将多模态信息压缩为一个单一 Token,而是将多模态 Note 拆分为两种模态。随后,采用类似于 ICL 的方式来聚合多模态信息:

作者将 Note 压缩 Prompt 重新表述成如下所示,其中 <IMG_EMB> 是一个特殊 Token:

在利用 LLM 处理多模态 Embedding 后:

- 选择相关的 Hidden State 来表示 Note,记作 nvi。由于 Decoder 的 Causal Attention 机制,nvi 仅包含 Note 的 Vision 信息。

- 同时选取最后一个 Token 的 Hidden State 作为多模态 Note Representation,记作 nmi,包含 Vision 和文本信息。

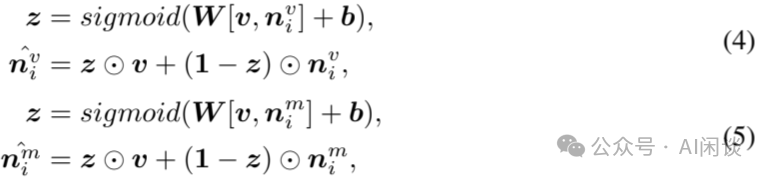

Late Fusion 机制采用原始 Vision Embedding 来增强 Note Embedding,这避免了因 LLM 空间导致的文本偏差,并融入更多原始 Vision 信息。其中的 Vis Emb 是通过 Vision Encoder 对整幅图提取的视觉特征,比如 CLIP ViT-B 中 [CLS] Token 对应的 Hidden State。随后采用线性层将这些特征转换到 LLM 空间,记作 v ∊ ℝht,采用相同的门控机制,将原始 Vision 信息融合进两个 Note Embedding 中:

其中  和

和 表示融合的 Note Embedding。[⋅,⋅] 表示连接操作,而 𝑾 和 𝒃 是可学习的参数。⊙ 是逐元素乘积。

表示融合的 Note Embedding。[⋅,⋅] 表示连接操作,而 𝑾 和 𝒃 是可学习的参数。⊙ 是逐元素乘积。

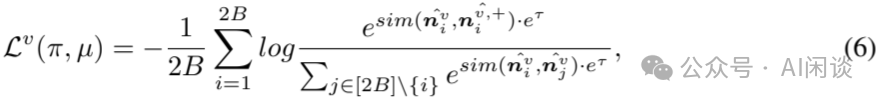

接下来,采用两个融合的 Embedding 进行对比学习,如下所示:

其中 是来自 Vision Note Embedding 的损失,而

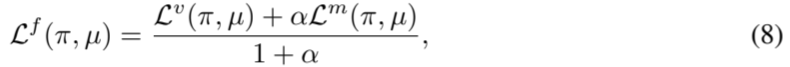

是来自 Vision Note Embedding 的损失,而 是来自多模态 Note Embedding 的损失。最终损失的计算方式如下:

是来自多模态 Note Embedding 的损失。最终损失的计算方式如下:

其中 α 是超参数。在评估中,我们使用  作为 Note Embedding,其包含多模态信息。

作为 Note Embedding,其包含多模态信息。

五、实验&结论

5.1 实验配置

在构建相关 Note 对时,将共现分数的上限 up 设定为 30,下限 low 设定为 0.01,并将 t 值设为 3。为了遵守 Contex 长度限制,对超过 20 个 Token 的标题进行截断,对超过 80 个 Token 的内容进行截断。在微调实验中,为了公平比较,添加了一个线性 Projector,将 Note Embedding 的维度降至 64。Batch Size B 设置为 128(在 8 x 80GB A100 上训练,每个 GPU Batch Size 为 16),每 Batch 包含 256 条 Note。温度参数 ε 初始化为 3。更多训练超参数如下图 Table 7 所示,训练中使用 DeepSpeed Zero-3 训练(由于 Qwen-VL-Chat 每个图像有 256 个 Vision Embedding,因此在 32 x 80GB A100 训练,每个 GPU 的 Batch Size 为 4):

为了评估 MLRM 的表征能力,作者根据 Query Note 的内容对 Note Pool 中的所有 Note(不包括Query Note)进行排序。并根据 Target Note 在排序列表中的位置计算召回率。在测试数据集上报告 All Pair、Shore Query Pair 和 Short Target Pair 的 Recall@100、Recall@1k 和 Recall@10k。

5.2 微调的 MLRM 的多模态表征性能

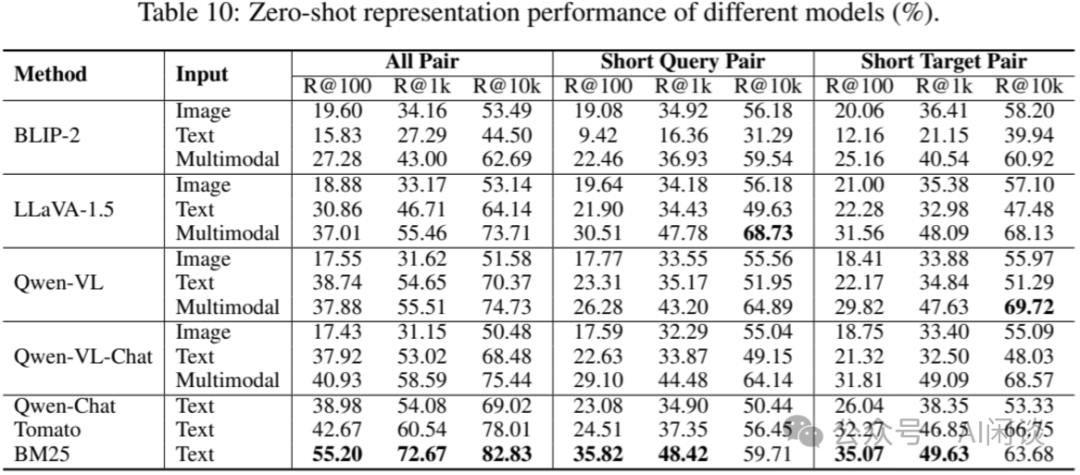

使用几个开源的 MLLM 进行 zero-shot 实验,如下图 Table 10 所示,发现 zero-shot 不足以使 MLLM 适应表征任务,其性能甚至比基线 BM25(The Probabilistic Relevance Framework: BM25 and Beyond Contents [2]) 还要差,因此有必要对 MLLM 进行微调以用于表征任务。

作者设计了三种端到端的 MLRM 来检验表征训练方法:

- MTomato-Base:使用 Tomato(作者基于 LLaMA 2Continuous Pretraining 的 LLM,其缺乏视觉感知能力)作为 LLM,CLIP ViT-B作为 Vision Encoder,以及一个随机初始化的Q-Former作为 Connector,以提高效率。

- MQwen-Base:使用Qwen-Chat替换 MTomato-Base 中的 Tomato。

- MQwen-bigG:使用ViT-bigG替换 MQwen-Base 中的 CLIP ViT-B。

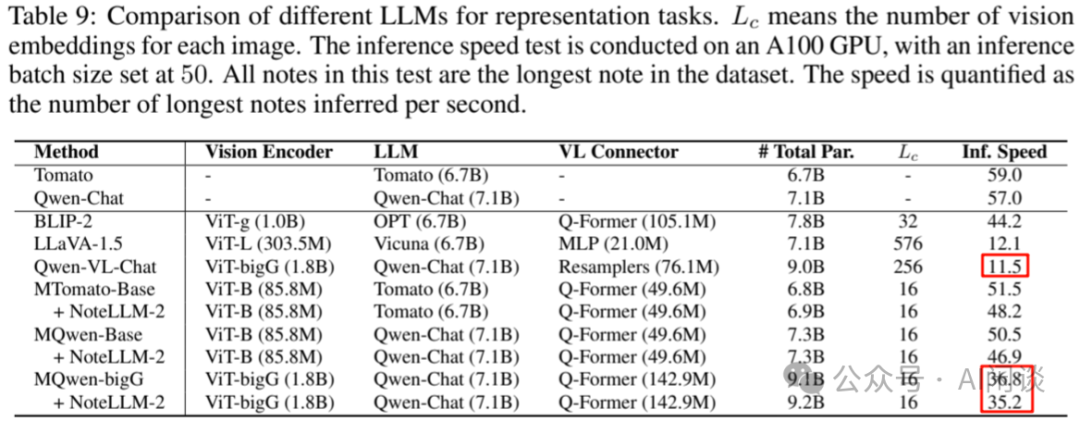

如下图 Table 9 所示为不同模型详细的配置以及推理速度对比:

作者将这些模型的 Vision Embedding 长度设置为 16,以提高效率。为了进行比较,选择两种预训练的 MLLM:BLIP-2 和 Qwen-VL-Chat 进行对比。这些模型中的所有 Vision Encoder 都被冻结以支持更大的 Batch Size。

结果下图 Table 1 所示, 可以观察到:

- 首先,基于 LLM 的 MLRM 显著优于现有基线。All Pair 评估中,Qwen-VL-Chat 在 R@100 上相比传统的 METER Co-attn 取得 10.78%(78.54/68.22) 的提升。

- 其次,端到端的训练表征方法可以增强模型的多模态表示能力。All Pair 评估中,MQwen-bigG 相比 Qwen-Chat 在 R@100 上提高 6.31%(77.64/73.03)。

- 然而,当 Vision Encoder 很小,例如 CLIP ViT-B 时,多模态感知的增强并不明显(73.03 -> 74.02)。

- 最后,尽管使用相同的 Vision Encoder 和 LLM,MQwen-bigG 比 Qwen-VL-Chat 更有效率(上图 Table 9 的11.5 ->35.2/36.8),但性仍然存在差距(下图最后两行)。

5.3 性能评估

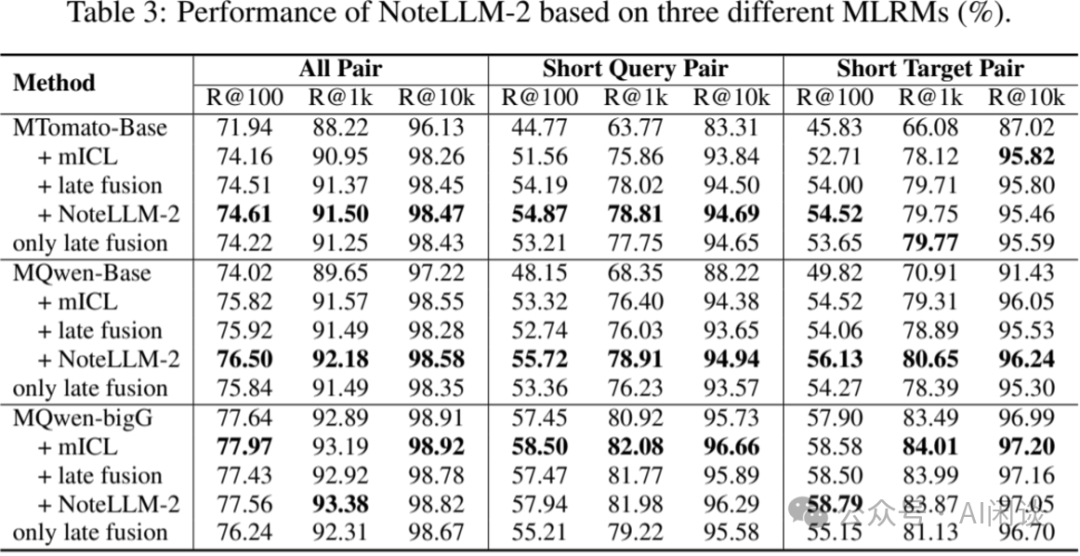

作者在三种 MLRM 上对 NoteLLM-2 的所有组件进行实验,以验证方法的有效性。此外,还进行了消融研究——仅采用 Late Fusion 策略,即仅通过 Late Fusion 整合图像与文本信息,而不将图像 Embedding 输入至 LLM。

实验结果如图 Table 3 所示:

- 首先,Vision Encoder 相对较小时,NoteLLM-2显著提升 MTomato-Base 和 MQwen-Base 的整体性能。

- 同时,NoteLLM-2主要增强了 MQwen-bigG 在 Short Pair上的表现。

- 其次,mICL 提升了所有模型的性能,而Late Fusion 在 Vision Encoder 较小的模型中效果更为显著。

- 此外,仅采用Late Fusion是一种直接且高效的融合方式,但在 Vision Encoder 能力更强时可能成为限制,因为它可能无法充分有效地与 LLM 交互,导致性能下降。

- 最后,MQwen-bigG 结合 NoteLLM-2 的表现仍不及 Qwen-VL-Chat,特别是在 Short 对方面。作者认为这归因于MQwen-bigG(16 个 Vision Token)与Qwen-VL-Chat(256 个 Vision Token)在 Vision Token 个数上的显著差异。

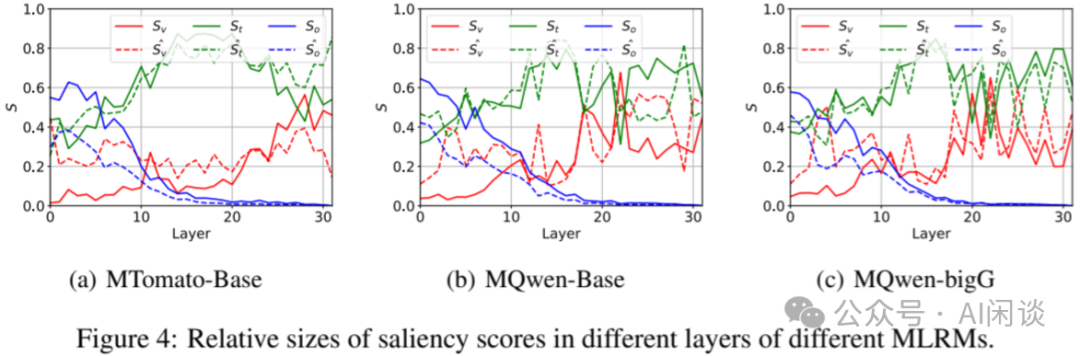

5.4 增强型 MLRM 的显著性评分

为进一步探究 NoteLLM-2 对 MLRM 的影响,作者展示了增强型 MLRM 在显著性分数上的差异。原始微调方法的显著性分数为 Sv、St 和 So,而增强微调方法的显著性分数为

、

、 和

和 。作者将视觉 Note 压缩 Token 视为 Vision Embedding Ev 的一部分。

。作者将视觉 Note 压缩 Token 视为 Vision Embedding Ev 的一部分。

实验结果如下图 Figure 4 所示,所有增强型 MLRM 的表征均强化了对图像的直接关注,同时在浅层减少了对 So 的重视,而 St 则基本保持不变。这一现象归因于 mICL 采用相同的压缩 Prompt 对两种模态进行压缩,通过识别图像信息中的相似压缩模式,mICL 能够增强多模态表征对图像的集中度,这与 ICL 的作用机制相似。

5.5 超参分析

作者使用 MTomato-Base 进行超参数分析实验。

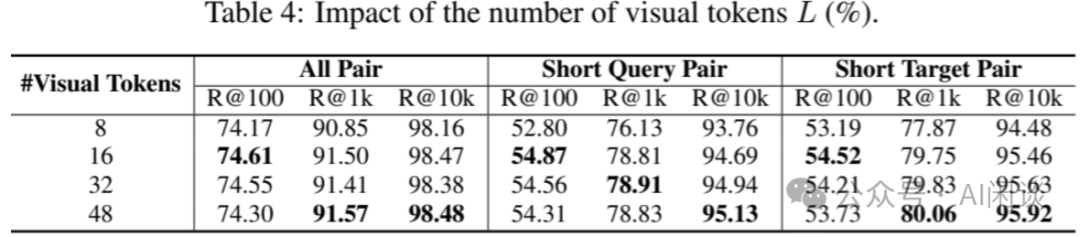

视觉 Token 长度的影响,如下图 Table 4 所示。将长度从 16 缩减至 8,在 Short Pair 任务中性能有所下降,表明视觉 Token 长度与推理速度之间存在性能权衡。

文本与视觉损失比例的影响,如下图 Table 5 所示。当比例较小时,性能略有下降;但随着比例增大,发现对文本与视觉损失比例的变化表现出不敏感性。

六、参考链接

- https://arxiv.org/abs/2405.16789

- https://www.staff.city.ac.uk/~sbrp622/papers/foundations_bm25_review.pdf

本文转载自 AI闲谈,作者: AI闲谈