清华大学深度解析:RLHF 真的能规模化吗?

图片

图片

RLHF 的规模化之谜:真的值得无限投入算力吗?

强化学习自人类反馈(RLHF)已成为大语言模型(LLM)后训练的关键步骤,帮助 ChatGPT、Llama 等模型更符合人类偏好。然而,RLHF 是否像预训练那样,能通过增加算力和数据带来持续提升?清华大学与知乎 AI 的最新研究对此进行了系统性分析,揭示了 RLHF 的规模化极限,并提出优化策略。

图片

图片

研究方法:三大核心变量的深入探究

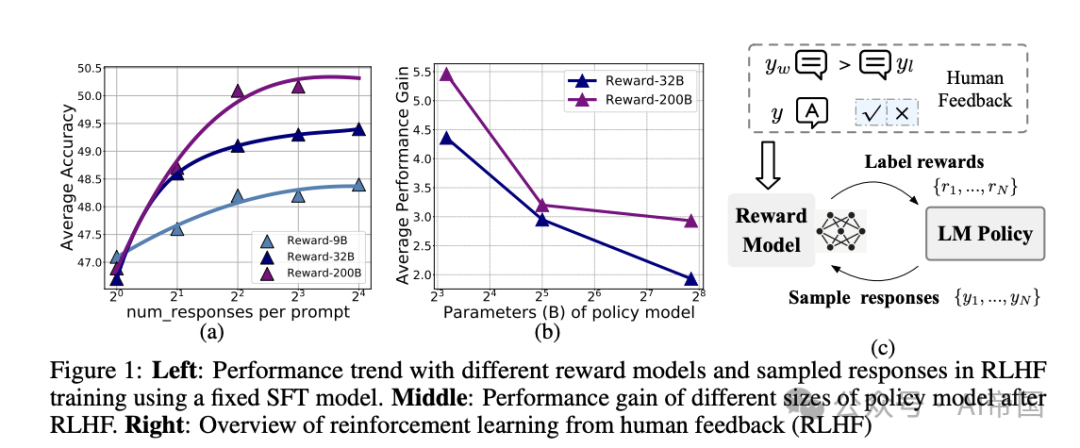

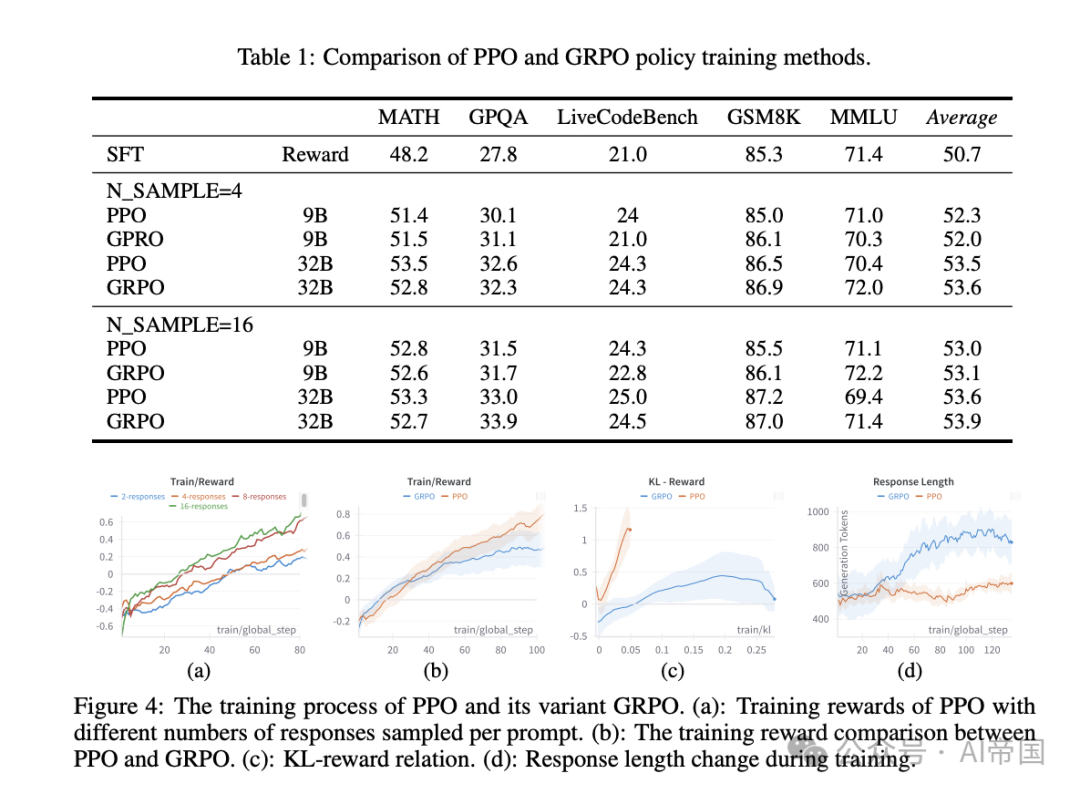

研究团队围绕 模型规模、数据多样性、推理计算预算 三大因素,训练了超过 20 种不同规模 的模型,涵盖 9B、32B、200B 参数量级,并对比不同的 RLHF 训练策略(如 PPO 和 GRPO)。他们重点分析了 RLHF 在 推理任务 方面的表现,同时也进行了通用对话任务实验。

RLHF 的规模化困境:效果递减,收益有限

研究发现,RLHF 在规模化方面存在诸多挑战:

单个 Prompt 采样更多的回复可以提升训练效果,但收益迅速趋于平稳(如从 1 个增加到 4 个效果明显,但 8-16 个收益递减)。

增大奖励模型(Reward Model)的规模有所帮助,但提升远小于“最佳 N 选一”方法。

在固定奖励模型的情况下,增大策略模型(Policy Model)规模收益有限。

早期训练阶段收益较大,但随着数据增加,额外提升非常有限。

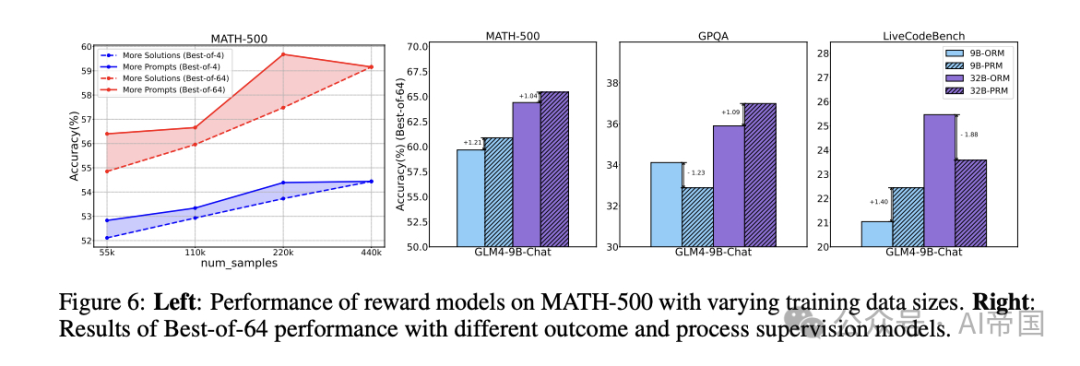

奖励模型的训练数据多样性比数量更重要,尤其是 Prompt 的多样性影响更大。

基于过程监督(Process Supervision)的标注比基于最终结果的监督效果更好,但泛化能力有限。

总的来说,RLHF 不像预训练那样具备明显的规模化趋势,投入更多算力并不会带来线性增长的效果。这可能与奖励模型学习误差、策略优化方法的局限性等因素相关。

图片

图片

RLHF 训练的优化策略:如何在有限算力下最大化收益?

尽管 RLHF 存在规模化限制,该研究也提出了一些 计算资源受限条件下的优化方案:

✅ 适度增加采样数量(如从 1 提升到 4 个),能够高效提升训练效果。

✅ 增加奖励模型的数据多样性,尤其是 Prompt 设计,而非简单增加数据量。

✅ 采用过程监督(Process Supervision)而非仅仅依赖结果监督,可以在目标任务上带来更好表现。

图片

图片

未来展望

这项研究表明,当前 RLHF 技术无法像预训练那样无限规模化,未来需要探索更具可扩展性的强化学习算法,以进一步释放 RLHF 在 LLM 训练中的潜力。

本文转载自 AI帝国,作者: 无影寺