VLLM 与 Ollama:如何选择合适的轻量级 LLM 框架?

VLLM是一款经过优化的推理引擎,在令牌生成速度和内存管理效率上表现出色,是大规模AI应用的理想之选。Ollama则是一个轻量级、易上手的框架,让在本地电脑上运行开源大语言模型变得更加简单。

那么,这两个框架该选哪一个呢?接下来,我们会从性能、易用性、适用场景、替代方案,以及详细的安装步骤等方面进行全面对比,帮助你做出更合适的选择。

一、VLLM和Ollama是什么?基础知识解析

在深入探讨之前,我们先来了解一下这两个框架的核心功能。

什么是VLLM?

VLLM(超大型语言模型)是SKYPILOT开发的推理优化框架,主要用于提升大语言模型在GPU上的运行效率。它的优势体现在以下几个方面:

- 快速令牌生成:采用连续批处理技术,让令牌生成速度大幅提升。

- 高效内存利用:借助PagedAttention技术,在处理大上下文窗口时,能有效控制GPU内存消耗。

- 无缝集成:与PyTorch、TensorFlow等主流深度学习平台兼容,可轻松融入AI工作流程。

VLLM深受AI研究人员和需要大规模高性能推理的企业青睐。

什么是奥拉玛(Ollama)?

Ollama是一个本地大语言模型运行时环境,能简化开源AI模型的部署和使用流程。它具备以下特点:

- 预打包模型丰富:内置了LLaMA、Mistral、Falcon等多种模型。

- 硬件适配性强:针对日常使用的硬件进行了CPU和GPU推理优化,无论是MacBook、PC还是边缘设备,都能流畅运行AI模型。

- 操作便捷:提供简洁的API和命令行界面(CLI),开发人员只需简单配置,就能快速启动大语言模型。

对于想在个人电脑上尝试AI模型的开发人员和AI爱好者来说,Ollama是个不错的选择。

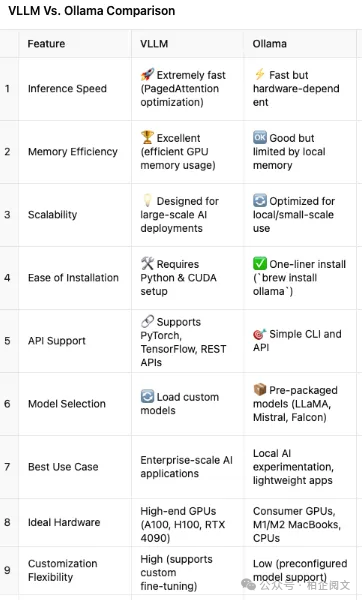

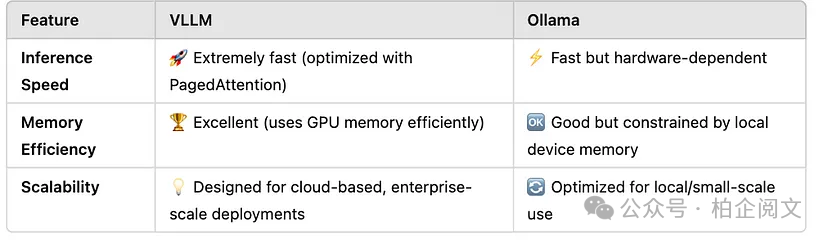

二、性能大比拼:速度、内存与可扩展性

性能是衡量推理框架优劣的关键指标,下面我们从速度、内存效率和可扩展性三个方面,对VLLM和Ollama进行对比。

关键性能指标分析

VLLM借助PagedAttention技术,在推理速度上优势明显,处理大上下文窗口时也能游刃有余。这让它成为聊天机器人、搜索引擎、AI写作辅助工具等高性能AI应用的首选。

Ollama的速度也还不错,但受限于本地硬件配置。在MacBook、PC和边缘设备上运行小型模型时表现良好,不过遇到超大模型就有些力不从心了。

结论:Ollama更适合初学者,而需要深度定制的开发人员则可以选择VLLM。

三、应用场景:VLLM和Ollama分别适用于哪些场景?

VLLM的最佳应用场景

- 企业AI应用:如客户服务聊天机器人、AI驱动的搜索引擎等。

- 云端高端GPU部署:适用于A100、H100、RTX 4090等高端GPU的云端大语言模型部署。

- 模型微调与定制:方便进行模型微调和运行自定义模型。

- 大上下文窗口需求:适用于对上下文窗口要求较高的应用。

不太适用的场景:个人笔记本电脑、日常AI实验。

Ollama的最佳应用场景

- 本地设备运行:无需借助云资源,就能在Mac、Windows或Linux系统的设备上运行大语言模型。

- 本地模型试验:不需要复杂的设置,就能在本地轻松试验各种模型。

- 简易API集成:开发人员可以通过简单的API将AI功能集成到应用程序中。

- 边缘计算应用:在边缘计算场景中表现出色。

不太适用的场景:大规模AI部署、高强度GPU计算任务。

总结:VLLM更适合AI工程师,而Ollama则是开发人员和AI爱好者的好帮手。

四、如何上手使用?(分步指南)

VLLM入门教程

- 安装依赖项:在命令行中输入pip install vllm,按提示完成安装。

- 在LLaMA模型上运行推理:在Python环境中,输入以下代码:

上述代码中,首先从vllm库中导入LLM类,然后创建LLM对象,并指定使用meta-llama/Llama-2-7b模型。最后,使用generate方法输入问题“What is VLLM?”,就能得到模型的输出结果。

Ollama入门教程

- 安装Ollama(Mac/Linux系统):在终端中输入brew install ollama,等待安装完成。

- 下载并运行模型:在终端输入ollama run mistral,即可下载并运行Mistral模型。

- 调用Ollama的API:在Python环境中,使用以下代码调用API:

上述代码中,首先导入requests库,然后使用requests.post方法向本地的Ollama API发送请求,请求地址为http://localhost:11434/api/generate,并在请求中指定使用的模型为mistral,输入的提示内容为“Tell me a joke”。最后,打印API返回的结果。

总结:Ollama安装更简单,而VLLM的定制性更强。