把 DeepSeek 部署在你的电脑上,保姆级教程,建议收藏! 原创

本地电脑部署主要适用于以下5种场景:

第一、设备性能较强,配备独立显卡,能够支撑高效运行。

第二、需要处理敏感数据,对数据安全性有较高要求,以防泄露。

第三、需要与本地工作流程紧密结合,应对频繁或复杂的任务处理。

第四、日常频繁使用,且 API 调用成本较高,本地部署有助于降低成本。

第五、希望在开源模型基础上,进行个性化定制和优化。

1、DeepSeek R1 模型部署2步搞定

本部分内容将重点阐述如何在本地环境下利用 Ollama 来部署 DeepSeek R1。后续章节将详细讲解如何将 DeepSeek R1 与 Open-WebUI 系统进行集成,让交互界面更美观。

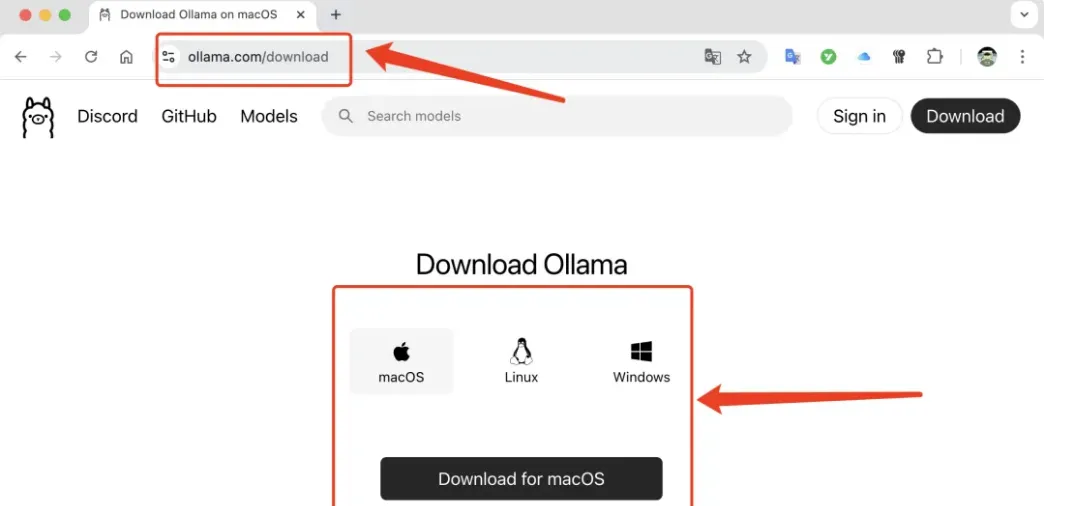

第一、安装 Ollama

请访问 Ollama 的官方网站,根据你的操作系统选择合适的版本,下载 Ollama应用程序并进行安装。

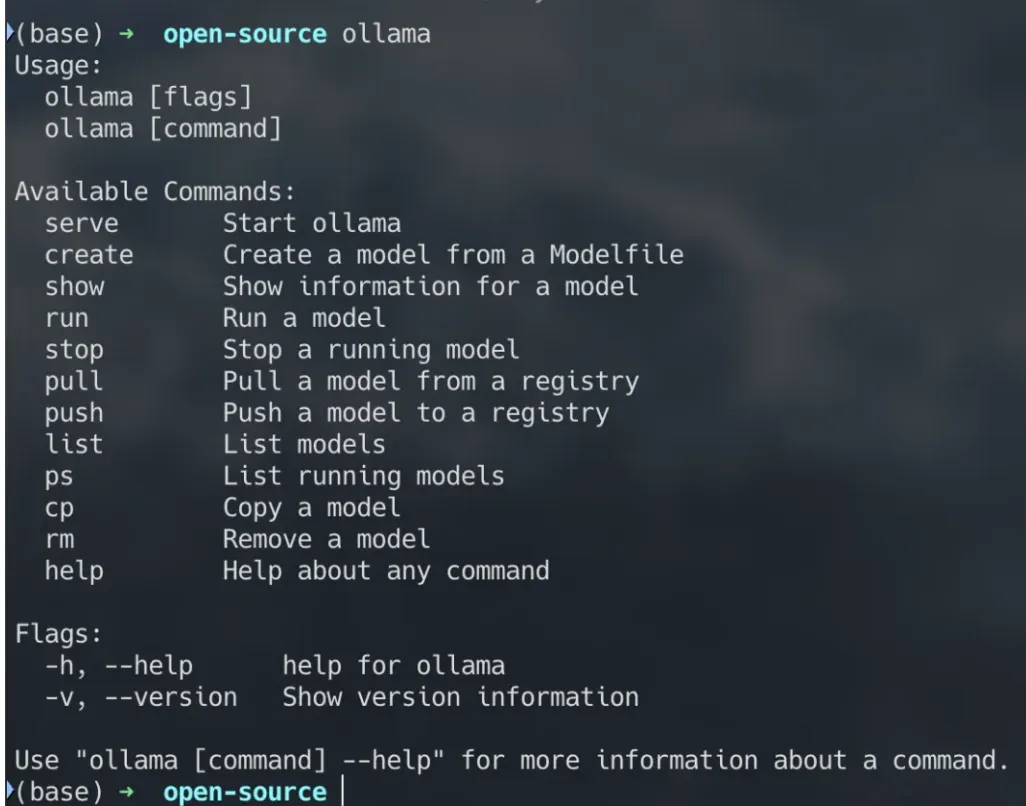

安装完成后,打开命令行界面并输入

命令。如果屏幕上出现以下提示信息,那么恭喜你,Ollama 已经成功安装。

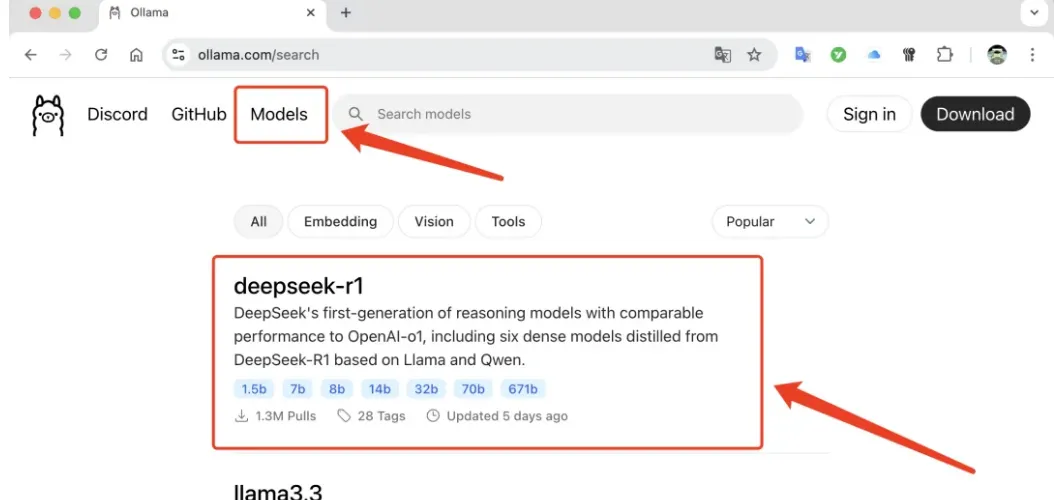

第二、部署 DeepSeek R1 模型

首先,访问 Ollama 官网并点击页面顶部的「模型」(Models)选项,接着在列表中找到并点击「DeepSeek R1」:

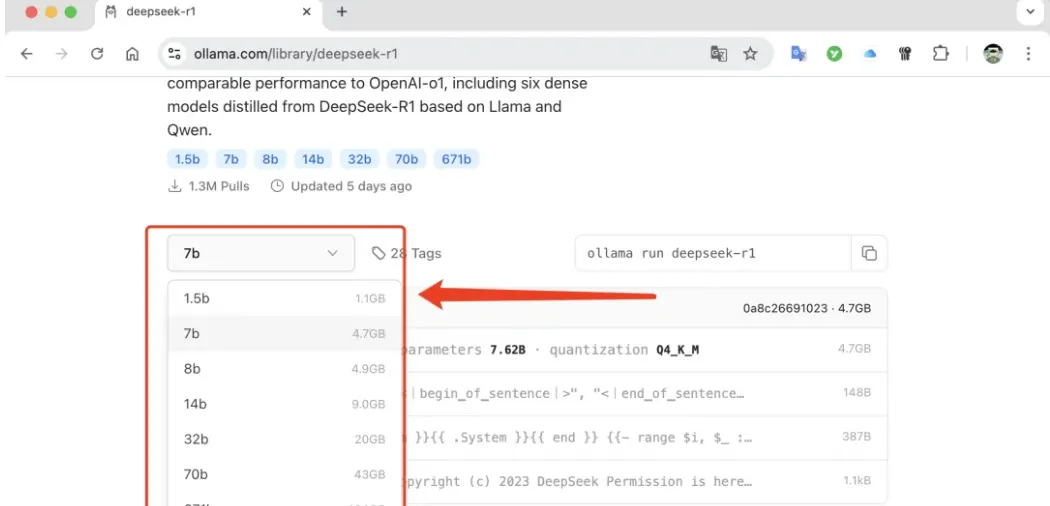

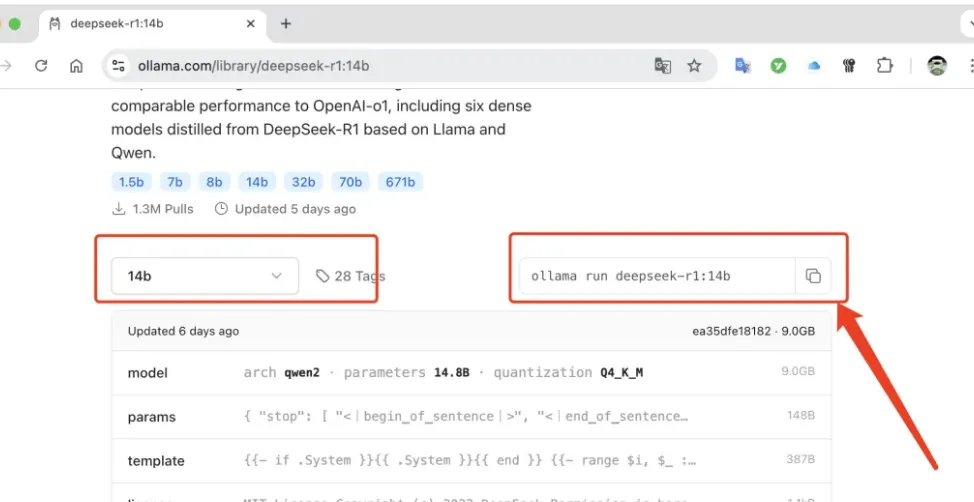

在模型详情页面,根据您的计算机显存容量选择合适的模型版本:

例如,我的电脑运行的是 MacOS 系统,拥有 32GB 的显存,因此我选择了14b 版本的模型。点击 14b 版本,页面右侧将显示下载指令:

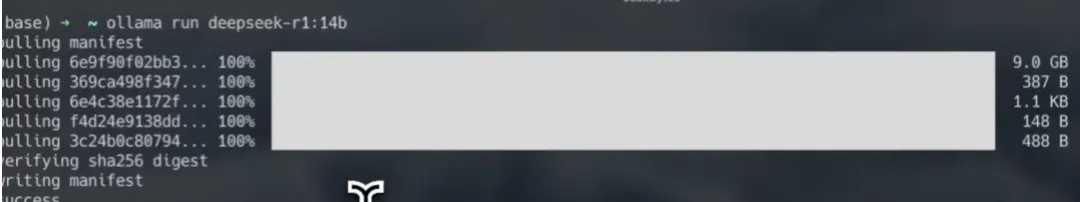

将此下载命令复制并粘贴到命令行中执行:

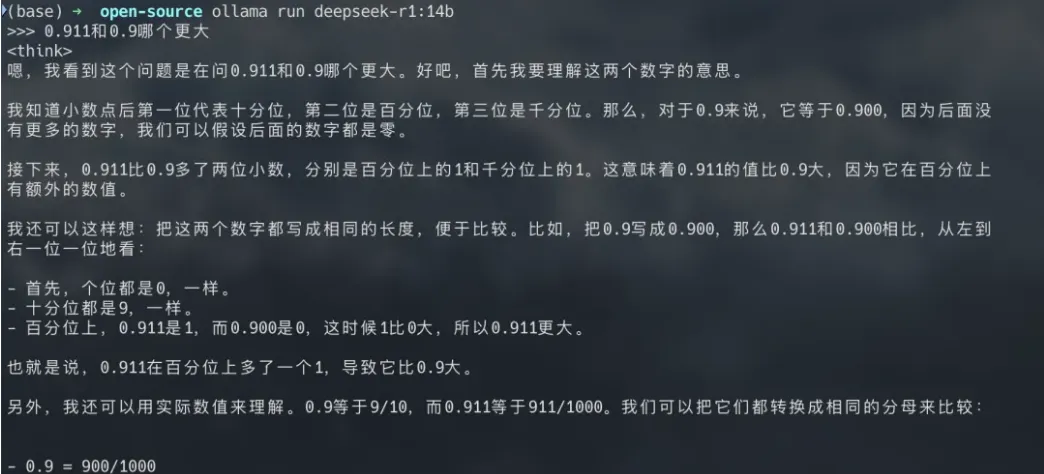

待命令执行完毕,您就可以通过命令行与大模型进行交互了:

然而,仅通过命令行与大模型交流可能不够便捷。因此,接下来,我们将介绍与 Open-WebUI 系统进行集成,让交互界面更美观。以便通过更直观的图形界面进行操作。

2、安装 Open-WebUI 交互界面

安装 Open-WebUI,按照以下4个步骤来操作:

第一、首先安装 Docker, 利用 Docker 来管理操作系统界面,这比直接安装Open-WebUI 更为便捷。访问 Docker 官方网站(https://www.docker.com/)进行下载。

第二、根据您的电脑操作系统,下载 Docker 桌面版并进行安装。

安装完成后,请重启电脑以确保 Docker 能够正常运行。电脑重启后,如果桌面上出现Docker 图标,表明安装成功。

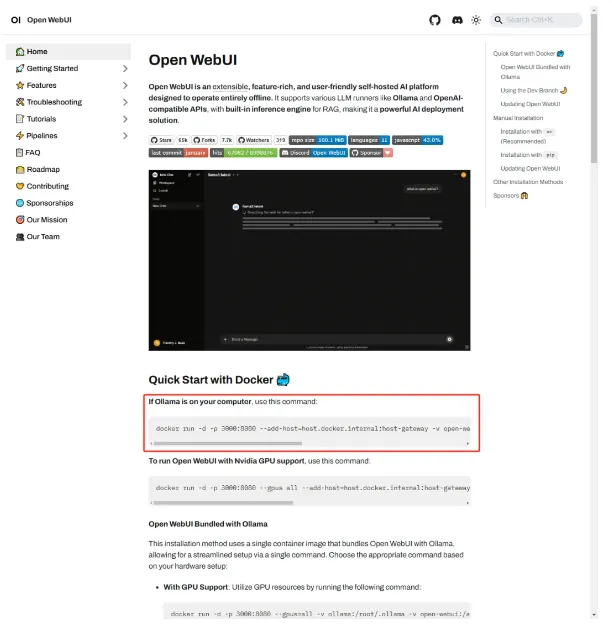

第三、安装 Open-WebUI

在浏览器中搜索 Open-WebUI,进入其官网,并复制显示在红框中的安装命令。

按照上述指示,打开命令行工具,粘贴复制的命令,然后等待安装完成。

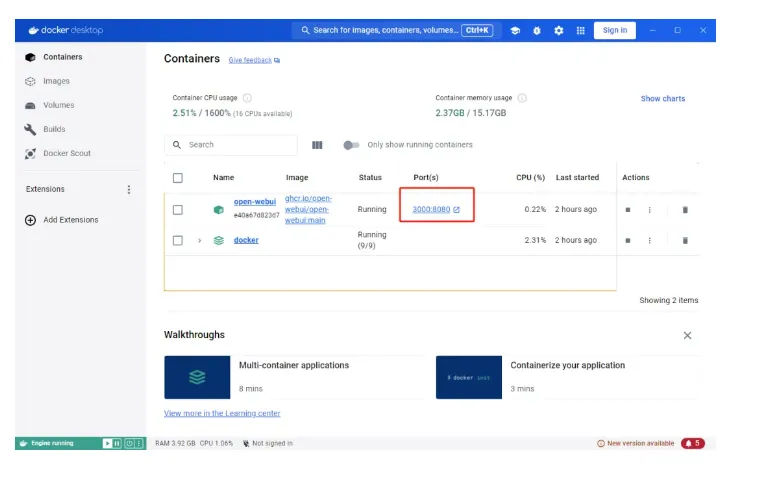

第四、启动 Open-WebUI

双击桌面上的 Docker 图标以打开应用,点击红框标注的端口,即可启动 Open-WebUI。

首次访问时,您需要注册一个账号。这些信息将会存储在您的电脑上。

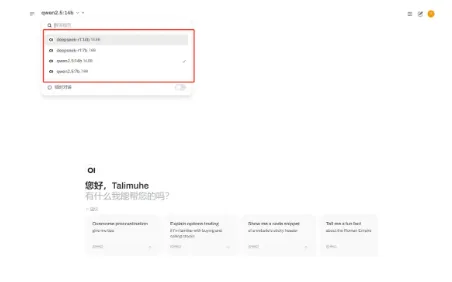

第五、开始对话

在界面的左上角选择您的 DeepSeek R1 大模型,之后便可开始对话。

请注意,Open-WebUI 的安装过程在此仅作简要说明。若遇到错误,您需要可以借助 DeepSeek R1 大模型协助解决问题的能力。

本文转载自公众号玄姐聊AGI 作者:玄姐