用强化学习重塑多模态AI:解读Kimi k1.5的突破与创新 原创

01、概述

近年来,随着人工智能的快速发展,强化学习(Reinforcement Learning,RL)技术逐渐成为推动AI模型性能提升的重要工具。相比传统的基于静态数据集的训练方法,RL通过交互与反馈实现了模型性能的迭代优化,为解决复杂任务(如数学推理、代码生成和多模态数据理解)开辟了全新路径。

在这种背景下,由Kimi团队开发的下一代多模态大语言模型——Kimi k1.5,凭借其创新的设计和卓越的性能脱颖而出。本文将详细解析Kimi k1.5的技术亮点、突破性成果以及对AI未来发展的意义。

02、传统LLM的挑战与RL的机遇

当前,大语言模型(LLMs)主要依赖于静态数据集的大规模预训练。然而,这种方法在处理动态探索和适应性决策任务时暴露出诸多局限:

- 推理能力受限:传统LLMs在复杂推理任务中,难以动态适应任务需求,特别是在长上下文、多步骤推理和多模态理解方面。

- 计算效率瓶颈:复杂推理方法(如链式思维“Chain-of-Thought” prompting)虽然能够提升推理质量,但计算成本高昂,且受制于模型的上下文窗口大小。

- 缺乏可扩展的RL框架:现有的RL实现由于提示设计、策略优化和数据处理上的效率低下,未能实现顶尖性能,导致在关键基准测试中的表现乏力。

Kimi k1.5正是在这些挑战的基础上,构建了一种创新性的解决方案,将RL与扩展上下文能力结合,开创了多模态推理的新篇章。

03、Kimi k1.5:开创多模态推理的全新标准

1) 两种模型版本:长-CoT与短-CoT

Kimi k1.5 包含两个版本,分别针对不同任务需求进行优化:

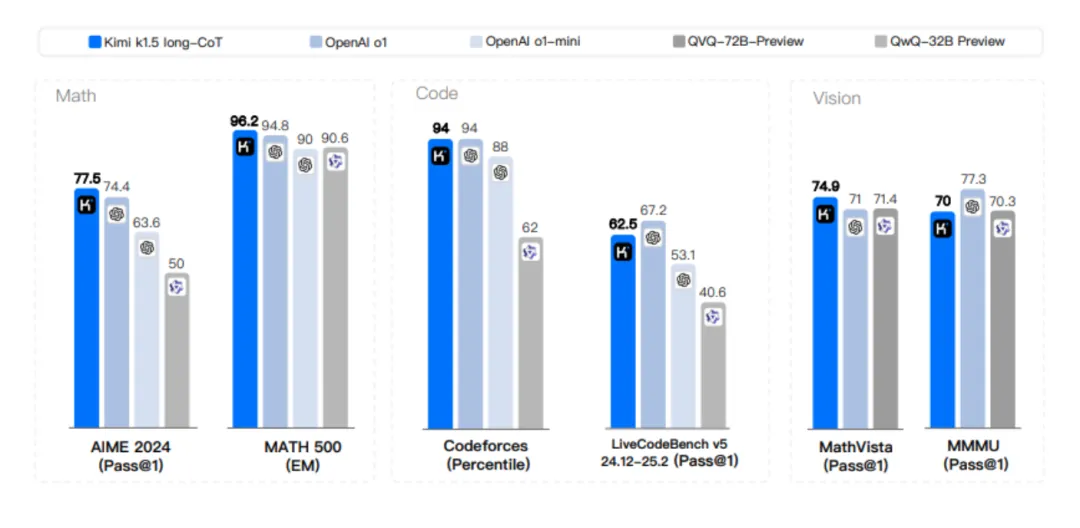

长-CoT模型

- 支持高达128,000个token的超长上下文窗口,在处理复杂的多步骤推理任务中表现出色。

- 关键成果:MATH500基准测试中取得96.2%的准确率,Codeforces测试中达到前94%,展现了其处理复杂问题的强大能力。

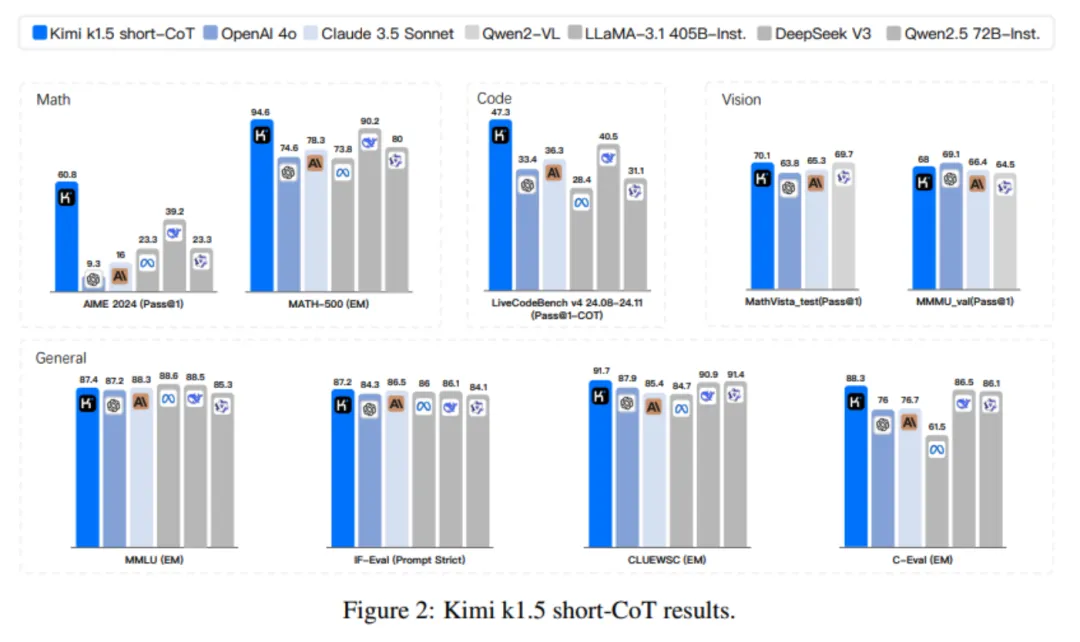

短-CoT模型

- 通过先进的“长到短上下文”训练方法,成功将长-CoT模型的推理能力转移到短上下文模型中。

- 在保持高性能的同时显著降低了计算资源需求,例如在AIME测试中达到60.8%,并在MATH500测试中保持**94.6%**的高准确率。

2) 创新性技术突破

Kimi k1.5 的开发过程中融合了多项技术创新,使其在效率与性能上实现平衡:

长上下文扩展(Long-Context Scaling)

- 支持超长上下文窗口(128k tokens),为复杂推理任务提供了充足的语境支持,打破了传统LLMs上下文窗口的限制。

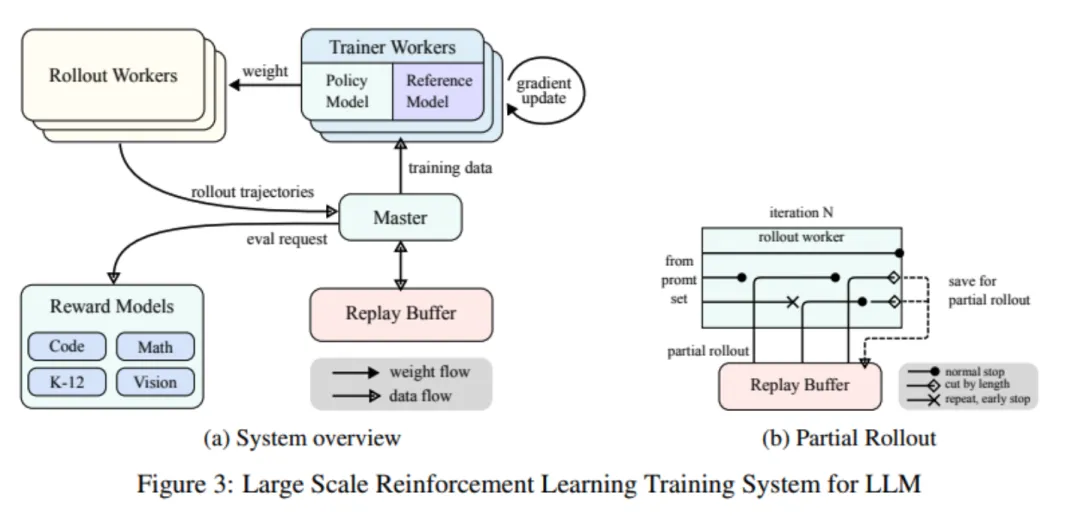

部分回滚技术(Partial Rollouts)

- 通过重复利用先前计算的轨迹,在长上下文处理过程中显著提升了计算效率,降低了资源消耗。

强化学习提示优化

- 设计多样化的提示集,包括STEM、编程和通用推理任务,使模型具备更高的适应性和泛化能力。

多模态数据整合

- 结合真实与合成的视觉推理数据集,显著提升了模型在文本和图像联合推理任务中的表现能力。

高级采样策略

- 采用“课程学习”和“优先采样”策略,重点优化模型在弱势任务中的性能分配,确保训练资源集中于最具影响力的领域。

04、超越传统:Kimi k1.5的核心优势

1) 对比同类模型的性能领先

- Kimi k1.5在多个关键基准测试中的表现显著超越现有的顶尖模型:MATH500测试:达到96.2%准确率,超越GPT-4o和Claude Sonnet 3.5。

- Codeforces测试:排名前94%,展现了其在编程推理任务中的卓越能力。

- AIME测试:以77.5%的通过率远超同类模型,表现提升高达550%。

2) 高效推理与节约计算资源

通过“长到短上下文”训练方法,Kimi k1.5将推理能力从长-CoT模型成功转移到短-CoT模型,同时显著减少了token使用量。这种方法在实现卓越性能的同时,确保了模型的计算效率。

3) 多模态协作能力

得益于多模态数据训练,Kimi k1.5在需要跨文本与图像推理的任务中表现优异,如MathVista和LiveCodeBench测试,进一步证明了其在联合推理领域的潜力。

05、Kimi k1.5的技术亮点解读

1) 长上下文推理的革命性突破

Kimi k1.5支持高达128,000-token的上下文窗口,这在复杂的链式推理任务中尤为重要。例如,在处理长文本问题或涉及多个步骤的数学问题时,该功能为模型提供了更广泛的语境支持。

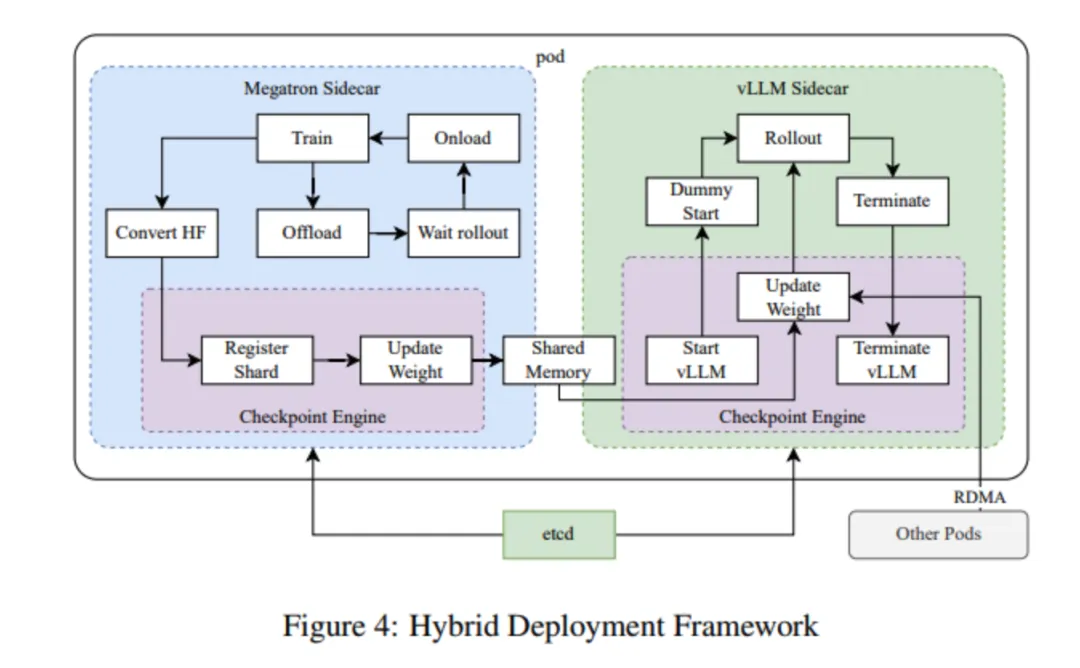

2) RL框架的简化与优化

Kimi团队采用了一种精简化的RL框架,避免了复杂的计算技术(如蒙特卡洛树搜索或价值函数),通过更高效的策略优化(例如在线镜像下降法)实现了顶尖性能。

3) 数据多样性与采样策略

通过整合文本与视觉数据,Kimi k1.5大幅提升了模型在多模态任务中的表现。此外,课程学习和优先采样策略有效解决了模型在弱势任务上的训练瓶颈,使其整体能力更加均衡。

06、技术突破背后的启示

动态探索与奖励机制扩展推理边界

RL通过引入奖励机制,让模型摆脱静态数据集的限制,为复杂任务的解决提供了全新可能。

长上下文能力助力复杂推理

128k-token上下文窗口的实现,让模型能够在长链推理任务中保持连贯性与高效性,解决了传统方法的性能瓶颈。

资源优化与多模态数据整合的重要性

部分回滚、优先采样等技术优化了模型资源分配,而多模态数据的使用拓展了模型的适用场景。

07、总结与展望

作为一款革命性的多模态大语言模型,Kimi k1.5通过整合强化学习、长上下文推理和多模态数据处理,在推理能力和资源效率上取得了显著突破。从处理复杂的数学问题到优化短上下文任务,Kimi k1.5不仅展示了其技术潜力,也为下一代智能系统提供了强有力的支撑。

参考:

- https://github.com/MoonshotAI/Kimi-k1.5/blob/main/Kimi_k1.5.pdf

- https://github.com/MoonshotAI/Kimi-k1.5?tab=readme-ov-file

本文转载自公众号Halo咯咯 作者:基咯咯