回复

分布式训练通信优化,重叠通信,参数子集同步,低精度外梯度量化

研究背景与意义

- 研究背景:随着大规模语言模型(LLMs)的迅速发展,训练这些模型所需的计算资源和带宽需求也随之增加。传统的分布式训练方法面临着设备协同和通信延迟等挑战,这使得在数千个加速器上进行有效训练变得复杂。

- 研究意义:本文提出的Streaming DiLoCo方法,旨在通过放宽设备协同的要求,降低训练过程中的带宽需求,从而提高训练效率。这一方法的成功实施将为分布式训练提供新的思路,助力在有限的带宽条件下实现大规模模型的有效训练。

- 研究目标:论文旨在通过三项创新(参数子集同步、计算与通信重叠、低精度外梯度量化)来实现带宽的显著降低,同时保持模型训练质量。

研究方法与创新

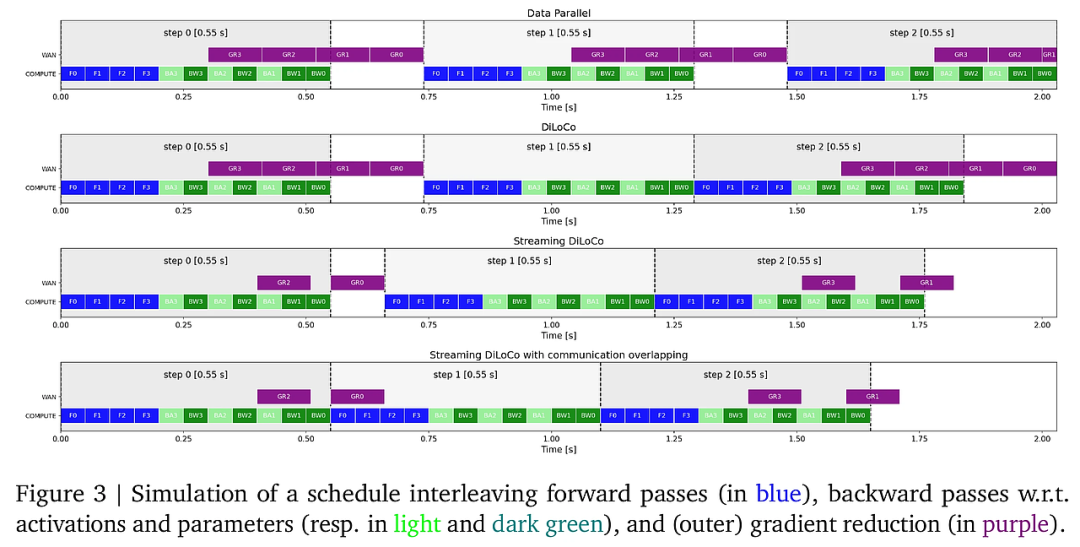

- 研究方法概述:本文基于DiLoCo算法,通过对参数同步和通信机制进行改进,提出了Streaming DiLoCo方法。该方法允许在训练过程中对参数进行分批同步,并在计算步骤中重叠通信。

- 方法创新:

- 参数子集同步:仅同步部分参数,而不是在每次迭代中同步所有参数,这样可显著降低峰值带宽需求。

- 计算与通信重叠:在进行参数同步的同时,继续进行训练计算,从而减少整体训练时间。

- 低精度外梯度量化:通过将外梯度量化至更低的精度(如4位浮点),进一步减少通信所需的带宽,且不影响模型性能。

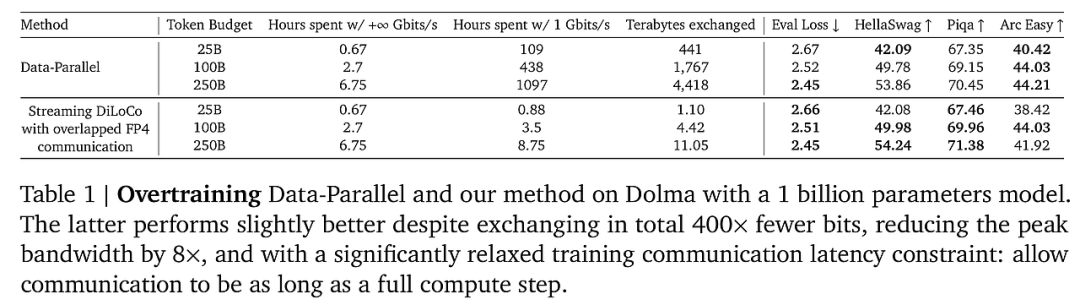

- 优势对比:与传统的Data-Parallel方法相比,Streaming DiLoCo在保持相似的训练效果的同时,带宽需求降低了400倍。这一创新为大规模模型的训练提供了新的解决方案。

实验设计与结果分析

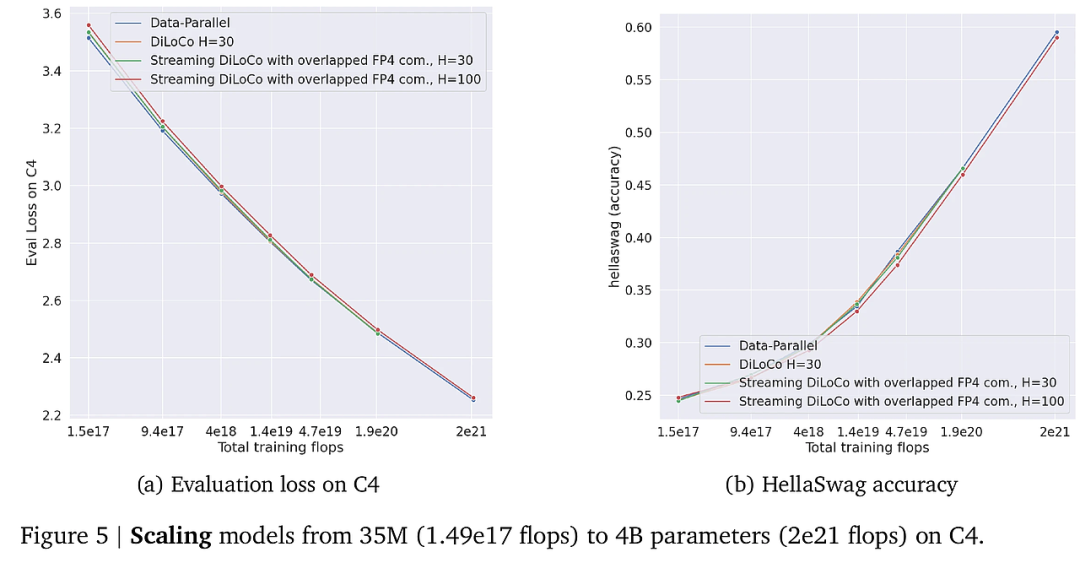

- 实验设计:通过在不同规模的模型(从35M到4B参数)上进行训练,评估Streaming DiLoCo方法的性能。实验设置包括使用C4数据集和Chinchilla架构,采用不同的带宽条件进行对比。

- 结果分析:

- 计算利用率:实验结果显示,Streaming DiLoCo在带宽为1-5 Gbit/s的条件下,计算利用率高达95%,而传统Data-Parallel方法则需要更高的带宽以达到相似的效果。

- 训练效果:在多个下游任务(如HellaSwag、Piqa等)中,Streaming DiLoCo与Data-Parallel方法的表现相似,证明了其在降低带宽需求的同时,仍能保持模型性能。

- 统计显著性:通过对比实验的统计分析,确认了Streaming DiLoCo在带宽利用率和训练效率上的显著优势。

结论与展望

- 总结贡献:本文提出的Streaming DiLoCo方法,通过创新的参数同步策略和通信机制,显著降低了大规模模型训练中的带宽需求,保持了训练效果。

- 分析局限:尽管Streaming DiLoCo在带宽利用率上表现优异,但在不同设备间的异构性和通信延迟方面仍需进一步研究。

- 方法展望:未来的研究可以探索如何将Streaming DiLoCo方法与其他分布式学习框架结合,以应对更复杂的训练场景,同时进一步优化通信效率和模型性能。

通过上述分析,可以看出本文不仅在理论上提出了新的方法论,同时在实验中验证了其有效性,为大规模语言模型的训练提供了新的思路和方法。

赞

收藏

回复

相关推荐