手把手教你在本地部署 DeepSeek R1,并集成到 Dify 中,建议收藏! 原创

本教程将一步步指导你如何在本地环境中安装 DeepSeek R1,并将其融合进 Dify 中,确保你的工作的效率得到实质性的提升!

1、DeepSeek R1 模型部署

本部分内容将重点阐述如何在本地环境下利用 Ollama 来部署 DeepSeek R1。后续章节将详细讲解如何将 DeepSeek R1 与 Dify 系统进行集成。

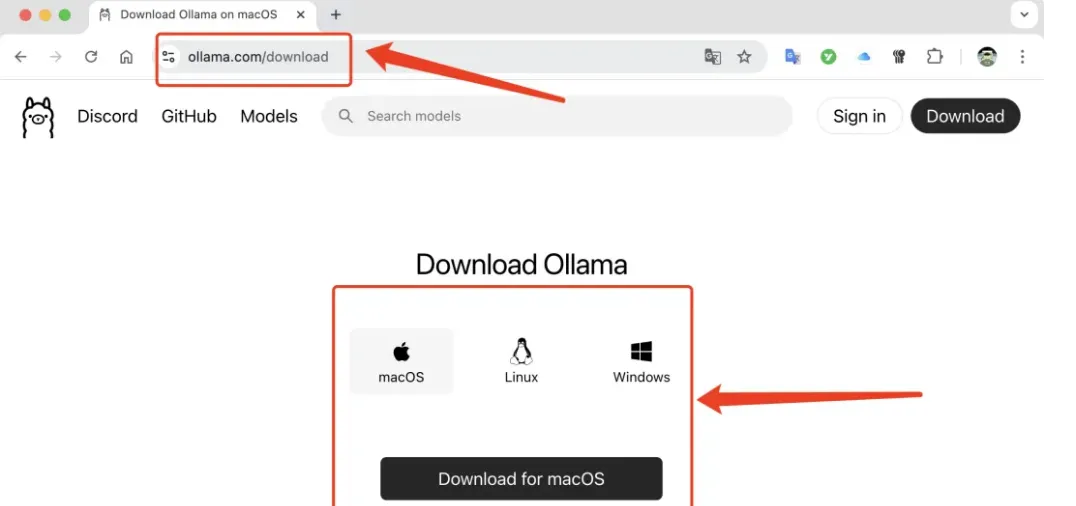

第一、安装 Ollama

请访问 Ollama 的官方网站,根据你的操作系统选择合适的版本,下载 Ollama应用程序并进行安装:

安装完成后,打开命令行界面并输入

命令。如果屏幕上出现以下提示信息,那么恭喜你,Ollama 已经成功安装。

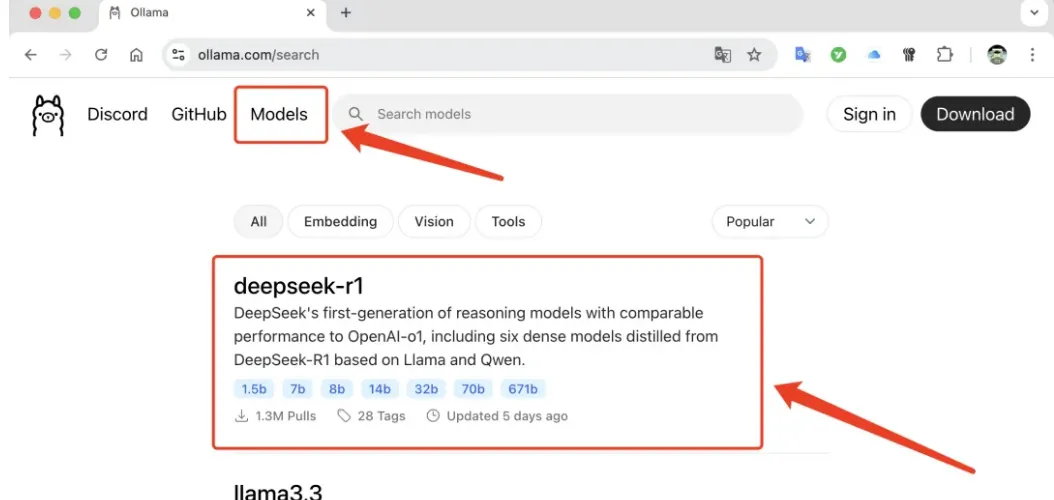

第二、部署 DeepSeek R1 模型

首先,访问 Ollama 官网并点击页面顶部的「模型」(Models)选项,接着在列表中找到并点击「DeepSeek R1」:

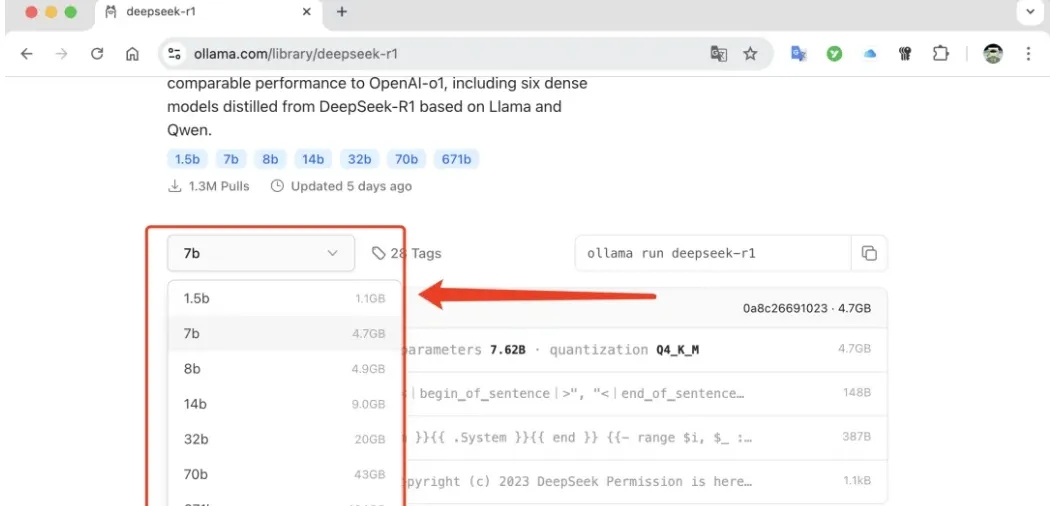

在模型详情页面,根据您的计算机显存容量选择合适的模型版本:

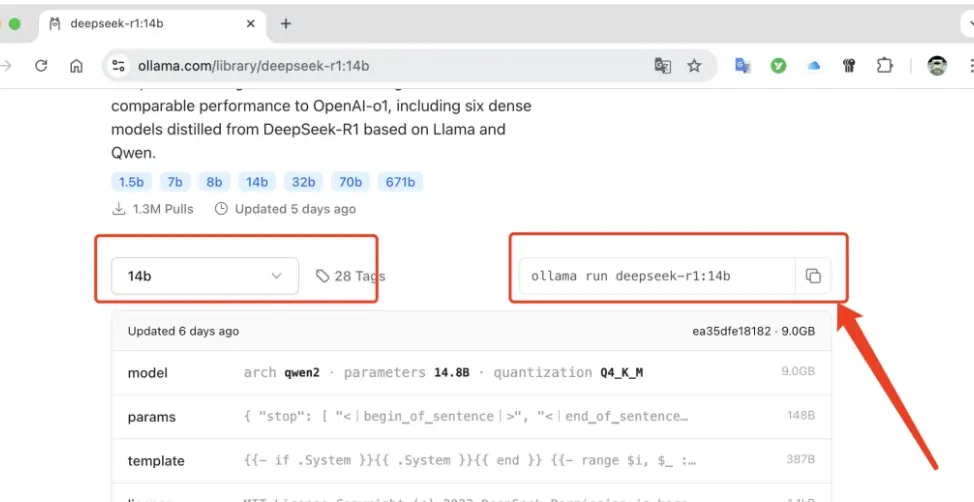

例如,我的电脑运行的是 MacOS 系统,拥有 32GB 的显存,因此我选择了14b 版本的模型。点击 14b 版本,页面右侧将显示下载指令:

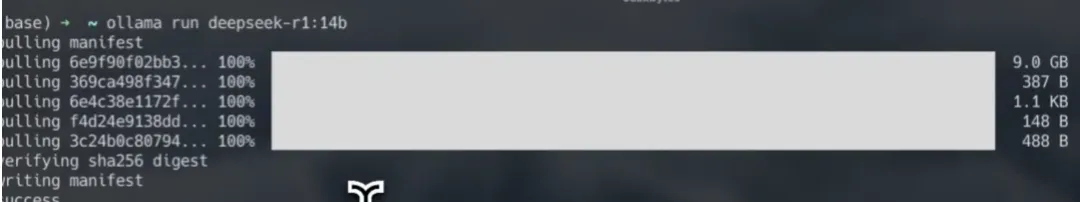

将此下载命令复制并粘贴到命令行中执行:

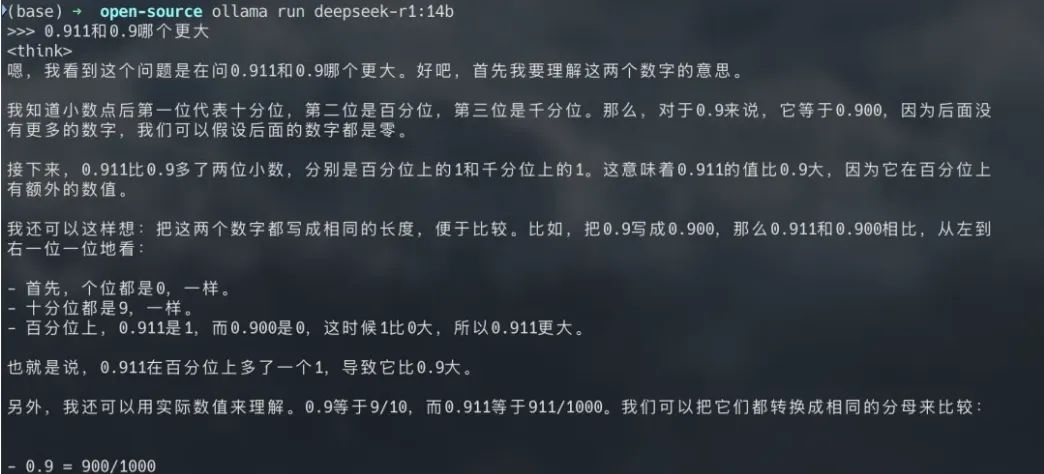

待命令执行完毕,您就可以通过命令行与大模型进行交互了:

然而,仅通过命令行与大模型交流可能不够便捷。因此,接下来,我们将介绍如何将模型集成到 Dify 中,以便通过更直观的图形界面进行操作。

2、在 Dify 中配置 DeepSeek R1 模型

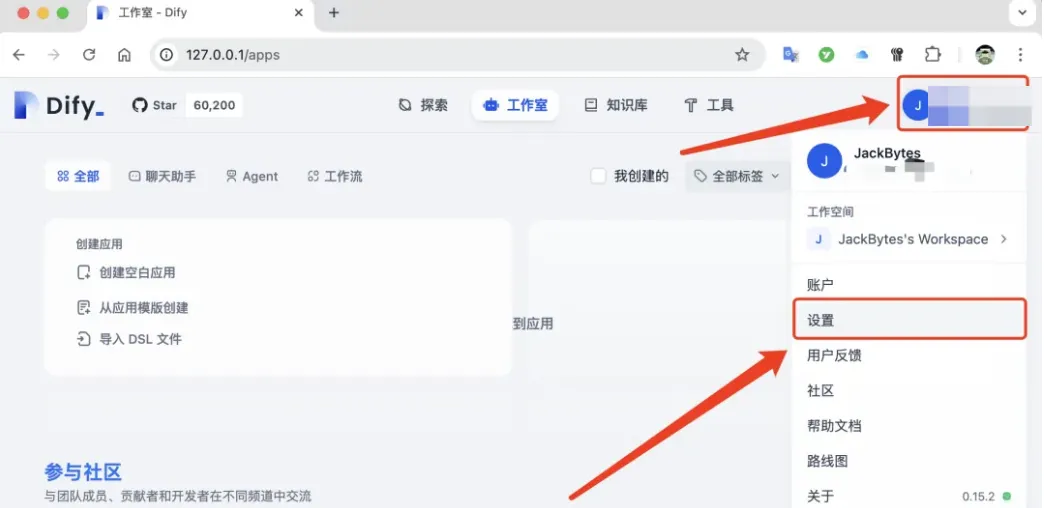

访问已部署的 Dify 系统,点击页面右上角的个人头像,随后选择「设置」选项:

在「模型供应商」配置页面,选择「Ollama」作为供应商:

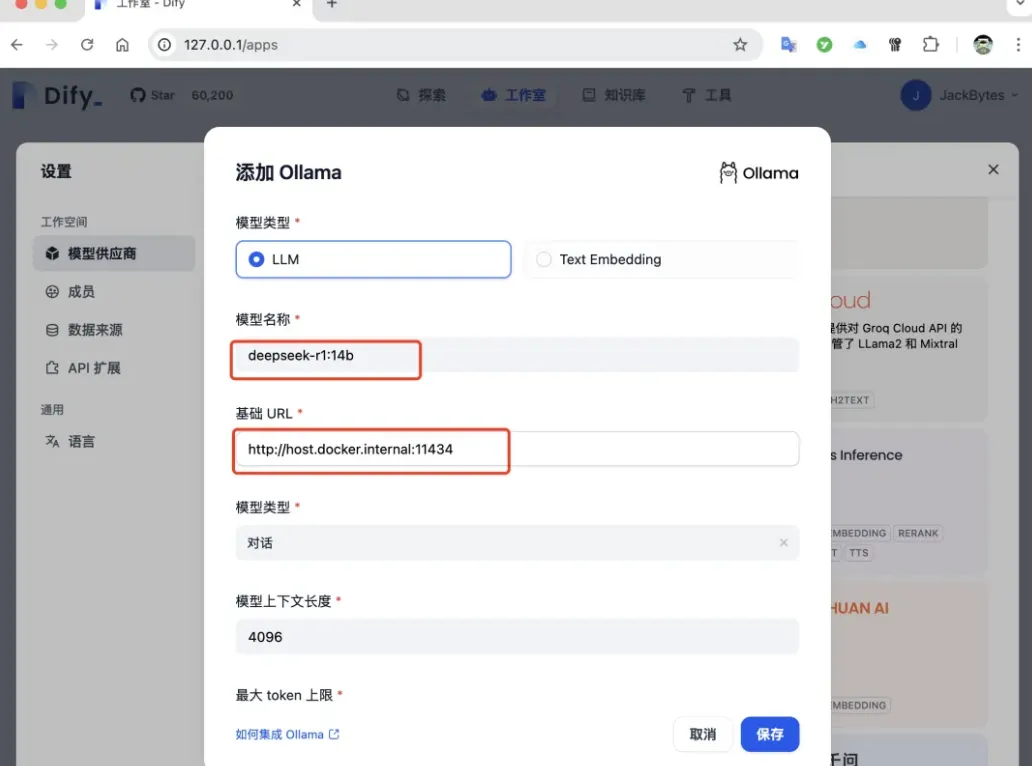

在「模型名称」一栏输入:deepseek-r1:14b。对于「基础 URL」,如果 ollama 和 Dify 在同一台机器上部署,并且 Dify 是通过 Docker 容器部署的,那么应填写http://host.docker.internal:11434;若非此情况,请填写http://ollama 的服务地址:11434。完成填写后,点击「保存」按钮。

3、创建应用

接下来,我将指导你如何在 Dify 中创建一个应用,以便利用 DeepSeek R1 模型。

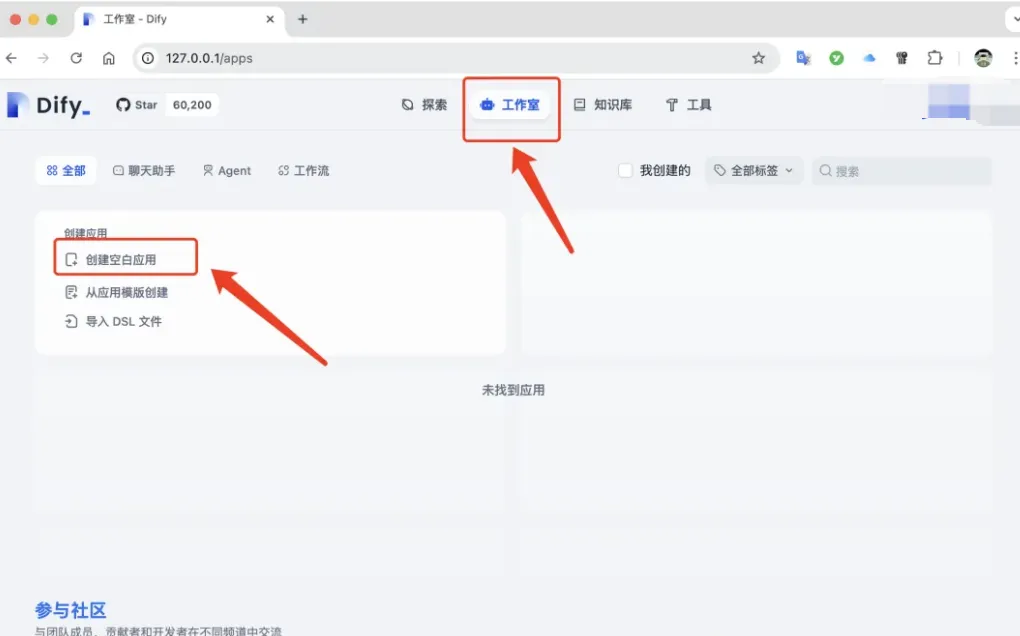

首先,在 Dify 的「工作室」页面中,点击「创建空白应用」的按钮:

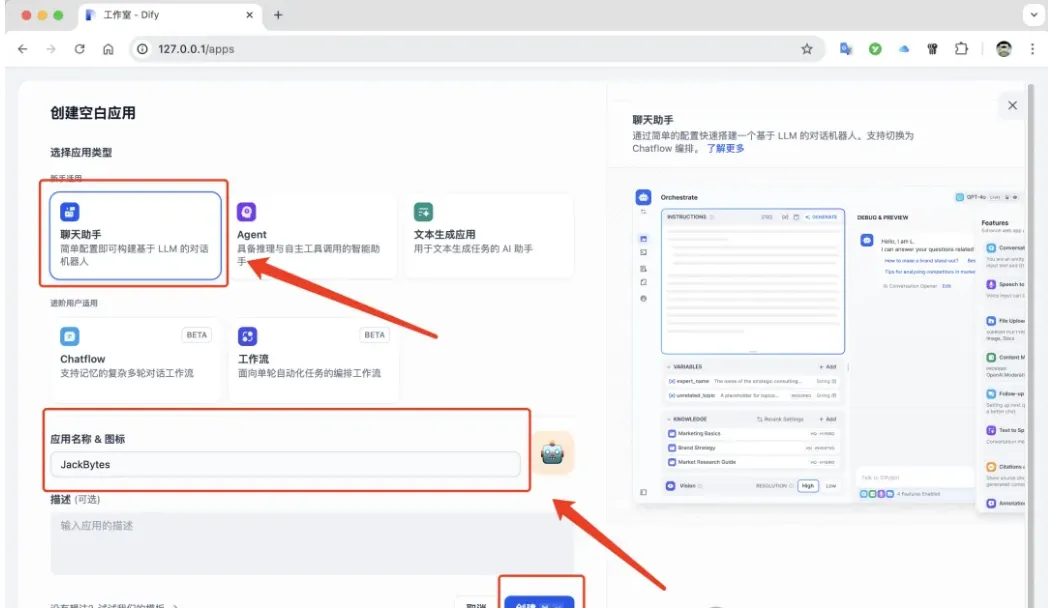

在出现的对话框中,选择「聊天助手」类型,输入「应用名称」和「描述」,然后点击「创建」:

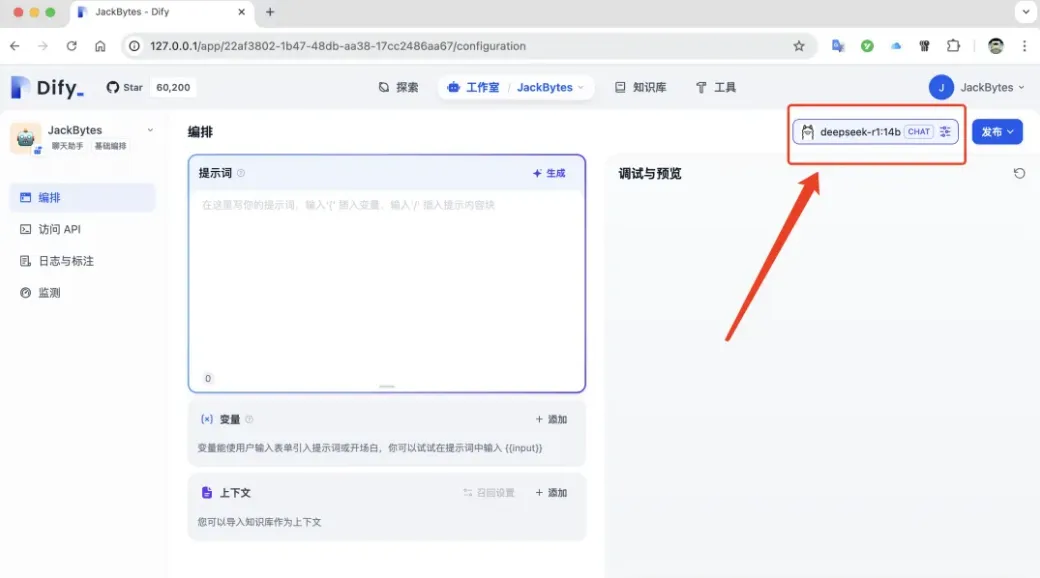

应用创建成功后,点击页面右上角,选择您已经添加的 DeepSeek R1 模型:

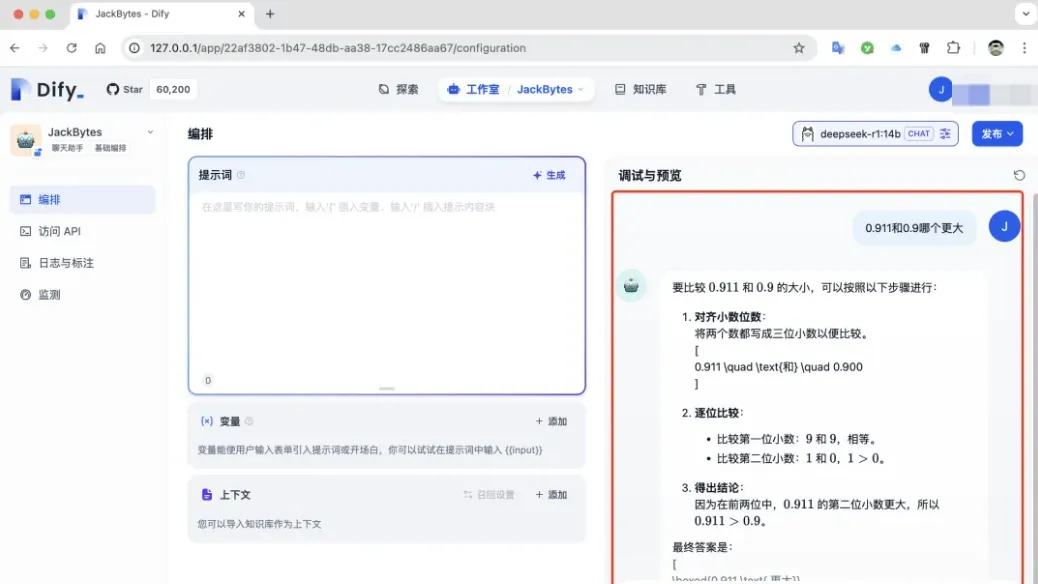

接下来,可以尝试提出问题进行测试:

请注意,DeepSeek R1是一个推理模型,它不支持函数调用。这意味着它不能被集成到 Dify 的智能体中。不过,DeepSeek V3 模型则可以进行集成。

4、总结

本文向您展示了目前广受关注的 DeepSeek R1 模型,并指导你如何在本地环境下进行部署,以及如何将其融合至 Dify 平台。感兴趣的朋友不妨亲自尝试一番。

本文转载自公众号玄姐聊AGI 作者:玄姐